原链接:https://mgalkin.medium.com/knowledge-graphs-in-nlp-emnlp-2020-2f98ec527738

在这篇综述中,我没有区分主要的论文和发现论文,而是试图选择30篇左右值得注意的作品,这些作品可能会在未来的2-3年确立新的趋势。

目录

-

KG增强的语言模型:增强Transformer

-

自编码器

-

自回归

-

自然语言生成:Datasetlandia的新成员

-

实体链接:海量和多语言

-

关系提取:OpenIE6和神经提取器

-

KG表示学习:时间KGC和FB15K-237的继承者

-

ConvAI+KGs:在OpenDialKG的肩上

** KG增强的LMs:增强Transformer **

我们在去年的EMNLP 2019年首次注意到结构化知识增强的LMs出现了繁荣。2019年和2020年出现了数十个使用维基百科或Wikidata实体进行丰富的模型(甚至在EMNLP2020上也有),但概念上的问题仍然存在。

如何度量知识编码在LM中的参数?

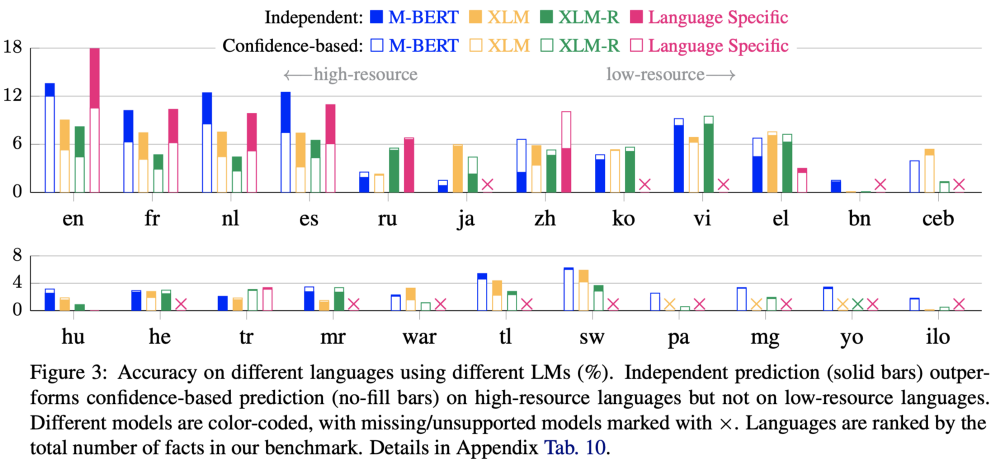

第一次尝试,比如LAMA基准测试,将问题定义为匹配从Wikidata中提取的事实的单标记块样式的空白,例如,iPhone是由_设计的(当然是苹果)。LMs显示了一些事实知识的概念,但坦率地说,不是很多,也不是很深。不过,LAMA是单令牌;2)只准讲英语的。我们能否涵盖更复杂的任务和多样化的环境? 是的!为了与XTREME等多语言基准测试的近期成功相一致,Jiang等人研究了多语言模型是否展示了一些事实知识,并提出了X-FACTR,一种使用23种语言、带有多标记空白(实际上多达5到10个标记)的closize风格问题的多语言基准测试,来测量它。作者探讨了M-BERT、XLM和XLM- r与X-FACTR的关系。关键的发现为设计和训练知识渊博的语言模型留下了很大的空间:多语言模型在高资源语言中只能达到15%的准确率,在低资源语言中只能达到5%左右 M-BERT似乎比更大的XLM和XLM- r包含更多的事实知识。多令牌预测比单令牌预测困难得多,因此您需要针对这类实体的重要解码策略。几乎没有协议有效性在多种语言,也就是说,瑞士命名_ (EN)和НаименованиеШвейцариивосходитк_(俄文)产生完全不同的答案。在X-FACTR上看到最近的mT5(多语言T5)和mm-100的探测结果将是相当令人兴奋的。

LMs中的实体表示

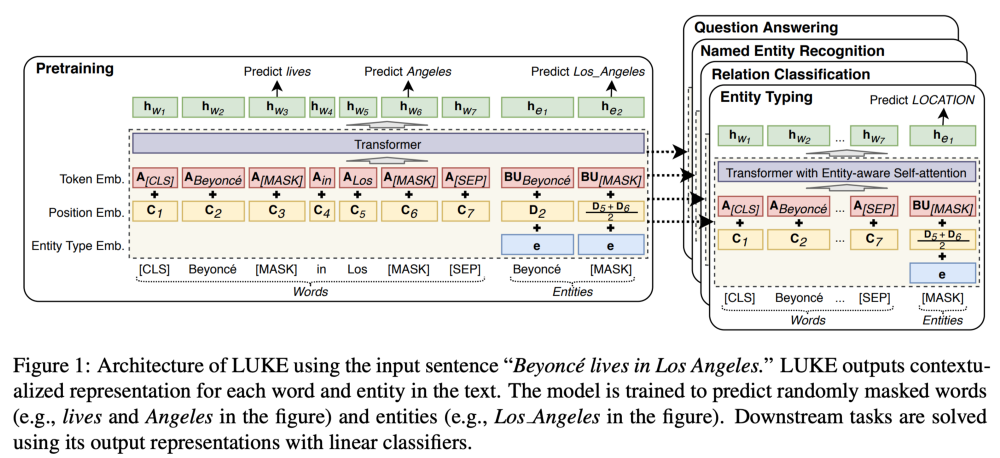

这次我们有四种新方法! 我把他们具体的训练前目标用粗体字写了出来。Yamada等人提出了LUKE(基于知识的嵌入语言理解),这是一个具有预训练任务的transformer模型:传销商+预测文档中的隐藏实体(见插图)。在保持实体嵌入矩阵(500K不同实体)的基础上,作者增加了实体感知自我关注,即根据计算的标记类型(word-entity, entity-entity, entity-word)增加了三个查询矩阵。一个简单的增强功能可以实现新的下游任务,并略微改进RoBERTa和最近的KG增强基线。

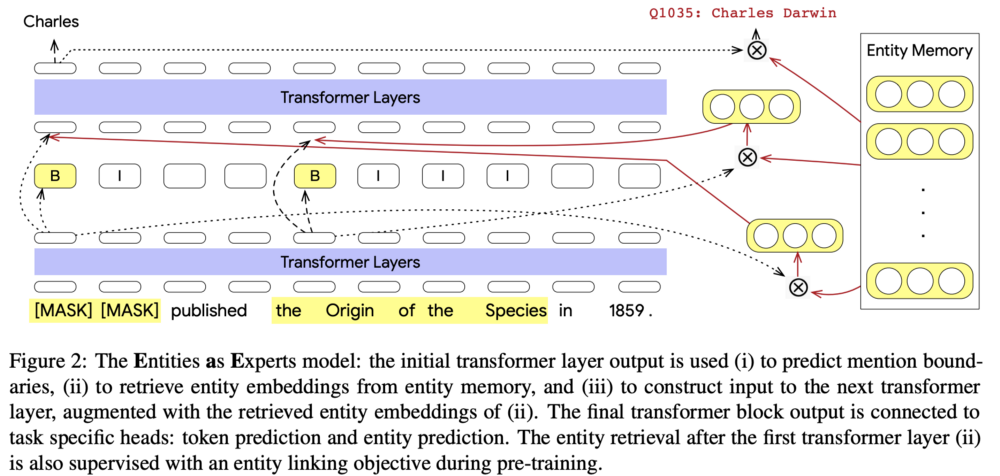

接下来,Fevry等人介绍了实体专家(EaE),这是一个12层的transformer,其中前四层正常工作,然后标记嵌入注释提到查询实体内存中的前100个实体,然后将汇总后的嵌入经过8个Transformer层。

另一方面,Shen等人使用的背景KG略有不同:在他们的GLM(图引导的掩码语言模型)中,图提供了命名实体及其连通性模式(k-hops中的可达实体)的词汇表。这一信息在两个训练前的任务中得到了利用:蒙面实体预测+在干扰因素存在的情况下实体排序,即负样本。KG帮助掩蔽信息实体和选择硬阴性样本进行鲁棒训练。

最后,Poerner等人在他们的E-BERT中使用了Wikipedia2Vec。他们的想法是这样的:vanilla BERT只训练单词的嵌入,而Wikipedia2Vec同时训练单词和实体的嵌入(270万个实体)。因此,我们首先学习W,即BERT wordpieces和Wikipedia2Vec单词之间的线性转换,然后使用拟合的参数W投射Wikipedia2Vec实体。

自回归KG增强的LMs

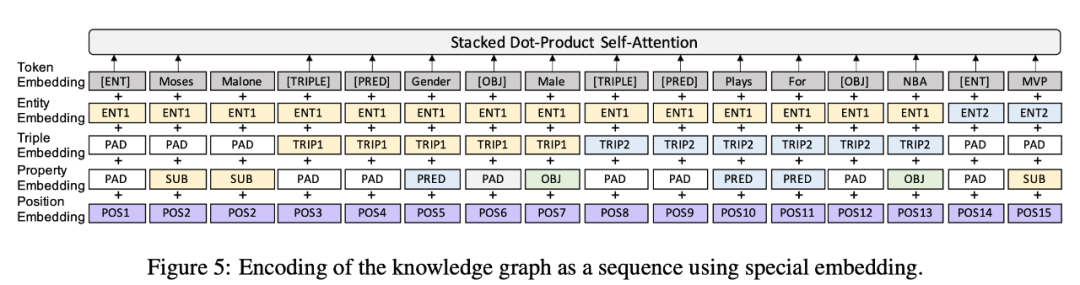

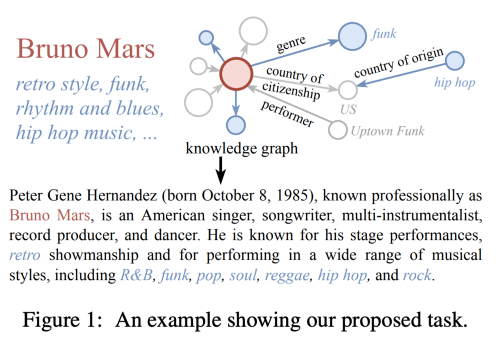

在本节中,LMs的生成过程受到小子图等结构化知识的制约或丰富。Chen等人对KGPT(基于知识的预训练)、数据到文本任务的生成模型和巨大的新数据集KGText做出了重大贡献! 1作者提出了一种对各种数据到文本任务(如WebNLG、E2E NLG和WikiBio)进行编码的通用格式,作为语言模型的统一输入。2 KGPT有两个编码器:基于网络的Graph Attention(对我来说有点复杂,只需要一个多关系的CompGCN就可以了)和带有位置嵌入式输入的伯特风格(请查看插图)。本质上,您可以用指针将一个图线性化为一个序列,其中的指针是实体、关系和完整三元组。解码器是一个标准的类似gpt -2的复制机制。3 KGText是一个新的预训练语料库,其中从维基百科的EN句子与从Wikidata的子图对齐,总共约1.8M(子图,文本)对。作者确保每个子图及其成对的句子描述了几乎相同的事实。这确实是一个实质性的贡献,因为以前的从图形到文本的数据集相当小,并且包含了一个监督设置。

在这里,KGPT显示了相当令人印象深刻的结果,在少数射击和零射击的情况下,在KGText的预训练,使GPT-2远远落后。也就是说,在WebNLG (RDF to text task)上,仅5%的训练数据就可以在少量射击设置中获得40+蓝标得分,在完全零射击设置中获得20+蓝标得分。我的看法:KGPT仍然缺乏显式的实体(每个嵌入的实体都是其子词单位的平均值),而且在编码给定的子图时,实体和文字之间没有区别。对8个Titan RTX gpu进行8天的预训练。

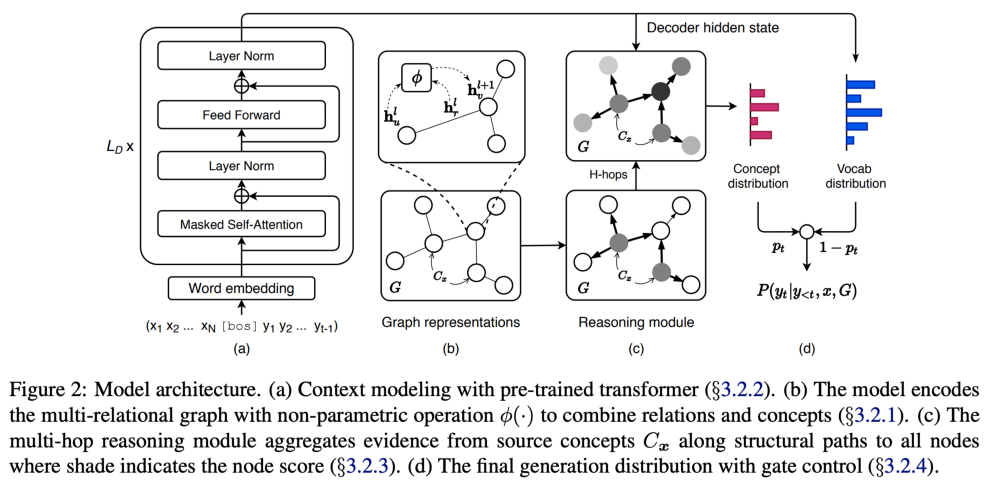

Ji等人采取了相反的方式,他们扩展了一个解码器,使用图推理模块来保持GPT-2编码器在他们的GRF(生成多跳推理流)中完好无损(见下)。在处理与常识相关的任务和像ATOMIC和ConceptNet这样的KGs时,作者首先从输入文本中提取一个k-hop子图。文本通过GPT编码器编码,而KG子图通过CompGCN(明智的选择)编码。推理模块(本质上看起来像消息传递)通过子图传播信息,并在实体上创建softmax分布以选择相关的实体。最后,复制门决定是放置该实体还是从词汇表中选择一个单词。

在故事结尾生成、拐展NLG和解释生成方面的实验表明,在自动度量以及对生成文本的人类评估方面,优于各种GPT-2基线。

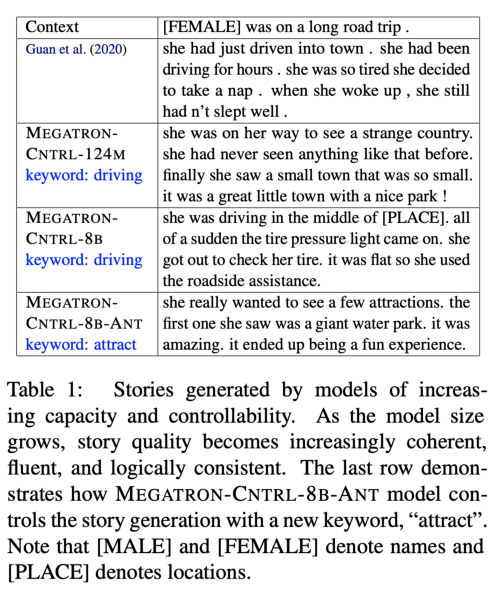

我们今天的举重冠军是由NVIDIA的Xu等人创建的MEGATRON-CTRL (8.3B参数)。通过控制生成,我们了解到调节LM生成器不仅要通过输入上下文,还要使用一些关键字,这些关键字可以推动故事向某个方向发展。

这里,作者使用ConceptNet及其600K triples作为常识性KG和外部知识来源。

首先,关键字与三元组匹配,匹配的关键词通过通用句子编码器(USE)传递。另一方面,输入上下文也通过使用传递。最后,选择top-K个最大内积向量。对猎犬进行负采样训练。

解码器是一个巨大的transformer (8.3亿个参数),关键字生成器只有2.5亿个参数。训练只需160台特斯拉v100。实验表明,这样的大模型确实能从背景知识中获益,并且在AMT实验中更容易被人们所青睐。

NLG(数据到文本):Datasetlandia的新成员

今年,我们看到了许多新的、大型的、设计良好的、复杂的任务/数据集,这些任务/数据集至少会在明年为NLG提供动力。

Cheng等人介绍了ENT-DESC,一个基于Wikidata的三到文本数据集,在其中,给定围绕主实体的2跳子图,任务是生成其文本描述。数据集在几个方面优于WebNLG: 1 - desc要大得多:110K图形-文本对,超过11M三组,大约700K不同的实体,1K不同的关系;2每个实体的三组比例更高,但不是所有的三组都对生成的文本有贡献,也就是说,其中一些是干扰,模型应该足够强大,以消除它们; 预期的描述比WebNLG的要长。

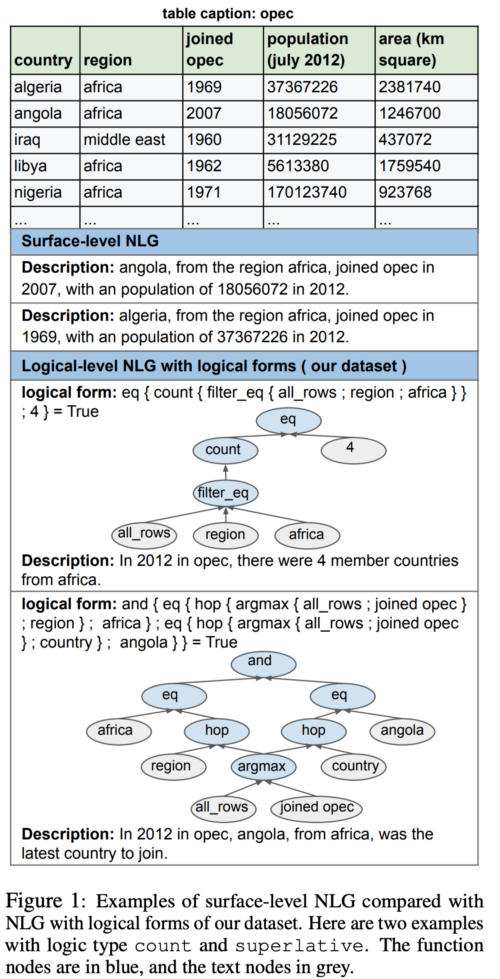

接下来,Chen等人提出了一个新的数据集Logic2Text,它挑战了NLG系统从逻辑形式生成文本的能力。需要注意的是,它不仅是一个表到文本的任务,而且是一个更复杂的任务,包含7种逻辑类型,包括计数、比较、最高级、聚合、多数、唯一和序数。

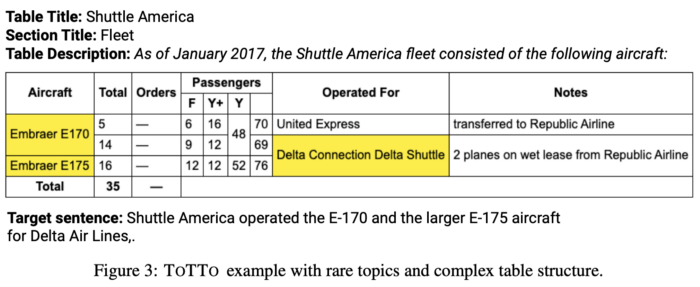

在表格到文本的世界中,Parikh等人介绍了ToTTo,一个包含120K示例的大型数据集。任务是在给定表和几个突出显示的节点的情况下生成可信的文本。

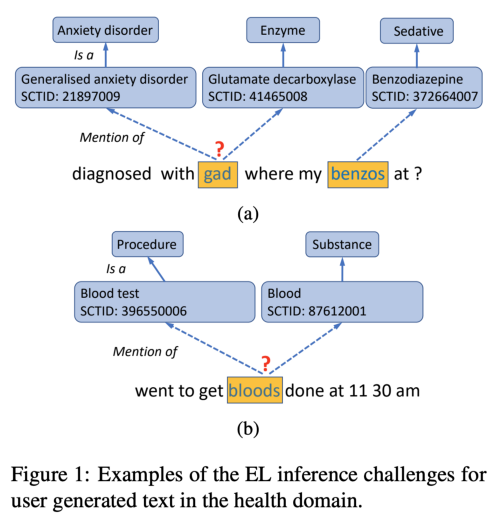

实体链接:海量和多语言

在实体链接的世界里,谷歌和Facebook也加入了进来,他们通过提升TPUs和HPC集群来解决大量的多语言实体链接问题。

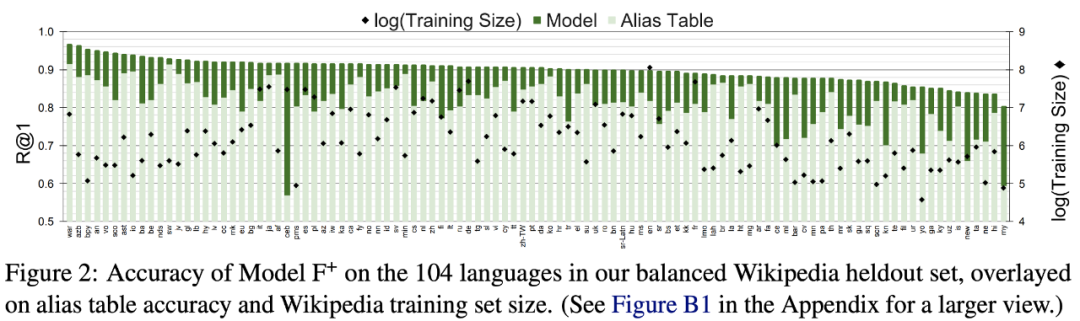

Botha, Shan和Gillick对100种语言的实体连接进行了研究。首先,为远离只使用en的场景向您致敬:这是NLP社区的一项了不起的努力!像Wikidata这样的大型KGs在设计语言上是不可知的,所以我们为什么不利用所有非en数据呢?(事实上,一些实体的标签和描述甚至可能不存在)作者首先我684M提到约20M的巨大的数据集Wikidata实体在104种语言,和设计Mewsli-9,只一个轻量级的测试用例集的300 k提到82 k实体的9种语言评估实体连接性能。在模型方面,作者求助于双编码器,其中一个Transformer(通常是BERT)编码提到,而第二个transformer编码实体描述,计算余弦相似度作为最后的操作。使用mBERT检查点初始化模型,在TPU v3上训练几天(TPUs运行brrr)。结果证明这个策略相当有效:在mewsli9上,最好的模型(以智能训练增强为动力)达到micro-avg 90% Recall@1和98% Recall@10。另外,请查看下面的插图,以获得heldout集上特定于语言的数字。

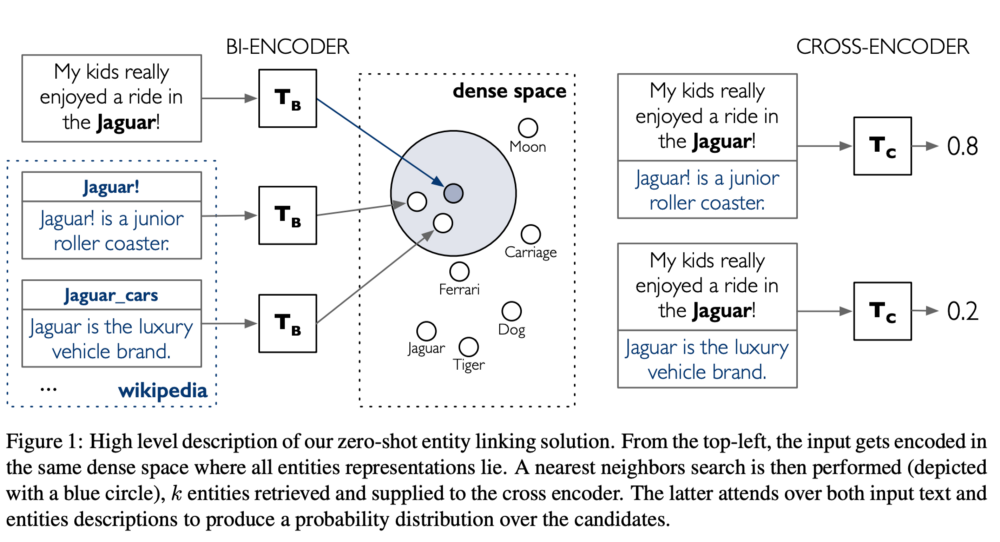

与此略有不同的是,Wu等人将EN Wikipedia视为为零命中率设置而定制的新BLINK实体链接器中的背景知识库和实体词汇表。BLINK也采用了双编码器范例,但是这次所有的实体描述都是预先计算并存储在FAISS索引中(那些是[CLS]嵌入)。上下文中提到的实体(需要事先注释)通过另一个transformer传递,结果嵌入的提到通过FAISS在索引中检索top-K最近邻。最后,通过交叉编码器transformer对top-K选项进行排序(非常有用)。实验证明:1)基于fais的检索速度快(~2ms/查询)、准确(Recall@10 ">">">">">">">">">">">">">">">">">">">">">">>90%),明显优于TF-IDF和BM-25;2)在零样本的情况下,BLINK会把所有的基线都远远甩在后面!3)即使在一个CPU上推理也很快,所以你也可以将模型插入到你的应用程序中!

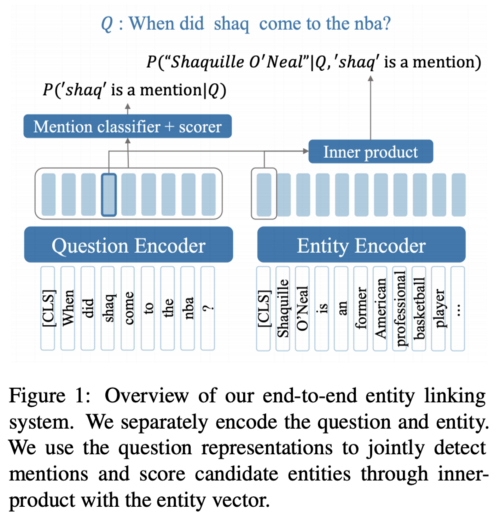

然而,BLINK确实需要注释实体提及。这个问题由Li等人在他们的ELQ(问题实体链接)中的一篇同类论文解决了。事实上,ELQ驻留在相同的回购完全互补BLINK。 虽然架构类似于BLINK (bi-encoder + FAISS),但ELQ共同学习了提及检测和消歧。也就是说,不需要输入注释! 此外,ELQ在实际应用中也表现出色:ELQ在QA数据集(如WebQSP和GraphQuestions)上优于TAGME和BLINK,同时也提高了在Natural Questions和TriviaQA等大型QA数据集上的准确性。

关系提取:OpenIE6和神经提取器

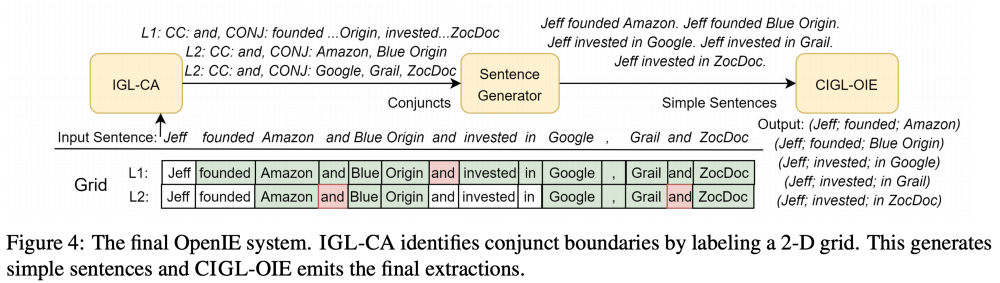

OpenIE是现代NLP应用程序的一个基石框架,它使用开放模式(没有背景本体)从文本中提取三元组。各种各样的CL论文都以这样或那样的方式使用OpenIE。Kolluru AtEMNLP 2020年,Adlakha等介绍OpenIE 6,下一个主要版本的IE方法。

什么新的? 首先,OpenIE 6帧的三重提取作为一个2-D (num_words x num_extraction)网格标注任务,使每次提取的每个单词都可以属于主语/谓词/对象/无标签。不过,细节才是真实的。提出了一种基于BERT的迭代网格标记系统,用于二维网格标记的实现。即帮助解决协调连词(如图IGL-CA),以及在三重提取过程中应用软约束(CIGL-OIE)。软约束使最终的损失函数增加了POS标签的信号、头部动词的覆盖和放大。排他性和提取计数附加在头动词上。实验表明,在几个基准测试中,OpenIE 6比OpenIE 5快10倍,性能有显著且一致的提升(大约4个F1点)。你还可以用这4点来换取更快的速度,并获得OpenIE 5级的性能,但是速度要快50倍。

此外,Hohenecker、Mtumbuka等人对OpenIE的神经结构进行了系统研究。

KG表示学习:时间KGC和FB15K-237的继承者

在今年的EMNLP 2020上,我们有大约20篇(!)论文专门针对KG表示学习。其中有我们的论文《超相关知识图谱的信息传递》,我不会在这里讨论,因为我们在Medium上发表了一篇独立的文章,涵盖了所有的细节,所以我邀请你也来看看。

一定数量的工作被放入暂时的KGs中,也就是那些具有特定事实在特定时间范围内有效的时间戳的KGs。例如,(奥巴马,美国总统,2009,2017)。我们需要预测一个主体或一个客体,给出剩下的四组/五组。几个著名的作品:

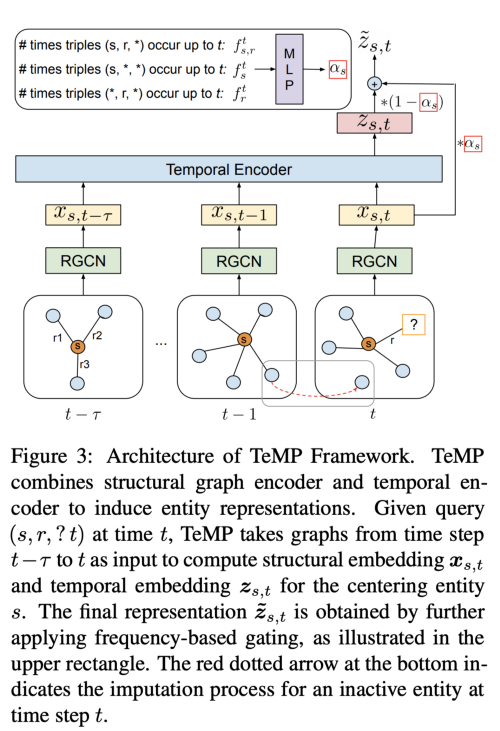

在这种设置中,Wu等人提出了TeMP(时态消息传递框架),其中结构GNN编码器(R-GCN使用,但任何多关系的都可以使用,如CompGCN)与时态编码器配对。 作者用时间编码器进行了实验:GRU和自我关注。也就是说,每一个时间步都用一个GNN编码,它们的输入被输入到时间编码器中。一个额外的控制机制考虑到在特定的时间范围内发生实体的频率(例如,在1900年1950年很少提到奥巴马,但在2000年2020年更多)。最后的实体嵌入是计算浇注后,并被送入一个解码器在这里它是复杂的,尽管我认为任何评分功能从KG嵌入家庭将工作。Jin等人在RE-NET中使用了类似的R-GCN + RNN方法(但处理时间分量时采用了不同的解码器)。我们的结论是:多关系GNN可以有时间感知能力。

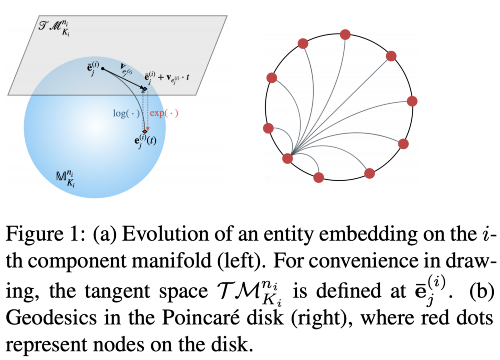

我们知道双曲嵌入具有较小的嵌入尺寸(例如,32d或64d),并产生竞争性的结果。到目前为止,这些模型已经在经典的静态KG完井设置中进行了探索。双曲线+时间= ?

Han等人在DyERNIE中使用一些高级数学来建模KGs的时间方面。实体的时间相互作用被建模为在具有一定速度的流形上的运动。DyERNIE利用了不同曲率的黎曼流形的乘积,并定义了一个应用于四维(s, p, o, t)的新评分函数。实验表明,20d/40d/100d维模型确实优于基线,学习速度确实捕获了时间方面。但是,您可能会在附录中发现,在标准数据集上训练100d模型可能需要350小时。

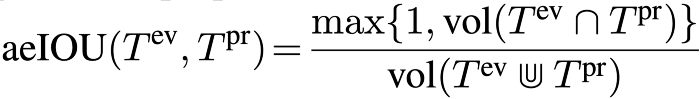

最后,Jain, Rathi等人提出了一个有价值的方法论贡献:大多数时间KG完成任务度量查询(s, r, ?, t)或(?, r, o, t),而预测实际时间间隔(s, r, o, ?)仍未充分探索。此外,此任务的现有指标或低估或高估了系统性能。摘要提出了一种新的时间区间预测指标:亲和力增强的并集交叉(aeIOU),其灵感来自于计算机视觉中常用的亲和力增强交叉。

这个花哨的联合符号是最小的船体(连续间隔),包含黄金和预测间隔。作者证明,aeIOU更好地抓住了任务的复杂性,并通过一个新的模型(TimePlex)展示了它的好处,这个新模型增加了具体时间的归纳偏差(例如,人出生的年份应该比人死亡的年份早)。总的来说,这篇论文结构良好,易于理解。

回到经典的链路预测,Safavi和Koutra深入研究了FB15K-237和其他KGE基准的缺陷,认为他们7年前的偏差和设计选择在2021年并不适合该领域。

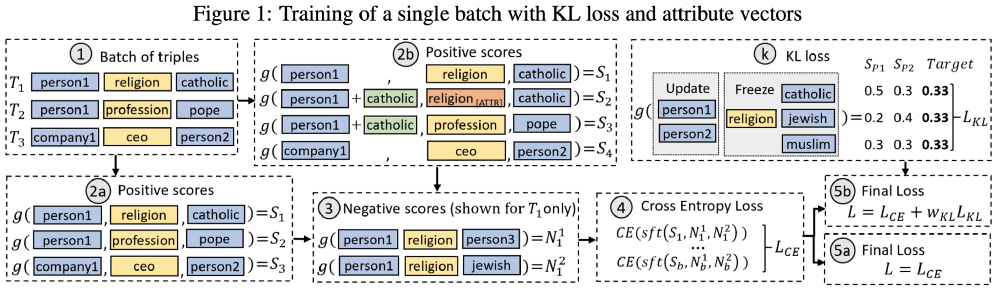

假设每年有大约50篇KG嵌入新论文,模型确实倾向于过度拟合数据集,因此,模型很难展示它们的表达能力,因为基准数据集不能从这种表达中获益。没有猛烈炮击。相反,作者提出了法典、从Wikidata()和维基百科中提取的KG完成数据集。里面有:1个小/中/大的子图; 2两个任务:链路预测和三元组分类;用6种语言描述实体和类型,没有一种语言能完全覆盖所有实体;4 .众包硬否定;5消除了测试泄漏源和大部分FB15K-237的偏差。我很高兴看到法典在社区中获得更多的吸引力!继续偏差,Fisher等人研究了如何减轻KG嵌入模型学习的KGs中的偏差。例如,在Wikidata中,大多数键入为银行家的人都是男性,但我们不希望性别影响所有Wikidata人的职业预测。强力解决方案的一个快速黑暗面可能是取消所有糟糕的三倍,但我们会发现没有女性美国总统,因此模式的质量将受到损害。相反,作者提出了另一种方法(非常有用):本质上,创建一个可能存在偏差的关系的面具,并将KL损失分配给模型预测,以推动概率达到均衡。实验表明,减少某些谓词的偏差而不牺牲大量模型的预测能力确实是可能的。

更有趣的一项研究通过Albooyeh、高尔和齐米集中样本外设置,也就是说,当在测试时间一个新的看不见的路节点到达作为一个主题或一个对象。有些人可能会称之为设置感应,但不清楚为什么作者决定去样本外。到目前为止,文献中有两种类型的任务,人们称之为归纳:(1)一个带有看不见的实体的三元组连接到看得见的经过训练的图(本文);(2)测试集包含一个全新的图,我们需要预测这个未见图中的链接(这是Teru等人最近发表的ICML 20论文)。尽管如此,在gnn的标准归纳任务中,节点通常具有一些特性,但在本文中,作者特别指出,这些特性是不可用的(简单的节点度启发式方法并不是很有用)。那么,我们如何推断到达的未见实体的嵌入呢?提出了对所见实体的嵌入进行聚合的方法。关系,提出两种策略:1简单平均1-hop附近,和2解决最小二乘问题(与我们的逆矩阵珞O (n)时间)。作者还为该任务设计了WN18RR和FB15K-237子集,发现这两种聚合策略都能够处理该任务。我唯一没有看到的是最小二乘选项的训练时间。

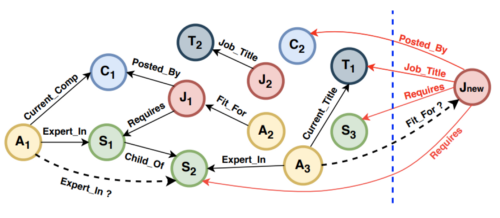

ConvAI+KGs:在OpenDialKG的肩上 OpenDialKG是ACL 2019的亮点之一:一个大型会话数据集,具有丰富的底层KG和相当复杂的任务。基线模型留下了很多改进的空间,最后,在EMNLP 20,我们发现了在使用或受到OpenDialKG影响的基于kg的ConvAI系统中有相当大的进步。

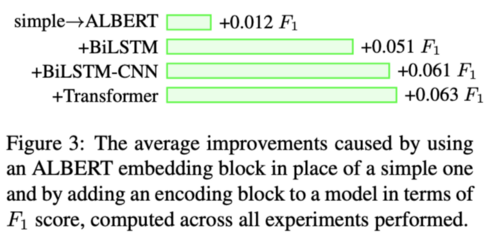

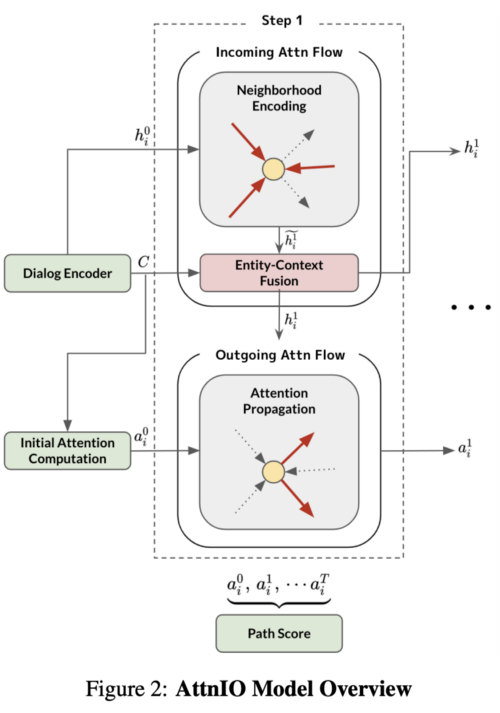

我最喜欢的会议之一是Jung等人的作品,它将注意力流的概念应用于多跳穿越。他们的方法AttnIO模拟了流入和流出的流量。传入流本质上是一个基于gnn的邻域聚合(带有关系类型的GAT),它在一个采样的子图上运行。对话上下文(和实体名称)是通过ALBERT编码的。流出流是由流出边的注意力分数决定的。解码器迭代T个步骤(分别得到T长的路径)。从数量上看,实验显示了比原来的OpenDialKG基线有很大的性能提升,特别是在前1和前3的预测方面。定性地,案例研究表明,AttnIO产生可解释的推理路径,可被人类评估者理解。将工作规模扩大到像Wikidata这样拥有100亿个节点和1.1亿个边的大型KGs可能是一项令人兴奋的努力,如果你有这个计划,请给我写信。

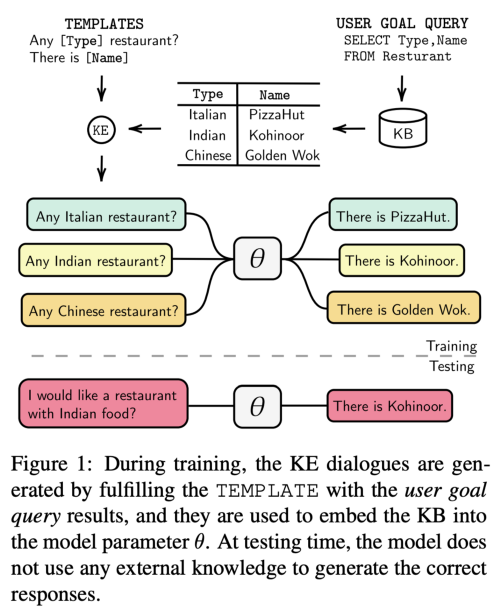

Madotto等人采用了一种不同的方式来合并KBs和KGs:正如我们在本文第一部分中所讨论的,巨大的transformer LMs往往展示一些事实知识。为什么我们不把所有的知识放入LM params中呢?所提出的模型,KE (Knowledge Embedder),正是基于这一理念。我们的目标是生成所有可能的组合諾公斤事实的对话和条件任何LM全集。提出的策略如下:(1)使用SQL或Cypher查询关系型DBs或KGs的内容。查询然后转换为对话模板(检查)。(2)在模板中填充查询的结果集。(3)我们将这些模板对话输入LM,假设它会记住参数中的知识库事实。将KE附加到GPT2中,并在多种ConvAI数据集(包括OpenDialKG)上对模型进行了探讨。事实上,GPT2从KE模块中获益良多(在某些数据集上产生+ 20 F1点),并且与显式的基于检索的模型相当。一些缺点:原来的OpenDialKG图太大,不能用当前的策略生成所有的对话模板,所以数字与AttnIO(例如)相差很远,但留下了很大的空间,供以后改进。我还想提到几篇论证在对话系统中使用KGs好处的论文:Yang等人在他们的GraphDialog中关注SMD和MultiWOZ数据集。他们将原来的表格数据转换为KG并对图进行了正确编码,从而极大地提高了实体检索F1得分!在医学领域,Khosla等人开发了MedFilter,一个用于医生和病人对话的系统。他们插入UMLS,一个巨大的医学本体,作为话语编码的一部分(连同话语信息)。MedFilter更好地提取和分类症状、抱怨和药物。很高兴看到有知识图谱的对话系统的更多实际应用。