简介:

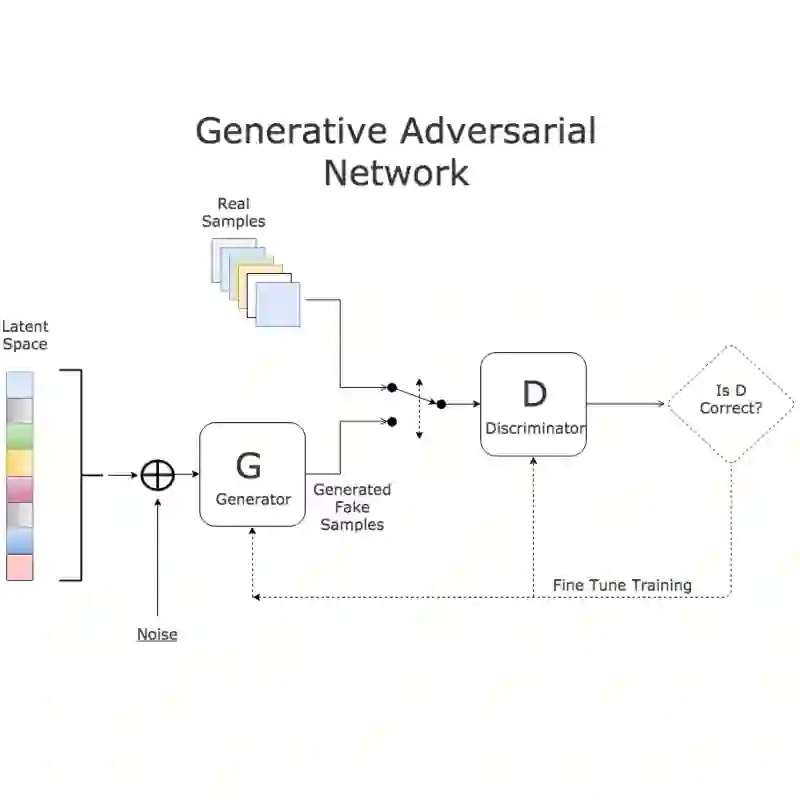

模仿学习研究如何从专家的决策数据中进行学习,以得到接近专家的决策模型。同样学习如何决策的强化学习往往只根据环境的滞后反馈进行学习。与之相比,模仿学习能从决策数据中获得更为直接的反馈。它可以分为行为克隆、基于逆向强化学习的模仿学习两类方法。基于逆向强化学习的模仿学习把模仿学习的过程分解成逆向强化学习和强化学习两个子过程,并反复迭代。逆向强化学习用于推导符合专家决策数据的奖赏函数,而强化学习基于该奖赏函数学习策略。基于生成对抗网络的模仿学习方法从基于逆向强化学习的模仿学习发展而来,其中最早出现且最具代表性的是生成对抗模仿学习方法(Generative Adversarial Imitation Learning,简称GAIL)。生成对抗网络由两个相对抗的神经网络构成,分别为判别器和生成器。GAIL的特点是用生成对抗网络框架求解模仿学习问题,其中,判别器的训练过程可类比奖赏函数的学习过程,生成器的训练过程可类比策略的学习过程。与传统模仿学习方法相比,GAIL具有更好的鲁棒性、表征能力和计算效率。因此,它能够处理复杂的大规模问题,并可拓展到实际应用中。然而,GAIL存在着模态崩塌、环境交互样本利用效率低等问题。最近,新的研究工作利用生成对抗网络技术和强化学习技术等分别对这些问题进行改进,并在观察机制、多智能体系统等方面对GAIL进行了拓展。本文综述了这些有代表性的工作,并探讨这类算法未来的发展趋势,最后进行了总结。

作者简介:

郝建业博士,现任天津大学智能与计算学部-软件学院副教授,博士生导师。香港中文大学(CUHK)计算机科学与工程专业博士,麻省理工学院(MIT)计算机科学与人工智能实验室(CSAIL)博士后研究员。

郝建业教授主持参与国家基金委、科技部、工信委、天津市重大等科研项目10余项, 与国际上多个顶尖科研团队(包括麻省理工学院 (MIT), 帝国理工学院,CMU, 香港中文大学,代尔夫特理工大学,新加坡国立大学,南洋理工大学等)具有良好的长期合作关系, 并取得了多项国际领先的研究成果。在人工智能领域具有丰富的研究经验,目前已在多智能体系统、 人工智能、 软件工程等领域的多个顶级国际期刊 (Journal of Autonomous Agents and Multiagent Systems, IEEE/ACM Trans (TPAMI, TSG, TAAS 等)) 和国际会议 (NIPS, AAMAS, IJCAI, AAAI, FSE 等)上发表学术论文70余篇,专著2部。