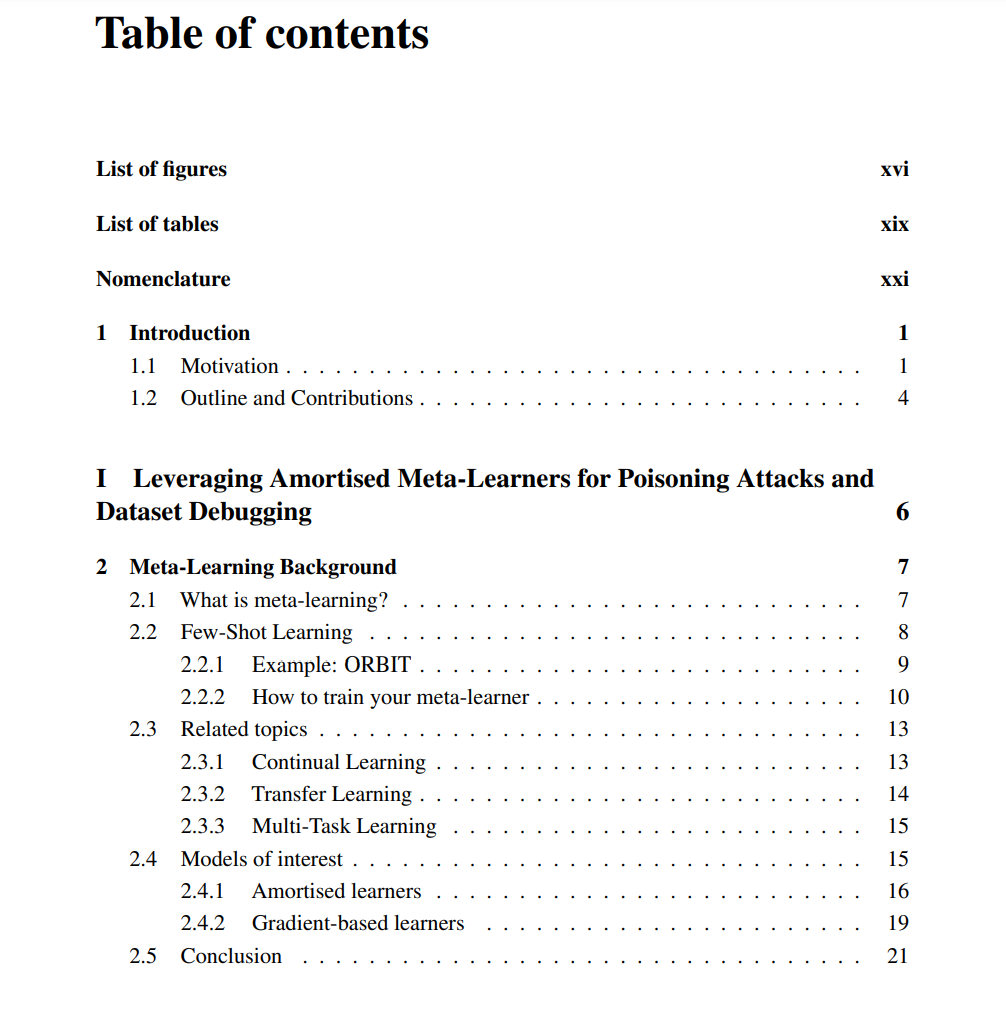

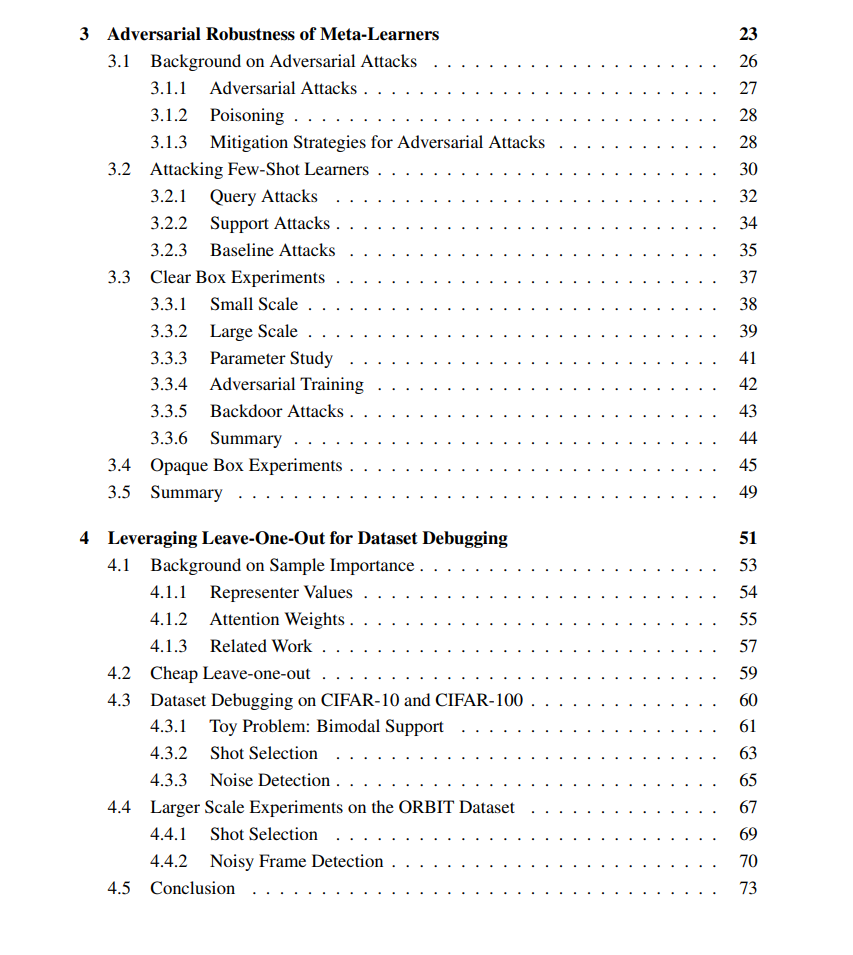

在机器学习领域,我们致力于开发能够学习的算法,即在没有被特别编程完成某项任务的情况下,积累关于如何完成任务的知识。在这篇论文中,我们从两个不同的角度来探讨学习:我们可以应用高效机器学习者的领域以及我们可以通过更有效地解决底层优化问题来改进学习的方式。机器学习方法通常非常依赖数据。虽然现代机器学习在解决实际问题方面取得了巨大成功,但这些成功案例主要局限于有大量相关领域数据可用的设置。元学习领域旨在通过创建“学会如何学习”的模型(即能够在给出相对较少的示例时迅速适应新任务的模型)来开发具有改进的样本效率的模型。在本论文中,我们关注使用超网络进行任务适应的摊销元学习者,这些学习者成本非常有效,只需通过超网络进行一次前向传播即可学会如何执行新任务。我们展示了这些摊销元学习者可以以超出其在小样本学习设置中的典型用途的新方式来利用。

我们针对摊销元学习者开发了一种基于集合的中毒攻击,这种攻击让我们能够定制一组协同作用的输入,用作适应新任务的训练数据(即作为支持集)时,这些输入能够欺骗系统的学习算法。这样共同制作的对抗性输入可以协同操纵分类器,对于具有可微适应机制的摊销学习者来说,这种输入尤其容易计算。我们还在可解释性领域利用摊销学习者进行“数据集调试”,在此过程中,我们开发了一种称为Meta-LOO的数据价值或样本重要性策略,可用于检测噪声或分布外数据;或者将一组示例提炼到其最有用的元素。

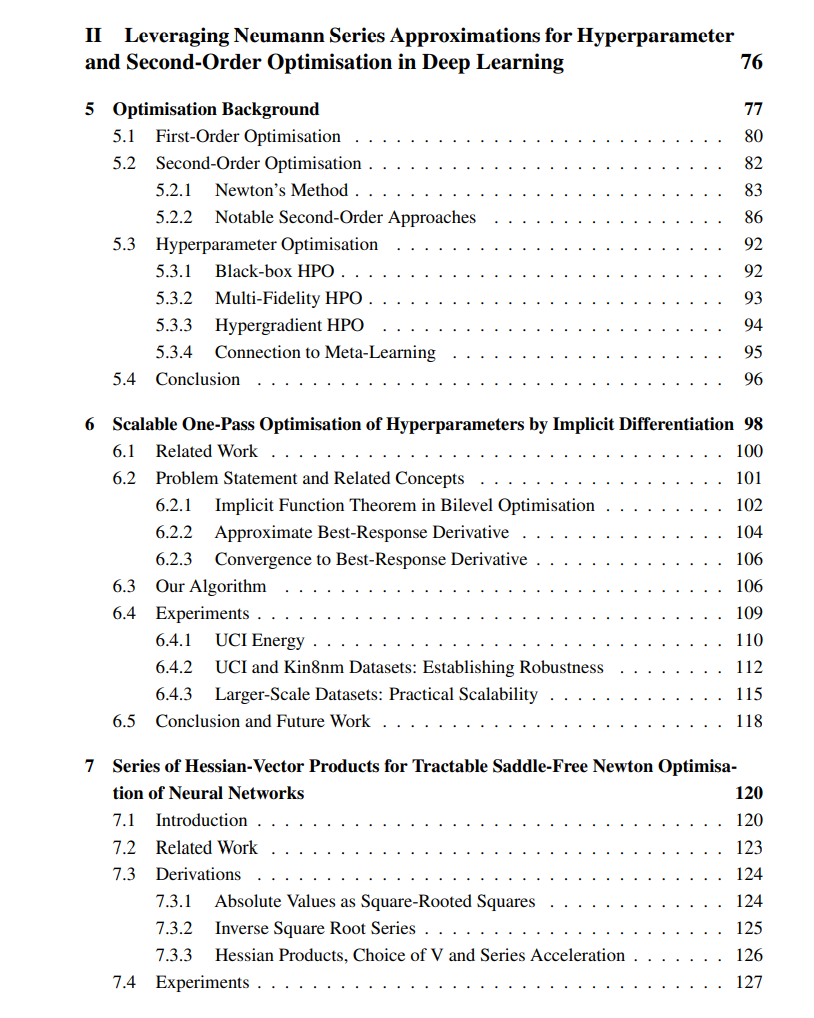

从我们的第二个角度看,机器学习和优化是密切相关的;实际上,学习可以被表述为以模型参数为目标的训练损失最小化问题——尽管实际上我们还需要我们的算法具有泛化能力,这不是更广泛优化的关注点。选择的优化策略影响了算法学习的速度以及找到的解决方案(即模型参数)的质量。通过研究优化,我们可以改善我们的模型的学习效果和速度。

在这篇论文中,我们采取了双管齐下的方法来实现这一目标。首先,我们开发了一种在线超梯度基础的超参数优化策略,通过支持广泛的超参数同时保持可扩展性,改进了现有的最佳技术。值得注意的是,我们的方法支持优化算法的超参数,如学习率和动量,这是文献中类似方法不支持的。其次,我们开发了一种适用于深度学习的非凸损失景观的二阶优化策略。我们的算法近似了一个鞍点是排斥而非吸引的鞍点自由版本的Hessian,以一种适用于深度学习问题的方式。