【对抗学习综述论文】-宾西法利亚大学-统计分类中的对抗性学习:对攻击防御的全面回顾

本文对对抗式学习攻击(adversarial learning attacks)进行详细综述,特别是针对统计分类器的攻击和防御。论文最后讨论了一些未来的研究方向。

编译:Xiaowen

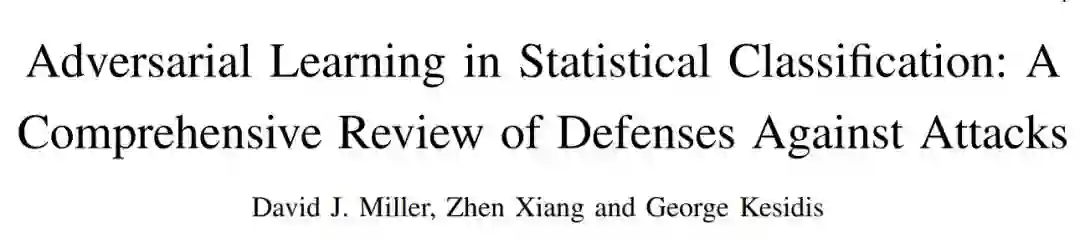

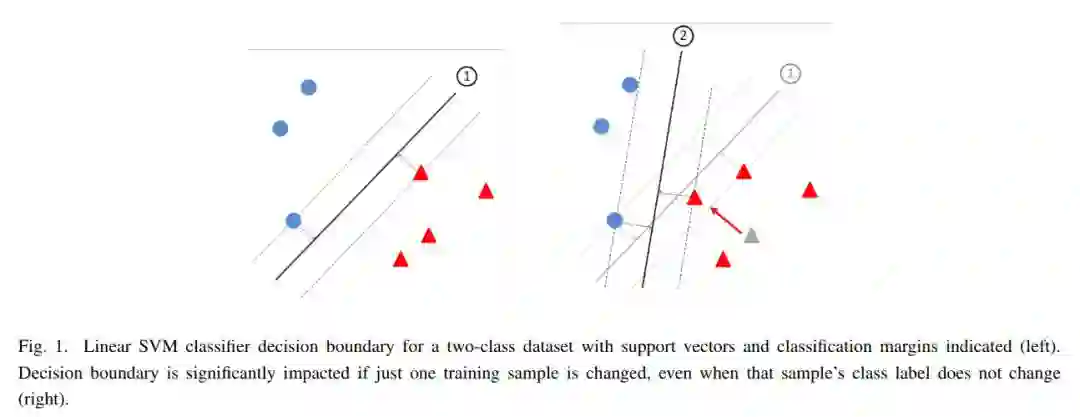

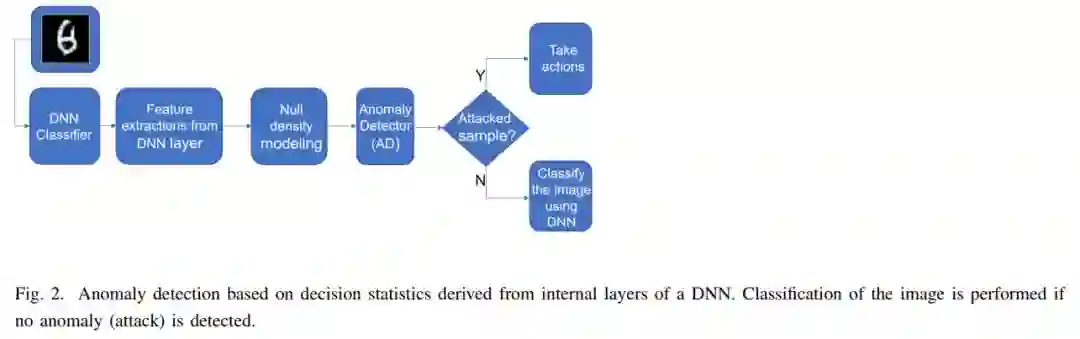

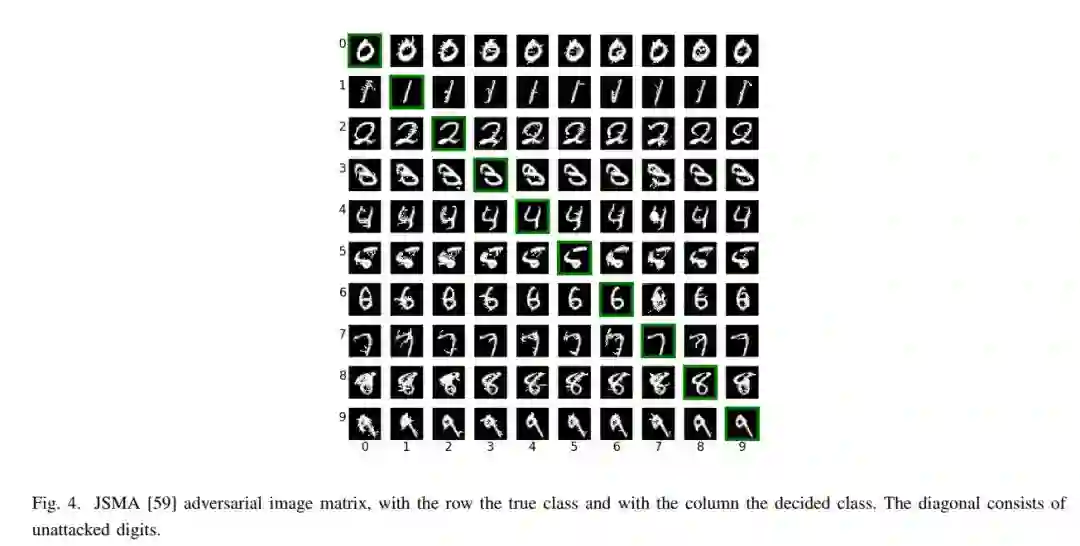

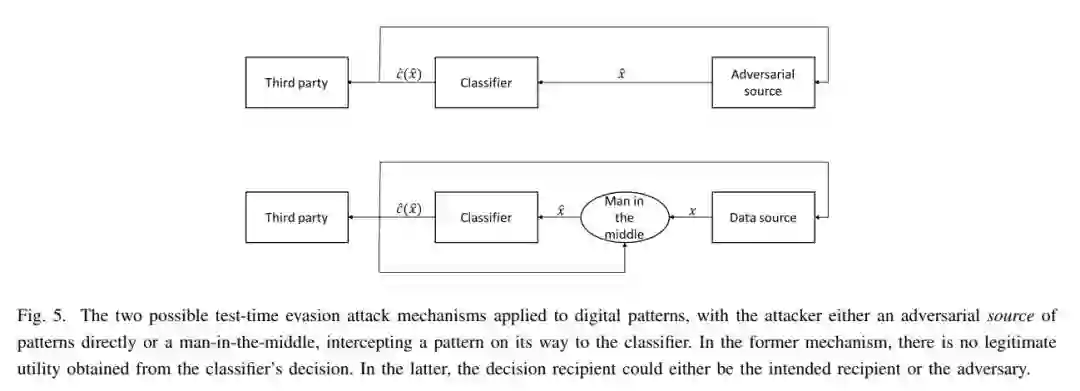

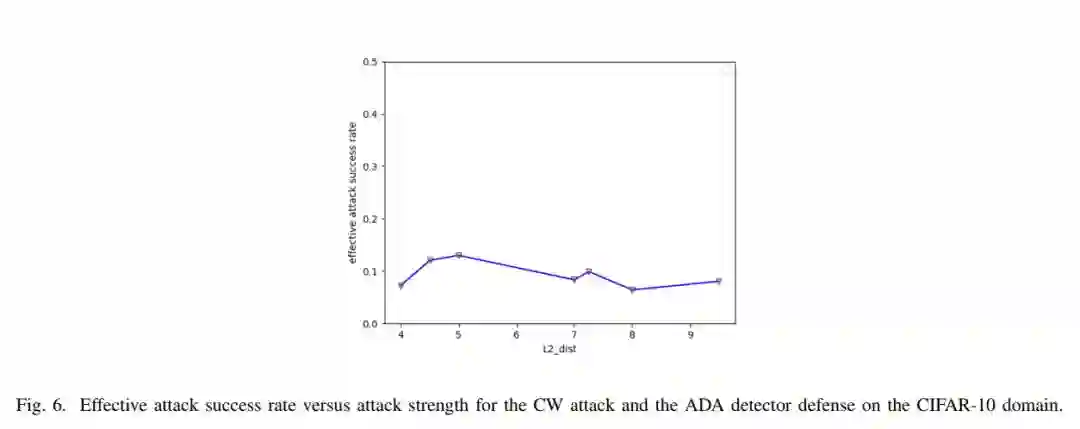

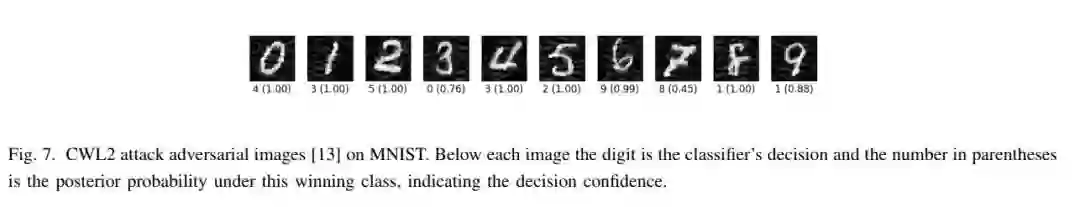

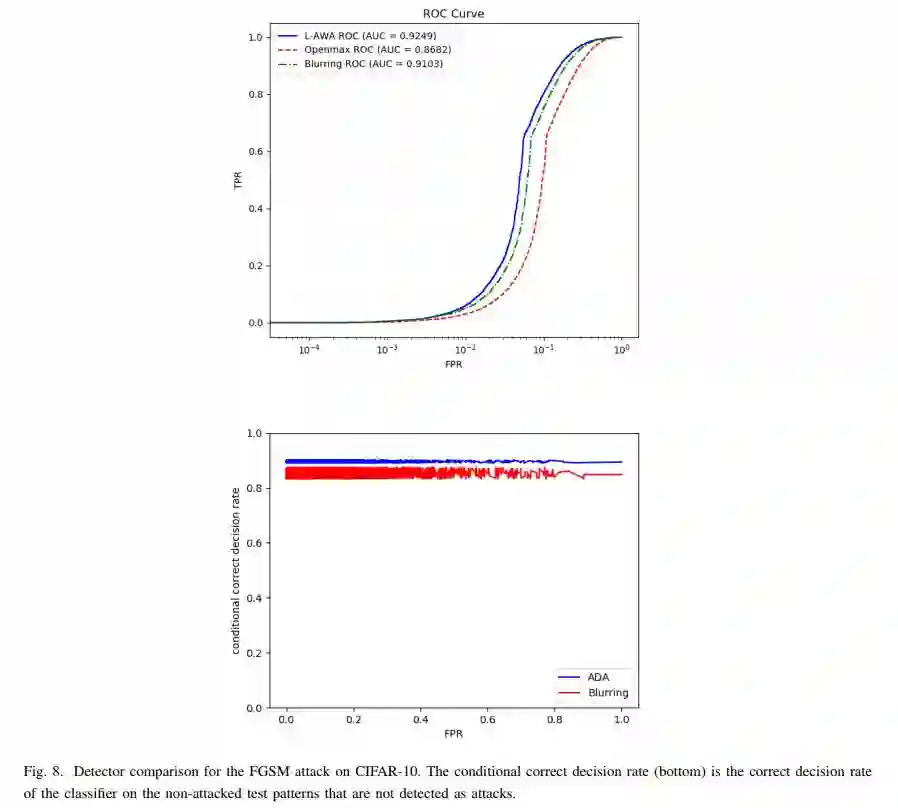

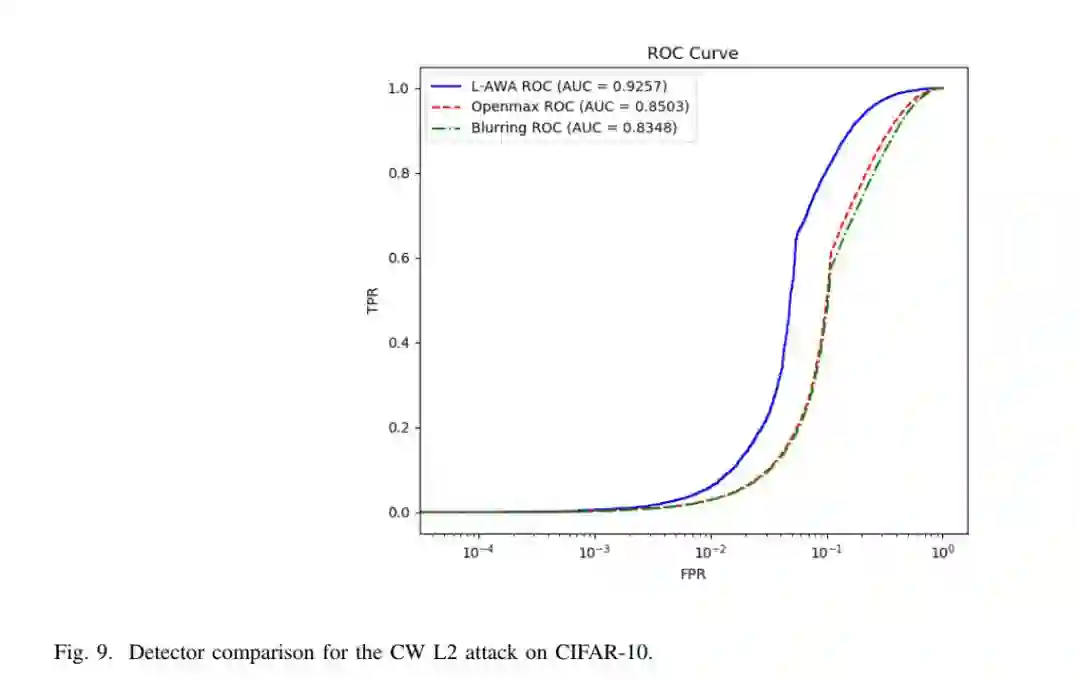

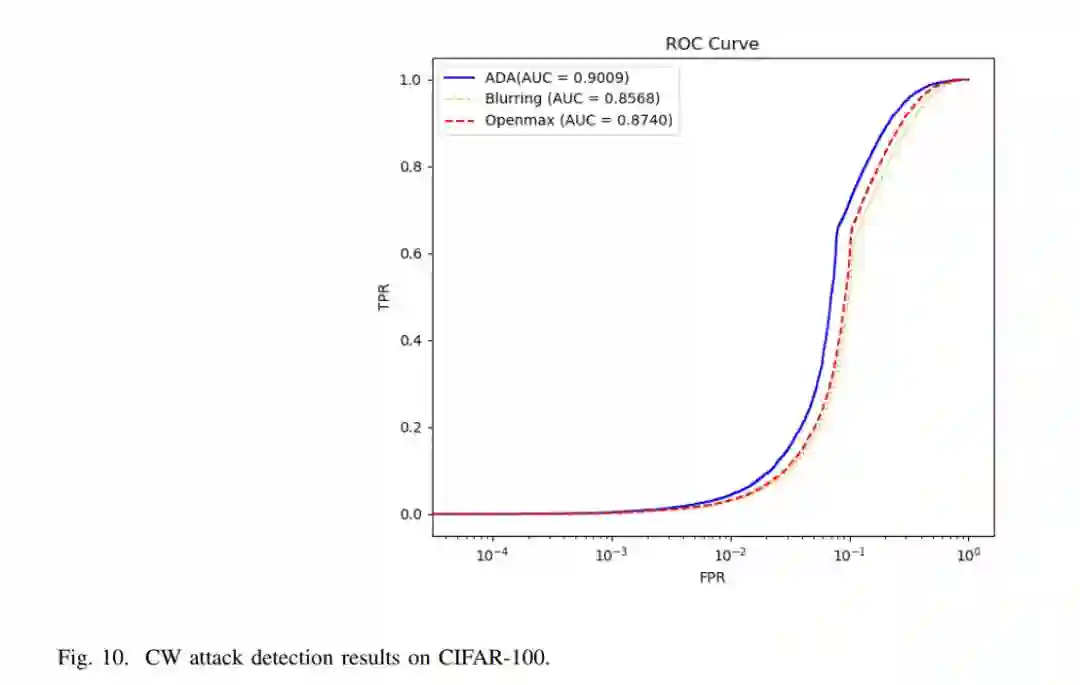

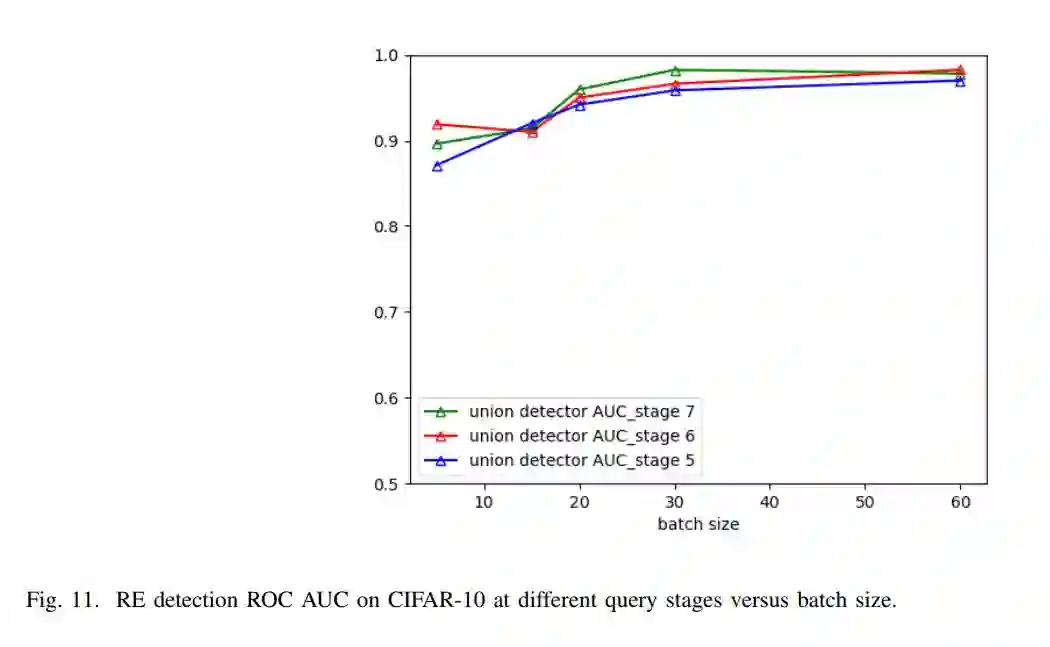

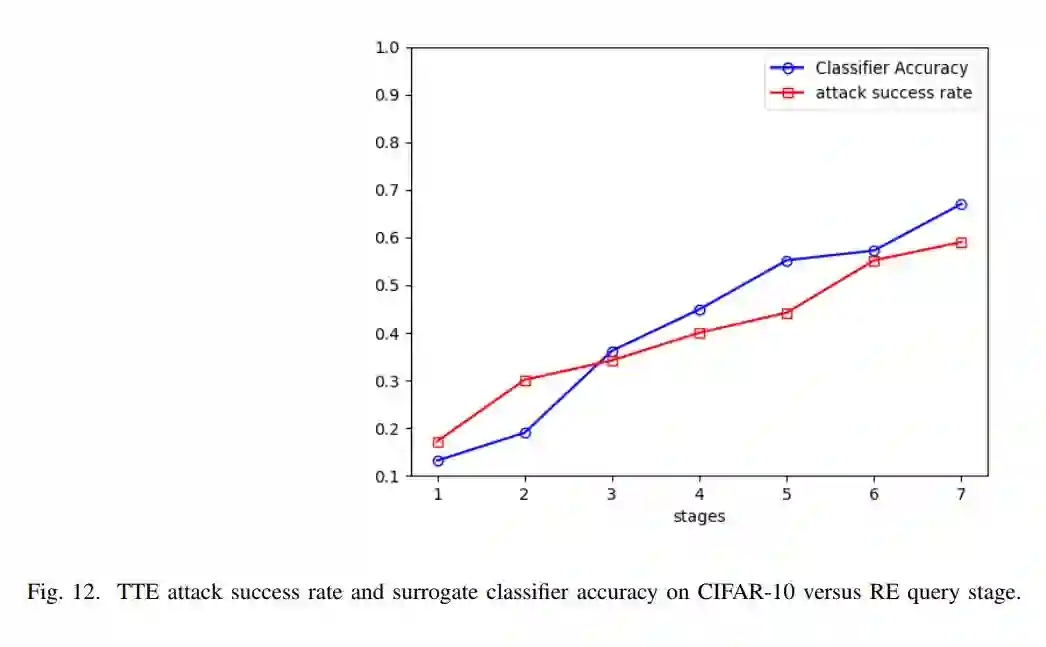

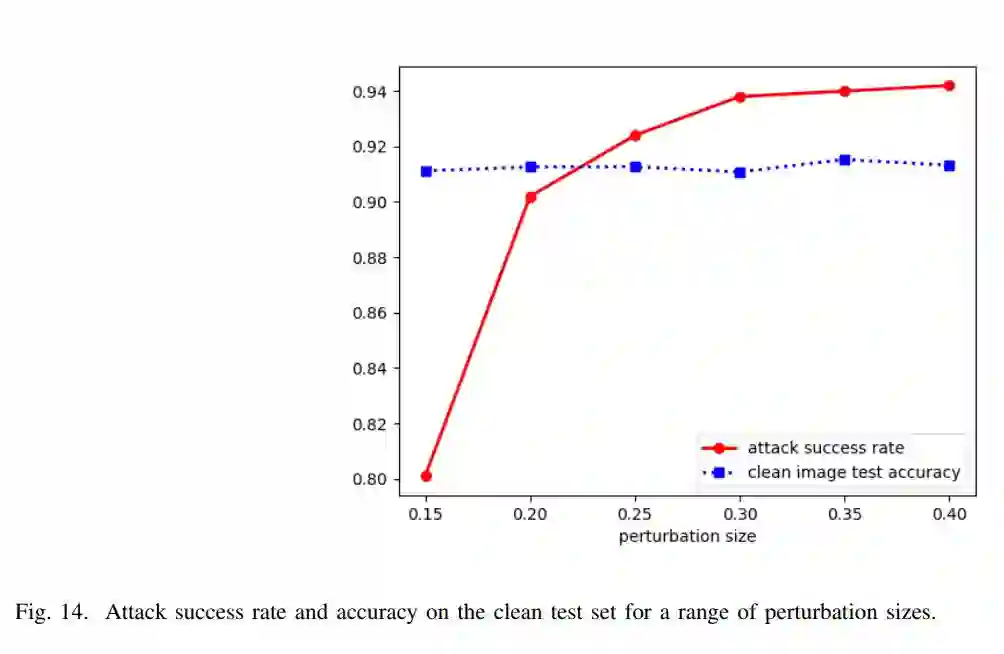

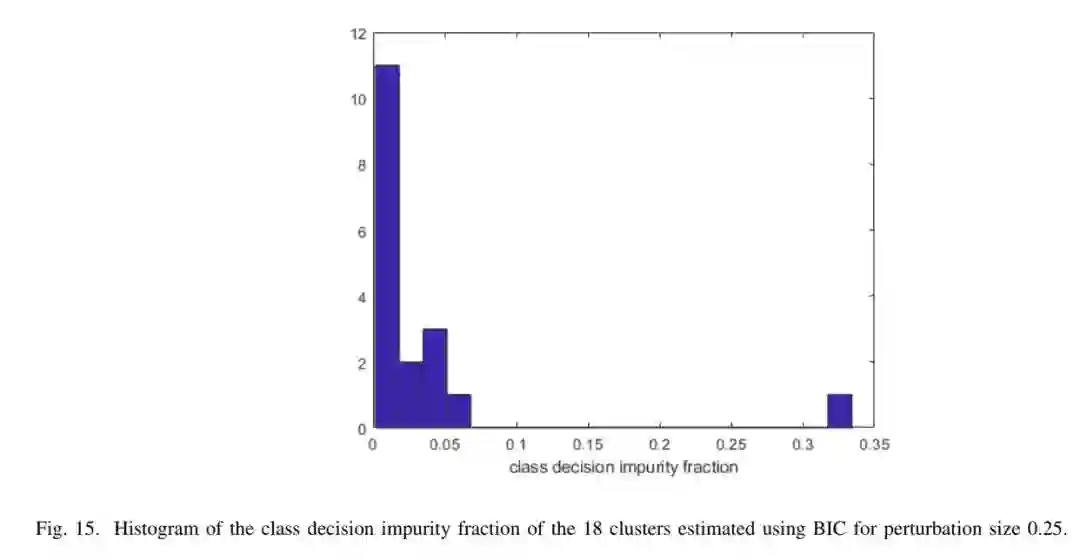

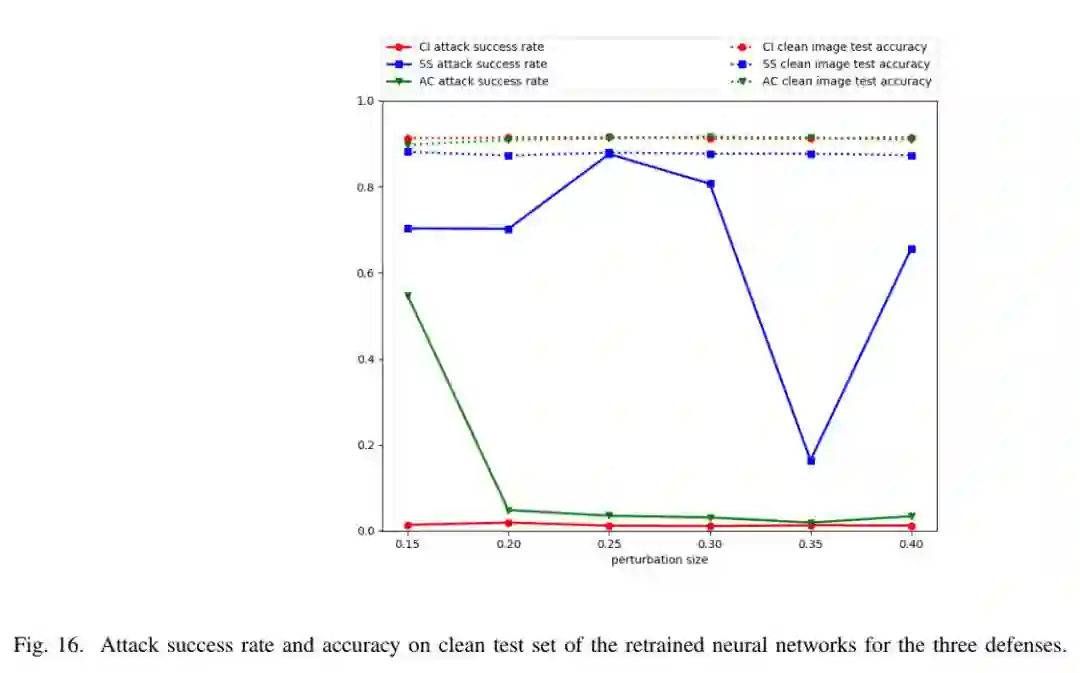

随着基于机器学习(ML)系统在医学、军事、汽车、基因组以及多媒体和社交网络等多种应用中的广泛应用,对抗式学习(AL)攻击(adversarial learning attacks)有很大的潜在危害。在这篇文章中,我们提供了一个关于AL的综述,特别是针对统计分类器的攻击的防御。在介绍了相关术语以及攻击者和维护者的目标和可能的知识范围后,我们回顾了最近在test-time evasion (TTE)、数据中毒(DP)和反向工程(RE)攻击方面的工作,特别是针对这些攻击的防御。在此过程中,我们将鲁棒分类与异常检测(AD)、无监督和基于统计假设的防御和无攻击(no attack)假设的防御区分开来;我们识别了特定方法所需的超参数、其计算复杂性以及评估其性能的指标和质量。然后,我们深入挖掘,提供新的见解,挑战传统智慧,并针对尚未解决的问题,包括:1)稳健的分类与AD作为防御策略;2)认为攻击的成功程度随攻击强度的增加而增加,这忽略了对AD的敏感性;3)test-time evasion (TTE)攻击的小扰动:谬误或需求?4)一般假设的有效性,即攻击者知道要攻击的示例的真实程度;5)黑、灰或白盒攻击作为防御评估标准;6)基于查询的RE对广告防御的敏感性。 然后,我们给出了几种针对TTE、RE和DP攻击图像的防御的基准比较。论文最后讨论了持续的研究方向,包括检测攻击的最大挑战,其目的不是改变分类决策,而是简单地嵌入“假新闻”或其他虚假内容,而不被发现。

【对抗学习综述论文便捷下载】

请关注专知公众号(点击上方蓝色专知关注)

后台回复“统计分类对抗学习”就可以获取《统计分类中的对抗性学习:对攻击防御的全面回顾》的论文下载链接~

未来的方向和挑战

A. Defence with a human-in-the-loop

即使基于广告的防御系统在检测TTE和DP攻击(真阳性率为1,假阳性率为零)方面取得了近乎完美的准确性,但在循环中有一名人类分析人员/专家将对描述检测到的攻击的性质和确定适当的响应行动(例如阻止攻击者未来访问的措施、潜在的报复)极为有用,终止可能基于TTE攻击或DP受损分类器决定的正在进行的操作)。人类对检测到的攻击进行分类还可以主动学习一个自动分类器,该分类器旨在模仿人类分析人员,即对异常进行分类,而不仅仅是检测异常。考虑到所检测到的异常的数量可能相当大,这样的自动分类器可能是非常有用的,而考虑到所需的努力和成本/专业知识,分析人员可能仅可以微操作以检查它们。

B. 虚假新闻和更广泛的注入内容攻击的挑战

(1)对分类器的复杂数据中毒攻击:我们已经展示了一些聚类和广告检测DP攻击的潜力。

(2)无监督学习环境中的数据中毒:考虑无监督的聚类/混合建模问题,尽管其中要分析的数据批已经中毒,包括来自不真实的集群/类的样本。一个好的聚类算法应该识别数据批中的所有集群,包括不真实的集群。

(3)“替代事实(Alternative Facts)”攻击

除了数据完整性之外,还有“实体完整性”攻击,实质上是寻求通过图灵测试,例如关于神经对话系统的工作。这些攻击更容易受到统计AD(或其他探测战略)的影响,因为增加对话所涉主题的持续时间和范围将最终考验人的(常识技能)熟悉限度,可能会产生统计上反常、逻辑上不一致的反应,或暴露出世界知识的巨大差距。

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!530+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程