随着神经网络在诸如刑事司法、医疗等高风险领域的应用日益增多,了解这些模型做出决策的原因变得越来越重要。例如,开发工具来分析模型是否在其未来的决策中延续了它们在训练数据中发现的有害的人口不平等至关重要。然而,神经网络通常需要大量训练数据集,具有“黑箱”决策特性,并且重新训练成本高昂,这增加了这个问题的难度。本文考虑三个问题。问题一)输入的各个元素与模型决策之间的关系是什么?问题二)单个训练点与模型决策之间的关系是什么。最后问题三)在多大程度上存在(有效的)近似方法,能够让实践者预测模型性能在不同训练数据或不同训练协议下的变化。

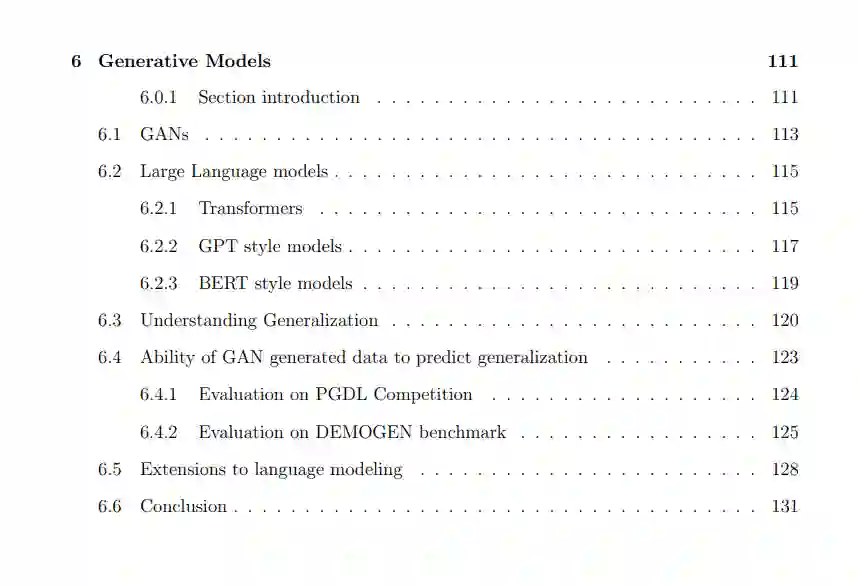

第一部分针对掩蔽显著性方法回答问题一。这些方法隐含地假设图像中的灰色像素是“无信息的”。我们通过实验发现,这一假设可能并非总是正确的,并定义了“健全性”,它衡量了显著性图的一种理想属性。第二部分在影响函数的背景下讨论问题二和问题三,这些函数旨在近似移除一个训练点对模型决策的影响。我们使用谐波分析来检查一种特定的影响方法,即数据模型,并发现数据模型的系数与目标函数的傅里叶系数之间存在关系。最后,第三部分在测试数据的背景下讨论问题三。首先,我们评估是否需要保留外部测试数据来近似元学习的外部循环,或者回收训练数据是否构成了一个足够的近似。我们发现保留的测试数据很重要,因为它学习到的表示是低秩的。然后,受到PGDL竞赛的启发,我们调查了尽管众所周知的限制,生成对抗网络(GAN)生成的数据是否可以用来近似泛化性能,当没有测试或验证集可用时,并发现它们可以做到这一点。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日