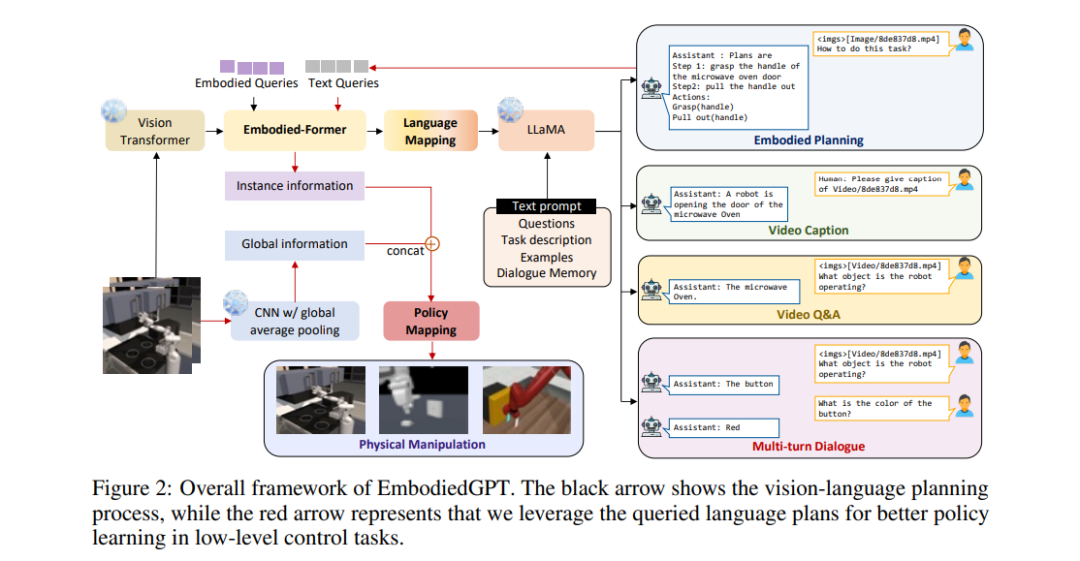

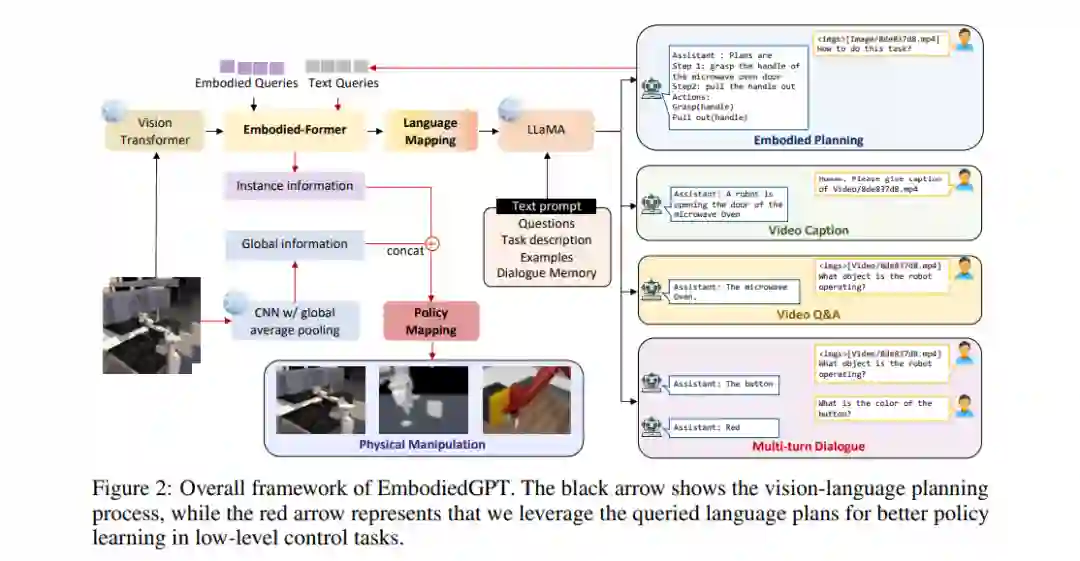

具身人工智能(Embodied AI)是机器人学的一个关键领域,能够为机器人规划和执行动作序列,以完成物理环境中的长时任务。在这项工作中,我们介绍了EmbodiedGPT,这是一个端到端的多模态基础模型,用于具身AI,赋予具身代理多模态理解和执行能力。为了实现这一目标,我们做出了以下努力:(i) 我们创建了一个大规模的具身规划数据集,名为EgoCOT。该数据集由从Ego4D数据集中精选的视频以及相应的高质量语言指令组成。具体来说,我们使用“思维链”模式生成一系列子目标,以实现有效的具身规划。(ii) 我们为EmbodiedGPT引入了一种高效的训练方法,通过前缀调整,将一个7B大的语言模型(LLM)适应到EgoCOT数据集,以生成高质量的规划。(iii) 我们引入了一种从LLM生成的规划查询中提取与任务相关特征的范例,形成了高级规划与低级控制之间的闭环。大量实验证明了EmbodiedGPT在具身任务上的有效性,包括具身规划、具身控制、视觉字幕和视觉问题回答。值得注意的是,EmbodiedGPT通过提取更有效的特征显著提高了具身控制任务的成功率。与使用Ego4D数据集微调的BLIP-2基线相比,它在Franka Kitchen基准上的成功率增加了1.6倍,在Meta-World基准上增加了1.3倍。

https://www.zhuanzhi.ai/paper/7f64b8ca9b167779aaf8999f66e2161d

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日