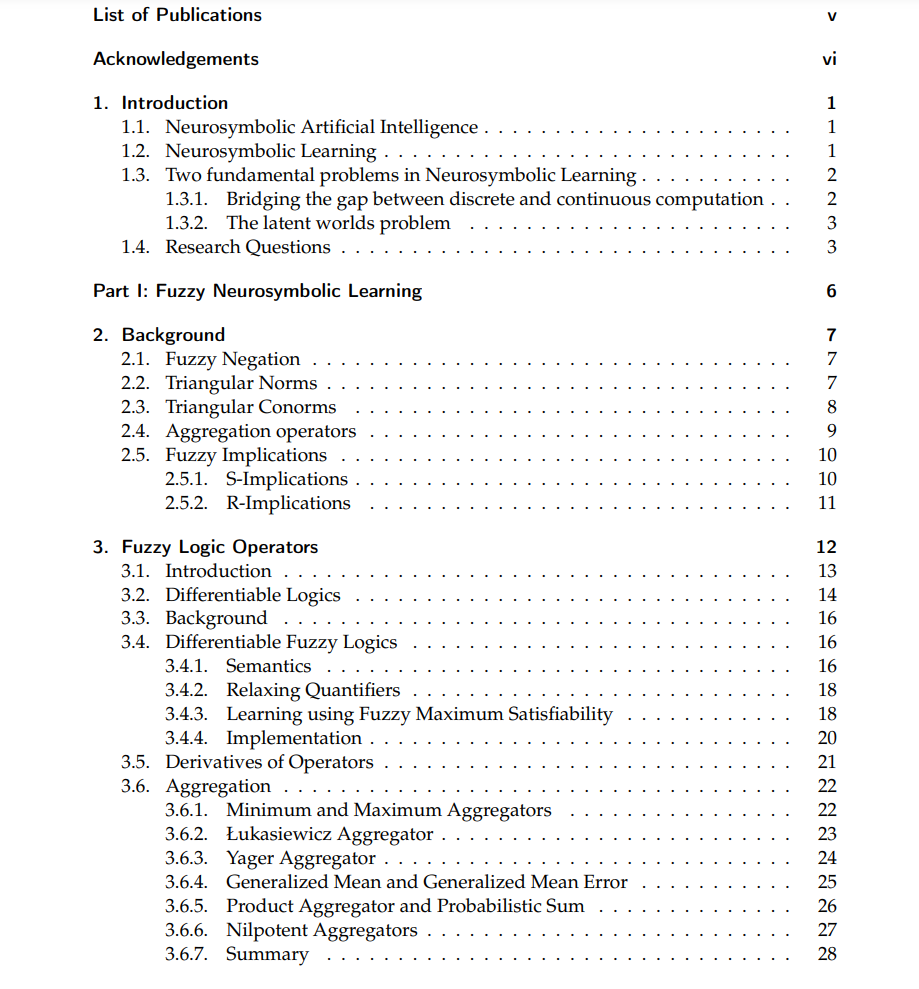

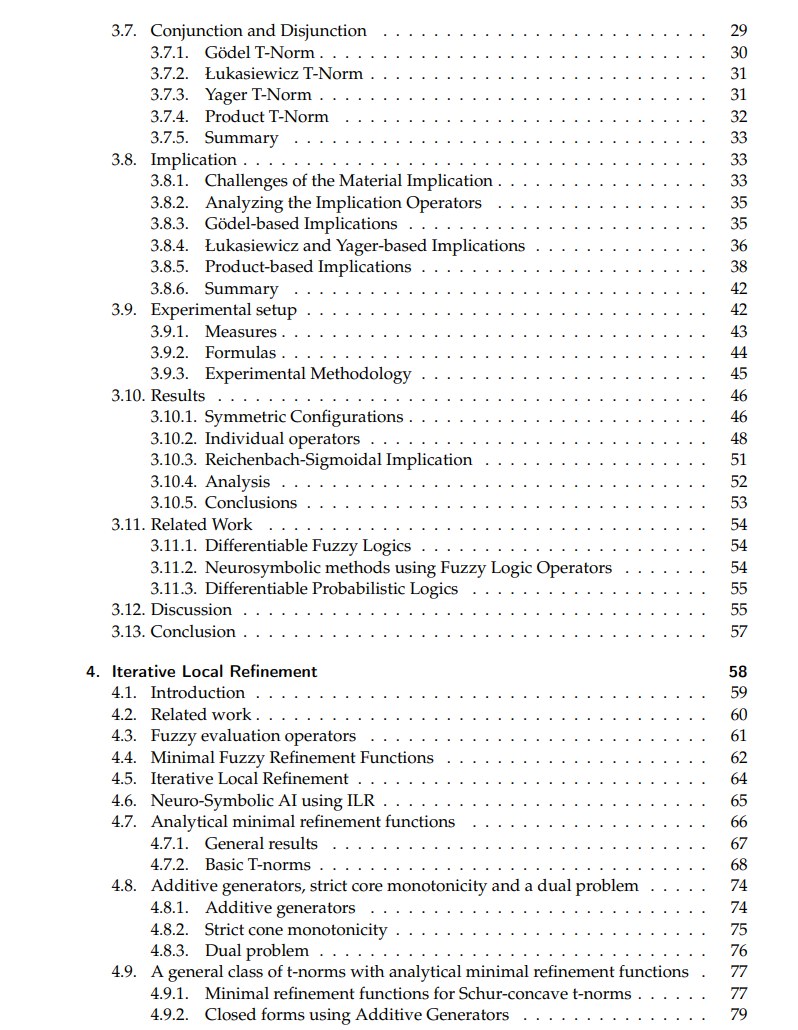

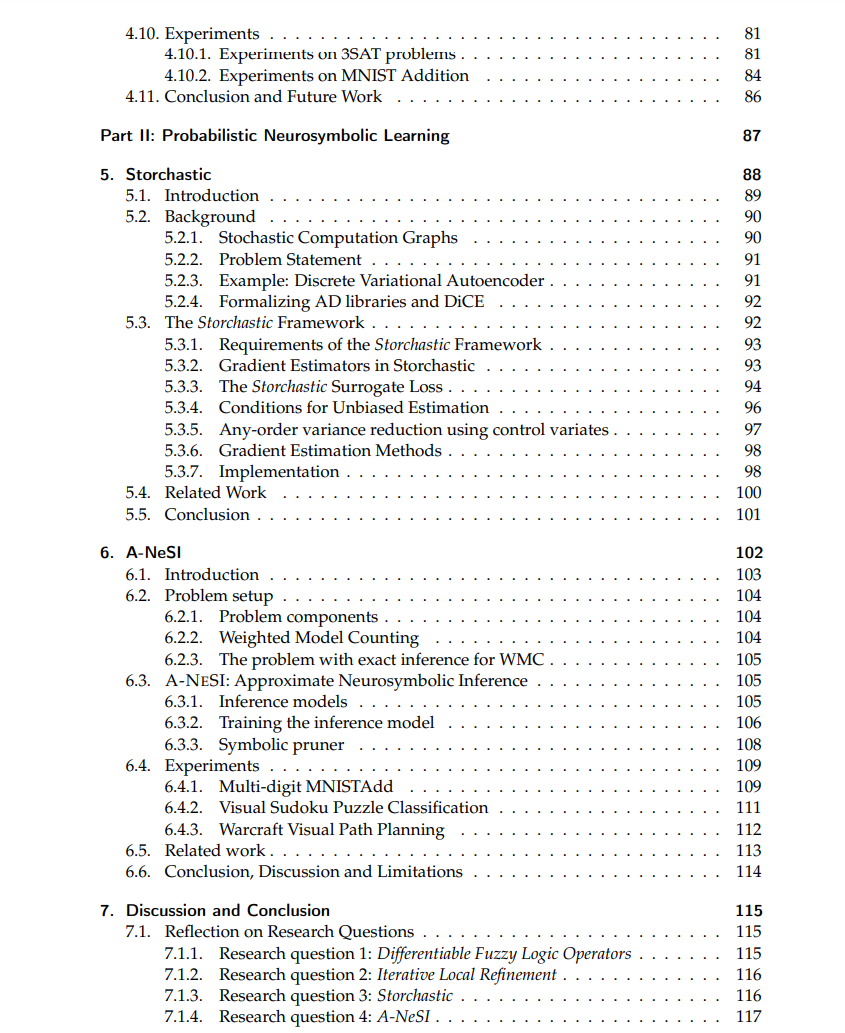

在过去几年中,人工智能(AI)通过诸如聊天机器人、图像生成器、语音合成和转录等高调应用进入了公众意识。这些都归功于深度学习的成功:从大量数据中学习任务的机器学习算法。用于深度学习的神经网络模型涉及许多参数,通常达到数十亿个。这些模型经常无法处理计算机传统上擅长的任务,如计算算术表达式、推理多种不同的信息、规划和调度复杂系统以及从数据库中检索信息。这些任务传统上使用基于逻辑和正式推理的人工智能中的符号方法来解决。而神经符号AI旨在将深度学习与符号AI整合。这种整合有许多承诺,例如减少训练神经网络所需的数据量,提高模型给出答案的可解释性和可解读性以及验证训练系统的正确性。我们主要研究神经符号学习,其中我们除了数据之外,还有用符号语言表达的背景知识。我们如何连接符号和神经组件,以将这些知识传达给神经网络?

我们考虑两个答案:模糊和概率推理。模糊推理研究真理的程度。一个人可能非常高或有点高:高度不是一个二元概念。相反,概率推理研究某事是真的或将发生的概率。硬币有0.5的可能性正面朝上。我们从不说它落在了“有点正面”。当我们使用模糊(第一部分)或概率(第二部分)方法进行神经符号学习时会发生什么?此外,这些方法是否使用了我们期望它们使用的背景知识?我们的第一个研究问题研究了不同形式的模糊推理如何与学习结合。我们发现了一些令人惊讶的结果,如与乌鸦悖论的联系,该悖论指出,当我们观察到一个绿苹果时,我们确认“乌鸦是黑色的”。在这项研究中,我们给神经网络一个由背景知识创建的训练目标。然而,当我们部署我们的模型进行训练后,我们没有使用背景知识。在我们的第二个研究问题中,我们研究了如何在部署模型中使用背景知识。为此,我们开发了一个基于模糊推理的新神经网络层。其余的研究问题研究了概率方法在神经符号学习中的应用。概率推理是神经网络的自然选择,我们通常训练它们是概率性的。然而,概率方法有一个成本:它们计算昂贵,并且不适合大规模任务。在我们的第三个研究问题中,我们研究了如何通过抽样来估计平均值,将概率推理与神经网络连接起来。抽样避免了为所有输入组合计算推理结果。在第四个也是最后一个研究问题中,我们研究了将概率神经符号学习扩展到以前不可能的更大问题。我们的洞察是训练一个神经网络来预测概率推理的结果。我们仅使用背景知识进行这一训练过程:我们不收集数据。这与优化有什么关系?所有研究问题都与优化问题相关。在神经符号学习中,使用像梯度下降这样的流行方法进行优化是一种推理形式。有充分的机会研究这种优化视角如何改进我们的神经符号学习方法。我们希望这篇论文能提供一些必要的答案,使实用的神经符号学习成为现实:从业者提供数据和知识,神经符号学习方法尽可能高效地使用它们来训练下一代神经网络。

https://research.vu.nl/en/publications/optimisation-in-neurosymbolic-learning-systems