情感计算(Affective Computing,AC)集成了计算机科学、心理学和认知科学的知识,旨在使机器能够识别、解释和模拟人类情感。为了创造更多价值,AC可以应用于多种场景,包括社交媒体、金融、医疗、教育等。情感计算包括两个主流任务,即情感理解(Affective Understanding,AU)和情感生成(Affective Generation,AG)。针对AU任务进行的预训练语言模型(Pre-trained Language Models,PLMs)微调已经取得了显著成功。然而,这些模型缺乏泛化能力,通常需要为特定任务定制专门的模型。此外,传统的PLMs在AG任务中面临挑战,尤其是在生成多样化且情感丰富的回应方面。随着大型语言模型(Large Language Models,LLMs)的兴起,如ChatGPT系列和LLaMA模型,为情感计算带来了新的机遇和挑战,促使该领域发生范式转变。LLMs具备上下文学习、常识推理和高级序列生成的能力,为AU任务提供了前所未有的机会。为了从自然语言处理(NLP)角度全面概述LLMs时代的情感计算,我们总结了这一领域LLMs研究的发展,旨在提供新的见解。具体而言,我们首先总结了与AC相关的传统任务,并介绍了基于LLMs的初步研究。随后,我们概述了流行LLMs提升AC任务的相关技术,包括指令微调(Instruction Tuning)和提示工程(Prompt Engineering)。在指令微调中,我们讨论了全参数微调和参数高效方法,如LoRA、P-Tuning和Prompt Tuning。在提示工程中,我们探讨了用于AU和AG的零样本、少样本、链式思维(Chain of Thought,CoT)以及基于代理的方法。为了清楚了解LLMs在不同情感计算任务中的表现,我们进一步总结了现有的基准和评估方法。最后,我们从NLP角度讨论了诸如伦理考虑和有效评估等挑战,并概述了未来的发展方向。我们的综述旨在为这一快速发展的领域的研究人员提供有价值的见解和参考。

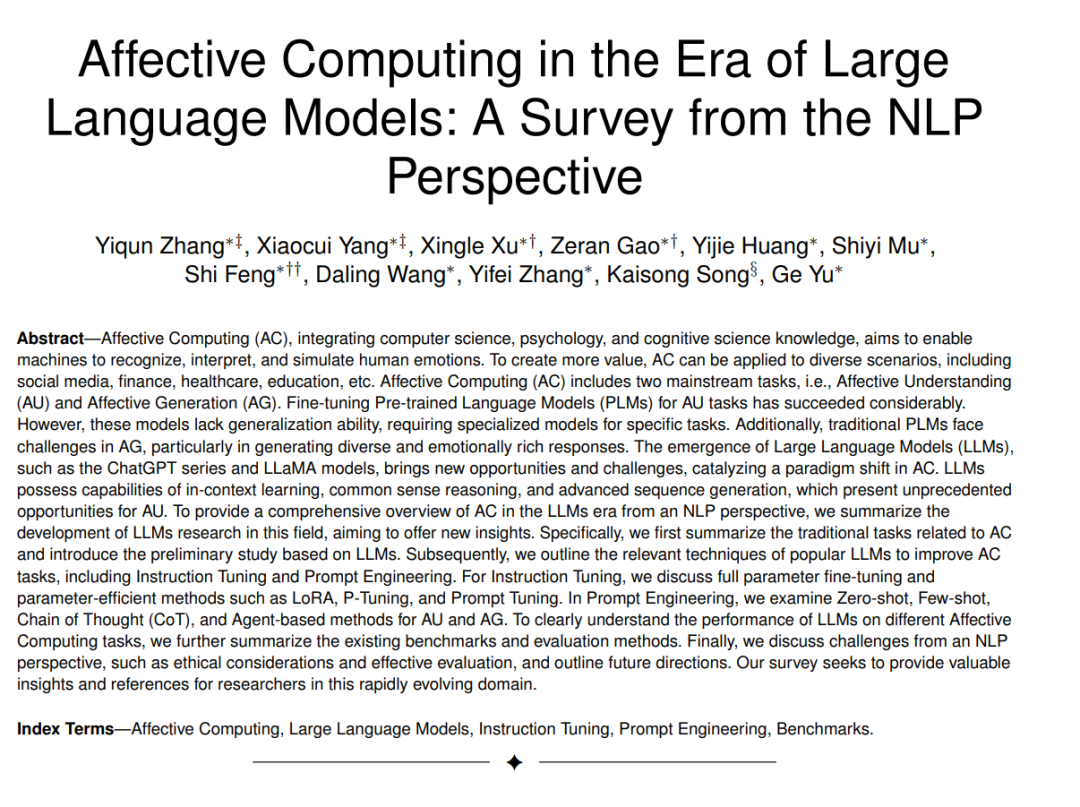

情感计算(Affective Computing,AC)涵盖了研究和开发能够通过自然语言及其他模态识别、解释、处理和模拟人类情感的系统,旨在弥合人类情感与机器理解之间的差距[1, 2, 3]。AC任务大致可分为两类主流任务:情感理解(Affective Understanding,AU)任务[4]和情感生成(Affective Generation,AG)任务[5, 6]。情感理解专注于识别和解释人类情感,包括情感分析[7, 8]、讽刺检测[9, 10]等。情感生成则涉及创建能够引发人类特定情感反应的内容或回应,以生成具有情感细微差别的表达形式,包括情感感知对话生成[11, 12]、创意内容生成等。随着大型语言模型(Large Language Models,LLMs)的出现[13, 14, 15],情感计算任务正在经历范式转变,以前所未有的方式探索和建模人类情感。 在LLMs出现之前,情感计算的主流范式是通过在标注数据集上微调预训练语言模型(Pre-trained Language Models,PLMs)[19],如BERT[20]和RoBERTa[21],以提升特定任务的表现。尽管这一训练范式在情感理解相关任务中取得了诸多成功,但其本质上仍受到人工标注数据的质量和规模的限制,难以泛化到新的领域[22]。如图1所示,LLMs研究的兴起深刻地改变了情感计算的研究范式,拓展了任务的多样性,超越了之前研究中的限制,这些研究往往集中于特定数据集和单一任务的性能提升[23, 24]。这种演变伴随着开发新方法以利用LLMs的广泛知识[25],以同时提升与情感计算相关的各种任务的表现。大型语言模型的自回归性质和大规模预训练使其在处理对话输入和生成连贯回应方面具有优势[26, 27]。 为了充分利用和增强LLMs的能力,提出了多种技术,包括指令微调(Instruction Tuning)和提示工程(Prompt Engineering)。具体而言,指令微调[28, 29]涉及在一个明确定义任务指令的数据集上微调预训练语言模型。例如,Flan-T5[28]为不同任务设计了具体的指令,如情感分析、常识推理、问答等。指令微调是一种目标明确的训练形式,旨在使模型更善于在不同领域内遵循复杂和多样的指令。另一方面,提示工程[30, 31]更注重如何设计输入以引导模型生成期望的输出,而无需修改模型本身。上下文学习(In-context Learning)可以进一步挖掘模型,根据直接在提示中提供的实例学习和应用知识,而无需对这些特定任务进行事先的明确训练[32]。虽然LLMs在各种任务中提供了新的机会并初步显示出成功,但目前尚缺乏从NLP角度对LLMs在情感计算中应用的综合评述。现有的综述要么专注于诸如情感分析等特定任务[23, 33, 34, 35, 36],要么集中于传统的非LLM方法[19, 37]。 为弥补这一空白,亟需提供一个全面的概述,说明LLMs如何在广泛的AC相关任务中应用,以及它们带来的独特机遇和挑战。因此,我们研究了LLMs在情感计算任务中的能力和局限性,涵盖情感理解和情感生成。虽然我们的重点主要是NLP,但我们也包括了以文本为中心的多模态情感计算任务,认识到在AC中整合多种模态的重要性。我们首先总结了为理解LLMs在AC中的能力和局限性奠定基础的早期研究。在此基础上,我们探讨了两项关键技术,用于将LLMs适应AC任务:指令微调和提示工程。这涉及回顾旨在提高LLMs在AC任务中表现的各种微调方法,随后探讨不同的提示策略,以期望从LLMs中引出特定的情感响应。为了提供全面的评估,我们进一步总结了用于系统性评估LLMs在AC中的表现的基准和评估方法,包括创新性地使用LLMs作为评估工具。最后,我们列出了尚待解决的挑战,并概述了有前途的未来研究方向,为这一快速发展的领域的持续演进和潜力提供了见解。 2 任务 情感计算(Affective Computing,AC)的主流任务包括情感理解(Affective Understanding,AU)[4]和情感生成(Affective Generation,AG)[5, 6]。AU和AG的主要传统任务及其相关子任务在表1中进行了总结。

2.1 情感理解

**2.1.1 情感分析

AU任务旨在增强模型识别和理解各种情感的能力,其中情感分析(Sentiment Analysis,SA)是核心任务。SA中的最基本任务是极性分类(Polarity Classification,PC)任务[64],通常需要判断给定文本的情感是负面、正面还是中立。然而,由于PC任务仅将情感分为两到三类,更多标签的情感分类(Emotional Classification,EC)任务[65, 66]已经出现,以更好地区分情感。 另一个关键任务是基于方面的情感分析(Aspect-Based Sentiment Analysis,ABSA)[67, 68],它不同于PC和EC,因为它专注于更具体的方面或属性的情感分析。为了实现更细粒度的情感分析,ABSA包括一系列子任务。其基础在于从文本中识别出具体的方面或属性,这一过程被称为方面术语提取(Aspect Term Extraction,ATE)[69, 70]。一旦这些具体方面被识别出来,下一步就是针对每个方面进行情感分析,即面向方面的情感分类(Aspect-Oriented Sentiment Classification,ASC)[71, 72]。该任务旨在确定用户对每个方面的情感。为了进一步提高分析的效率和准确性,研究人员提出了联合方面-情感分析(Joint Aspect-Sentiment Analysis,JASA)[73]。该方法通过联合建模,将方面提取与情感分类结合起来,更好地捕捉方面与情感之间的关系,并提升整体性能。在此基础上,方面-类别-观点-情感(Aspect-Category-Opinion-Sentiment,ACOS)任务[74]进一步扩展了分析的维度,考虑了不仅是方面和情感,还包括类别和具体观点。 除了对情感标签和方面的更细粒度研究外,SA任务还探索了情感强度的量化,称为情感强度检测(Emotional Intensity Detection,EID)[75, 76]。EID不仅识别情感类型,还评估其强度。此外,考虑到人类情感并不总是明确表达在文本中,研究人员提出了隐含情感分析(Implicit Sentiment Analysis,ISA)任务[77, 78]。ISA旨在识别和分析文本中未通过显式情感词汇或表达传达的隐含情感。此外,认识到情感可以通过文本以外的多种模态表达,研究人员引入了多模态情感分析(Multimodal Sentiment Analysis,MSA)任务[79, 80],整合文本、视觉和声学信息,以提供更全面的情感理解。 从最初的SA到更细粒度的ABSA、EID和ISA,再到MSA,SA任务不断朝着更深入、全面和准确的方向发展,以更好地理解和应用人类情感。随着人机交互技术的不断发展[81],对话中的情感识别(Emotion Recognition in Conversation,ERC)[65, 82, 83]变得越来越重要。一个更具挑战性的任务,多模态对话中的情感和意图联合理解(Emotion and Intent Joint Understanding in Multimodal Conversation,MC-EIU)被提出。MC-EIU旨在解码多模态对话历史中表现出来的语义信息,同时推断当前话语中的情感和意图[84]。ERC任务要求识别每个话语中表达的情感,并在对话的上下文中跟踪情感动态,以全面理解这些动态。在一个相关但不同的方向上,情感原因对提取(Emotion Cause Pair Extraction,ECPE)[85]任务专注于从文本中提取情感及其相应的原因。该任务需要准确识别情感表达并找出这些情感的具体原因。

**2.1.2 主观文本分析

虽然AC领域内的SA和ERC已经取得了显著进展,研究人员同时也在探索主观文本分析(Subjective Text Analysis,STA)的潜力,以更深入地了解用户体验和观点的细微差别。这一新兴研究领域通过深入挖掘文本信息中揭示的用户意图和态度的复杂性,得到了丰富。 具体而言,STA涵盖了多种任务,如人格评估(Personality Assessment)[86]、自杀倾向检测(Suicide Tendency Detection)[87]、毒性检测[88]、讽刺检测(Sarcasm Detection)[89]、幸福感评估(Well-being Assessment)[89]以及参与度测量[90],所有这些任务都旨在分析文本中的主观情感、意见和态度。与经典的SA相比,这些任务得到的关注和研究资源较少。

2.2 情感生成

**2.2.1 情感对话

情感生成(Affective Generation,AG)旨在增强系统对不同情感做出反应并与之互动的能力。在这一领域,同理心回应生成(Empathetic Response Generation,ERG)[11]和情感支持对话(Emotional Support Conversation,ESC)[12]是两个突出的研究方向。ERG任务专注于训练模型理解对话的内容和情感细微差别,从而生成适当的、富有同理心的回应。随着多模态数据和研究的兴起,研究人员认识到多模态回应在这些模型中培养同理心的有效性,推动了多模态同理心回应生成(Multimodal Empathetic Response Generation,MERG)的发展[80, 55]。 与此相反,ESC任务采用更有针对性的方法,为用户提供专业的情感支持,并帮助他们应对情感挑战。因此,评估情感支持对话任务时,除了要考虑传统的对话评估指标外,还需考虑所提供的情感支持的有效性[12, 66]。

**2.2.2 评论总结

评论总结(Review Summarization,RS)是一个更广泛的任务,而意见总结(Opinion Summarization,OS)是其核心组成部分。意见总结[90, 91]是自动化地将关于特定主题的多条意见(通常来自社交媒体和用户生成内容)压缩为简洁且有意义的摘要。其目标是帮助用户快速了解某个主题的整体情感和关键点,而无需阅读大量文本。然而,由于社交媒体内容的非结构化和噪声特性,以及讽刺和多样化语言使用等问题,这一任务面临着挑战。 值得注意的是,在LLM时代之前,由于模型能力和技术的限制,AG研究相对滞后于AU。然而,随着LLMs出色的序列生成能力的出现,为情感生成带来了新的可能性,使其成为LLM时代研究的焦点[92]。

2.2 情感生成

**2.2.1 情感对话

情感生成(Affective Generation,AG)旨在增强系统对不同情感做出反应并与之互动的能力。在这一领域,同理心回应生成(Empathetic Response Generation,ERG)[11]和情感支持对话(Emotional Support Conversation,ESC)[12]是两个突出的研究方向。ERG任务专注于训练模型理解对话的内容和情感细微差别,从而生成适当的、富有同理心的回应。随着多模态数据和研究的兴起,研究人员认识到多模态回应在这些模型中培养同理心的有效性,推动了多模态同理心回应生成(Multimodal Empathetic Response Generation,MERG)的发展[80, 55]。 与此相反,ESC任务采用更有针对性的方法,为用户提供专业的情感支持,并帮助他们应对情感挑战。因此,评估情感支持对话任务时,除了要考虑传统的对话评估指标外,还需考虑所提供的情感支持的有效性[12, 66]。

**2.2.2 评论总结

评论总结(Review Summarization,RS)是一个更广泛的任务,而意见总结(Opinion Summarization,OS)是其核心组成部分。意见总结[90, 91]是自动化地将关于特定主题的多条意见(通常来自社交媒体和用户生成内容)压缩为简洁且有意义的摘要。其目标是帮助用户快速了解某个主题的整体情感和关键点,而无需阅读大量文本。然而,由于社交媒体内容的非结构化和噪声特性,以及讽刺和多样化语言使用等问题,这一任务面临着挑战。 值得注意的是,在LLM时代之前,由于模型能力和技术的限制,AG研究相对滞后于AU。然而,随着LLMs出色的序列生成能力的出现,为情感生成带来了新的可能性,使其成为LLM时代研究的焦点[92]。

3 指令微调

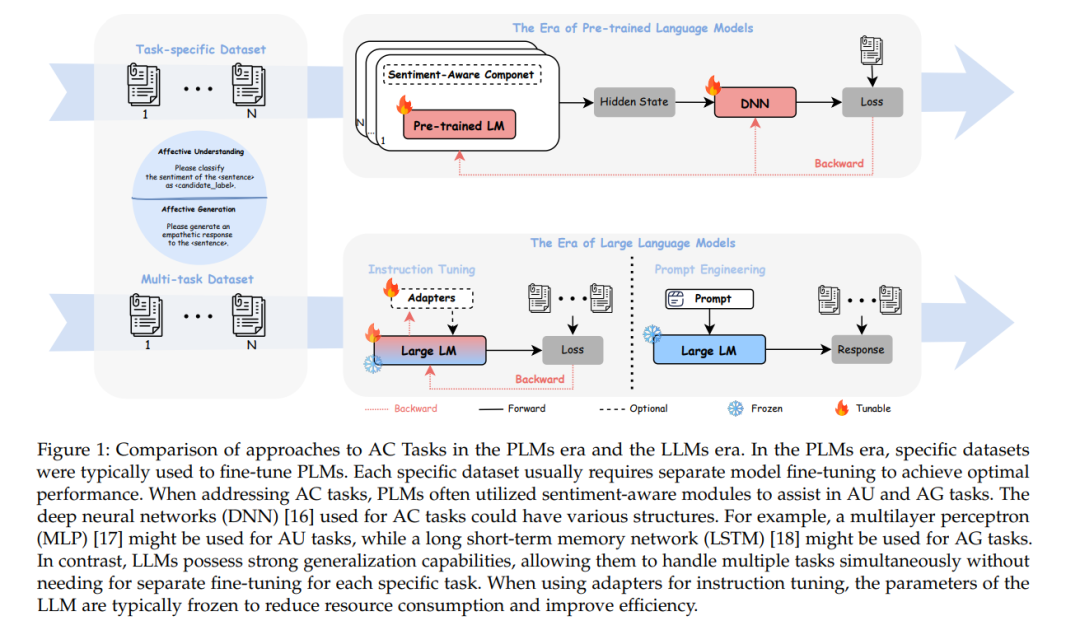

大型语言模型(LLMs)在不同任务上表现出色,如问答、序列生成等[115]。指令微调(Instruction Tuning)[116]被引入以适应LLMs在特定任务中的应用,从而在保持原始模型优势的同时,提升LLMs在专门下游任务中的性能。 由于LLMs的规模通常超过数十亿参数,对整个模型的所有参数进行全参数微调(Full Parameter Fine-Tuning,FPFT)在实践中可能并不实际。为降低模型训练成本,提出了一系列参数高效微调(Parameter-Efficient Fine-Tuning,PEFT)方法,如LoRA[117]、前缀微调(Prefix Tuning)[118]和P-Tuning[119],如图2所示。LoRA通过冻结所有原始参数,并在原始权重旁边注入一对低秩分解矩阵,减少了微调过程中需要训练的参数数量。前缀微调通过在LLM的输入序列中添加与特定任务相关的可训练“前缀”令牌作为隐式可学习提示,涉及在Transformer的每一层中插入可训练的自由向量。在情感计算任务中应用PEFT进行指令微调可以有效降低训练成本。

提示工程

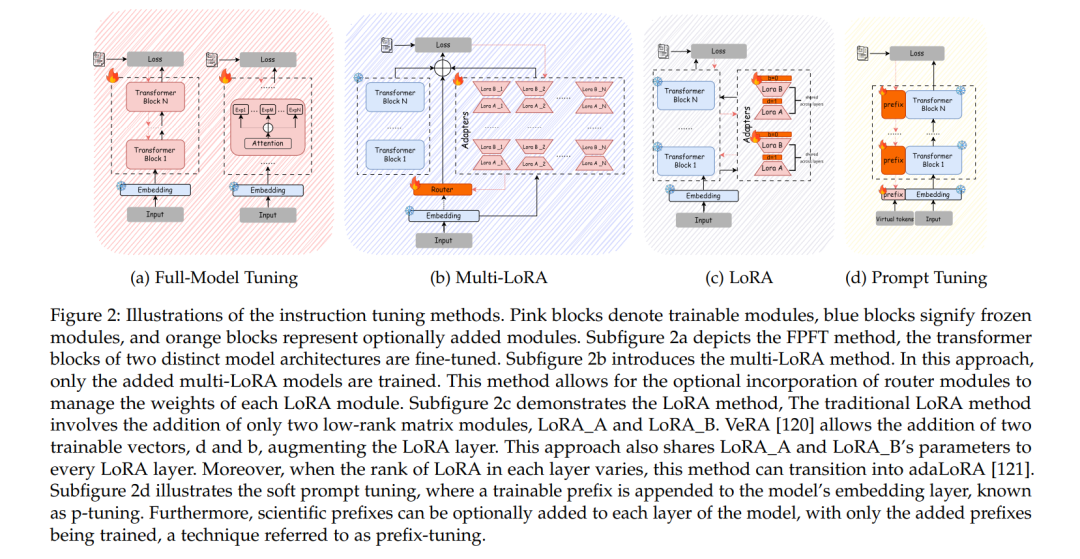

大型语言模型(LLMs)凭借其强大的理解和生成能力,为与情感计算(AC)相关的任务开辟了新途径。尽管通过预训练或监督微调(SFT)可以提升LLMs的表现,但有效利用LLMs进行AC任务仍然具有挑战性。提示工程(Prompt Engineering)[27]通过设计合适的输入提示,引导LLMs生成期望的输出,从而在AC任务中实现更高的准确性和可靠性。本节介绍了提示工程在AC领域的最新进展,重点介绍了关键技术和应用案例,以提供相关研究的参考和见解。目前的研究识别了四种主要的提示技术,如图3所示:零样本提示、少样本提示、链式思维(Chain-of-Thought,CoT)提示和代理(Agent)提示。 零样本提示(Zero-shot Prompt)[27]是一种方法,其中模型在没有任何演示或训练数据中的特定实例的情况下,生成关于特定主题或领域的文本。这种方法结构简单,易于理解,能够快速适应不同的领域和任务。通过利用模型广泛的知识和内在的推理能力,零样本提示可以有效地生成所需的文本。这使得它在需要快速生成高质量内容的应用中尤其有效,特别是在数据不足或难以获取的情况下。 少样本提示(Few-shot Prompt)[27]为模型提供了与给定任务相关的少量示例或演示。这些示例和任务描述作为提示输入,帮助模型更好地理解特定任务。模型通过学习少量示例并遵循任务指令,可以高效地进行推理并生成高质量的输出。少样本提示提高了许多复杂任务的表现,尤其在数据样本有限或数据不平衡的情况下具有优势。 链式思维(CoT)提示[147]是一种显著增强LLMs推理能力的技术。与直接提示模型生成输出不同,CoT提示方法使用逐步推理过程引导模型进行逻辑思考。此方法涉及将中间步骤显式输出,作为推理链的一部分。CoT提示使LLMs能够生成更准确且与上下文相关的响应。这在各种复杂的推理任务中非常有效,如算术、常识推理和符号推理。此外,中间步骤使用户更容易理解模型的思维过程,从而提高了LLMs推理的可解释性。 代理(Agent)[92]是一种新兴且有前途的提示工程技术。它作为一个智能代理,能够感知其环境,自主理解、做出决策并执行行动。在LLM代理中,LLM充当代理的大脑,与多个LLM组件协作完成任务的各个部分。配置文件、工具、模块、计划和行动模块根据提示方法执行各自的任务,然后LLM大脑综合各个模块的结果,以实现更好的结果。这种协作方法使代理在解决需要多个步骤或多样化知识的复杂任务时特别有效。它们通常用于需要角色扮演[92]或协调行动的场景[148],展示了它们在处理复杂多面挑战中的多功能性[149]。 尽管这些提示技术具有一些共性,但它们在特征和应用上各有不同。零样本提示方法使用句子或段落作为提示文本来引导模型,而其他三种方法在此基础上进行了各种修改和扩展。少样本提示方法在提示文本中添加了解决任务的示例以帮助完成任务。CoT提示方法采用多步骤链式思维,使用不同的提示文本在每个步骤完成任务。CoT还可以与少样本方法结合,利用CoT的多步骤思维过程作为示例来引导思维链的生成。代理方法与前三种方法不同,它采用多LLM协作的方式。每个LLM可以使用任何提示形式,如零样本、少样本或CoT,而每个LLM输出的信息则被整合以完成任务。图3展示了这四种方法的相似性和差异性。

结论

情感计算(Affective Computing,AC)已成为人工智能中的一个重要研究方向。随着大型语言模型(LLMs)的兴起,在理解和生成情感方面取得了显著进展。本文对LLMs在AC中的应用进行了全面综述,探讨了指令微调和提示工程等技术在情感理解和生成任务中的作用。我们还总结了多个大型语言模型在AC中的基准测试,为相关领域的研究人员和从业者提供深入的帮助。 研究表明,LLMs凭借其强大的上下文学习和序列生成能力,在情感理解和生成方面表现出色。然而,LLMs在多语言和多文化情感分析、实时情感计算以及特定垂直领域的情感相关任务中仍面临诸多挑战。我们讨论了与AC相关的挑战和未来的研究方向,旨在为这一快速发展的领域提供见解。