对话系统(DS),包括面向任务的对话系统(TOD)和开放领域对话系统(ODD),一直是自然语言处理(NLP)中的基础任务,实际应用广泛。由于复杂的训练和精心设计的模型架构,语言模型(LM)通常被作为构建对话系统的必要支撑。因此,LM中的每一个突破都会引起对话系统学习范式和研究重点的转变,尤其是预训练语言模型(PLMs)和大型语言模型(LLMs)的出现。在这篇论文中,我们深入探讨对话系统的历史,特别是其与语言模型进步的特殊关系。具体来说,我们描述了基于LM的对话系统的演化轨迹,将其分为四个独特阶段,每个阶段都由语言模型的关键突破标志:1)早期阶段,以统计LM为主,导致基于规则或机器学习驱动的DS;2)基于神经语言模型(NLM;如LSTM和GRU)的TOD和ODD的独立发展,因为NLM在其参数中缺乏内在知识;3)随着预训练语言模型(PLMs)的出现,不同类型对话系统的融合,从TOD内部四个子任务的融合开始,然后是TOD与ODD的融合;4)当前基于LLM的对话系统,其中LLMs可以无缝地进行TOD和ODD。通过这种方式,我们的综述提供了一个系统的视角,按照LM突破的时间顺序对阶段进行分类,全面回顾了最新研究成果。此外,我们关注新兴话题并讨论开放性挑战,为基于LLM的对话系统的未来方向提供有价值的见解。总之,这篇综述深入探讨了语言模型和对话系统之间的动态相互作用,揭示了这一重要关系的演化路径。通过这种探索,我们为该领域的更深入理解铺平了道路,指导基于LM的对话系统的未来发展。

构建一个具有会话能力的智能系统一直是自然语言处理领域的基本目标[1, 2]。与机器自然而无缝地交互的能力已经为人机通信开辟了新的途径,从Siri、小冰[3]到最新的新必应1和谷歌巴德2,引领着不同行业的变革应用。这一演进的核心是对话系统发挥的关键作用,这些系统旨在促进交互,其特点包括无害性[4]、有帮助性[5]、可信度[6]和个性化[7]。这些系统旨在模仿人与人之间的对话,从而提供增强用户体验、简化任务并根据对话上下文提供个性化帮助的潜力,涵盖了不同领域,如客户支持、虚拟助手、医疗保健、教育等,具体取决于表1中所示的对话上下文类型[8]。

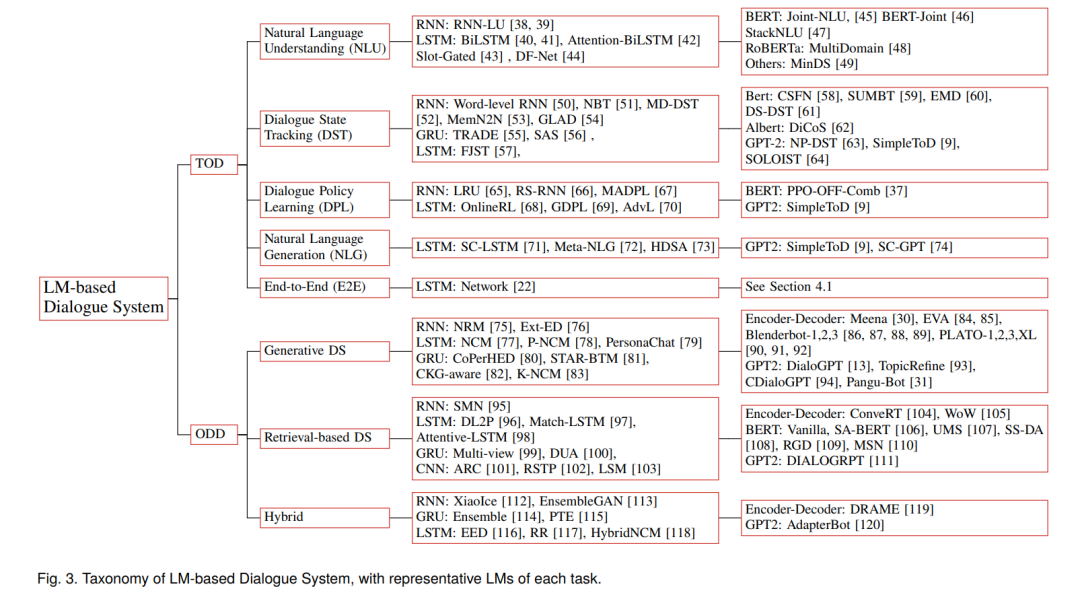

具体而言,实际中有两种主要类型的对话:任务导向对话和闲聊对话。任务导向对话围绕着帮助用户实现特定任务或目标,例如预订或购票。在这种情况下,对话系统更像是一个有益的助手,为用户提供相关信息和指导[2, 9]。相反,闲聊对话涉及到随意和非正式的对话,主要旨在建立和维护社交联系。在这里,对话系统扮演友好的聊天机器人的角色,以更轻松和对话的方式与用户互动[1]。基于它们的不同角色,提出了两种类型的对话系统:任务导向对话系统(TOD)和开放领域对话系统(ODD)。TOD旨在高效处理任务导向的对话,通过检测用户意图、跟踪对话状态、执行适当的操作并做出相应的回应,引导用户实现特定目标。相反,ODD旨在进行开放领域的互动,通过将对话上下文直接映射到回应,而不需要预定义的任务或目标,在各种主题上进行自由流动的对话。这两种类型满足不同的用例和用户需求,展示了对话系统在各种场景中的多功能性和适用性。因此,在2020年前的大部分早期研究(图2之前)旨在独立设计和构建这些对话系统,使用不同的基础结构考虑了它们的不同角色[1, 2]。

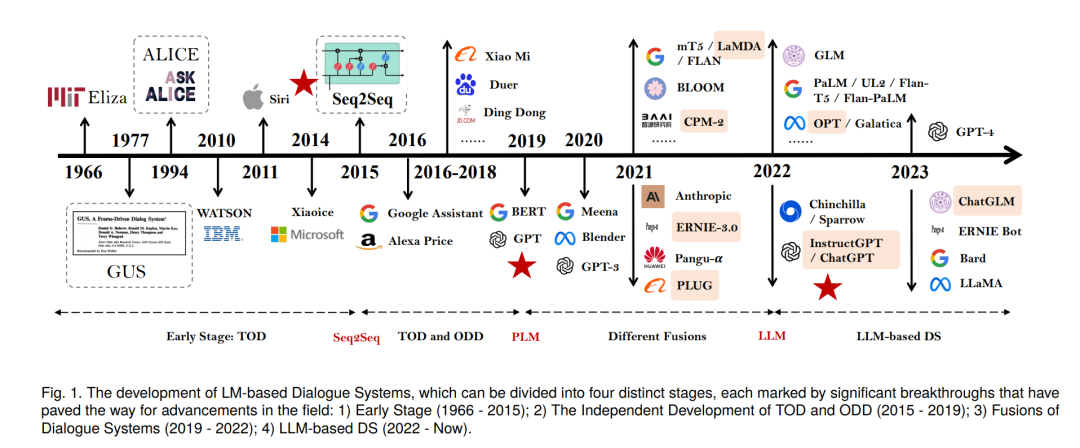

然而,语言模型(LM)方面的革命性进展已经引发了对话系统的深刻演变,重新塑造了它们的根基。LM的核心目标是预测单词序列的概率,这对对话系统产生了深刻的影响[10, 11],赋予它们从预训练语料库[12]中学习世界知识并生成更具上下文相关性和有帮助性的响应的能力[13]。同时,LM发展中的每个里程碑都在对话系统中引发了变革性的变化,在它们的快速演变和持续趋势中发挥了关键作用,尤其是最新的大型语言模型(LLMs),如ChatGPT的出现。与其深入研究语言模型的发展,我们的重点在于对话系统经历这一变革过程的迷人之旅,可以分为四个主要发展阶段,对应于图1中所示的LM的四个阶段[14]:

•** 早期阶段 - 统计语言模型(SLMs)**。第一个对话系统 - Eliza,由麻省理工学院于1966年提出,早于20世纪90年代SLMs的兴起,允许人与机器之间进行似是而非的对话。随后,构建了一系列对话系统,包括协助客户制定前往加利福尼亚州一个城市的简单往返行程的旅行代理商[15],以及配置了个性化的基于规则的聊天机器人,采用启发式模式匹配规则来回答有关年龄、爱好、兴趣等方面的询问[16] 3。除了学术工作之外,越来越多的公司关注对话系统领域,并开发了自己的产品。例如,IBM开发了WATSON,苹果拥有Siri,微软有小冰。这些早期虚拟助手功能有限,遵循严格的流程,主要帮助用户执行单一而简单的任务,如安排约会、设置提醒以及提供基本答案。在这个阶段,大多数对话系统都是任务导向的,这些对话系统的主导性质主要是任务导向的,采用了模块化的方法或基于SLMs的机器学习方法。

• TOD和ODD的独立发展 - 神经语言模型(NLMs)。大约在2015年,有一个巨大的变革,当提出了序列到序列(seq2seq)框架时,其中显著的特征与模型培训一起学习 - NLM[17, 18]。具体而言,NLM通过神经网络表征了单词序列的概率,例如,两种典型的循环神经网络(RNNs),如长短时记忆网络(LSTM)[19]和门控循环单元(GRU)[20]。这些NLM作为将可变长度的输入序列映射到可变长度的输出序列的骨干,通过使用两个主要组件实现:编码器和解码器。这种范式转变促使了开放领域对话(ODD)系统的出现(∼2015年,图2),因其seq2seq网络启用的明确定义的端到端框架而引起关注。与此同时,NLM也应用于TOD,目标是在多个领域中实现更好的性能并执行复杂的任务[21, 22, 23]。

•** 对话系统的融合 - 预训练语言模型 (PLMs)**。传统的NLM需要大量手工选择特征和领域特定知识,使其在每个任务中开发变得繁琐和耗时。然而,随着深度学习和大规模语言语料库的出现,预训练语言模型(PLMs)出现,成为一种突破性的解决方案。这些模型在大量未标记的文本数据上进行了预训练,捕捉了丰富的语义和句法模式[11, 24, 25]。通过利用预训练,随后对特定任务的微调变得更加可行,使模型能够迅速适应并以最少的任务特定数据取得卓越的结果。在对话系统领域,DialoGPT通过在Reddit评论链中提取的1.47亿个类似对话的交换进行预训练,然后通过几个训练示例进行微调,以生成更相关、信息更多且上下文一致的响应[13],这是这种方法的典型示例,通常被称为预训练和微调[26],导致最终模型成为预训练对话模型(PDM),通过对话语料库进行微调。值得注意的是,PDM之间的主要区别在于用于训练的语料库和采用的骨干语言模型,例如PLATO [27, 28]、BlenderBot [29]、Meena [30]、Pangu-bot [31]、PLUG [32]等等。此外,在TOD内部(例如,端到端TOD)、TOD与ODD之间融合,以及在此期间提出统一对话系统(UniDS)等方面,人们越来越关注不同任务的融合(图2)。

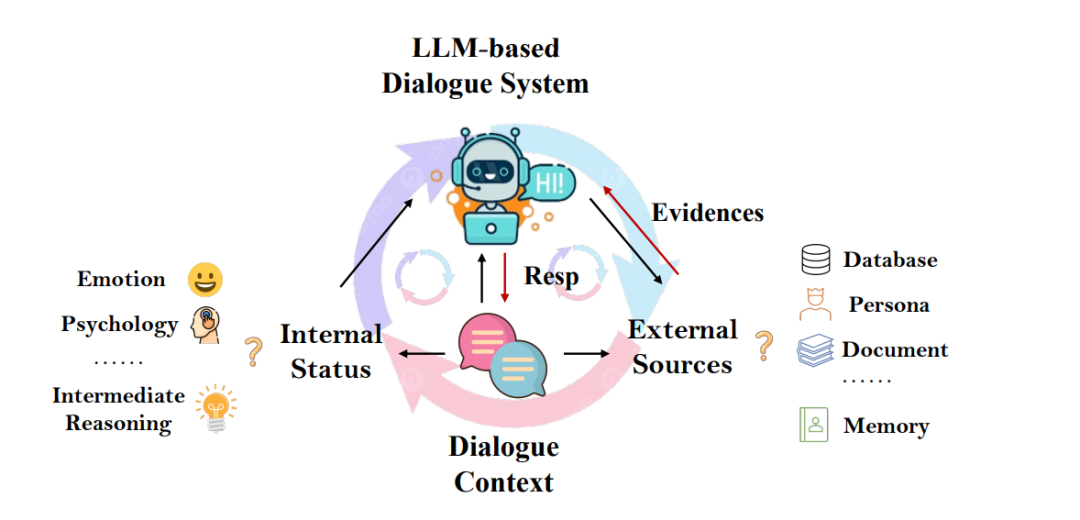

•** 基于LLM的对话系统 - 大型语言模型 (LLM)**。认识到预训练语料库规模和模型大小与不同NLP任务的性能提高之间的相关性[33],研究人员尝试同时扩展模型大小和预训练语料库的大小,以提高样本效率,使模型能够从数据中学到更复杂的模式和表示。因此,PLMs变成了大型语言模型(LLMs),如GLM [34]、LLaMA [35]和InstructGPT [4]。由于较大的模型大小和使用大规模高质量的预训练语料库,这些LLMs在许多语言理解和生成任务方面提供了前所未有的能力,包括但不限于问答和命名实体识别,从而重塑了对话系统的格局。通过使用数据进行进一步的指导调整,这些LLMs能够回答各种问题并遵循各种指令,例如撰写电子邮件和讲笑话。此时,LLMs可以直接用作对话系统。此外,通过使用领域内数据,即对话/会话语料库,对LLM进行微调,可以进一步增强其对话能力。例如,GPT-3.5演变为InstructGPT,然后演变为ChatGPT,恰好遵循这一路径。同样,ChatGLM [36]也是使用基于相应LLM - GLM的公开可用的中文对话数据集进行微调的。为了增强与人类偏好和价值观的一致性,引入强化学习变得至关重要,尤其是在模型精炼的最后阶段。这涉及利用来自人类评估员[4]或自动化系统[37]的反馈,以迭代改进模型的性能并确保其符合期望的标准。毕竟,这种基于LLM的对话系统(LLM-based DS)在任务导向对话和闲聊方面表现出色,使其成为通用会话AI的理想基础。

值得注意的是,基于LM的对话系统的发展是一个持续不断的演进过程,各个阶段之间并没有被具体的转折点划分得严格。相反,在这些阶段之间存在重叠和不断的进展,尤其是在后期阶段。一般来说,随着LM的进步,TOD与ODD之间的边界和DM与LM之间的边界变得日益模糊,开启了基于LLM的对话系统的新时代。尽管现有的研究已经彻底研究了不同类型的对话系统的发展和挑战,例如TOD [2]和ODD [1],但在提供对话系统的演进轨迹的整体视角方面,特别是在考虑到LM的进展时,仍然存在明显的文献差距。通过批判性地分析和理解关键里程碑的影响,我们可以获得有关未来可能出现的可能性以及对各种领域和应用产生变革性影响的对话系统的有价值见解。本综述旨在提供关于LM基础对话系统领域的全面概述[4],为当前领域正在前进的重要方向提供光明。这包括对现有文献的细致审查,旨在阐明在LM基础对话系统的不同阶段观察到的范式转变。这些转变涵盖了各种层面的整合,尤其是任务、数据和框架维度。

本综述的其余部分组织如下:第2节描述了不同类型的对话,并以统一的方式定义了问题,随后在第3节中介绍了两种类型的LM基础对话系统的早期发展:TOD和ODD。第4节回顾和总结了当PLMs扩展到LLMs时不同对话系统的演变。然后,我们在第5节中调查了LLM-based DS中新兴的趋势和开放性挑战。然后,第6节讨论了LLM-based对话系统的开放问题。最后,在第7节中,我们通过总结主要发现并讨论未来工作的未解决问题来总结综述。