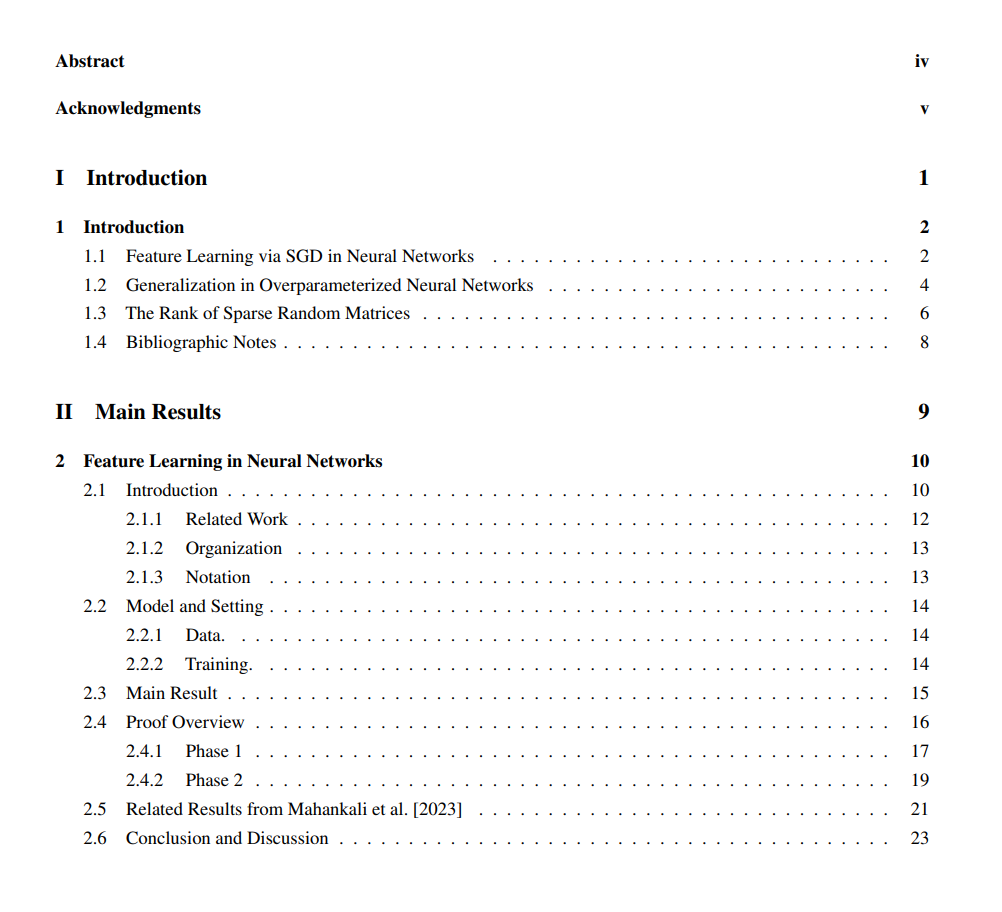

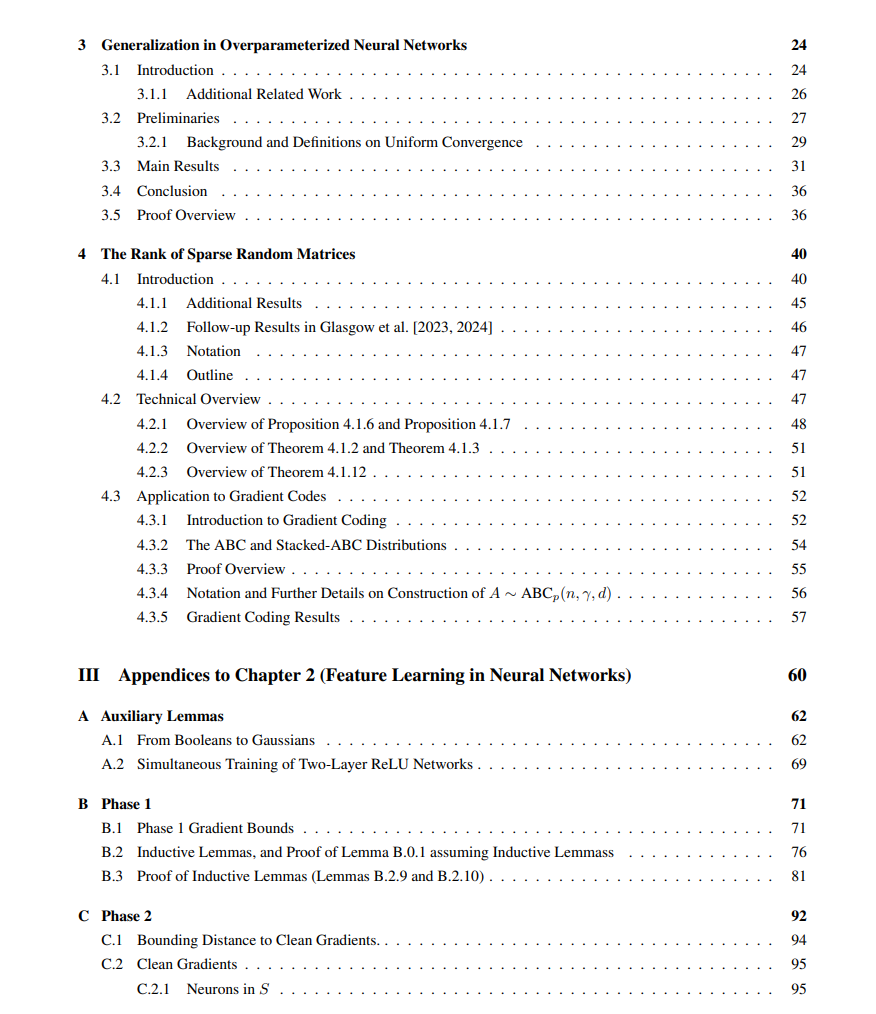

近年来,深度学习的前所未有的成功在经验上得到了证明。然而,我们对梯度下降为何能成功训练神经网络的理论理解仍然缺乏,并且似乎违背了传统统计学和优化的许多预测。在本论文中,我们深入探讨了关于深度学习的几个理论问题。

**论文的第一部分

我们重点研究神经网络的优化问题。为什么随机梯度下降(SGD)经常能在非凸的景观中找到好的解决方案?特别是,它是如何有效地从结构化数据中学习特征的?我们将通过学习一个称为“XOR”函数的二次真实函数在一个两层神经网络上的示例来研究这些问题。值得注意的是,我们的结果显示,简单的SGD能够利用训练数据中的特征,比不学习特征的核方法更有效地学习。虽然XOR设置很简单,但它突出了我们对SGD理论理解中的一些关键挑战,即理解SGD如何在优化景观中逃离鞍点,以及需要多少训练样本才能逃离这样的鞍点。

**论文的第二部分

我们重点研究过参数化神经网络的泛化问题。许多实证研究表明,最先进的视觉模型过参数化到能够拟合随机噪声 [Zhang et al., 2021],这表明基于统一收敛的标准泛化界已经过时。那么,为什么通过梯度下降训练的过参数化模型会选择能够泛化的好解?为了在这个问题上取得进展,我们考虑了一个二次设置,其中神经网络过参数化到能够以大边距分离训练数据,但对新样本完全不能泛化。然而,我们证明了实现最大可能边距的神经网络确实能够泛化。关于过拟合在过参数化模型中的问题,在更简单的线性设置中已经被广泛研究。我们的结果是第一个在神经网络的非线性设置中取得成果的研究。

**论文的最后一部分

我将介绍一些与稀疏随机矩阵相关的其他“随机”探索。我们的主要结果是证明,在高概率下,随机Erdos-Rényi图的邻接矩阵的秩可以通过某些导致线性依赖的小结构在组合上进行表征。这使我们能够将秩与图的匹配数联系起来。我们的结果建立在长期研究稀疏随机矩阵的可逆性概率和秩的工作之上。该工作中的一个共同主题是将随机图的组合属性与其线性代数属性联系起来。我们将我们的技术应用于其他几个稀疏随机矩阵设置,包括证明在高概率下,随机矩阵的3-core是可逆的,以及研究在分布式计算中的“梯度编码”中具有应用的随机矩阵集合。我们的大多数结果考虑了随机图的平均度数趋于无穷的设置。