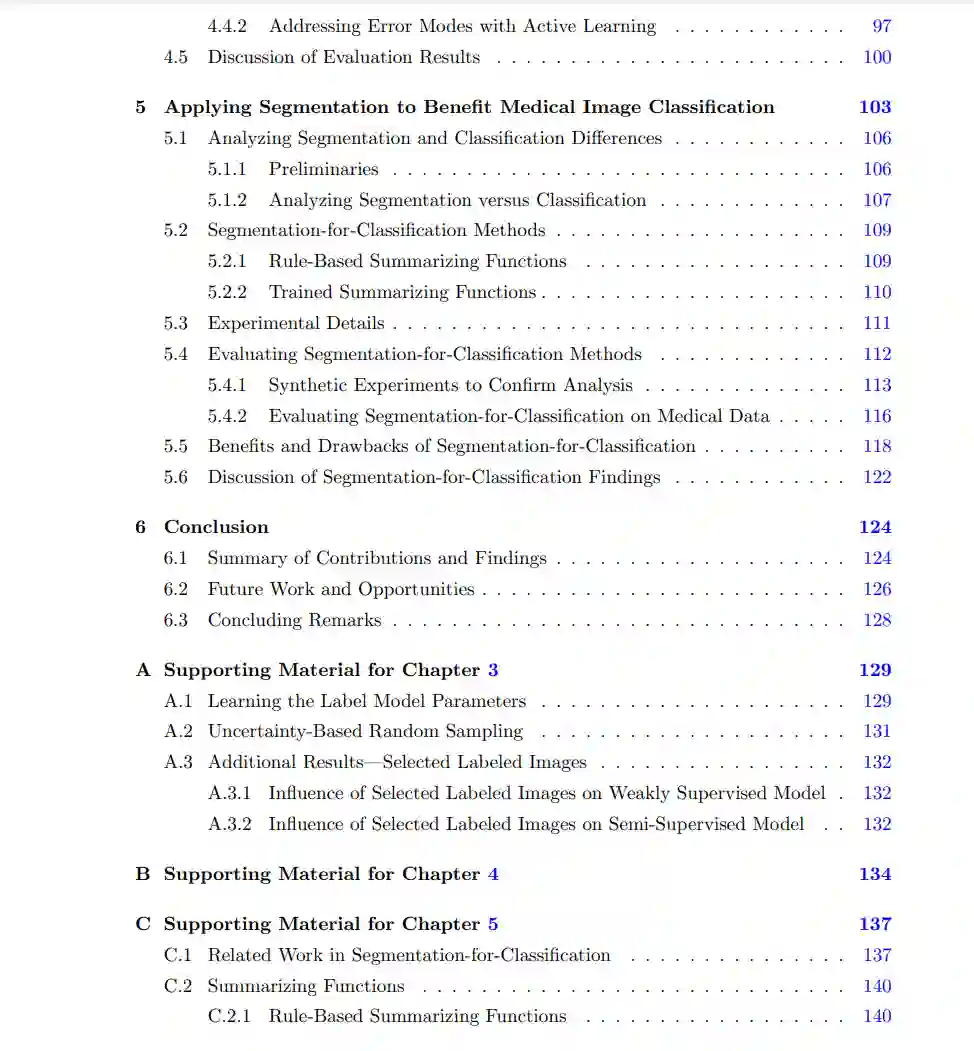

我们首先描述了两种在标签数据有限的情况下训练医学图像分割神经网络的方法。在我们的第一种方法中,我们将弱监督适应于分割。在我们的第二种方法中,我们将数据增强、一致性正则化和伪标签融合在一个统一的半监督流程中。这些方法将多种有限标签训练方法融入到同一框架中,利用每种方法的优点实现高性能,同时保持标签负担低。接下来,我们评估了在多机构、多扫描仪、多疾病数据集上使用有限标签数据训练的网络在临床相关指标上的表现。我们发现,我们的半监督网络在某些泛化任务上比全监督网络(训练数据标签多100倍以上)表现更好,与人类注释者的一致性更强。然而,我们发现了标签效率方法表现不佳的数据子集。我们提出了一种针对我们半监督流程的主动学习扩展,以解决这些错误模式,使困难数据切片上的半监督性能提高18.5%。通过这种评估,我们了解了如何使用有限标签数据训练的网络在临床任务上的表现,它们与使用丰富标签数据训练的网络的比较,以及如何减轻错误模式。

最后,我们将标签高效的分割模型应用到更广泛的医学图像分析任务中。具体来说,我们展示了分割如何以及为什么可以使医学图像分类受益。我们首先分析了为什么在同一数据集和任务上,分割模型和分类模型可能达到不同的性能。然后,我们实现了使用分割模型对医学图像进行分类的方法,我们称之为"以分割为分类",并将这些方法与三个回顾性数据集上的传统分类进行比较。最后,我们利用我们的分析和实验总结了与标准分类相比,使用"以分割为分类"的优点,包括:改善样本效率,能够在标签图像更少的情况下(少一个数量级)提高性能,在低发病率类别和某些罕见子组中(最高提高161.1%的召回率);提高对假相关的鲁棒性(最高提高44.8%的鲁棒AUROC);以及提高模型的可解释性,评估和错误分析。这些结果表明,利用分割模型可以在常见设置中导致更高质量的医学图像分类器。总的来说,本文聚焦于将分割作为支持自动化医学图像分析的关键工具,并展示了如何训练分割网络,在没有大量标签负担的情况下,在许多图像分析任务上实现高性能。