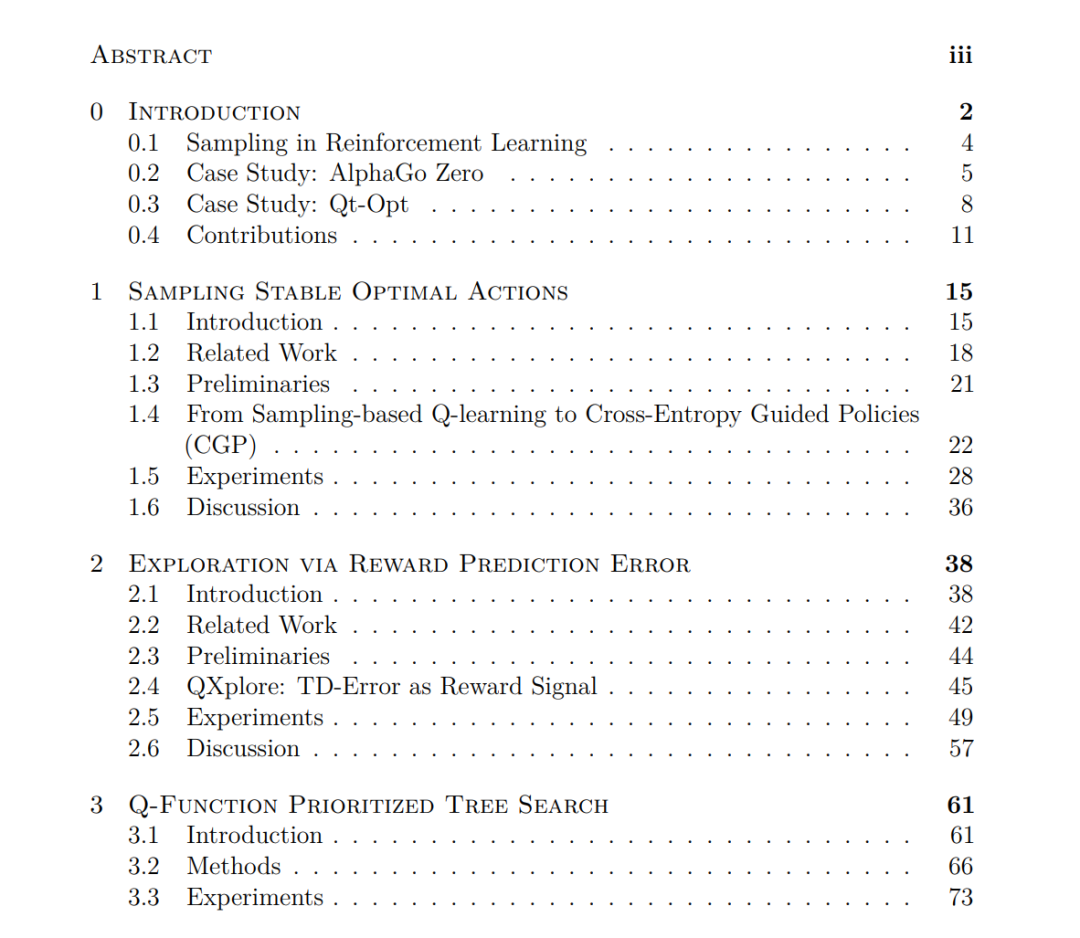

深度神经网络与强化学习(RL)的结合在解决其他棘手的学习任务方面显示出巨大的前景。**然而,深度强化学习的实际演示仍然很少。将深度强化学习用于给定任务的挑战可以分为两类,大致上是“从经验中学习什么?”和“从什么经验中学习?”在本文中,我描述了解决第二类问题的工作。**具体来说,采样包含与学习任务相关信息的动作、状态和轨迹的问题。我从算法设计和任务复杂性的三个层次来研究这个挑战,从算法组件到打破常见RL惯例的混合组合算法。在第一章中,我描述了稳定高效的动作采样工作,以优化连续值动作的Q函数。通过将基于样本的优化器与神经网络近似相结合,可以获得训练、计算效率和精确推理的稳定性。在第二章中,我描述了在奖励感知探索方面的工作,即发现常见采样方法不足的理想行为。教师"探索"智能体发现状态和轨迹,使学生"利用"智能体从这些经验中学习到的数量最大化,并能使学生智能体解决其他不可能的困难任务。在第三章中,我描述了将强化学习与启发式搜索相结合的工作,用于迁移模型已知的任务领域,但状态空间的组合数学对于传统搜索来说是难以解决的。通过将深度Q学习与最佳优先树搜索算法相结合,可以用比普通搜索算法或仅使用强化学习更少的样本来找到程序合成问题的解决方案。最后,总结了这项工作的主要收获,并讨论了强化学习中高效采样的扩展和未来方向。

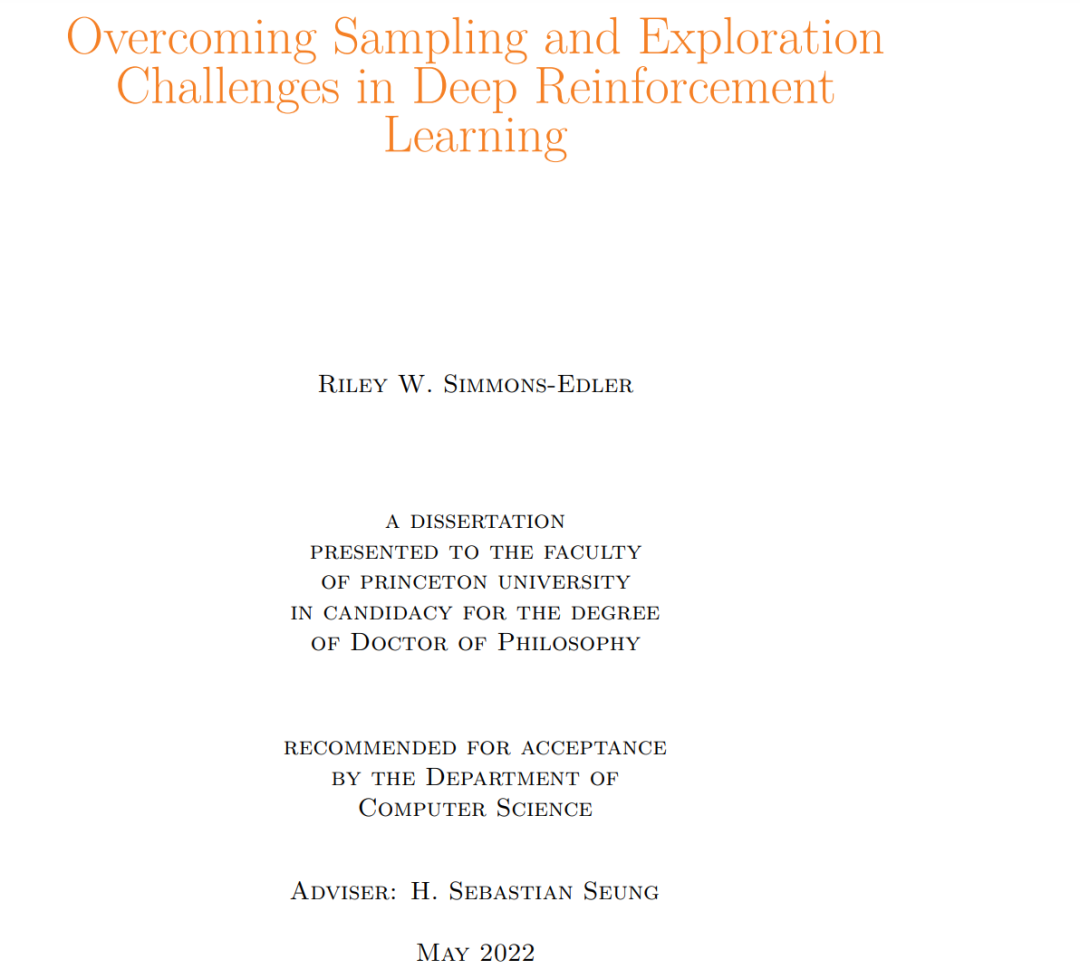

https://dataspace.princeton.edu/handle/88435/dsp01x346d733f

成为VIP会员查看完整内容

相关内容

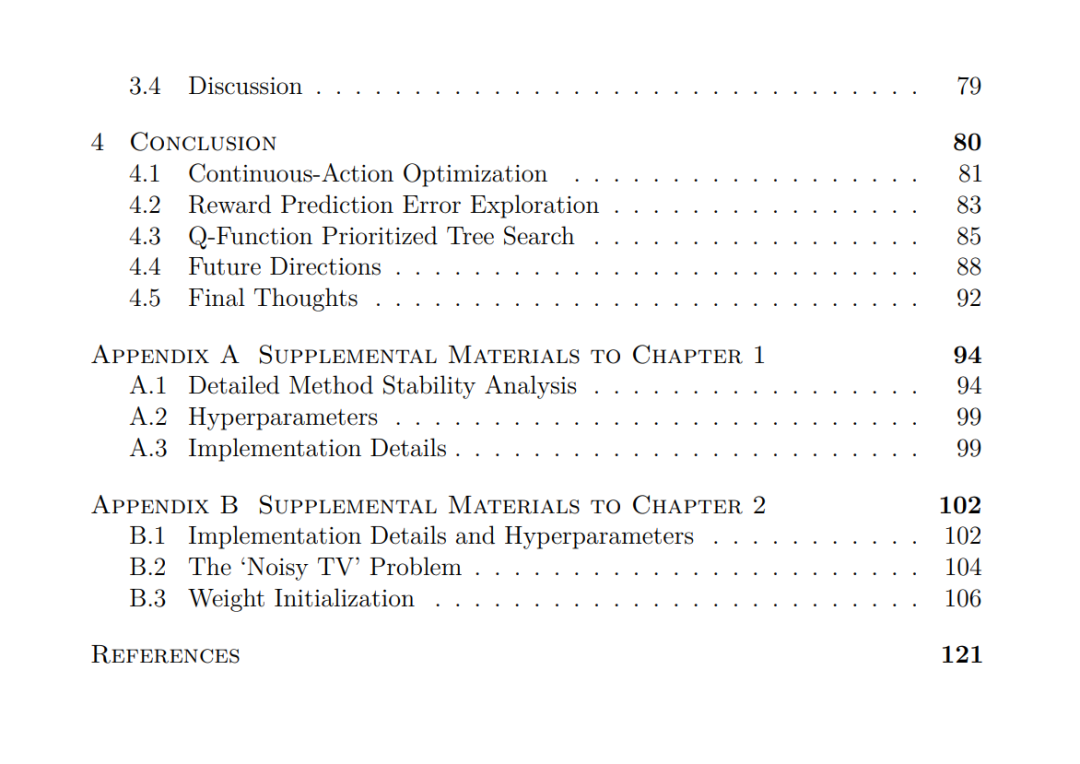

普林斯顿大学,又译

普林斯敦大学,常被直接称为

普林斯顿,是美国一所私立研究型大学,现为八所常青藤学校之一,绰号为老虎。

Arxiv

17+阅读 · 2019年9月9日

Arxiv

10+阅读 · 2019年9月5日