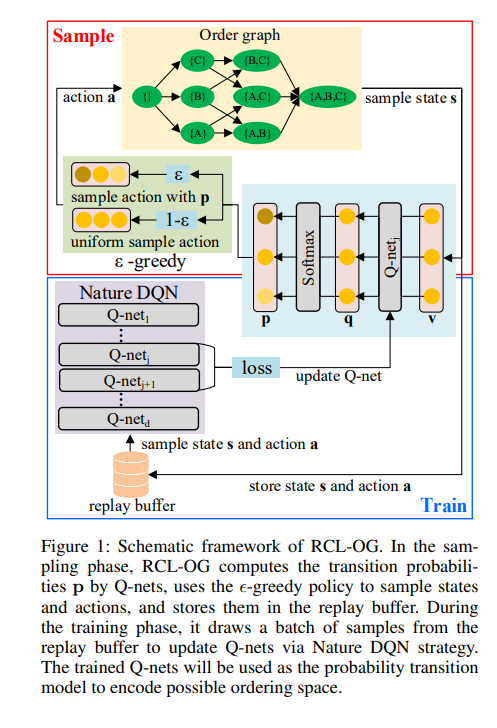

学习描述观测数据因果关系的有向无环图(DAG)是一项非常具有挑战性但又非常重要的任务。由于观测数据的数量和质量有限,以及因果图的不可识别性,几乎不可能推断出单个精确的DAG。一些方法通过马尔可夫链蒙特卡罗(MCMC)逼近DAG的后验分布来探索DAG空间,但DAG空间具有超指数增长的性质,准确刻画DAG空间的整体分布是非常棘手的。本文提出了一种基于序图的因果结构强化学习(RCL-OG)方法,该方法使用序图代替MCMC来建模不同的DAG拓扑顺序,从而减小问题的规模。RCLOG首先用一种新的奖励机制定义强化学习,以效能的方式近似排序的后验分布,并使用深度Q学习在节点之间更新和传递奖励。其次,得到顺序图上节点的概率转移模型,并计算不同顺序的后验概率。这样我们就可以在这个模型上进行抽样,得到高概率的排序。在综合数据集和基准数据集上的实验表明,RCL-OG提供了精确的后验概率逼近,并取得了比Baseline因果发现算法更好的结果。

https://www.zhuanzhi.ai/paper/c90518730875122693a9e8cdefab601a

成为VIP会员查看完整内容

相关内容

Arxiv

10+阅读 · 2021年12月13日