摘要

近年来,深度神经模型在几乎每个领域都取得了成功,甚至解决了最复杂的问题。然而,这些模型的尺寸非常大,有数百万(甚至数十亿)个参数,需要强大的计算能力,以至于无法部署在边缘设备上。此外,性能提升高度依赖于大量的标记数据。为了实现更快的速度和处理由于缺乏标记数据而引起的问题,知识蒸馏(KD)被提出,知识蒸馏是将从一个模型学到的信息迁移到另一个模型。KD通常以所谓的“学生-教师”(S-T)学习框架为特征,被广泛应用于模型压缩和知识转移。本文是关于KD和S-T学习的研究,这两种学习方法是近年来研究比较活跃的。首先,我们旨在解释KD是什么以及它如何/为什么起作用。然后,我们对KD方法和S-T框架在视觉任务中的最新进展进行了全面的调研。总的来说,我们调研了推动这一研究领域的一些基本问题,并全面概括了研究进展和技术细节。系统分析了KD在视觉应用中的研究现状。最后,我们讨论了现有方法的潜力和开放挑战,并展望了KD和S-T学习的未来方向。

引言

深度神经网络(DNNs)的成功与否,通常取决于DNN体系结构的精心设计。在大规模机器学习中,特别是在图像和语音识别等任务中,大多数基于DNN的模型都被过度参数化,以提取最显著的特征,确保泛化。这种笨重的模型通常深度和宽度都很大,训练时需要相当多的计算量,很难实时操作。因此,为了获得更快的速度,许多研究人员一直试图利用训练过的笨重模型来获得轻量级的DNN模型,这些模型可以部署在边缘设备上。也就是说,当这个笨重的模型经过训练后,可以使用它学习一个更适合实时应用或部署[1]的小模型,如图1(a)所示。

另一方面,DNNs的性能也严重依赖于非常大且高质量的标签来训练数据集。由于这个原因,许多人都在努力减少标记训练数据的数量,同时又不太影响DNNs的性能。处理这样缺乏数据的情况的一种流行方法是从一个源任务转移知识,以促进对目标任务的学习。一个典型的例子是半监督学习,在这种学习中,一个模型只用一小组有标记的数据和一大组没有标记的数据来训练。由于未标记的样本的监督代价未定义,应用一致性代价或正则化方法来匹配标记和未标记数据的预测是至关重要的。在这种情况下,知识在假定教师和学生[2]双重角色的模型内转移。对于未标记的数据,学生照常学习;然而,教师产生目标,然后学生使用这些目标进行学习。如图1(b)所示,这种学习度量的共同目标是在没有额外训练的情况下,从学生身上形成一个更好的教师模型。另一个典型的例子是自监督学习(self-supervised learning),该模型是用输入转换(例如,旋转、翻转、颜色变化、裁剪)构建的人工标签来训练的。在这种情况下,来自输入转换的知识被转移到监督模型本身,以提高其性能,如图1©所示。

本论文是关于知识蒸馏(KD)和师生学习(S-T)的研究,这是近年来研究的热点。一般来说,KD被广泛认为是一种主要的机制,当只给予具有相同或不同类别[3]的小训练集时,KD可以使人类快速学习新的复杂概念。在深度学习中,KD是一种有效的技术,被广泛用于在进行建设性训练的同时将信息从一个网络转移到另一个网络。KD最初由[4]定义,由Hinton等人[1]推广。KD被广泛应用于两个不同的领域:模型压缩(见图1(a))和知识转移(见图1(b)和©)。对于模型压缩,一个较小的学生模型被训练来模拟一个预先训练过的更大的模型或模型集合。虽然基于目的定义了各种形式的知识,但KD的一个共同特征是通过它的S-T框架来表征的,其中提供知识的模型称为教师,学习知识的模型称为学生。

在本研究中,我们重点分析和分类现有的KD方法,并结合不同类型的S-T结构,用于模型压缩和知识迁移。我们回顾和调研这一迅速发展的领域,并特别强调最近的进展。KD方法在视觉智能、语音识别、自然语言处理(natural language processing, NLP)等各个领域都有应用,但本文主要关注的是视觉领域的KD方法,因为大部分的演示都是在计算机视觉任务上进行的。利用视觉中的KD原型可以方便地解释用于自然语言处理和语音识别的KD方法。由于目前研究最多的KD方法是用于模型压缩,我们系统地讨论了其技术细节、挑战和潜力。同时,我们也关注了半监督学习、自我监督学习等知识转移的KD方法,重点关注了以S-T学习作为学习度量方式的技术。

我们将探索推动这一研究领域发展的一些基本问题。具体来说,KD和S-T学习的理论原理是什么?是什么让一种蒸馏方法比其他方法更好?使用多个老师比使用一个老师好吗?更大的模型总是能造就更好的老师和更鲁棒的学生吗?只有在教师模型存在的情况下,学生才能学习知识吗?学生能自学吗?离线KD总是比在线学习好吗?

在讨论这些问题的同时,我们结合现有KD方法的潜力,并结合S-T框架展望KD方法的未来发展方向。我们特别强调最近开发的技术的重要性,如神经结构搜索(NAS),图神经网络(GNNs),和增强KD的门控机制。此外,我们也强调KD方法的潜力,以解决在特定的领域的挑战性的问题,如轨道变化是在12个360°的视觉和基于事件的视觉。

本文的主要贡献有三个方面:

(1)对KD和S-T学习方法进行了全面的概述,包括问题定义、理论分析、一系列具有深度学习的KD方法以及视觉应用。

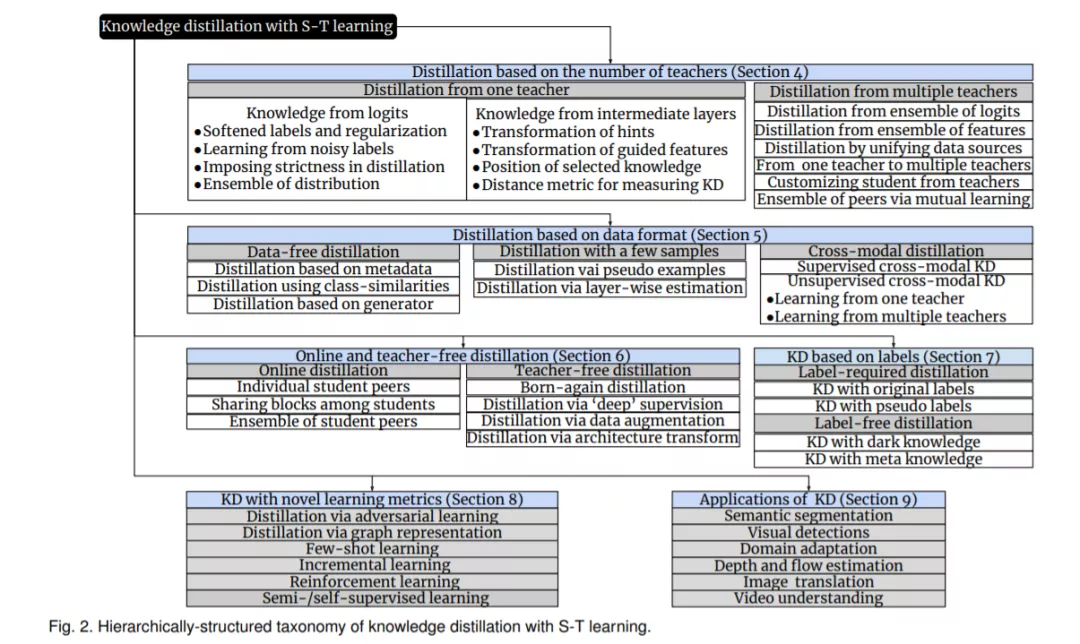

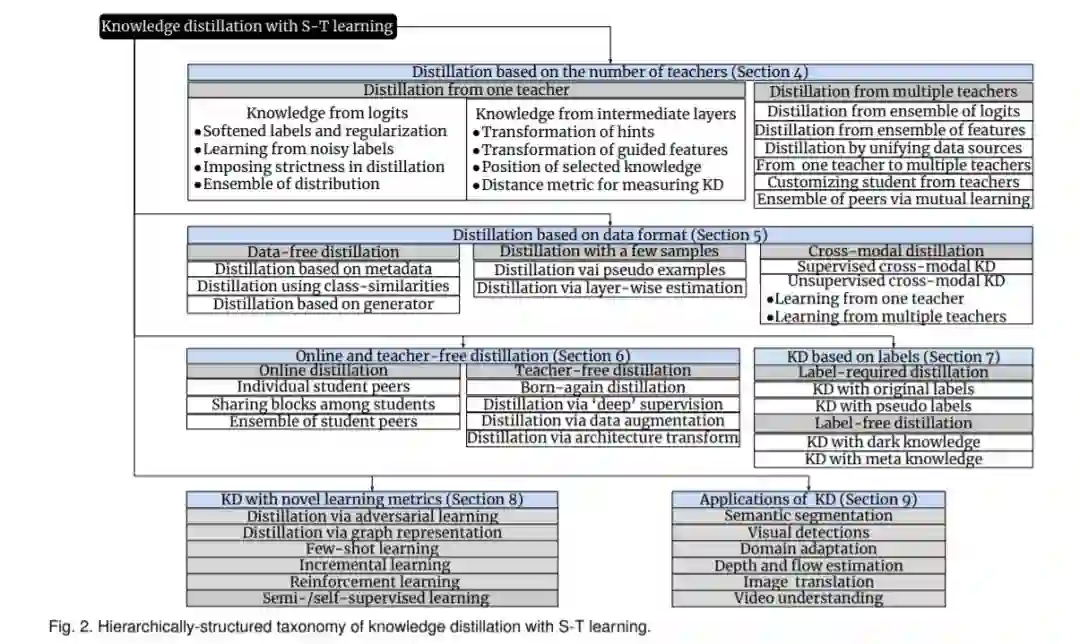

(2) 对KD方法和S-T框架的最新进展进行了分层、结构化的系统综述和分析,并对每个类别的潜力和挑战提出了见解和总结。

(3) 讨论问题和开放问题,确定新的趋势和未来的方向,为该研究领域提供深刻的指导。

本文的组织结构如下。首先,在第二章我们解释了为什么我们需要关注KD和S-T学习。

请解释为什么我们需要在第二节中关注KD和S-T学习。第三章对KD进行了理论分析。从第4节到第8节,我们对一些现有的方法进行了分类,从**基于教师数量的KD、基于数据格式的KD、在线/离线KD、基于标签的KD,到具有新颖学习指标的KD第三章对KD进行了理论分析。从第4节到第8节,我们对一些现有的方法进行了分类,从基于教师数量的KD、基于数据格式的KD、在线/离线KD、基于标签的KD,到具有新颖学习指标的KD。在讨论这些KD方法的技术细节的基础上,我们也分析了它们的挑战和潜力。在第9节中,根据分类法,我们将讨论第1节中提出的问题的答案。第10节介绍了KD和S-T学习的未来潜力,并在第11节给出了结论。由于篇幅有限,关于KD方法相关的新学习指标和KD应用方法的详细介绍在suppll材料的第8和9节中给出。这份手稿还包括分类法/比较表和一些插图的数字,这是不包括在这里由于缺乏空间。

图2展示了KD和S-T学习的分类图。