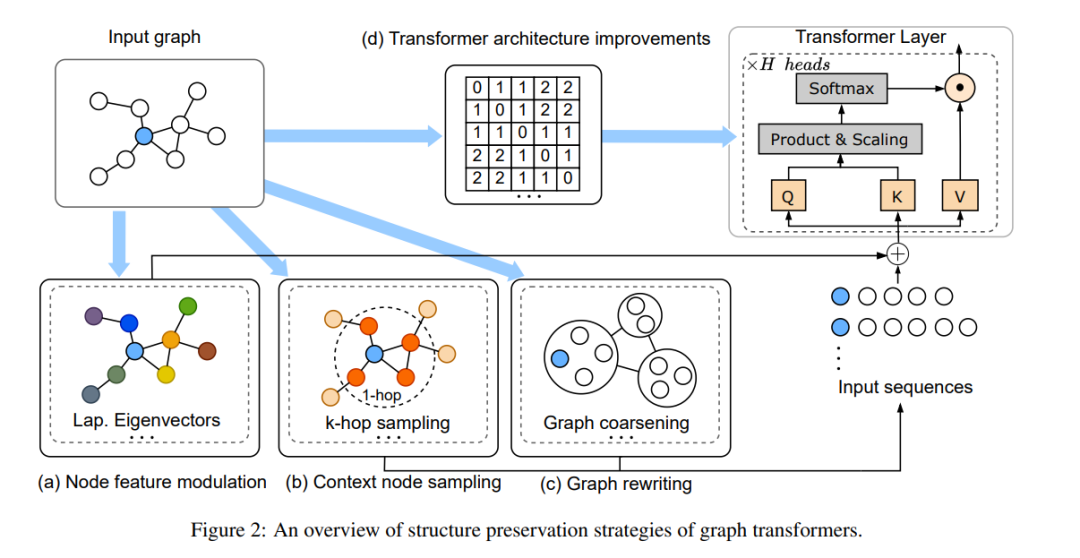

Transformer架构在自然语言处理和计算机视觉等多个领域展现了显著的成功。当涉及到图学习时,transformer不仅需要捕捉节点对之间的交互,还需要保持揭示它们之间潜在关系和邻近性的图结构,显示出捕捉不同图结构的表达能力。因此,已经提出并广泛应用了各种结构保持图transformer,用于生物信息学和化学信息学中的图级任务。然而,与图结构保持相关的策略在文献中尚未得到良好的组织和系统化。在本文中,我们提供了结构保持图transformer的全面概述,并从它们的设计目标的角度对这些方法进行了概括。首先,我们将策略分为四个主要组:节点特征调制、上下文节点采样、图重写以及transformer架构改进。然后,我们根据图结构保持的覆盖范围和目标进一步细分策略。此外,我们还讨论了图transformer模型在保持图结构和理解图的本质方面的挑战和未来方向。

成为VIP会员查看完整内容

相关内容

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构

Arxiv

224+阅读 · 2023年4月7日