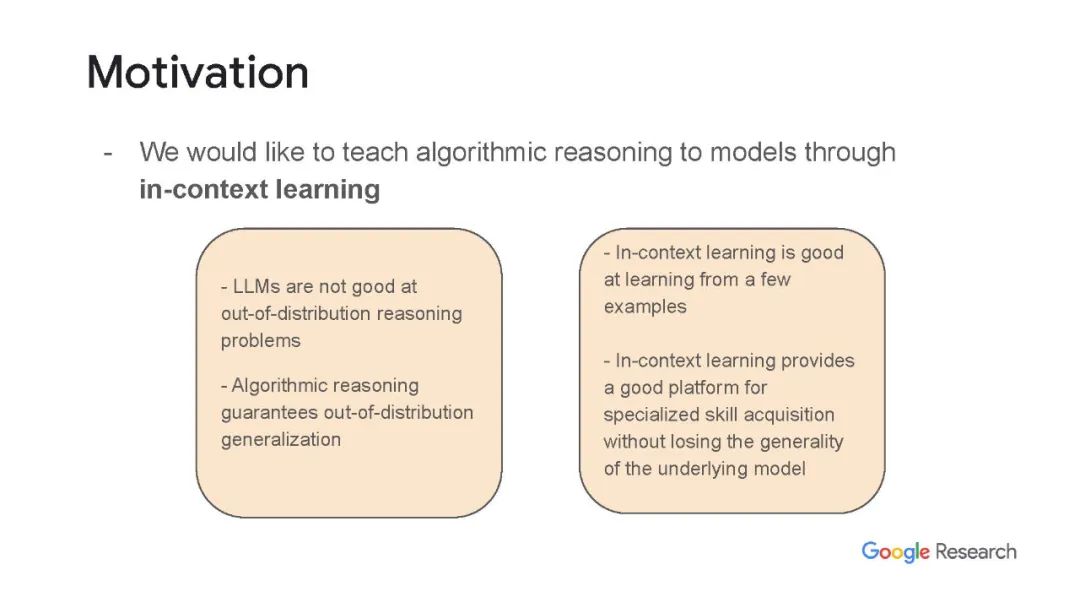

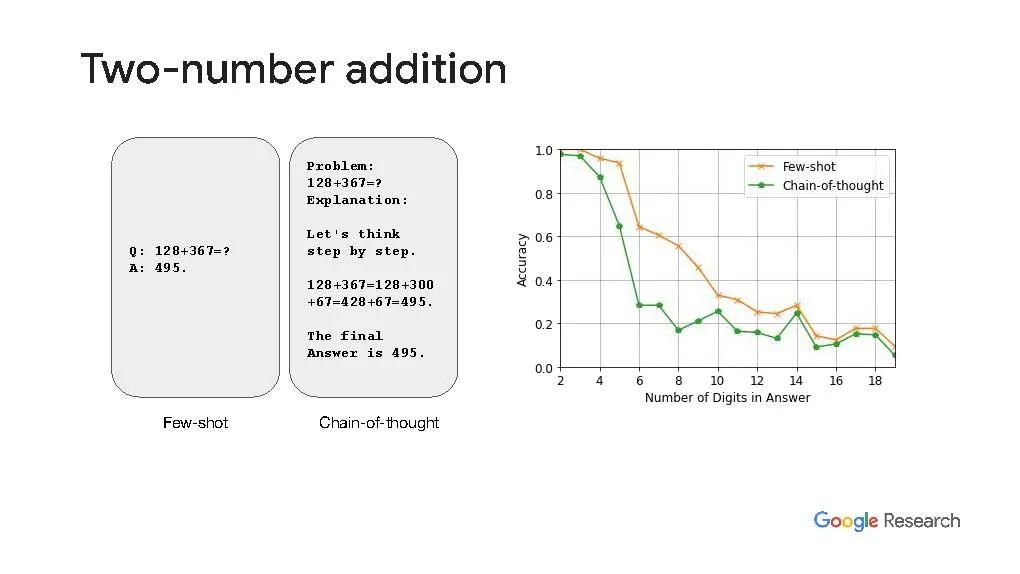

大型语言模型(LLMs)通过扩展模型和数据大小显示出越来越强的上下文学习能力。尽管取得了这些进展,LLM仍然无法解决算法推理问题。虽然为最终答案提供了一个基本原理,导致了多步推理问题的进一步改进,但Anil等人在2022年表明,即使是简单的算法推理任务,如parity,也远远没有解决。在这项工作中,我们确定并研究了成功地向LLMs教授算法推理的四个关键阶段:(1)将算法制定为技能,(2)同时教授多种技能(技能积累),(3)教授如何组合技能(技能组合)以及(4)教授如何将技能用作工具。我们证明了通过上下文学习(我们称之为算法提示)向LLM教授算法推理是可能的。我们在各种算术和定量推理任务上评估了我们的方法,并证明了与现有的提示技术相比,该方法在性能上有显著提升。特别是,对于长奇偶校验、加法、乘法和减法,与最佳可用基线相比,我们分别实现了大约10倍、9倍、5倍和2倍的误差减少。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年4月30日

Arxiv

20+阅读 · 2023年3月21日