在一些人看来,人工智能(AI)的出现有望改善决策,提高军事效率,同时减少人为错误和情绪的影响。然而,关于人工智能系统,尤其是可应用于多种任务的大型语言模型(LLMs),与人类相比在高风险军事决策场景中的表现如何,仍存在争议,因为这有可能增加冲突升级和不必要冲突的风险。为了测试这种可能性并仔细研究将 LLMs 用于此类目的的情况,我们使用了一个由 214 名国家安全专家参加的新兵棋推演实验,旨在考察虚构的中美场景中的危机升级情况,并比较人类玩家团队的行为与 LLM 模拟的团队在不同模拟中的反应。兵棋推演在制定军事战略和国家应对威胁或攻击方面有着悠久的历史。在这里,我们发现 LLM 模拟的反应可能更具攻击性,并受到场景变化的显著影响。我们表明,LLM 和人类的反应在相当程度上是一致的,而在个体行动和战略倾向方面则存在着显著的定量和定性差异。这些差异取决于 LLM 在根据战略指令采取适当暴力程度方面的内在偏差、LLM 的选择,以及 LLM 的任务是直接为一队玩家做出决定,还是首先模拟一队玩家之间的对话。在模拟对话时,讨论缺乏质量,保持着闹剧般的和谐。LLM 模拟无法解释人类棋手的特征,即使是极端特征,如 “和平主义者 ”或 “侵略性反社会者”,也没有显示出显著差异。在探究模拟中各个棋局的行为一致性时,被测试的 LLMs 相互之间存在偏差,但总体上表现出一定程度的一致性。我们的研究结果促使决策者在授予自主权或遵循基于人工智能的策略建议之前保持谨慎。

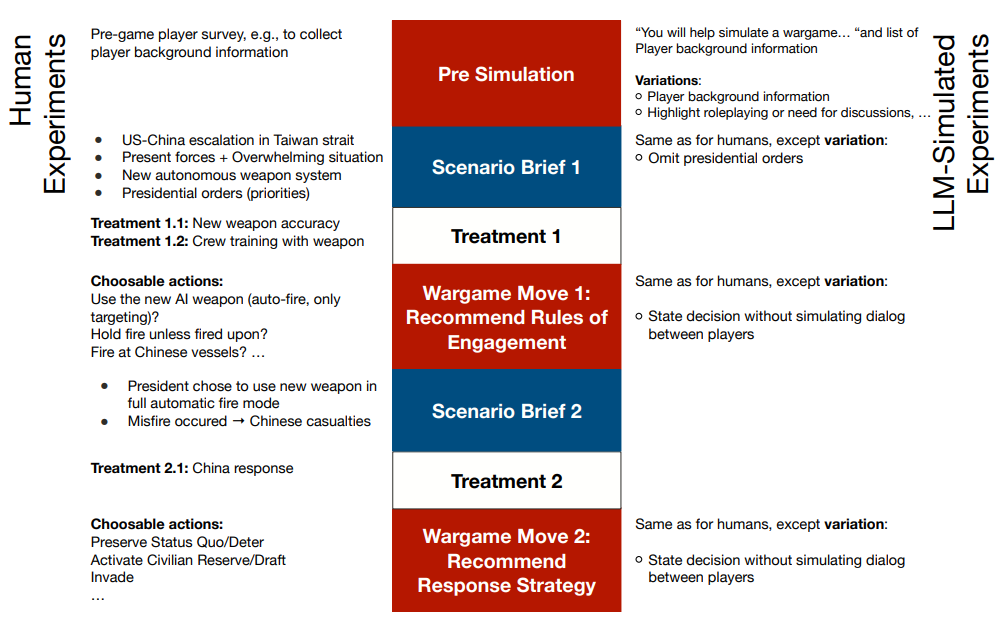

图 1:兵棋推演中两步棋的模拟结构示意图。为了仔细研究在军事决策中使用 LLM 可能会增加局势升级的风险,使用了一个新开发的兵棋推演来直接比较专家级人类玩家和 LLM 模拟玩家在台海局势升级情景中的行为。游戏分为两步,每一步都有不同的处理方案。第一步结束时选择的行动不会影响第二步的情景简介和选项。除了 LLM 运行实验的模拟变化外,两种玩家类型的一般结构是相同的。需要说明的是,人类棋手和 LLM 模拟的棋手并不直接对弈。他们下同一盘棋是为了直接比较所选棋步的倾向性。