生成式人工智能(AI)正在以前所未有的规模与人类互动,为产生巨大的积极影响提供了新的途径,但同时也引发了人们对个人和社会潜在危害的广泛关注。如今,人类-人工智能安全的主要模式侧重于微调生成模型的输出,使其更好地符合人类提供的示例或反馈。然而,在现实中,人工智能模型的输出结果无法在孤立的环境中确定:它们与人类用户的反应和行为长期紧密纠缠在一起。在这份立场文件中,我们认为,只有通过推理人工智能的输出和人类行为形成的反馈回路会如何推动交互走向不同的结果,才能为这些人工智能技术提供有意义的安全保证。为此,我们设想了一个高价值的机会之窗,将快速增长的生成式人工智能能力与控制理论中的动态安全框架联系起来,为未来几十年以人为本的人工智能安全奠定新的基础。

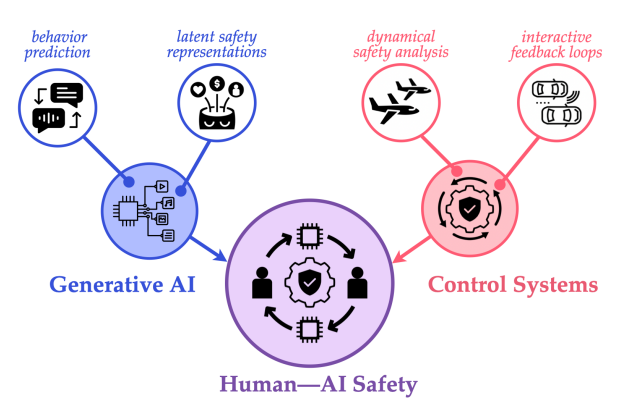

图 1. 在本立场文件中,我们认为存在一个高价值的机会窗口,可将生成式人工智能不断增长的能力与控制理论中的动态安全框架相结合,从而实现新一代以人为本的人工智能安全分析和大规模系统性风险缓解。

价值与需求:定义安全关键型人机交互

在继续讨论之前,我们必须回答这样一个问题:"什么定义了安全关键型人机交互?除了人工智能安全目前对价值一致性的关注之外,我们认为,高风险的人工智能系统还必须了解人类的需求,违反这些需求可能会对人类造成不可接受的、往往是无法弥补的损害。在人工智能决策问题的数学表述中,人的价值对应于优化目标(如随时间累积的奖励或偏好),而人的需求则对应于必须始终满足的硬约束。

因此,我们将安全定义为始终满足人类的关键需求。在本文中,我们将人与人工智能的交互作为一个闭环动态系统进行研究,该系统由人的行为和人工智能的输出驱动,它们共同影响着人工智能的学习和人的未来行为。我们将安全关键型人机交互系统定义为:在交互演化过程中,人类的关键需求有可能受到侵犯,因此人工智能所做的决策必须积极确保此类侵犯行为不会发生。即使是一个看似无害的人工智能聊天机器人,也可能给人类带来灾难性的后果,例如因投资建议不当而造成不可挽回的经济损失(Hicks,2023 年)或身体伤害(Xiang,2023 年)。我们认为,由于任何实用的人工智能系统都无法确定人类当前的内部状态,因此也无法确定他们未来的行为,因此应该要求人工智能系统确保任何可以想象的人类行为(包括适当悲观的情况)都能保持安全。第 4 节和第 5 节的人类-人工智能系统理论路线图将更正式地阐述这些关键因素。