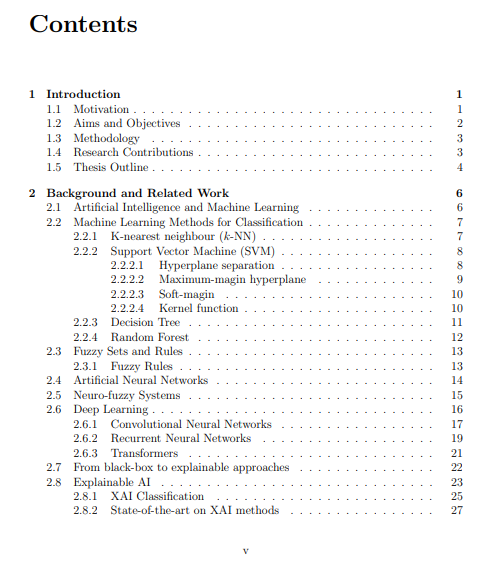

机器学习,更具体地说,深度学习,在过去的十年中吸引了媒体和更多公众的关注,因为它有可能彻底改变行业、公共服务和社会。深度学习在图像识别、语音和语言翻译等不同的挑战性问题上取得了甚至超越了人类专家的表现。然而,深度学习模型通常被定性为一个 "黑盒",因为这些模型由数百万个参数组成,专家极难解释。复杂的 "黑盒"模型很容易愚弄无法检查算法决策的用户,这可能导致危险或灾难性的事件。因此,可审计的可解释的人工智能方法对于开发安全系统、遵守法规和在社会中接受这种新技术至关重要。这篇论文试图回答以下研究问题。是否有可能提供一种与深度学习相比具有性能,同时具有透明结构(非黑盒)的方法?为此,它引入了一个新颖的可解释设计的深度学习架构框架,该框架提供了透明度和高精确度,帮助人类理解为什么达成了一个特定的机器决策,以及它是否值得信任。此外,所提出的基于原型的框架有一个灵活的结构,可以在无监督的情况下检测新的类别和情况。论文中提出的方法已被应用于多个用例,包括图像分类、公平性、深度递归学习解释和新颖性检测。

成为VIP会员查看完整内容

相关内容

Arxiv

20+阅读 · 2023年3月21日

Arxiv

15+阅读 · 2018年1月5日