可解释深度学习

·

深度神经网络(DNN)是一种不可缺少的机器学习工具,尽管很难诊断出模型的输入有哪些方面在驱动它的决策。在无数的现实世界领域,从立法、执法到医疗,这样的诊断对于确保DNN的决策是由适合其使用的方面驱动的,是至关重要的。因此,开发能够解释DNN决策的方法和研究已经成为一个活跃而广泛的研究领域。对于 "解释 "DNN的行动和评估方法的 "解释能力 "的定义的竞争,加剧了该领域的复杂性。本文提供了一个领域指南,为那些在人工智能/ML领域没有经验的人探索可解释的深度学习的空间。该领域指南:i)介绍了三个简单的维度,定义了有助于可解释的深度学习的基础方法的空间,ii)讨论了对模型解释的评价,iii)将可解释性放在其他相关的深度学习研究领域的背景中,以及iv)讨论了面向用户的解释设计和未来的方向。我们希望该指南能被看作是那些着手于该研究领域的人的一个起点。

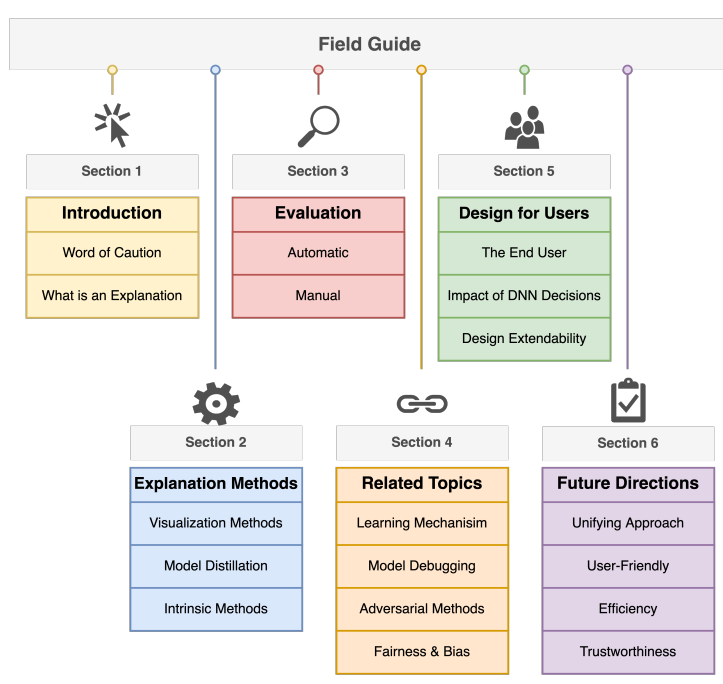

本文为正在着手可解释深度学习领域的研究人员和从业人员提供了一个起点。这份领域指南旨在帮助新人了解:

-

一组表征可解释深度学习的基础性工作空间的维度,以及对这类方法的描述。这个空间总结了可解释的DNN技术的核心内容,目前的大部分工作都是由这些技术启发或建立的(第2节)。

-

评估解释方法的方法(第3节)。

-

与可解释性相一致的补充性研究课题,如 DNN 如何学习概括或减少 DNN 对特定输入特征的敏感性的方法。这些课题与可解释性间接相关,因为它们研究了DNN如何学习或执行推理(第4节)。

-

开发可解释的 DNN 系统的设计者的考虑(第 5 节)。

-

可解释性研究的未来方向(第6节)。

图 1:指南大纲。

成为VIP会员查看完整内容

相关内容

Arxiv

17+阅读 · 2021年6月18日