【牛津大学博士论文】论可解释性和不确定性在确保人工智能应用安全中的作用,217页pdf

深度学习,特别是神经网络(NN),在过去十年中受到了极大的欢迎。它们在自动驾驶、医疗诊断和自然语言处理等通常对安全至关重要的决策系统中得到了越来越多的应用。因此,迫切需要一些方法来帮助开发基于人工智能的系统。在这篇论文中,我们研究了可解释性和不确定性在为基于神经网络的人工智能应用提供安全保证方面的作用。

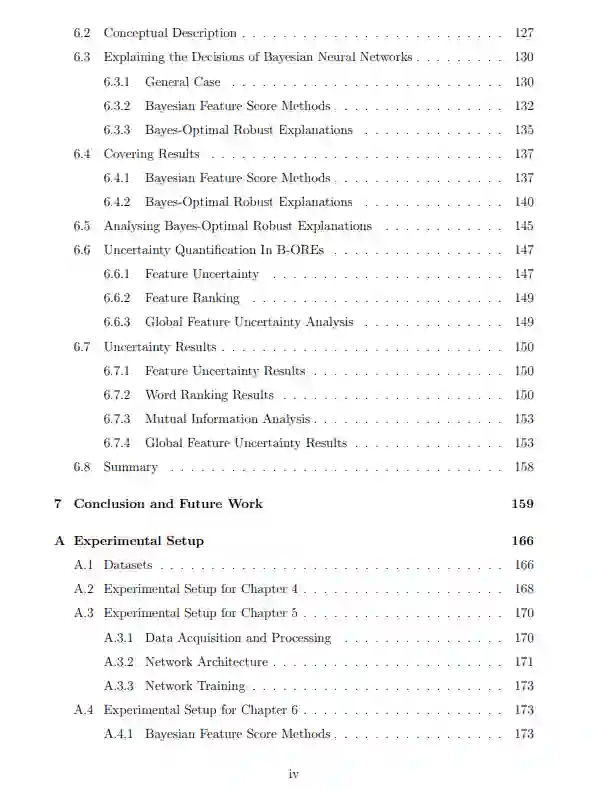

我们的第一个贡献,主要研究基于神经网络模型的决策,是一种获得具有可证明的鲁棒性和最优性保证的局部解释的方法,称为最优鲁棒解释(OREs)。ORE隐含模型预测,为模型决策提供了充分的理由。我们开发了一种提取矿石的算法,该算法使用神经网络验证工具Marabou或Neurify作为黑箱求解器。我们展示了ORE在模型开发和安全保证任务中的有用性,如模型调试、偏差评估和修复由非形式解释者(如anchor)提供的解释。

我们的第二篇文章关注的是一个自动驾驶场景,该场景由基于Carla模拟器数据训练的端到端贝叶斯神经网络(BNN)控制器实现。BNN能够捕捉学习模型中的不确定性,同时保留神经网络固有的主要优势。我们提出了两种方法来评估在离线和在线设置中存在不确定性的BNN控制器的决策安全性。我们开发了一种技术,在给定的标准下近似整个系统的安全边界,具有高概率和先验统计保证。我们最后的贡献是结合贝叶斯神经网络的不确定性信息和局部解释方法的方法集合。展示了如何制定现有特征评分解释方法的贝叶斯版本,以及矿石的贝叶斯版本,称为贝叶斯最优鲁棒解释(B-OREs)。我们定义了一个覆盖解释,它将由多个BNN后验样本产生的信息浓缩为一个单一的解释,该解释的可能性是一个随机样本的解释。在贝叶斯最优鲁棒覆盖解释的情况下,我们获得了解释暗示预测的可能性的概率。我们将贝叶斯覆盖解释与特征不确定性的概念结合起来,对覆盖解释中出现的每个特征进行重要性排序,并表明特征不确定性可以用于提供模型与每个类关联最多的输入特征的全局概述。

引言

深度学习,特别是神经网络(NNs),在过去十年中迅速流行起来。网络神经网络在现实世界中越来越普遍,通常是对安全至关重要的决策系统,如自动驾驶、自然语言处理和医疗诊断。因此,人工智能的安全性已经成为一个核心问题,因为我们试图用可理解的解释和严格的安全保证来补充这种高度准确但不透明的模型。

目前,由于安全保证很少,我们已经看到了错误的边例行为。这种行为的一个显著例子发生在人工智能系统应用于自动驾驶的过程中。2016年,一辆特斯拉Model S(以自动驾驶模式著称的汽车品牌和型号)未能在明亮的天空中分辨出一辆白色拖车,导致致命事故[132]。因此,迫切需要能够准确检测、分析和诊断这种错误行为的方法。

解释一个决定背后的原因对于确保人工智能的安全同样重要,在世界上一些地区甚至是法律要求的[24]。例如,图1.1所示的交通标志。通过对标识进行分类的模型检查图像的哪些部分影响决策,人工解释器可以验证使用了适当的相关信息(例如,我们可能要求模型基于标识本身而不是可能表明错误决策的背景进行分类)。模型开发人员也从解释中受益,因为解释有助于模型调试和偏差评估。例如,从推特[43]中提取情绪分析数据集,考虑以下推文:“我真的很想听一些泰勒斯威夫特的歌,但我找不到CD,我不想在电脑上播放它,CD听起来更好。”这条推特含有负面情绪,但作为研究的一部分,一个简单的神经网络将其归类为积极情绪。通过检查分类背后的解释,我们可以确定积极的分类是否可以完全归因于流行创作型歌手泰勒·斯威夫特的名字的存在,即这是否是一个有偏见或不合理的决定。

神经网络的一种变体,称为贝叶斯神经网络(BNNs),能够捕捉学习模型中的不确定性,同时保留神经网络固有的主要优势[83]。因此,它们对安全关键应用特别有吸引力,如自动驾驶,其中不确定性估计可以通过决策管道传播,以实现安全决策[85]。直观地说,如果模型的不确定性很高,我们可能想要更严格地检查它的预测,或者进行干预。例如,一辆自动驾驶汽车在行驶过程中发现路中间有一个障碍。在每个时间步中,控制器可能不确定转向的角度,为了避免障碍,可以选择使汽车向右或向左转弯的角度,其概率相等。BNN控制器能够指示这种不确定性,不像NN控制器可能会沿着一条直线朝着障碍物摆动(选择左、右、左等等的结果)。拥有BNN不确定度的精确定量测量有助于发现和解决这种模糊情况。

此外,在面对决策过程中的不确定性时,解释保持鲁棒和有用是很重要的,因为对于非常相似的决策的高度可变的复杂解释不能为人类解释器提供良好或有用的反馈。保证对对抗扰动的鲁棒性保证了解释的稳定性,并且可以使用用户定义的代价函数来收集有用的解释(以确保得到的解释是相关的和有用的)。目前,在确保人工智能安全方面,缺乏探索不确定性信息和解释之间相互作用的技术。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“E217” 就可以获取《【牛津大学博士论文】论可解释性和不确定性在确保人工智能应用安全中的作用,217页pdf》专知下载链接