随着深度学习方法多年来取得了巨大的成功,对这些模型的理解还没有跟上模型的发展。可解释机器学习是致力于理解复杂机器学习模型的主要研究领域之一。虽然提出解释的例子越来越多,但对解释的评估一直是一个悬而未决的问题。在解释的开发阶段,涉及人类的评估是昂贵的。为了解决解释设计过程中涉及到人的困难,本文旨在定义客观标准,允许人们在没有人的情况下衡量一些好的属性解释和相对于客观标准可取的设计解释。

在本文中,我们讨论了使可解释AI方法的评估更加客观的不同标准,其中我们的方法主要可以分为三个方面:(a)忠实导向(b)理论驱动的(c)应用驱动的。面向忠实度的度量通常与模型的解释应该忠实地“解释”模型这一核心概念相关联。理论动机的客观标准通常具有“当模型和数据满足某种性质时,解释应满足相应的性质”的形式。应用驱动的客观标准定量模拟解释如何在没有人类的情况下帮助某些应用。我们为不同类型的解释设计客观标准,并使用这些客观标准来指导新的解释的设计。最后,通过一些人体研究来验证这些新解释的设计。

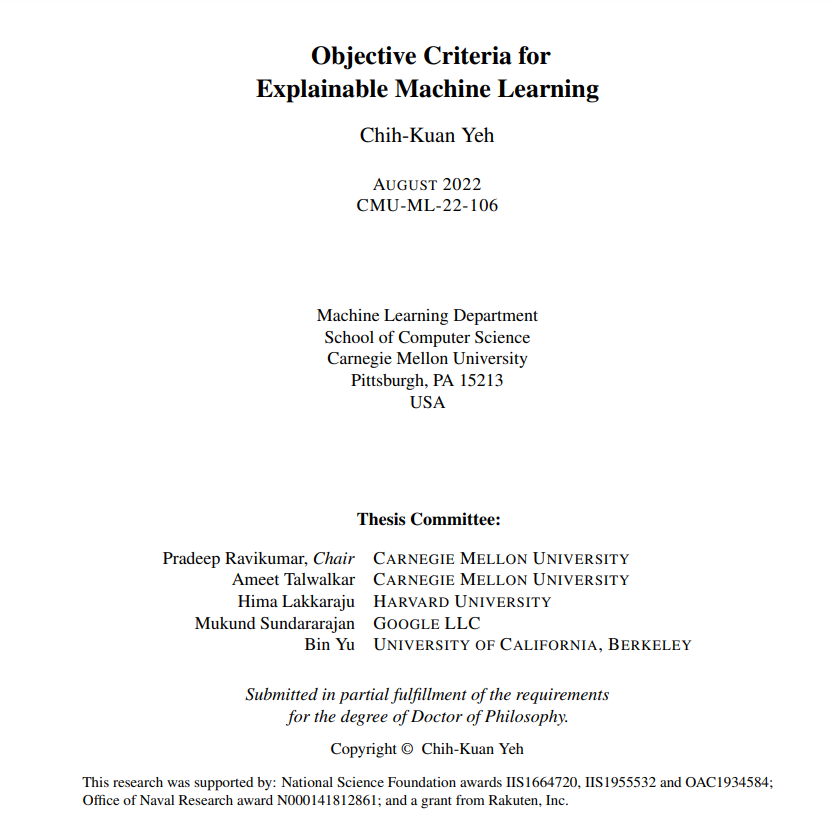

Chih-Kuan Yeh

https://chihkuanyeh.github.io/ 谷歌Brain的研究科学家。在CMU读博期间,研究兴趣集中在通过更客观的解释(可能是功能评价或理论性质)来理解和解释机器学习模型。最近,对用更少(但更有效)的数据构建更好的大尺度模型感兴趣,并通过模型解释获得的理解来改进模型。

**引言

可解释人工智能(XAI)领域关注的是解释机器学习模型的任务,随着现代机器学习模型复杂性的增长,这一领域受到了越来越多的关注。解释机器学习模型复杂的内部工作原理的需求也显著增加,特别是当机器学习模型被应用于高风险决策时,包括金融、法律、医疗、社会应用和自动驾驶。在这些应用中,对高风险决策的解释有助于理解和调试模型,增强用户对模型的信任,明确模型的责任,并与模型就人- ai协作进行沟通。例如,使用人工智能帮助诊断的医生将通过了解人工智能如何预测来决定是否信任它,从而受益。在社交应用中,理解模型为什么会做出某些决定来检验算法是否公平也很关键。此外,《通用数据保护条例》声称,数据保护当局有权解释算法的输出[123]。

解释机器学习模型的一个关键困难是术语“解释”或“可解释性”没有明确定义。目前的大多数解释都解释了复杂模型的某些类型的“属性”,这些属性可以被人类消化。一些常见的属性包括但不限于模型使用的最显著的数据输入特征,模型使用的最显著的训练数据,模型使用的最显著的人类可理解的概念,以及如何改变数据点的特征来改变模型的预测。然而,有许多不同的解释和相互矛盾的哲学。例如,给定一个图像分类器,图像分类器的关键像素可能被认为是对某些用户的一个很好的解释,因为它阐明了模型如何进行预测,但也可能被认为是不可解释的,因为最显著的特征可能不足以推断模型的推理原理。可以进行用户研究和访谈,并要求用户在给定的一组不同的解释中选择最具解释性的算法,这与公正性的度量启发有关[27,75]。然而,要求人类选择最容易解释的解释也有其缺陷。众所周知,人类存在认知偏差,解释似乎是可以解释的,但与模型无关。最近的研究甚至表明,许多关键的解释彼此不一致,用户可以根据个人喜好来决定使用哪种解释[92]。如何选择一个复杂机器学习模型的正确“属性”来解释?

衡量解释有效性的另一种方法可能是评估解释在应用中与人类一起的有用性,这是许多最近的研究提出的。Doshi-Velez和Kim[39]、Murdoch等人[116]提出要评估涉及人类用户的现实应用中的解释,并测试解释如何在现实应用中帮助用户。类似地,Chen等人。[25]鼓励可解释的机器学习问题与目标用例更紧密地联系起来,并建议考虑基于真实任务的模拟版本的模拟。虽然这种评价是基于实际的应用,但利用这种类型的评价可能代价高昂,特别是在解释的发展阶段,因为这种评价往往需要真正的人参与。因此,合理的基于功能的评估对于设计/选择要使用的解释可能是有用的,而应用程序驱动的评估可以用于验证设计/选择的解释可以在真实的应用程序或模拟用例中帮助人类。我们将这类基于功能的评估称为客观标准,主要是因为它在评估阶段不需要实际的人员参与。

在本文中,我们主要考虑三类客观标准(基于功能的评价):(1)以忠实度为动机的客观标准,其动机是解释对模型的描述能力如何;(2)以应用为动机的客观标准,其动机是解释在现实应用中如何被使用;(3)以理论为动机的公理标准,其动机是通过解释的某些理论特性来帮助解释的设计。下面,我们将更深入地讨论这三类客观标准。

- 忠实导向的客观标准

一类基于功能的评价是基于解释对给定模型的忠实程度,也被称为解释的忠实度或描述准确性[116]。解释的忠实度是至关重要的,因为“忠实度”通常很难用人类来衡量——人类可能更喜欢那些在视觉上有吸引力但与要解释的模型无关的解释。客观标准的一种形式是基于“解释是否解释了这个模型?”这个问题。这些评估的核心思想是确定一个忠实的解释应该满足的属性,并在模型-解释对上执行测试,以验证属性是否满足。Murdoch等人[116]也将其称为描述性准确性,因为它衡量了解释解释模型的准确性。例如,许多解释是局部邻域内的线性近似,而忠实度度量度量解释在局部邻域内近似模型的程度。Adebayo等人[2]的一个流行例子是为解释设计一个完整性检查,即随机改变模型权重也应该改变结果解释。令人惊讶的是,并不是所有的解释都令人信服地通过了这个理性检查,这可能意味着一些解释不忠实于模型。

应用驱动客观标准

另一种形式的客观标准是基于与解释相关的应用,特别是那些不需要人工参与或可以自动模拟的应用。例如,寻找有害的训练例是基于例解释的一个关键应用,而基于例解释的某些评估涉及到根据解释删除有害的训练例,并对模型进行再训练,并衡量新模型的性能。由于在这种应用中不需要人工参与,移除和再训练评估已经成为由现实应用驱动的基于实例的解释的一个关键的客观标准。

理论动机的客观标准

基于功能的解释评估的另一种形式是公理形式的理论性质。公理可以被看作是解释在特定输入中应该如何表现的理论约束。如果要解释的机器学习模型具有某种期望的特性,人们会希望这种期望的特性可以反映在解释中。这种解释的约束称为公理性质。例如,如果机器学习模型在两个特征上是完全对称的,并且这两个特征对于某个给定的输入具有相同的值,那么这两个特征对这个输入的解释值应该是相同的。这就是被广泛用于解释方法的对称公理。也许将公理融入设计解释中最常见的工作是Shapley值家族[139],它起源于合作博弈论社区。

本文的目标是开发和定义有意义的客观标准,并使用这些客观标准来帮助我们设计不同类型的解释。由于不同的解释类型自然会遵循不同的客观标准,我们旨在为各种解释类型设计客观标准,包括特征重要性解释、特征集解释、特征交互重要性解释、示例重要性解释和基于概念的解释。