导读 随着大语言模型(LLM)的快速发展,Transformer 架构在自然语言、视频、音频处理上表现突出,大模型技术正在赋能千行万业。大模型+图模型相遇又会发生什么?大模型时代下图机器学习该如何做?这是我们需要思考的问题。本次分享是由北京邮电大学石川教授团队带来的图基础模型初探。文章将深入探讨图基础模型(Graph Foundation Model 简称 GFM)的概念、特点、发展历程。主要内容包括以下几大部分:

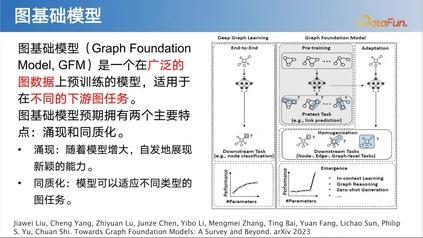

- 图基础模型

- 相关工作进展

- 我们团队的工作

- 总结和展望

- 问答环节 分享嘉宾|石川 北京邮电大学 教授 编辑整理|张俊光 内容校对|李瑶 出品社区|DataFun

01

图基础模型****

1. 基础模型概念基础模型是一种在广泛的数据上训练且可以被应用于多种下游任务的模型。这一概念最初在 21 年由斯坦福大学提出。基础模型已在语言、视觉、语音等领域展现出强大的实力,并逐渐成为这些领域的核心力量。基础模型通过在大规模数据集上进行预训练,积累了丰富的知识和能力,从而能够轻松应对各种下游任务。在语言领域,大语言模型已成为主导,传统的语言处理任务几乎已被其全面取代。同样,在视觉和语音领域,基础模型也发挥着举足轻重的作用。它们不仅提升了任务处理的效率和准确性,更为我们打开了通往更广阔应用前景的大门。基础模型的崛起,标志着人工智能领域正迎来一个全新的发展时代。****

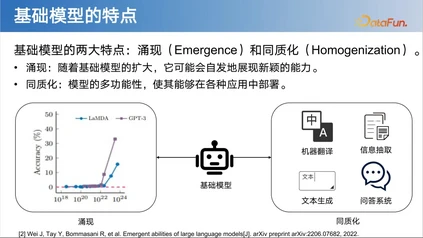

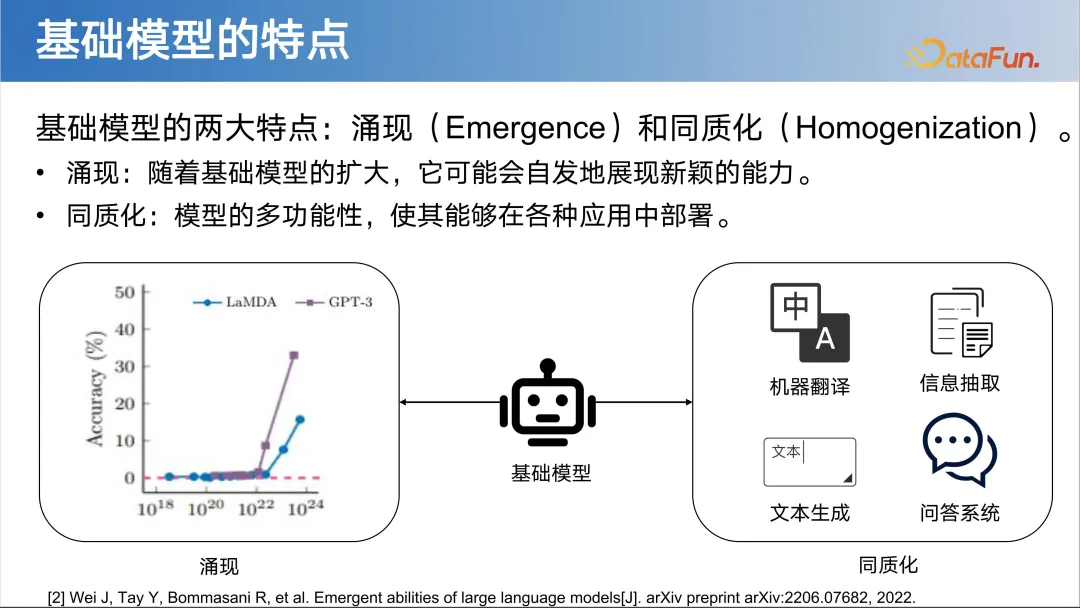

2. 基础模型特点****

**3. ****大语言模型(LLM)**大语言模型,无疑是基础模型中的璀璨明星。它拥有令人瞩目的庞大参数量,从昔日的 ELMO 百万参数模型,一路疾驰,发展到如今 GPT4 的万亿参数规模,展现出了强大的预训练语言处理能力。这种模型不仅具备理解、生成文本的基础功能,更拥有出色的逻辑推断和记忆能力,可谓是人工智能领域的全能选手。大语言模型在通用人工智能领域展现出了巨大的潜力和广阔的应用前景。它不仅能够智能涌现出各种答案,还能巧妙运用同义词进行表达,使得语言处理更加自然流畅。无论是回答复杂问题、创作文学作品,还是进行逻辑推理、记忆检索,大语言模型都能游刃有余地应对,成为通用人工智能的有效实现方式。

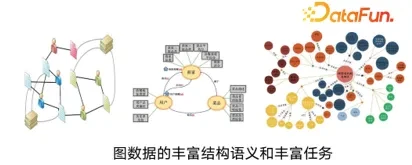

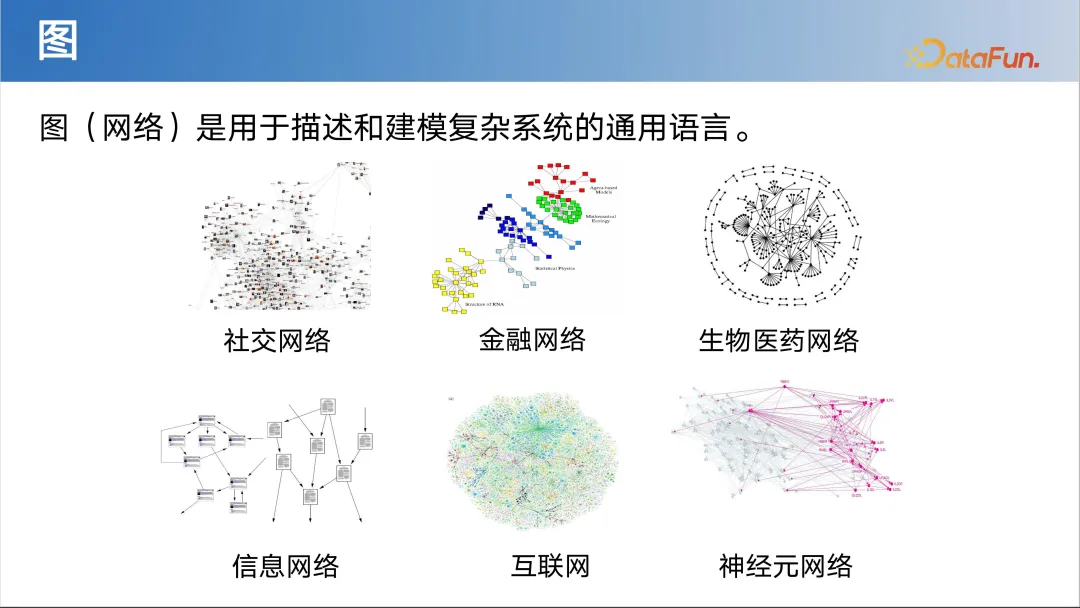

4. 图的基本概念****

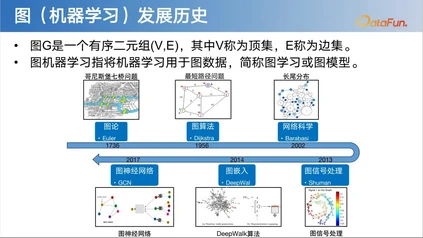

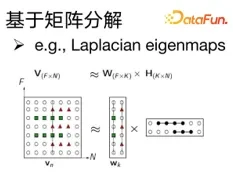

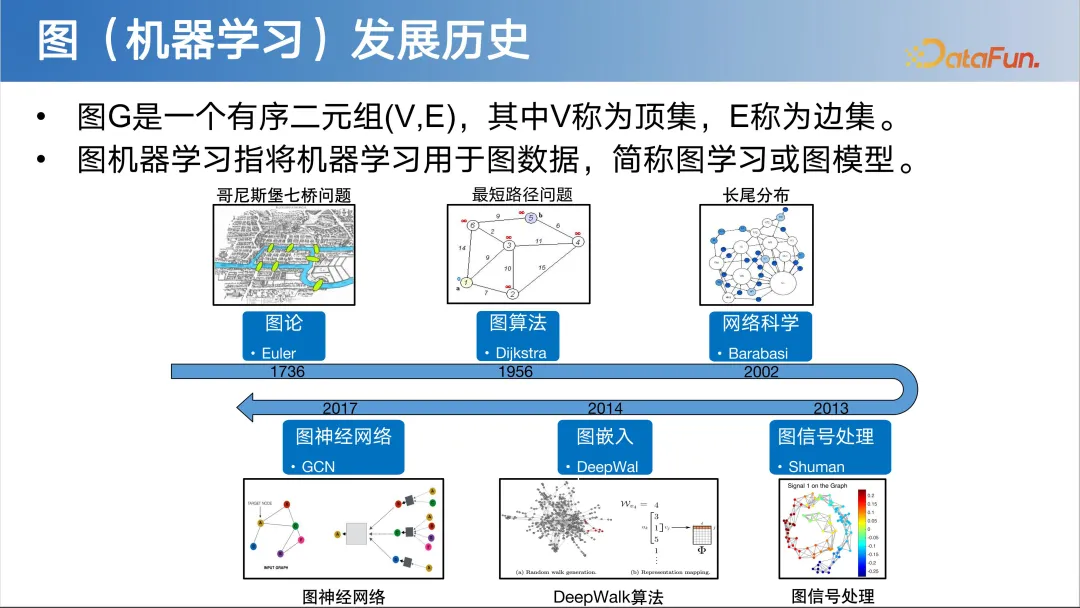

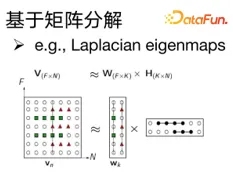

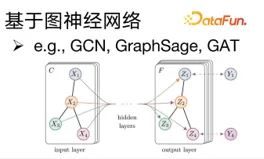

7. 图机器学习的发展与分类**(1)浅层模型①基于矩阵分解**

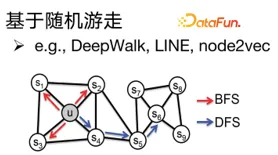

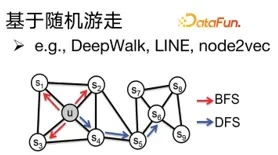

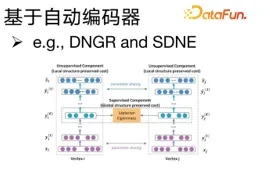

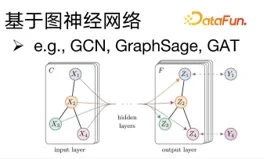

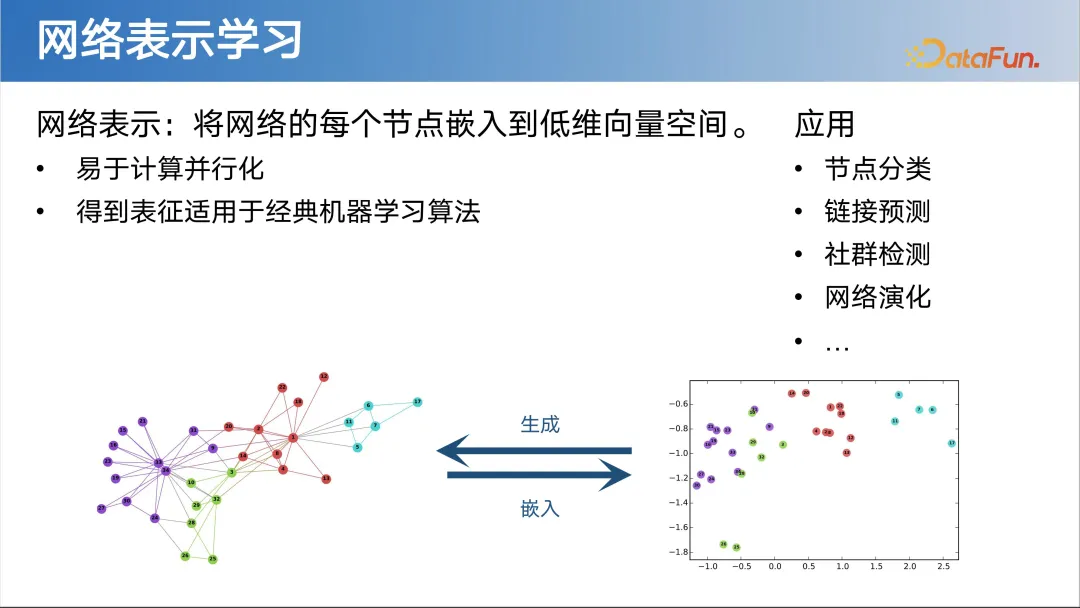

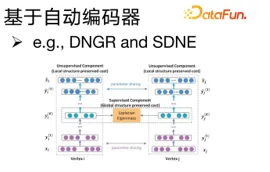

近年来,基于随机游走的方法在图网络表示学习中备受关注。这些方法实际上借鉴了自然语言处理中的 Word2Vec 等表示学习模型。它们的核心思想是,通过模拟图中的随机游走过程,认为在游走序列中相邻的节点应该具有相近的表示。这类方法可以有效地捕捉图中节点的上下文信息,从而生成低维且富含语义信息的节点向量表示。这种表示方式不仅有助于提升节点分类、链接预测等任务的性能,还为我们提供了一种深入理解图结构的新视角。(2)深层模型①基于自动编码器****

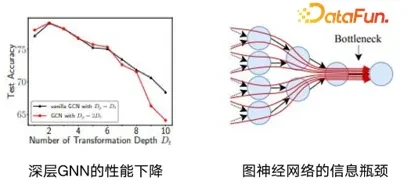

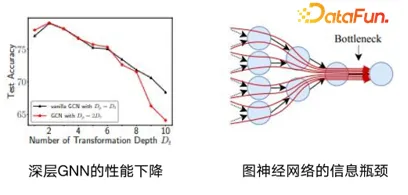

8. 当图模型遇到大模型**(1)大模型解决不了图的问题**

- 涌现:随着基础模型增大,自发地展现新颖的能力。

- 同质化:模型可以适应不同类型的图任务。

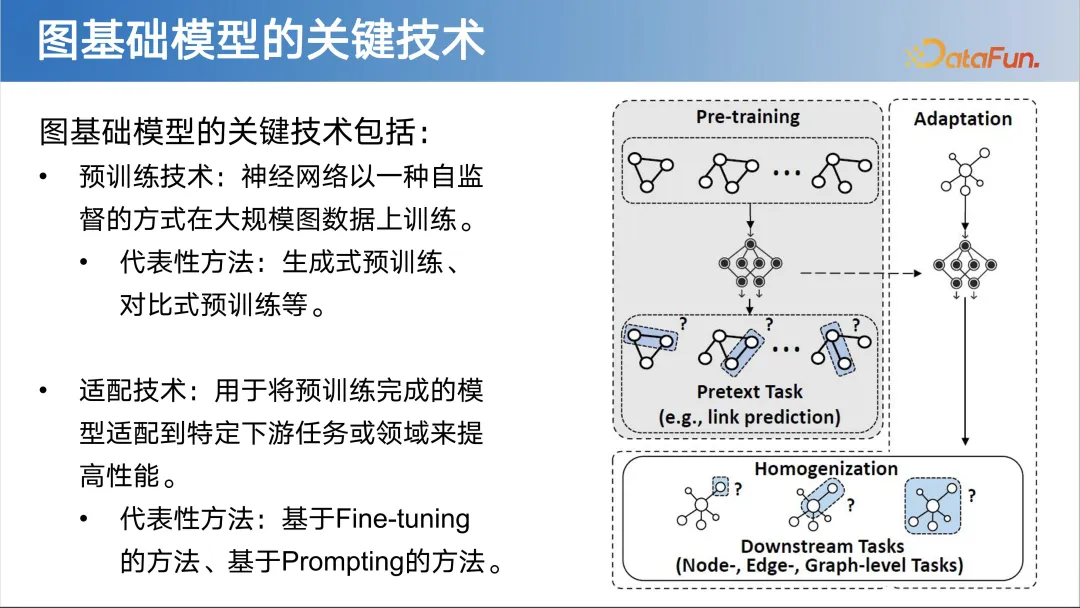

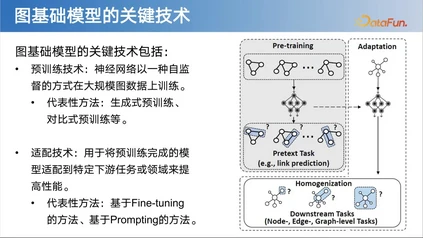

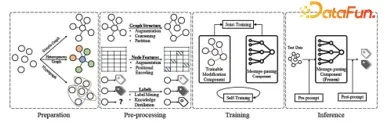

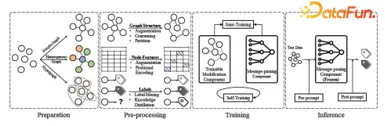

10. 图基础模型的关键技术图基础模型的关键技术包括两个方面:预训练技术和适配技术。

- 预训练技术:神经网络以一种自监督的方式在大规模图数据上训练,代表性方法有生成式预训练、对比式预训练等。

- 适配技术:用于将预训练完成的模型适配到特定下游任务或领域来提高性能,代表性方法为基于 Fine-tuning(微调)的方法和基于 Prompting(提示词)的方法。

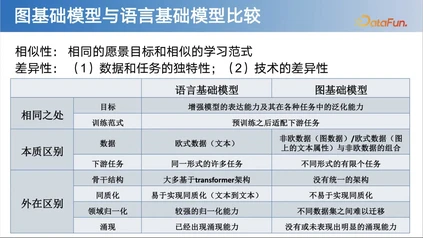

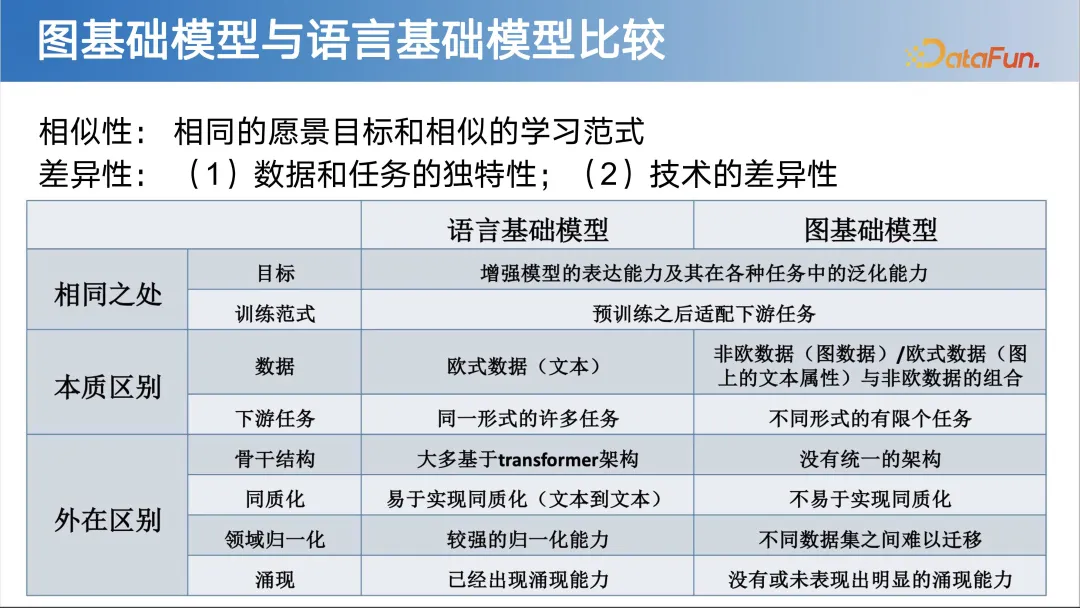

11. 图基础模型与语言基础模型比较

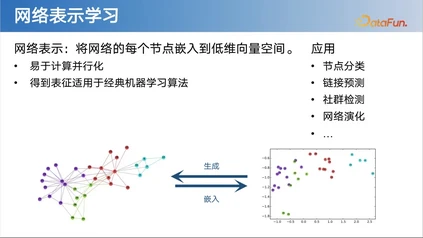

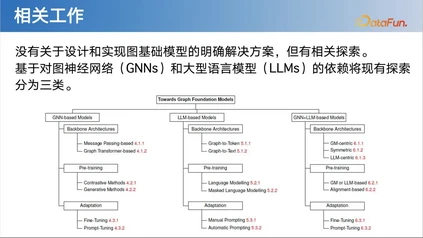

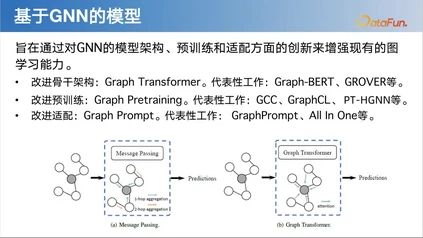

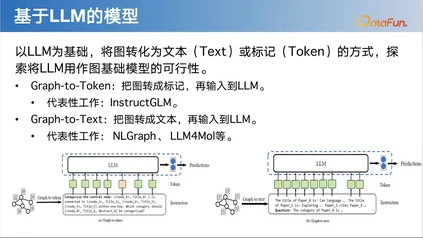

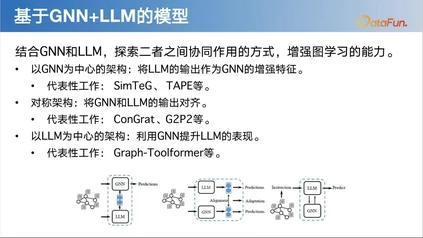

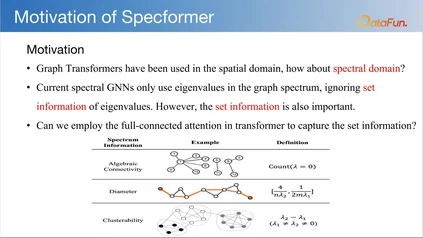

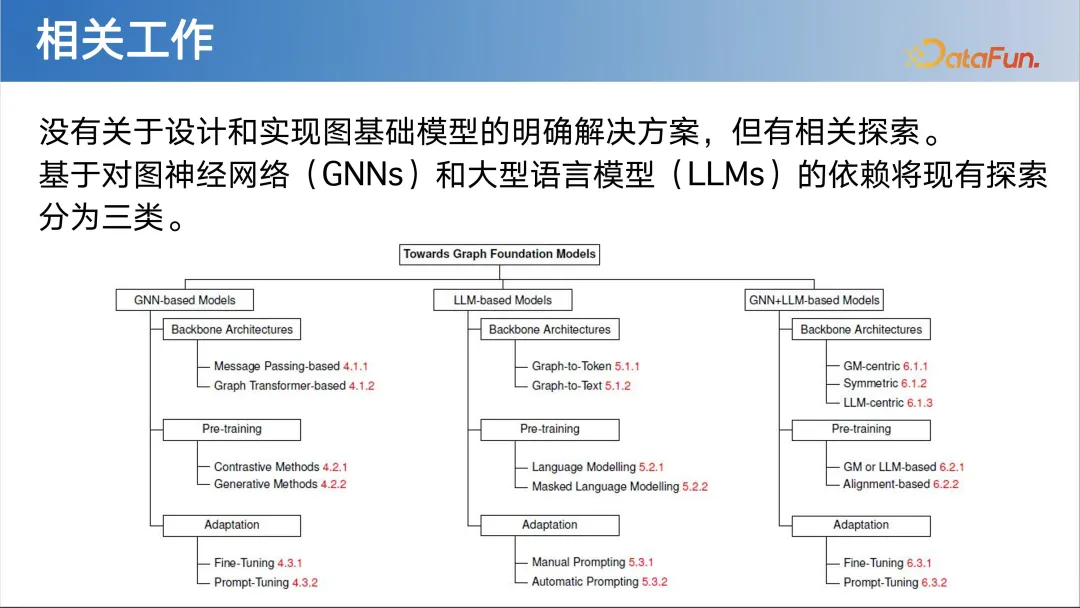

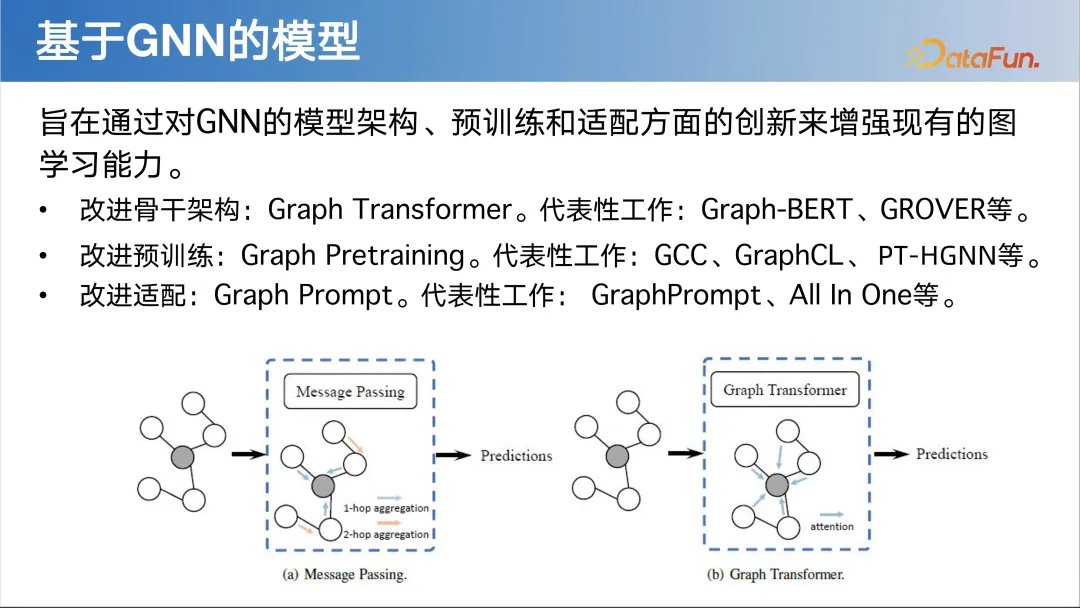

相关工作进展******1. 图模型类别******

- 改进骨干架构:Graph Transformer。代表性工作:Graph-BERT、GROVER 等。

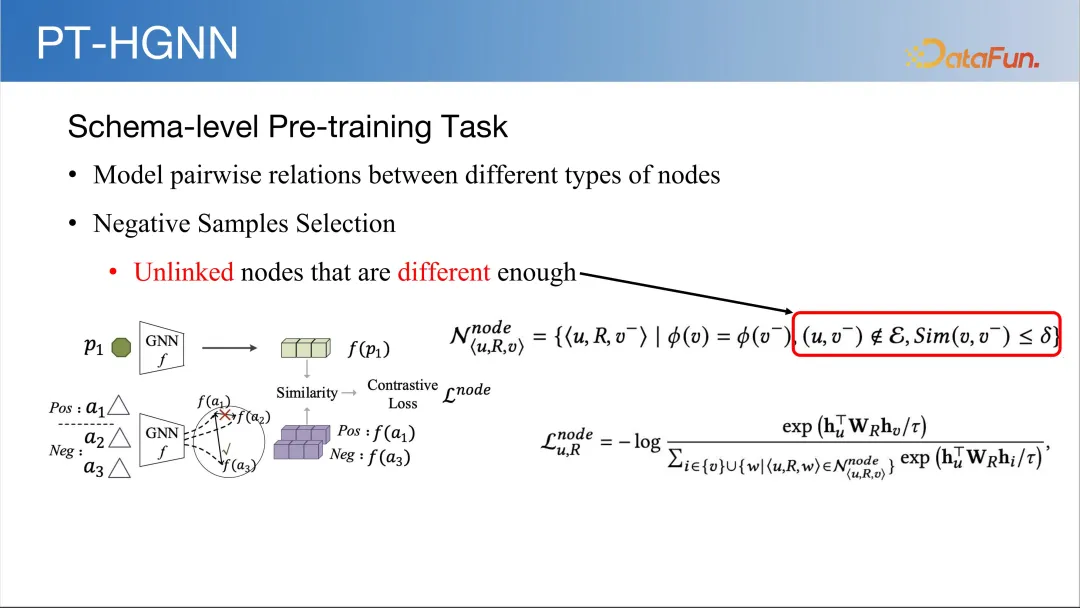

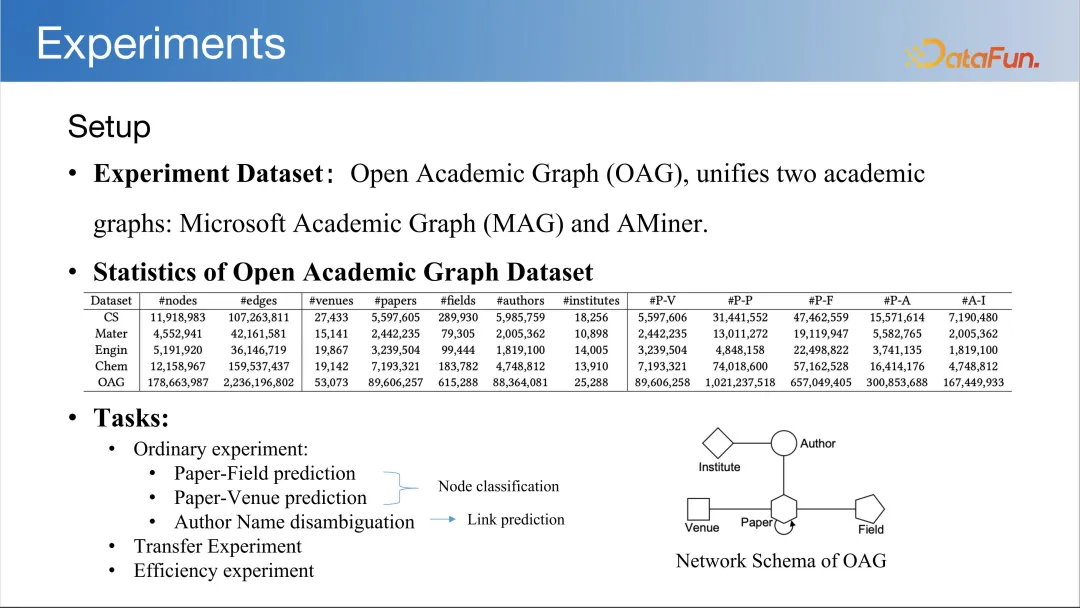

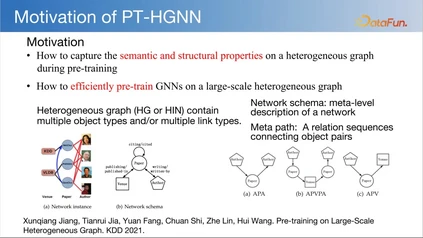

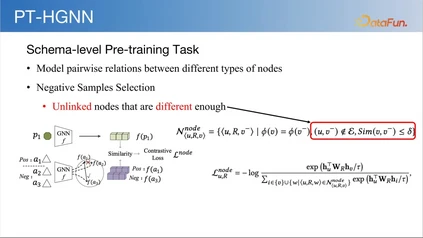

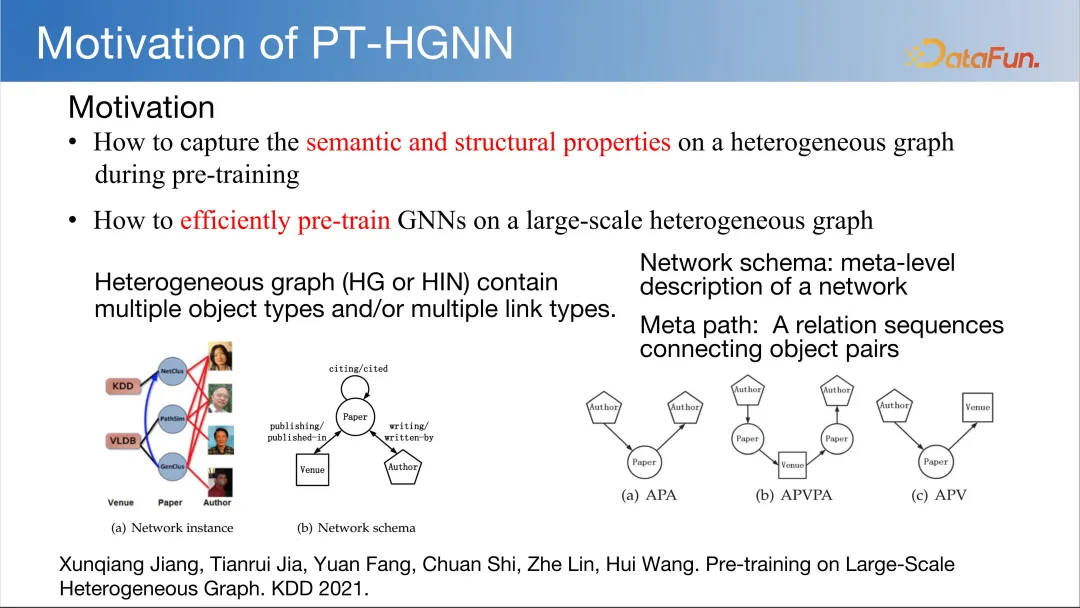

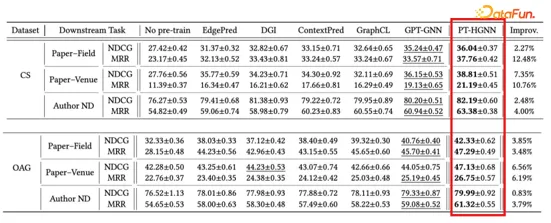

- 改进预训练:Graph Pretraining。代表性工作:GCC、GraphCL、PT-HGNN 等。

- 改进适配:Graph Prompt。代表性工作:GraphPrompt、All In One 等。

- Graph-to-Token:把图转成标记,再输入到 LLM。代表性工作:InstructGLM。

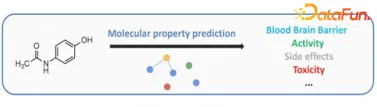

- Graph-to-Text:把图转成文本,再输入到 LLM。代表性工作:NLGraph、LLM4Mol。

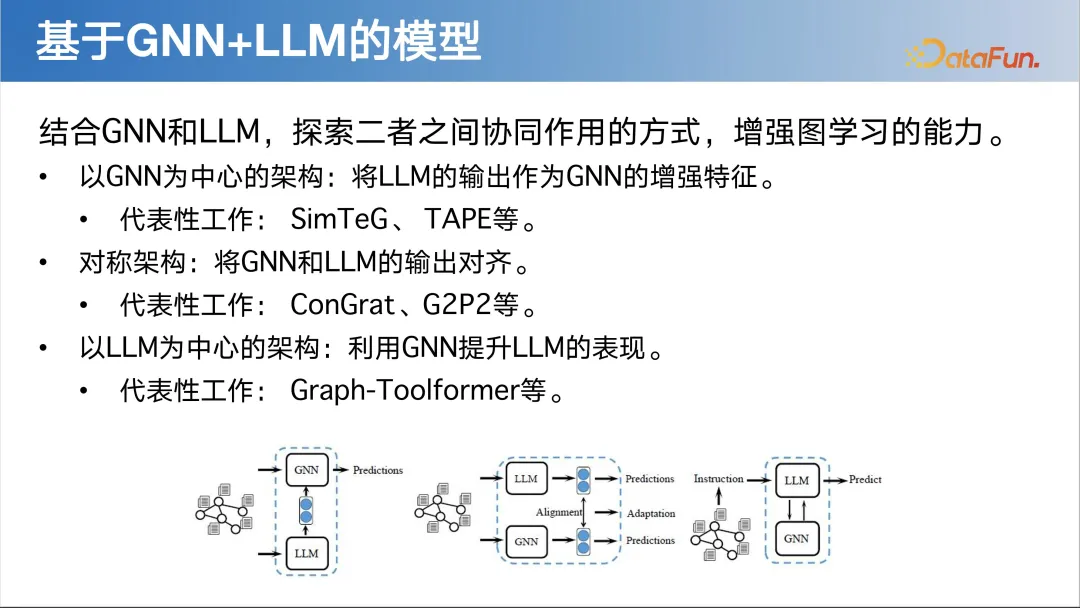

- 以 GNN 为中心的架构:将 LLM 的输出作为 GNN 的增强特征。代表性工作: SimTeG、TAPE 等。

- 对称架构:将 GNN 和 LLM 的输出对齐。代表性工作:ConGrat、G2P2 等。

- 以 LLM 为中心的架构:利用 GNN 提升 LLM 的表现。代表性工作:Graph-Toolformer 等。

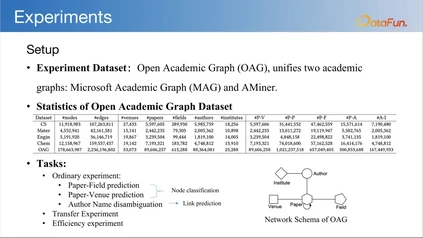

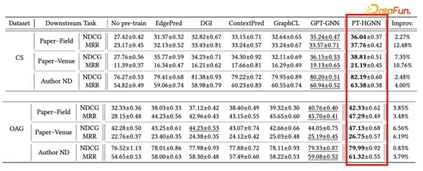

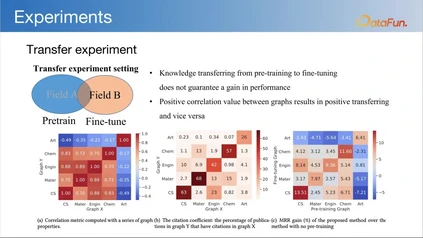

我们团队的工作****接下来介绍我们在图基础模型方面的三项探索。

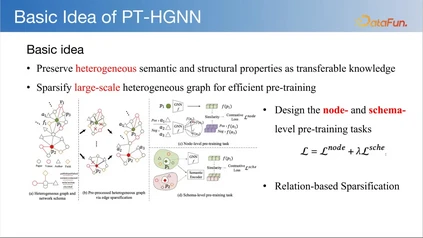

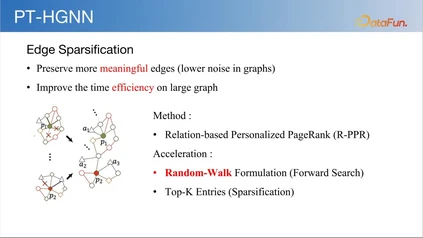

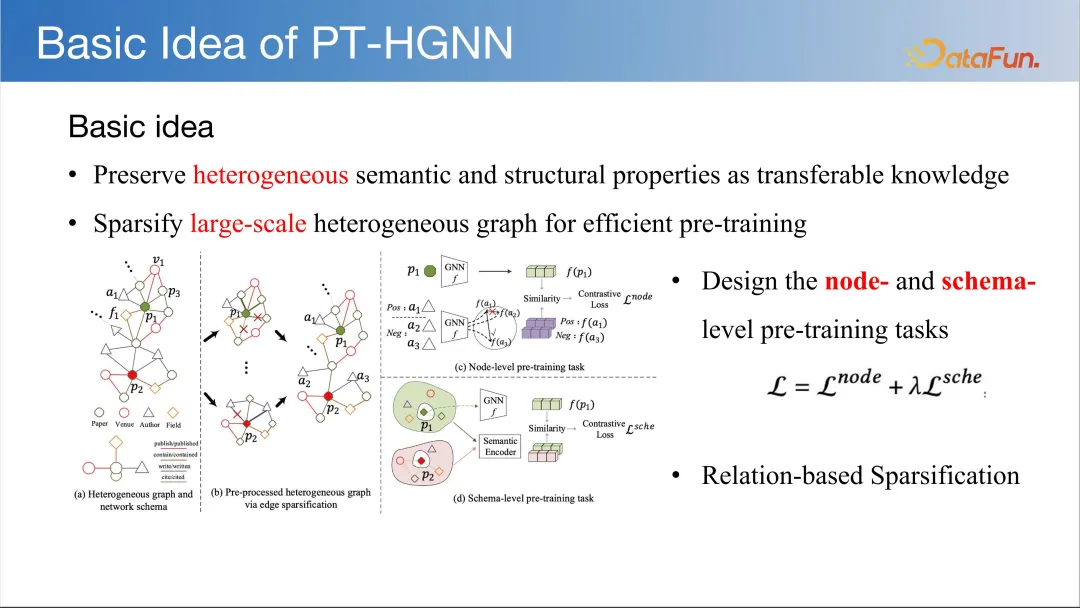

- 将异质语义和结构属性保留为可转移的知识

- 稀疏化大规模异构图,实现高效的预训练 具体细节如下图,在此不做详细介绍。

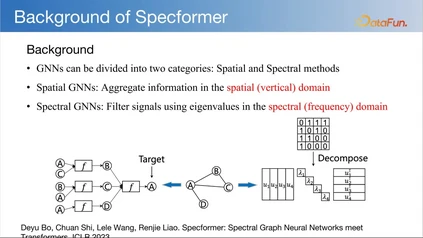

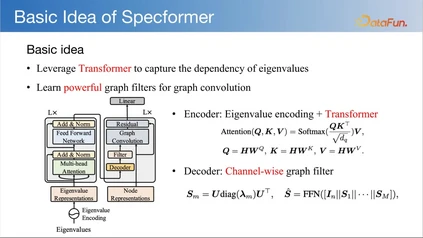

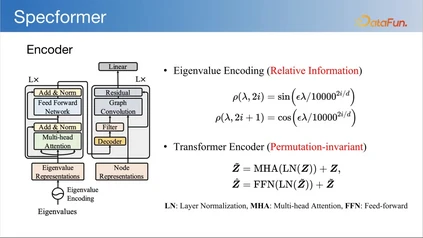

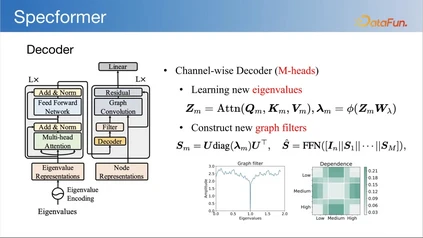

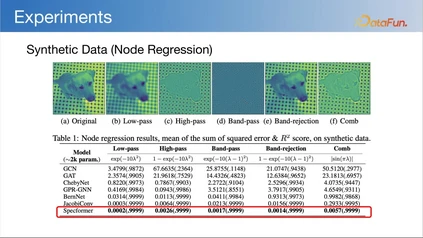

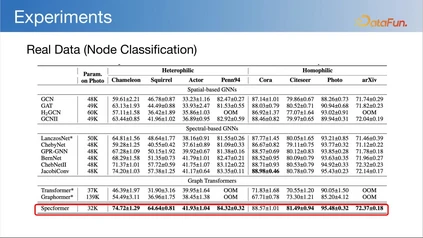

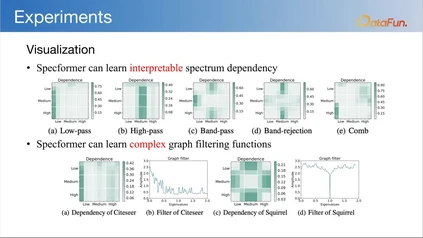

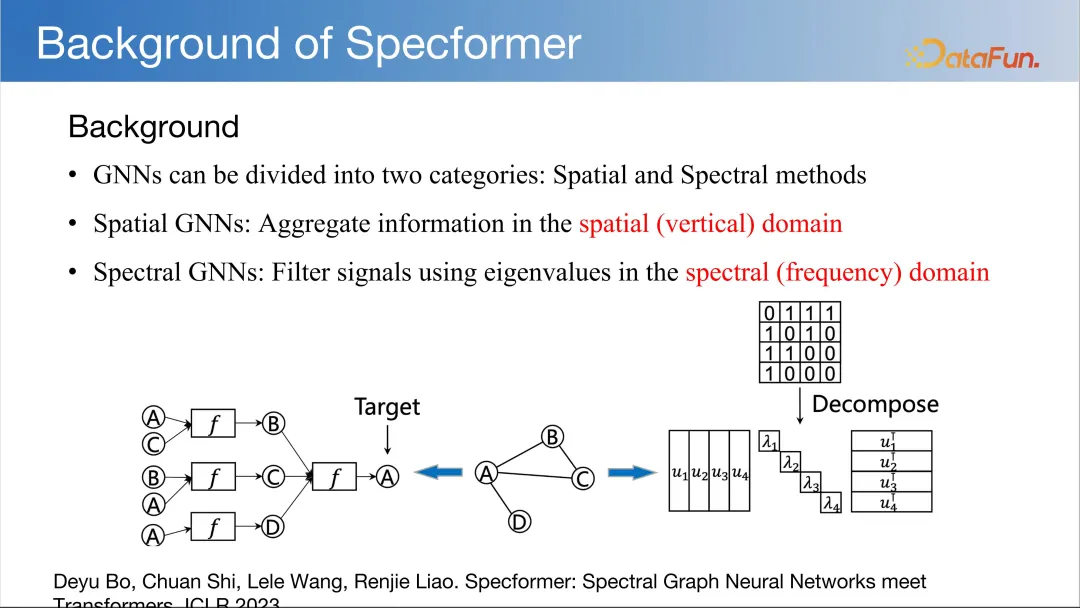

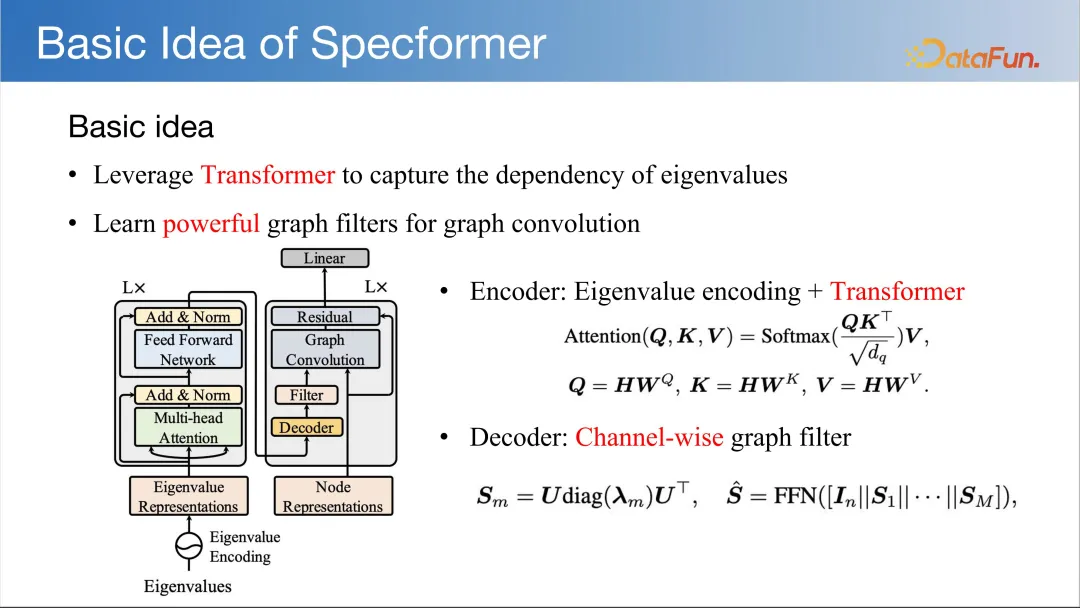

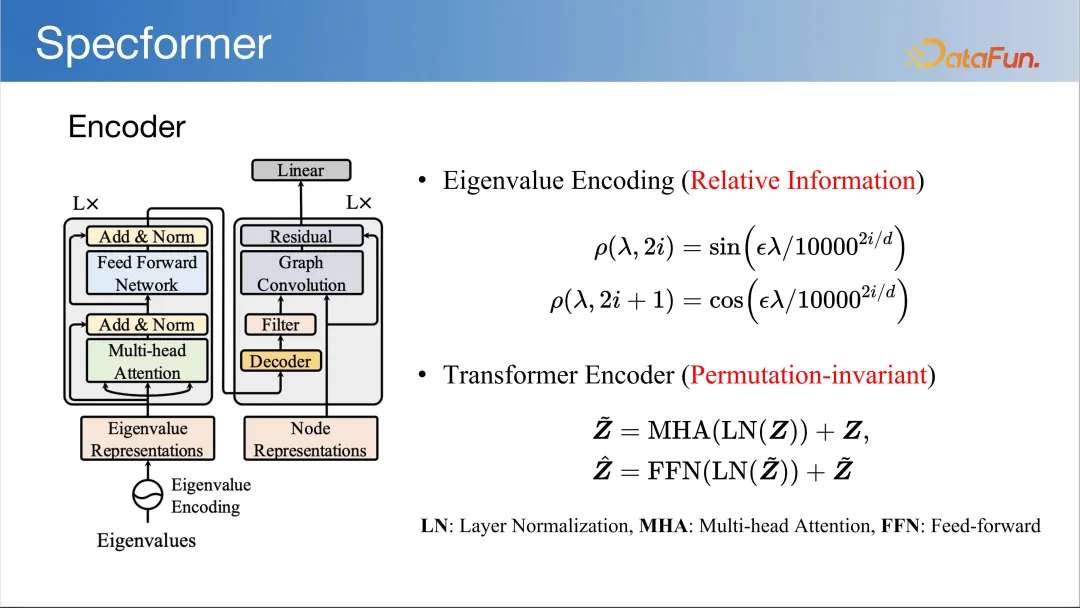

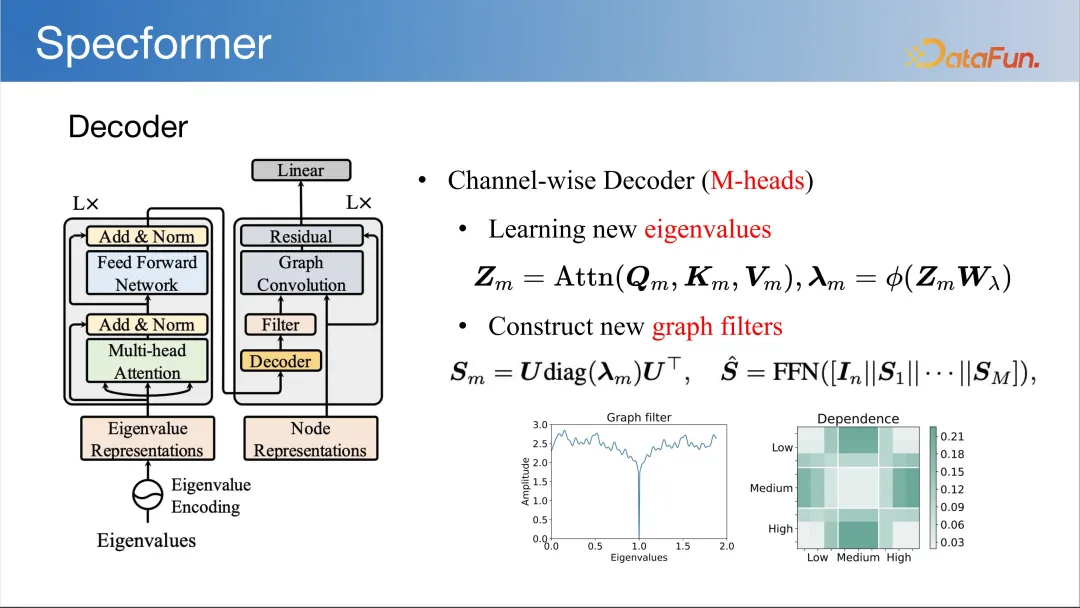

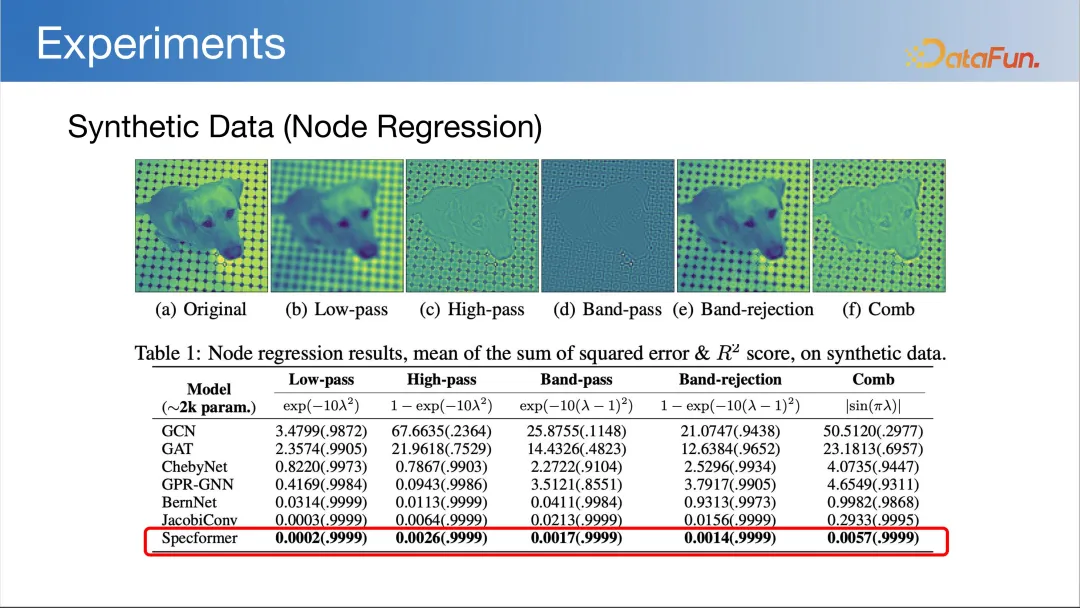

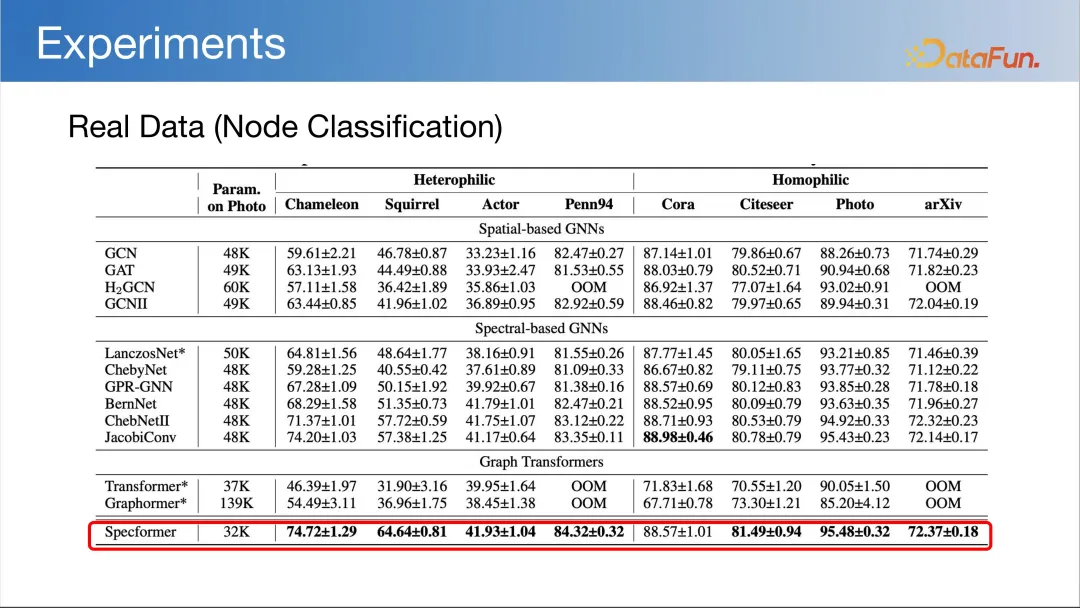

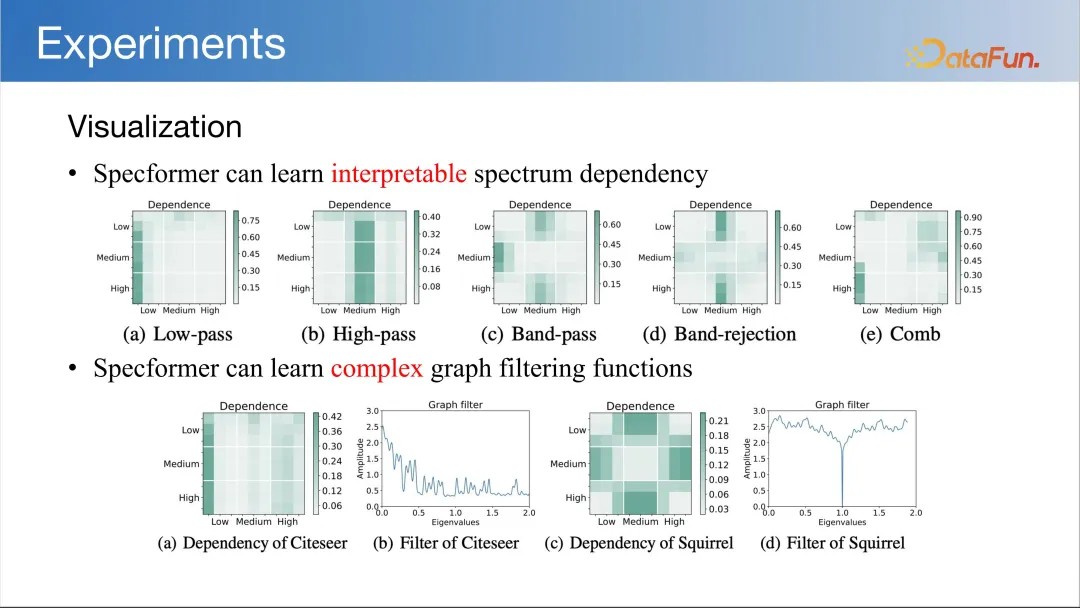

- 能够识别出哪些特征值对图的表示学习更为重要,以及这些特征值是如何相互作用的。这样的学习过程可以帮助模型更好地理解和处理图数据,从而在图分类、节点分类、链接预测等图机器学习任务中取得更好的性能。同时,这种对谱特性的深入理解也为研究人员提供了一种方式,使得他们能够解释模型的行为,而不是仅仅将其视为一个“黑箱”。

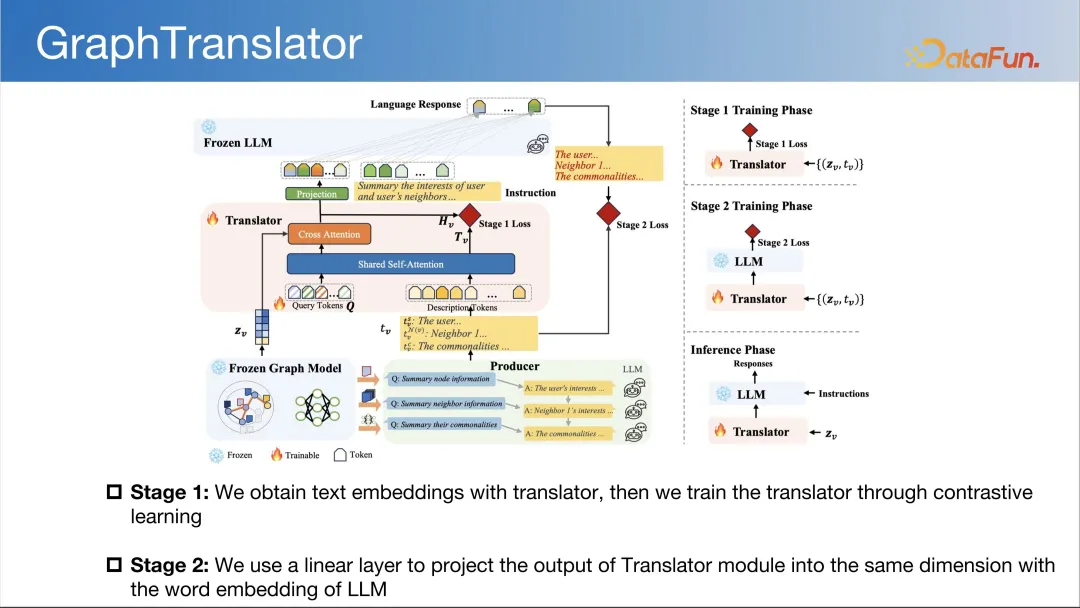

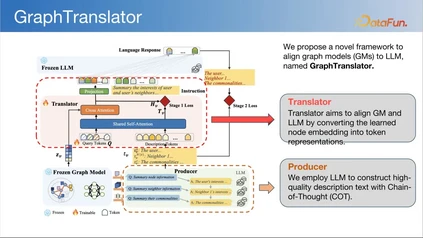

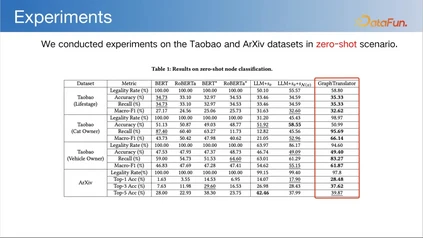

- 能够捕捉图数据中节点间的复杂关系,并通过学习到的图滤波函数来改善图任务的性能。这使得 Specformer 在处理图数据时更加灵活和强大,尤其是在面对具有复杂拓扑结构和信号特性的图时。 3. GraphTranslator (WWW 2024)********

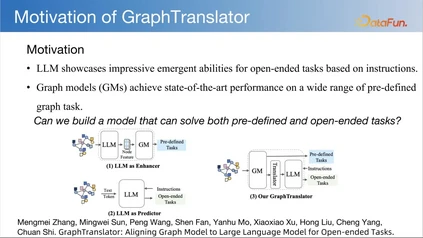

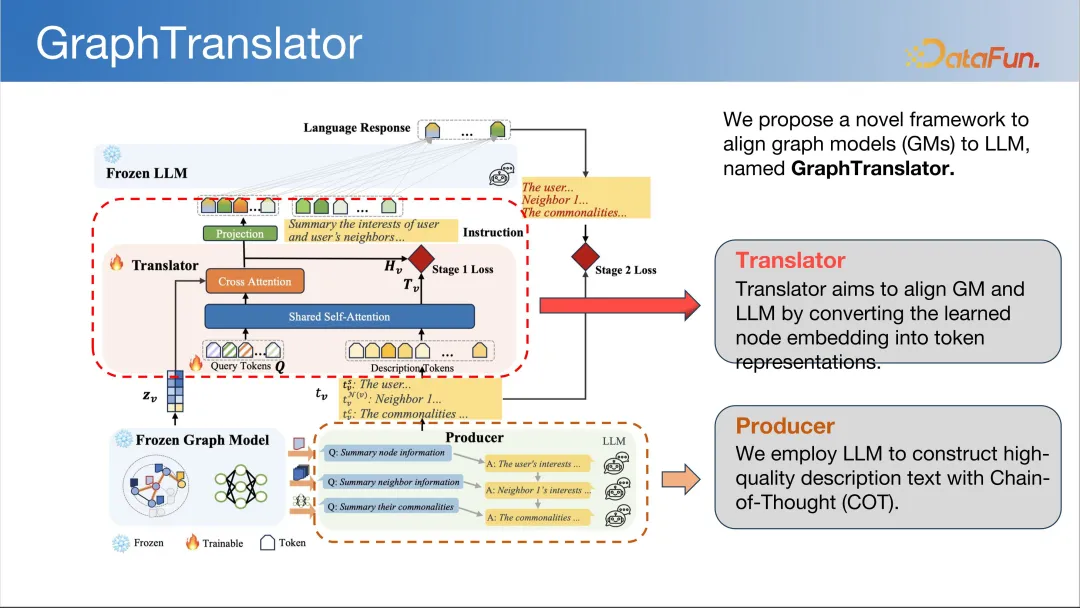

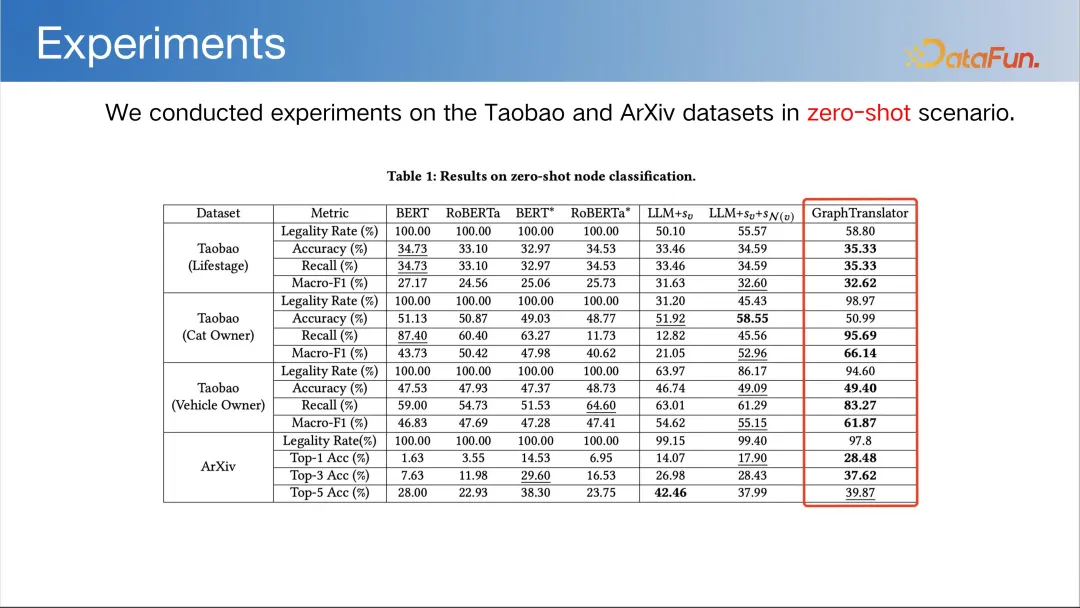

- LLM 展示了在基于指令的开放式任务中令人印象深刻的涌现能力;

- 图模型 (GM) 在各种预定义的图任务上实现了最先进的性能;

- 我们能否构建一个既能解决预定义又能解决开放式问题的模型? 问题的关键在于图模型和 LLM 如何对齐。****

-

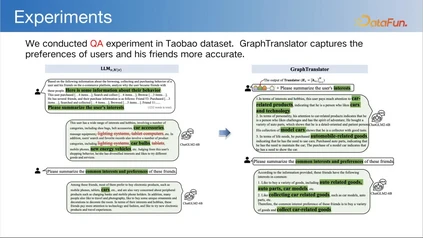

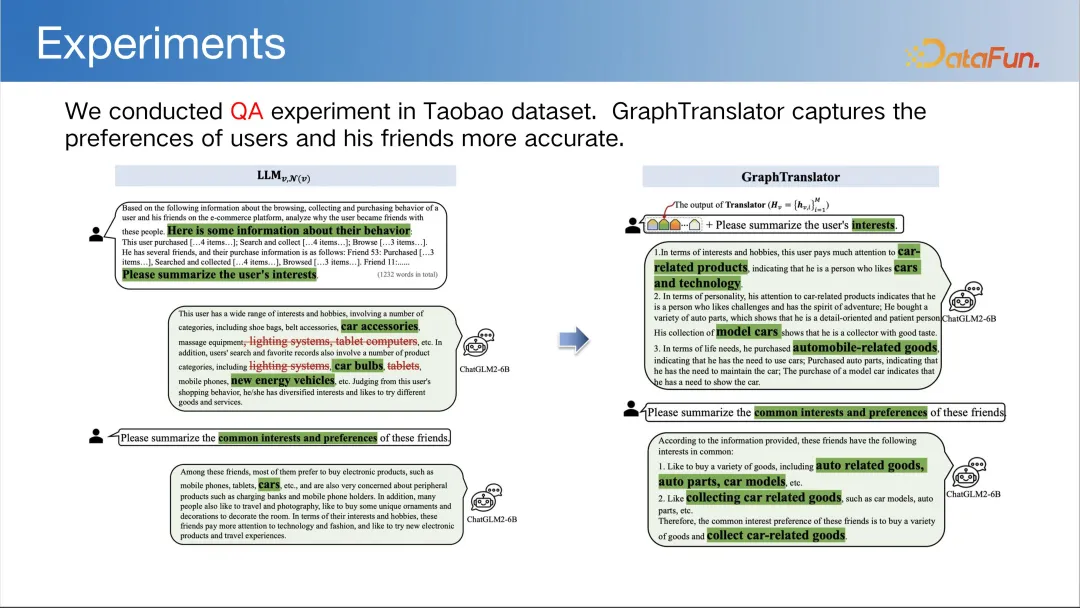

Translator:旨在通过将嵌入的学习节点转换为令牌表示来对齐 GM 和 LLM。

-

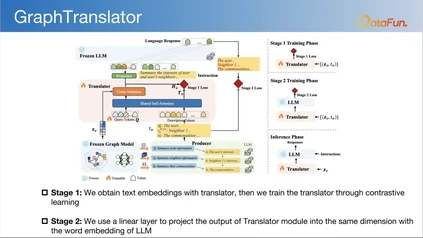

Producer:我们使用 LLM 来构建具有思维链(COT)的高质量描述文本。 训练步骤如下图所示:

-

第一阶段,可以利用图转换器来处理图数据,其中图转换器采用了 Transformer 架构,将图视为完全连接的结构,从而考虑和衡量图中每对节点之间的相似性。相比之下,消息传递机制在图的邻接矩阵约束下运作,只在显式连接的节点之间传播信息。这种方法使得图转换器能够具有长距离建模能力和强大的表达能力,特别在分子预测任务中表现出了有效的结果。

-

第二阶段,通常会进一步优化和改进图转换器的性能,包括引入更复杂的模型结构、调整超参数、增加训练数据量等方法。这些改进旨在提高图翻译器在处理图数据时的准确性、泛化能力和效率,从而更好地应对现实世界中复杂的图数据任务。这一阶段的工作通常需要深入的实验和分析,以确保所做的改进能够有效地提升图翻译器的性能。

总结与展望我们在图机器学习方面做了非常多的工作,对学习机制、不同类型数据、如何增强鲁棒性、可信性等方面进行了深入研究和大量探索,并尝试将图神经网络应用到安全和推荐等领域,在很多实际业务中取得了很好的效果。关于图基础模型,我们发表了一篇文章,欢迎大家阅读。

3. 模型评估和杀手级应用****

问答环节******Q1****:****提高模型可解释性,有哪些方向。**A1:提升模型的可解释性,特别图神经网络的可解释性,是一个很重要的问题,但是目前做得并不是太好,因为可解释性是一个很主观的东西。我认为提升可解释性主要包括几个方面:

- 一是从理论的角度能够解释图神经网络为什么有效,又存在哪些不足,可以从理论上做一些分析,我们在这方面也做了一些工作,用统一优化框架来解释图神经网络。

- 二是有一些技术方法具有一些可解释性和语义性,例如 PT-HGNN 神经网络,它的特征值和特征向量实际上都是有物理意义的,可以提供一定程度的可解释性。

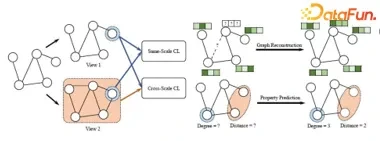

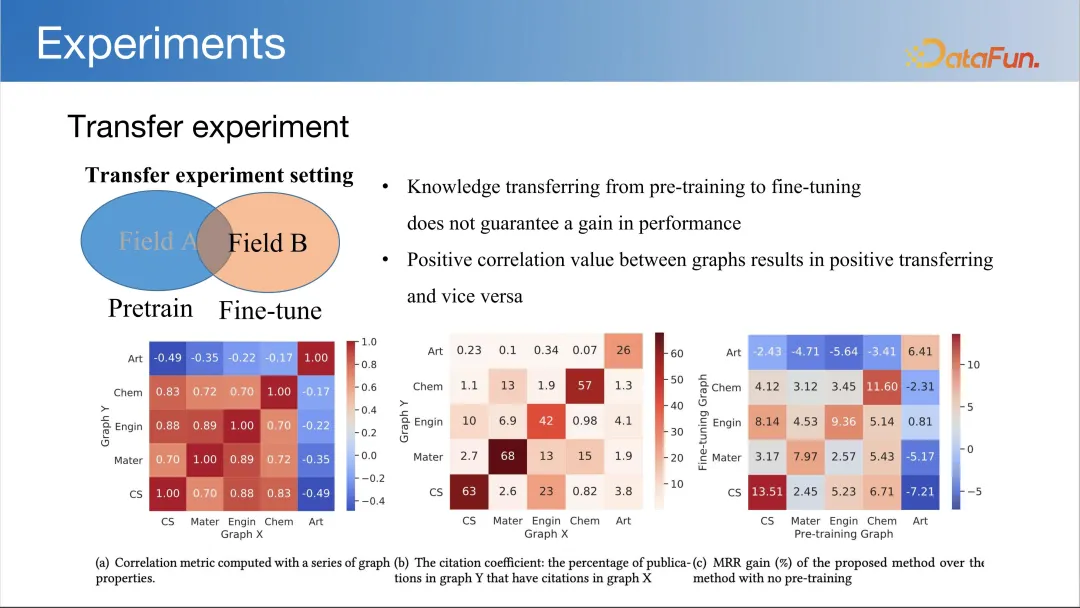

- 三是意志图沉浸网络。意志图沉浸网络是一种基于 HGT(Heterogeneous Graph Transformer)的 GNN 模型,它采用了同尺度的对比学习(Same-Scale CL)和 Vanilla Fine-Tuning(Vanilla FT)策略作为自适应方法,有较好的结构语义信息,因为它的节点和边都是有语义的,可以增强其语义解释。 Q2**:****未来图大模型也会是一个像自然语言一样的同质的统一的模型,还是一个需要接不同分类器的模型?A2:目前图大模型或者图基础模型还有没有一个明确的方案,还处于探索中。但图基础模型的实现,相对语言基础模型来说会更复杂。目前没有统一的框架,因为结构知识的迁移往往是更困难的。而且很多知识可能就不具备迁移性。某一领域相关的数据图,是可以设计一个通用模型,能够比较好地解决这一个领域的大部分问题,这是当前的状态。Q3:****鲁棒图神经网络有哪些方向?A3:鲁棒图神经网络涉及图神经网络的安全性,这里可以做的东西很多,比如模型的盗取、模型的攻击、各种攻击形式、模型可靠性等等。AI 安全实际上也是 AI 的一个很重要的研究方向,我们都可以借鉴过来做 GNN 的安全。Q4:****现在 LLM 加 GNN 的工作是否都是 a 加 b 式的工作?****A4:不能简单地理解为 a 加 b 式的工作。要借鉴大模型里面的一些技术和方法,但LLM 和图模型有一些本质性的区别,虽然可以借鉴一些思想,但肯定要针对图模型做一些全新的设计,这还是很有挑战性的,所以不是简单的 a 加 b 式的工作。Q5:****未来的图大模型是基于 GNN 的形式还是基于大模型的形式。A5:目前没有定论,GNN、LLM、GNN+LLM 这三种技术手段都有可能,且各有利弊,适用于不同的场景和任务。这三类都值得探索,未来到底是不是有可能会出现像大语言模型一样一统天下的一个模型,现在还不可知。Q6:****进行训练的图数据与进行测试的图任务,其载体除了 Graph 形式还有文本形式吗?如果有以文本形式为载体的图结构,是否可以使用一些自然语言处理的思想去研究它?A6:我认为是可以的,文本图也是研究很多的一种数据。既有文本信息,又有结构信息,可以很自然地把语言模型和图模型进行结合,这也是目前的一个研究热点。Q7:****图机器学习的结构是否具备迁移性?图的结构迁移性问题还有哪些值得探索的?比如图 OD 问题。A7:图的结构知识迁移性是一个很重要的问题,图结构特性能否定量描述,能不能说图的结构支持多大程度迁移,什么情况下能进行迁移,同领域图数据多大程度能迁移,跨领域的能不能迁移等等,有很多问题是值得深入研究的,目前在这方面的工作都不太多。图机器学习的结构具备迁移性,但在面对不同领域的图数据时,其迁移性可能会受到限制,尤其是当遇到与训练数据结构或特征差异显著的图结构时,其性能可能会显著下降。图的 OD 问题,也是很重要的一个问题,图基础模型也是解决 OD 问题的一个可行的技术手段。Q8:****图基础模型与多模态基础模型有哪些结合的点?A8:目前多模态模型基本上很少考虑图结构,其实文本图结构跟其他模态结合,这就是一个多模态的模型,文本图结构+文本+视频,实际上是都可以做的。从图的角度来做的话,我们也是希望图的结构能够在各种模态中占据一个重要的位置,能真正对性能有所提升。Q9:您的团队是否对超图神经网络进行过探索?有哪些值得关注的方向?****A9:超图神经网络也是一个很重要的研究方向。像清华大学的高月老师在这方面做了很多很好的工作。我们也在一些应用中用到了超图建模,其对于构建高阶结构关系是很有用的。这也是超图建模的一个很重要的方法,是值得深入探索的。Q10:训练的图结构和测试的图结构不同,应该如何处理?****A10:这涉及到图的 OD 和图结构知识迁移的问题。这是一个比较难的问题,要更好地形式化,让它在某种程度上是能解决的,能够实现一些结构知识的迁移,能够改善一下它的性能。最主要的还是把问题定义清楚,使其成为一个有意义的问题。Q11:区别于其他领域,图模型最突出特有的思想是什么?

**A11:图结构的非欧特性跟文本的序列结构和图的网格结构,本质上是不一样的,因此也产生了它独特的分析方法,不是自然语言或 CV(机器视觉)的方法能够直接解决的。这也体现了图机器学习社区存在的价值。目前的大语言模型(LLM)基本上摧毁了 NLP,也让 CV 领域受到了极大的冲击。相对来说对图机器学习对图模型虽然有一些影响,但影响还没那么大,这也给我们留下了更大的发展空间。以上就是本次分享的内容,谢谢大家。

分享嘉宾

INTRODUCTION

石川

北京邮电大学

教授

石川,北京邮电大学计算机学院教授、博士研究生导师、智能通信软件与多媒体北京市重点实验室副主任。主要研究方向: 数据挖掘、机器学习、人工智能和大数据分析。近 5 年以第一作者或通讯作者在 CCF A 类期刊和会议发表论文 60 余篇,中英文专著五部,谷歌学术引用过万,连续入选爱思唯尔高被引学者;授权发明专利 30 余项,相关研究成果应用于阿里、蚂蚁、腾讯、华为、美团等公司。研究成果获得中国电子学会科技进步一等奖和北京市科学技术奖自然科学二等奖等奖励。