导读 最近一年以来,大语言模型技术突飞猛进,被广泛地认为开启了人工智能研究的新阶段。大语言模型时代的到来,给知识图谱技术也带来了新的机遇与挑战。我们在 5 月份的时候曾经发布过知识图谱与 AIGC 大模型的知识地图,其中包括了文本生成、图像生成等技术。本次分享将聚焦于大语言模型最新的研究进展,从大模型对知识工程的帮助、知识图谱帮助大模型的评测和应用,以及未来知识图谱与大模型交互融合的展望等几个方面进行介绍。

主要内容包括以下几个部分:

- 大语言模型与知识图谱的对比

- 大语言模型助力知识抽取

- 大语言模型助力知识补全

- 知识图谱助力大语言模型能力评测

- 知识图谱助力大语言模型落地应用

- 知识图谱交互融合

- 结束语

- 参考文献 分享嘉宾|付瑞吉博士 快手科技 知识图谱中心负责人 编辑整理|张进东 内容校对|李瑶 出品社区|DataFun

01

大语言模型与知识图谱的对比****首先来对比一下大语言模型和知识图谱的优势与劣势。

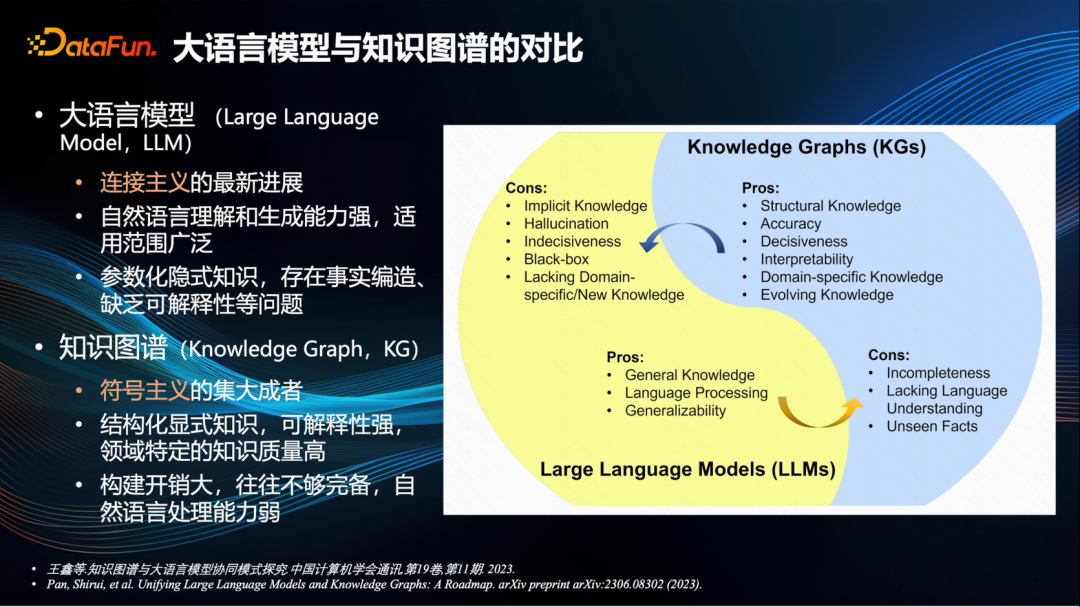

去年 ChatGPT 问世的初期,还曾有声音说知识图谱已经过时了,将被大模型所替代。然而,随着这一年来的深入探讨和研究,目前业界普遍认为,大语言模型和知识图谱各有所长,能够互相补充[1,2]。具体而言,基于深度神经网络技术的大语言模型是连接主义的最新里程碑,其优势在于对自然语言的理解和生成能力极强,适用范围广泛。而缺点则是其中的知识是参数化的隐式知识,存在事实的编造,缺乏可解释性等问题。也就是我们常说的大模型生成内容存在幻觉的现象。知识图谱是符号主义的集大成者,过去十几年来受到了广泛的研究与应用。它的优点是知识结构化、显式化,可解释性非常强,特别是在某些特定领域,知识质量极高。当然,缺点也很明显,那就是构建成本太高,往往不完全正确,在自然语言处理方面相对较差。那么二者应该如何相结合进行优势互补呢?接下来将从不同角度来分析二者的相互作用。

02

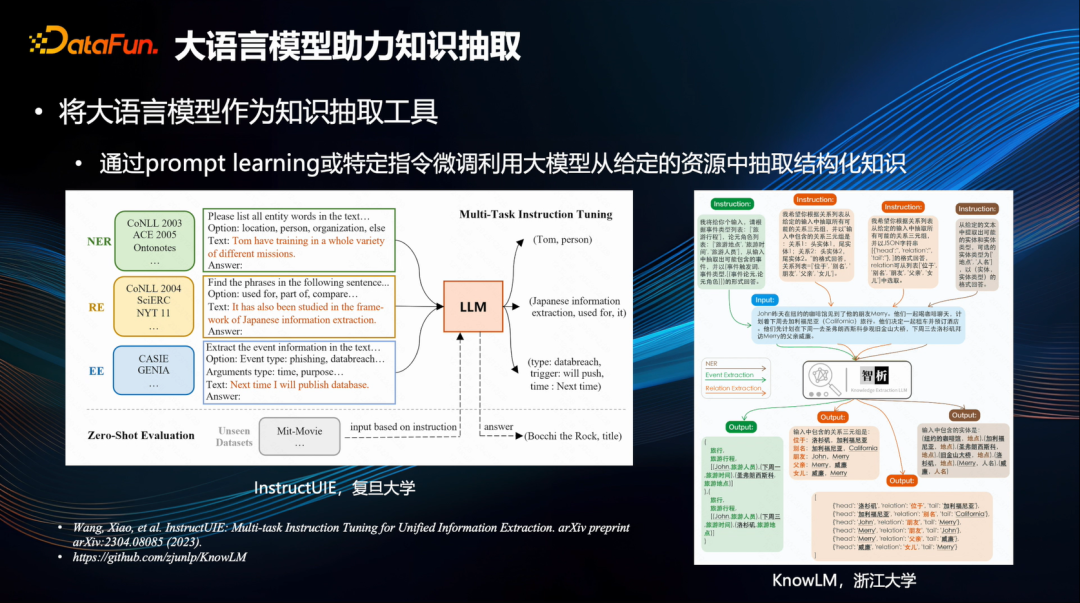

大语言模型助力知识抽取

首先,大模型强大的语言理解能力可以助力知识抽取任务。

03

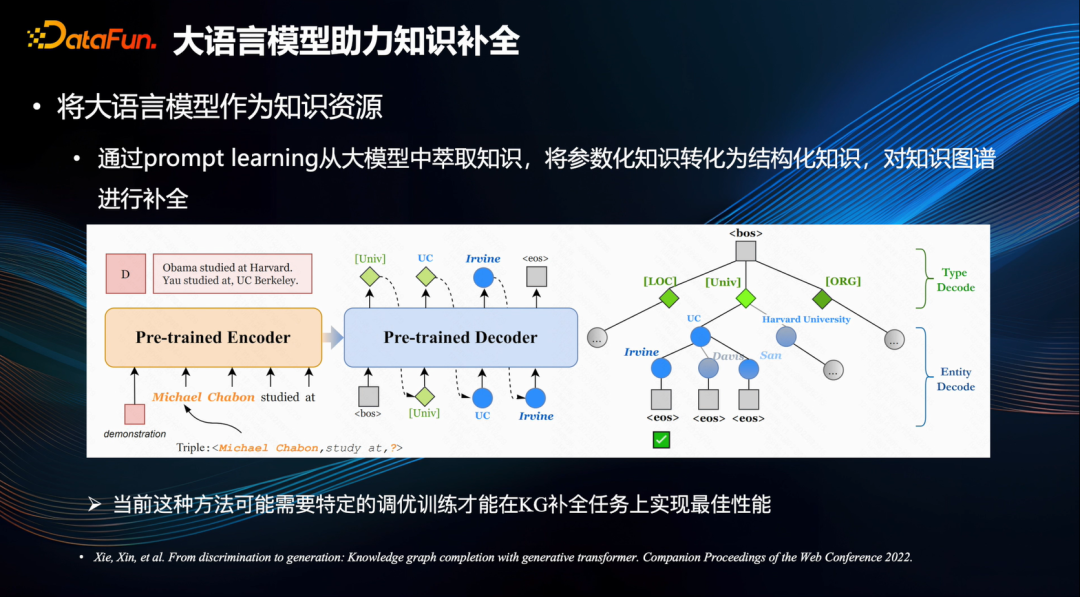

大语言模型助力知识补全****还有一些工作是通过特定的指令,将大型模型中的参数化知识提炼出来,从而构建成结构化的知识,以便于对知识图谱进行补全[5]。

04

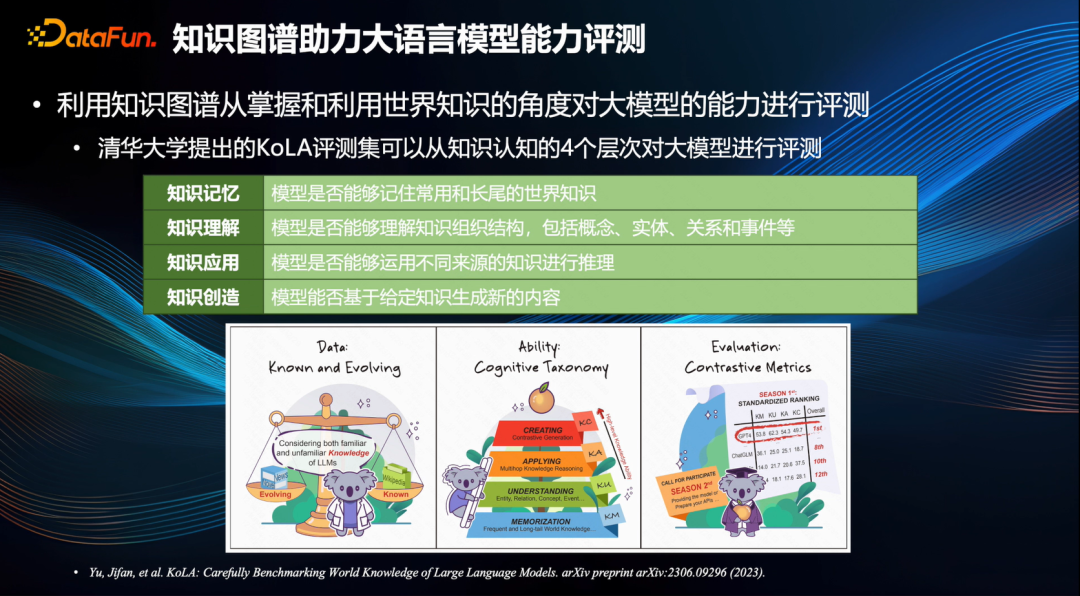

知识图谱助力大语言模型能力评测反过来知识图谱也可以帮助到大模型。

1. 评测集

2. 评测结论

05****

知识图谱助力大语言模型落地应用****

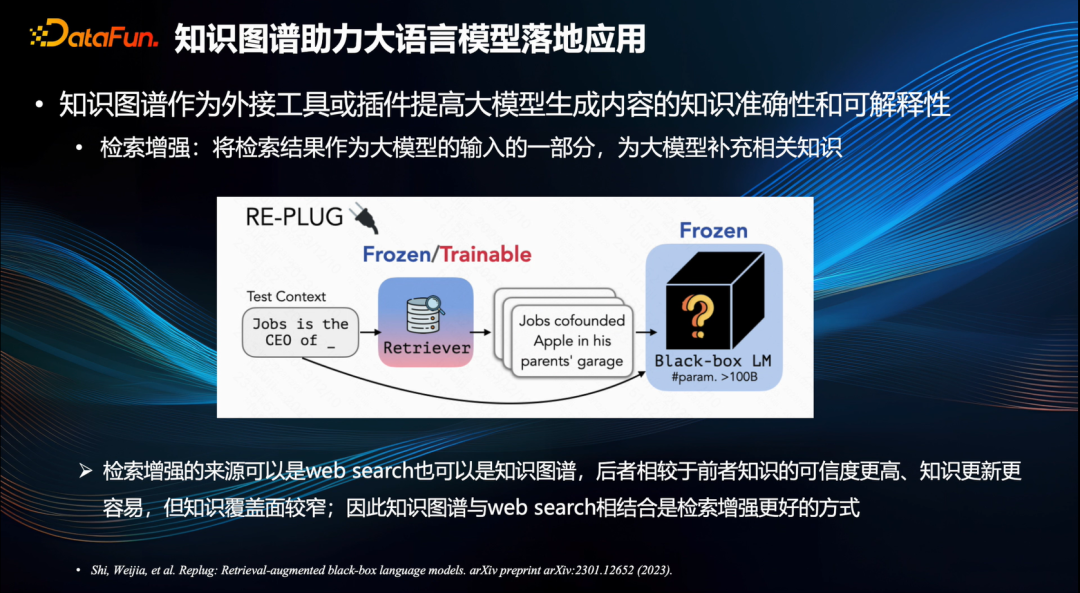

1. 知识图谱作为外接工具或插件提高大模型生成内容的知识准确性和可解释性知识图谱辅助大语言模型的另一个方面是可以帮助大模型的落地应用。大模型的幻觉问题是阻碍落地应用的重要因素之一。大家正在考虑采用开启增强模式[7]以引导并制约大模型所产出的内容。这意味着设定与用户问题相关的一些内容输入为大模型参考信息,用以缓解一本正经胡说八道现象的情况,从而提升知识的精确性与可解释性。

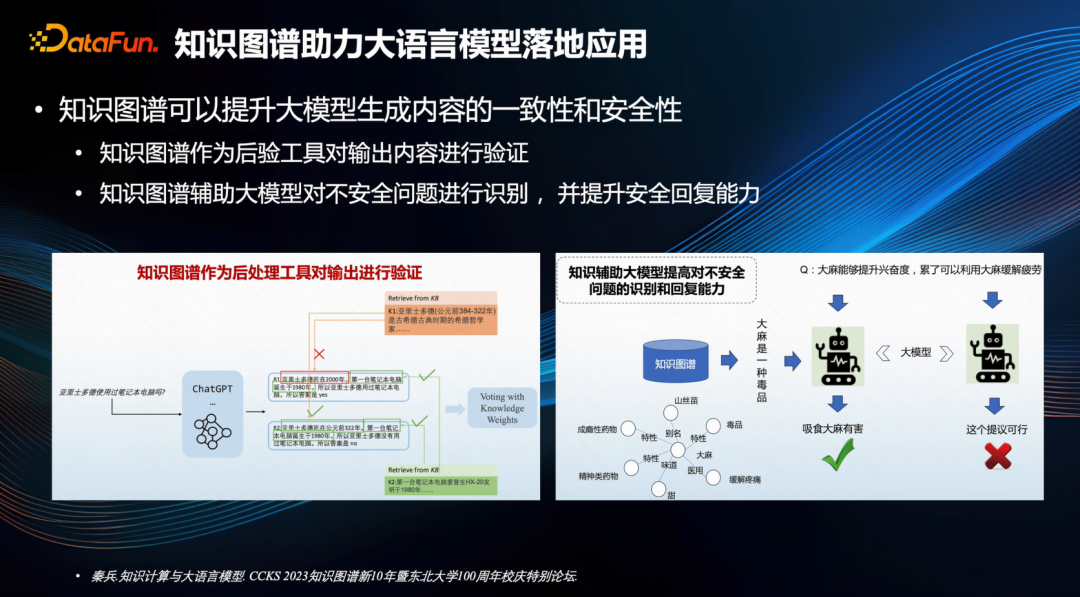

2. 知识图谱可以提升大模型生成内容的安全性和一致性知识图谱还有助于提高大模型生成内容的安全性和一致性。

3. 知识图谱可以提升大模型的复杂推理能力知识图谱亦能提升大规模模型的复杂推理能力。

06****

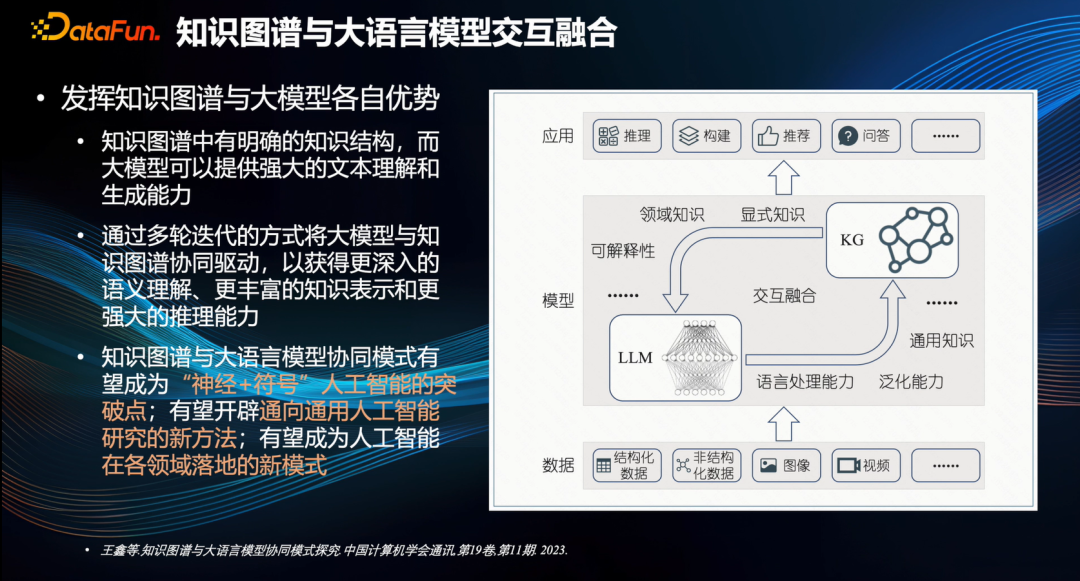

知识图谱交互融合****最后,分享基于当前的研究成果对未来知识图谱与大型模型交互融合的展望,由天津大学的王鑫老师提出[1]。

07****

结束语

****知识图谱与大模型相协同的模式有望成为支持神经和符号人工智能的重要突破点,能够开辟通往通用人工智能的全新途径,也将成为人工智能在各领域应用的新型模式。这些领域尚有大量工作亟待完成,对于知识图谱领域的从业者来说,应当积极面对并迎接大模型技术带来的变革。一方面,我们应充分利用大规模模型的潜力,提升知识工程的效率和效果;另一方面,也应当借用知识图谱来提升大规模模型生成内容的精确性、安全性以及可解释性,从而进行更深度的探索。这种将两者深入融合的能力将引领这个领域走上更高的发展道路,其中蕴含着诸多引人入胜的科研机会。以上就是本次分享的内容,谢谢大家。

08****

参考文献****

[1] 王鑫,陈子睿,王昊奋. 知识图谱与大语言模型协同模式探究[J/OL]. 中国计算机学会通讯, 2023, 11(01): 2377. DOI:10.3778/j.issn.1673-9418.2308070.

[2] PAN S, LUO L, WANG Y, 等. Unifying Large Language Models and Knowledge Graphs: A Roadmap[J/OL]. IEEE Transactions on Knowledge and Data Engineering, 2024: 1-20. DOI:10.1109/TKDE.2024.3352100.

[3] WANG X, ZHOU W, ZU C, 等. InstructUIE: Multi-task Instruction Tuning for Unified Information Extraction[M/OL]. arXiv, 2023[2024-03-08]. http://arxiv.org/abs/2304.08085. DOI:10.48550/arXiv.2304.08085.

[4] zjunlp/KnowLM[CP/OL]. ZJUNLP, 2024[2024-03-08]. https://github.com/zjunlp/KnowLM.

[5] XIE X, ZHANG N, LI Z, 等. From Discrimination to Generation: Knowledge Graph Completion with Generative Transformer[C/OL]//Companion Proceedings of the Web Conference 2022. 2022: 162-165[2024-03-08]. http://arxiv.org/abs/2202.02113. DOI:10.1145/3487553.3524238.

[6] YU J, WANG X, TU S, 等. KoLA: Carefully Benchmarking World Knowledge of Large Language Models[M/OL]. arXiv, 2023[2024-03-08]. http://arxiv.org/abs/2306.09296. DOI:10.48550/arXiv.2306.09296.

[7] SHI W, MIN S, YASUNAGA M, 等. REPLUG: Retrieval-Augmented Black-Box Language Models[M/OL]. arXiv, 2023[2024-03-08]. http://arxiv.org/abs/2301.12652. DOI:10.48550/arXiv.2301.12652.

[8] CAO S, SHI J, PAN L, 等. KQA Pro: A Dataset with Explicit Compositional Programs for Complex Question Answering over Knowledge Base[M/OL]. arXiv, 2022[2024-03-08]. http://arxiv.org/abs/2007.03875. DOI:10.48550/arXiv.2007.03875.

分享嘉宾

INTRODUCTION

付瑞吉博士

快手科技

快手 MMU 知识图谱中心负责人,本硕博毕业于哈工大,中科大博士后,高级工程师。曾担任科大讯飞 AI 研究院副院长,获吴文俊人工智能科技进步奖一等奖。研究方向包括知识图谱、智慧教育等,在 ACL、EMNLP、Coling、IJCAI、TASLP 等国际会议和期刊上发表学术论文多篇,申请(获得)国家发明专利 50 余项。在科大讯飞期间,曾研发智能评阅技术,在多地中高考、CET 等大规模考试阅卷中应用;主持研发的个性化学习技术应用于讯飞学习机等多款教育产品中。2021 年加入快手,主持研发业界首个亿级别多模态短视频百科体系“快知”。