题目: A Geometric Perspective on Optimal Representations for Reinforcement Learning

摘要:

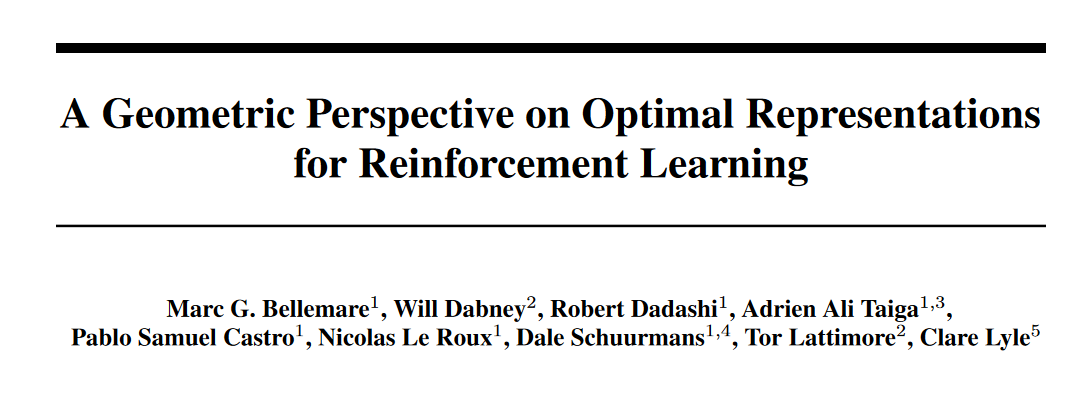

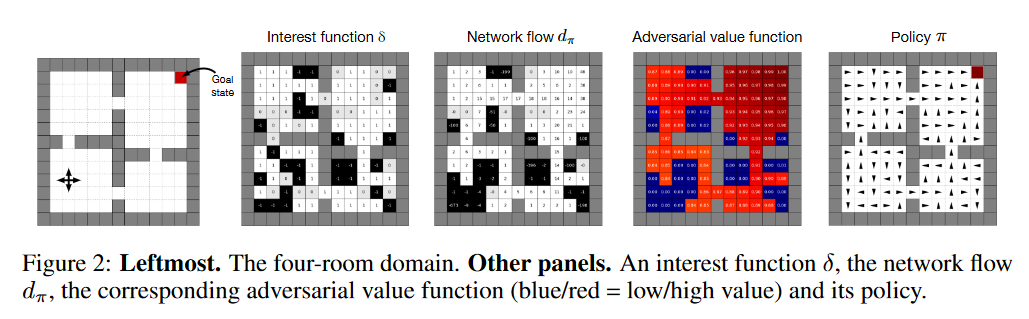

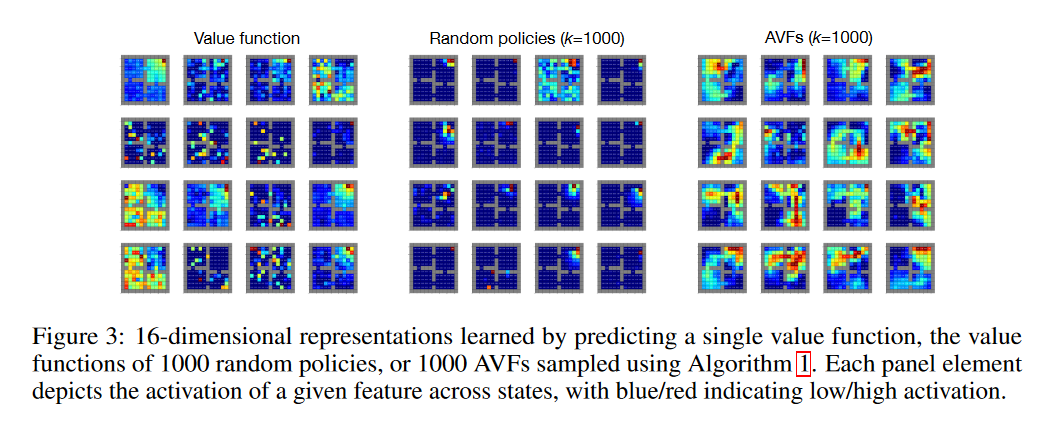

在这篇论文中提出了一种基于值函数空间几何性质的表示学习方法。我们利用这个观点来提供关于价值函数作为辅助任务的有用性的正式证据。我们的公式考虑调整表示法来最小化给定环境中所有平稳策略的值函数的(线性)近似。我们证明了这种优化简化为对一类特殊的值函数(我们称之为对抗性值函数(AVFs))进行准确的预测。我们证明了使用值函数作为辅助任务对应于我们的公式的期望误差松弛,AVFs是一个自然的候选,并确定了与原值函数的密切关系。我们在一系列域实验中强调了AVFs的特点及其作为辅助任务的实用性。

作者:

Marc G. Bellemare是加拿大蒙特利尔谷歌大脑的一名研究科学家,专注于强化学习,之前在阿尔伯塔大学获得了博士学位,研究领域是强化学习和概率预测的交叉领域,还对深度学习、生成模型、在线学习和信息论感兴趣。个人官网:http://www.marcgbellemare.info/

Nicolas Le Roux是现在是蒙特利尔谷歌大脑优化项目的负责人,也是麦吉尔大学的兼职教授。研究领域是机器学习,神经网络,优化,大规模学习和统计建模。个人官网:http://nicolas.le-roux.name/

成为VIP会员查看完整内容

相关内容

表示学习是通过利用训练数据来学习得到向量表示,这可以克服人工方法的局限性。 表示学习通常可分为两大类,无监督和有监督表示学习。大多数无监督表示学习方法利用自动编码器(如去噪自动编码器和稀疏自动编码器等)中的隐变量作为表示。 目前出现的变分自动编码器能够更好的容忍噪声和异常值。 然而,推断给定数据的潜在结构几乎是不可能的。 目前有一些近似推断的策略。 此外,一些无监督表示学习方法旨在近似某种特定的相似性度量。提出了一种无监督的相似性保持表示学习框架,该框架使用矩阵分解来保持成对的DTW相似性。 通过学习保持DTW的shaplets,即在转换后的空间中的欧式距离近似原始数据的真实DTW距离。有监督表示学习方法可以利用数据的标签信息,更好地捕获数据的语义结构。 孪生网络和三元组网络是目前两种比较流行的模型,它们的目标是最大化类别之间的距离并最小化了类别内部的距离。

专知会员服务

41+阅读 · 2020年4月11日

专知会员服务

51+阅读 · 2020年2月22日

专知会员服务

24+阅读 · 2019年11月11日