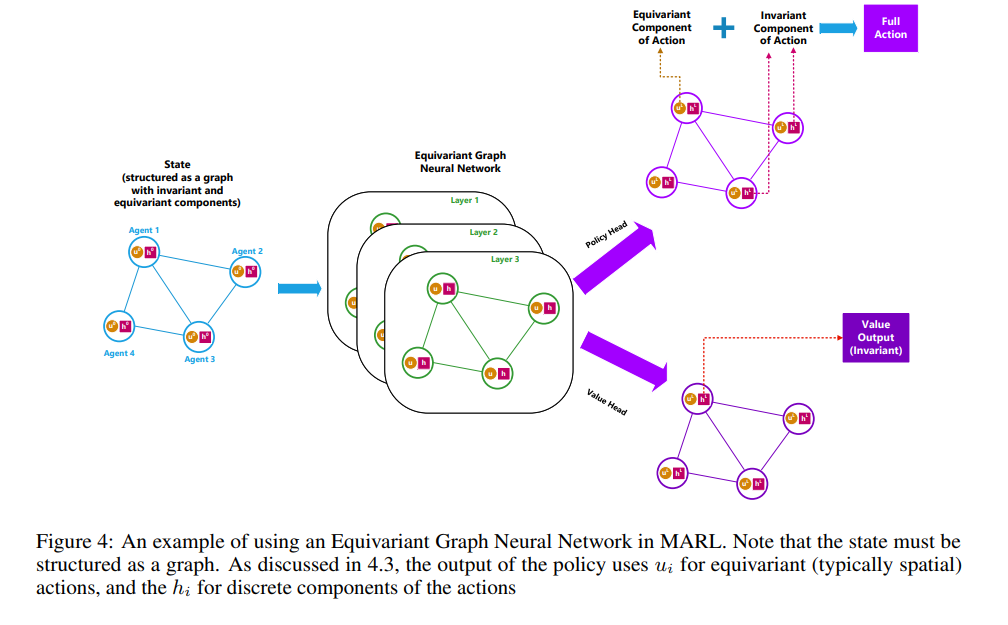

多智能体强化学习(Multi-Agent Reinforcement Learning, MARL)在样本效率和泛化能力方面存在挑战 [1]。这些挑战部分源于通常用于学习策略的神经网络缺乏结构或归纳偏置。在多智能体场景中,常见的一种结构是对称性。几何深度学习(Geometric Deep Learning)领域开发了等变图神经网络(Equivariant Graph Neural Networks, EGNN),它们对节点的旋转、平移和反射具有等变性(或对称性)。引入等变性已被证明可以提高学习效率并减少误差 [2]。本文中,我们展示了 EGNNs 提高了 MARL 的样本效率和泛化能力。然而,我们还发现,将 EGNNs 直接应用于 MARL 会导致早期探索表现不佳,这是由于 EGNN 结构中的偏置。为了解决这一问题,我们提出了探索增强型等变图神经网络(Exploration-enhanced Equivariant Graph Neural Networks, E2GN2)。我们将 E2GN2 与其他常用的函数逼近器进行了比较,使用了常见的 MARL 基准测试 MPE 和 SMACv2。结果表明,E2GN2 显著提高了样本效率,最终奖励收敛更高,并且在泛化测试中相较于标准 GNNs 提升了 2 倍至 5 倍的性能。我们的研究为在复杂多智能体系统中提供更可靠且有效的解决方案铺平了道路。

https://www.zhuanzhi.ai/paper/d4a39764ec4e33851558579e3da4a914

成为VIP会员查看完整内容

相关内容

Arxiv

166+阅读 · 2023年4月7日

Arxiv

20+阅读 · 2023年3月21日