机器人技术和机器学习的进步正在服务业、采矿业、家务劳动和交通运输等多个领域带来前所未有的震撼性变化。随着智能机器人时代的深入发展,它们不再局限于简单受控环境中的操作场景,我们面临的严峻挑战是如何让它们具备感知和理解不断发展的复杂世界的能力。除其他外,这需要让它们能够识别具有多种变化的物体,为高度动态的环境建模,根据不同的模式流进行综合并做出决策,以及适应改变场所视觉外观的环境,如不同的天气条件、一天中的不同时间、光照和结构变化。这些因素使得目前针对特殊情况进行人工调整的方法,在面对复杂而丰富的广阔感知空间时显得力不从心。

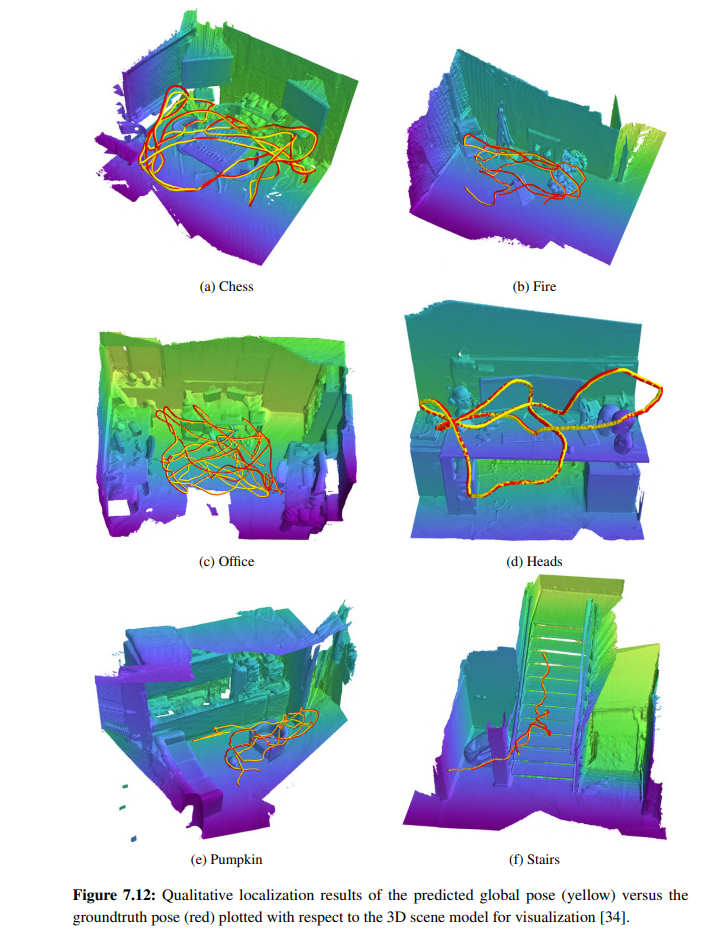

本论文介绍了一些技术,通过利用来自视觉图像以外的模式的强大表征,以及发现多个不同任务之间的共享结构,使机器人能够从先前的经验中学习环境的语义结构。首先,从人类如何在没有视觉感知的情况下感知地形并进行导航中获得灵感,我们提出了新颖的网络架构,利用车辆与地形的交互声音作为本体感知模式,对各种室内和室外地形进行分类。其中包括递归模型,使机器人能够在没有视觉信息的情况下,甚至在不利的真实世界声学条件下,利用廉价的麦克风对地形进行准确分类。其次,我们提出了用于场景理解的紧凑型全卷积架构,该架构汇总了多尺度上下文信息,并结合了用于高分辨率语义分割的新技术。我们的模型可高效地部署在计算资源有限的机器人上,由此产生的像素级语义分类可有效地泛化到不同环境的自然图像中经常出现的多尺度物体,从城市自动驾驶场景到室内场景和非结构化森林环境。第三,作为向根据所遇到的情况重新配置自己的神经模型迈出的一步,我们提出了自监督多模态架构,动态融合来自视觉图像、深度和红外等互补模态的信息,以相应地利用物体属性(如外观、几何形状和反射率)实现更全面的场景语义理解。这些技术使配备了我们的模型的机器人能够解决分类中的局部模糊问题,并在天气和季节变化所带来的极具挑战性的感知条件下稳健地识别场景中的各种元素。第四,我们提出了首个用于联合语义运动分割的端到端学习网络,该网络可同时利用运动线索改进语义学习,并相应地利用语义线索改进运动估计。我们提出的模型能让机器人在了解环境动态的同时,以时间连贯的方式辨别场景语义。最后,我们提出了一种多任务学习策略,在学习视觉定位、预测场景语义和估计机器人自我运动的同时,自动利用协同效应。我们的贡献超越了现有的范例,促进了这些关键机器人自主能力的合作学习,并有效地编码了来自环境的几何和结构限制。

在标准基准上对本论文介绍的方法进行了全面评估,并提供了大量经验证据,证明模型达到了最先进的性能。此外,还利用一些不同的机器人对提出的每种方法进行了实际评估,证明了这些方法在各种环境和感知条件下的通用性。我们相信,这些技术已经使机器人向可靠地部署在复杂的真实世界环境中迈进了一步,它们将永远从根本上改变我们的社会。