图表示学习方法通过捕获图结构中的复杂关系和特征,在处理复杂的非欧几里得数据方面表现出高度的有效性。然而,传统方法在处理包含多种类型节点和边的异构图时面临挑战,这主要源于数据的多样性和复杂性。现有的异构图神经网络(Heterogeneous Graph Neural Networks, HGNNs)已展示出良好的效果,但它们需要预先了解节点和边的类型以及统一的节点特征格式,从而限制了其适用性。 近期,利用大型语言模型(Large Language Models, LLMs)进行图表示学习的研究取得了新的进展。通过结合LLM的数据处理能力,这些方法能够对多种图表示进行对齐。然而,这些方法通常忽略了异构图数据,并且需要大量的预处理。

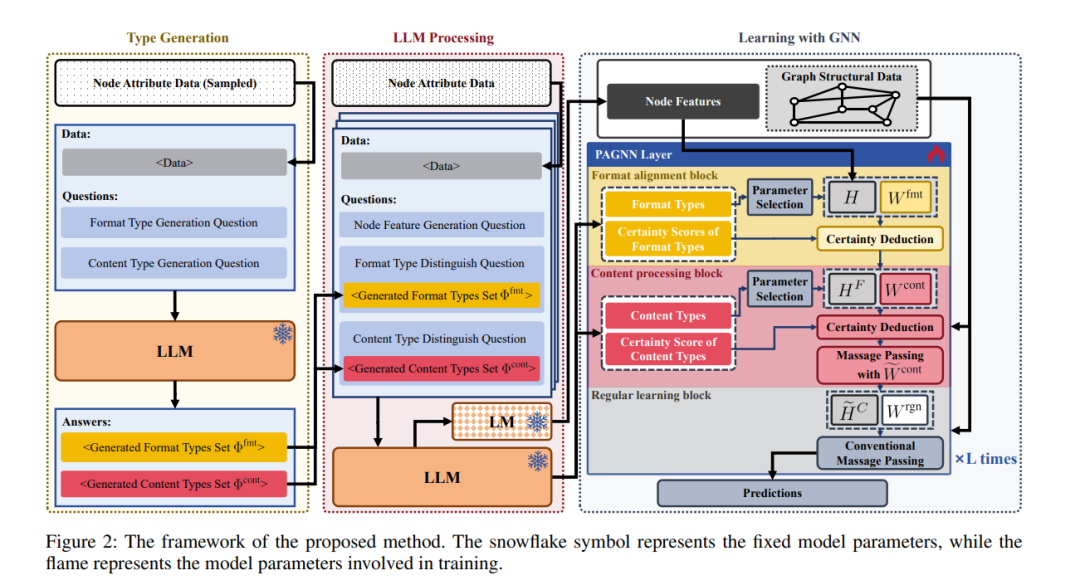

为了解决这些局限性,我们提出了一种新颖的方法,将LLM和GNN的优势相结合,能够处理具有任意格式和类型的节点和边的图数据,而无需了解类型信息或进行特殊的预处理。我们的方法利用LLM自动总结和分类不同的数据格式和类型,对齐节点特征,并结合一种专门设计的GNN进行目标学习,从而获得适用于下游任务的有效图表示。理论分析和实验验证表明了我们方法的有效性。代码和附录可以在补充材料中找到。

成为VIP会员查看完整内容

相关内容

Arxiv

213+阅读 · 2023年4月7日

Arxiv

20+阅读 · 2023年3月21日