大型语言模型(LLMs)中的情感认知对于提升各类应用的性能至关重要,如社交媒体、人机交互以及心理健康评估。我们探讨了当前的研究现状,主要围绕情感分类、情感丰富的响应生成和心理理论评估,同时也承认了依赖标注数据和情感处理复杂性等挑战。在本文中,我们详细综述了LLMs在情感认知领域的最新进展,探讨了关键研究、方法、成果和资源,并将其与乌尔里克·奈瑟(Ulric Neisser)的认知阶段进行了对齐。此外,我们还概述了这一不断发展的领域中未来研究的潜在方向,包括无监督学习方法的发展以及更复杂且可解释的情感认知LLMs的构建。我们还讨论了对比学习等高级方法,这些方法用于提升LLMs的情感认知能力。

在当今的情感计算领域,越来越多地认识到大型语言模型(LLMs)中的情感认知的重要性(Ren等人, 2024)。它为人类情感和认知的复杂过程提供了深刻的见解。这一领域不仅涉及对个体或群体的情感状态进行分析,还有效地将这些情感应用于各种领域,如社交媒体分析(Chen等人, 2024b;Yang等人, 2024;Chen等人, 2024e;Jin等人, 2023, 2024b)、人机交互(Chen等人, 2023e,c)和心理健康评估(Chen等人, 2024d)。具备情感认知能力使LLMs能够更紧密地与人类价值观保持一致,从而提升其在情感相关下游任务中的表现。

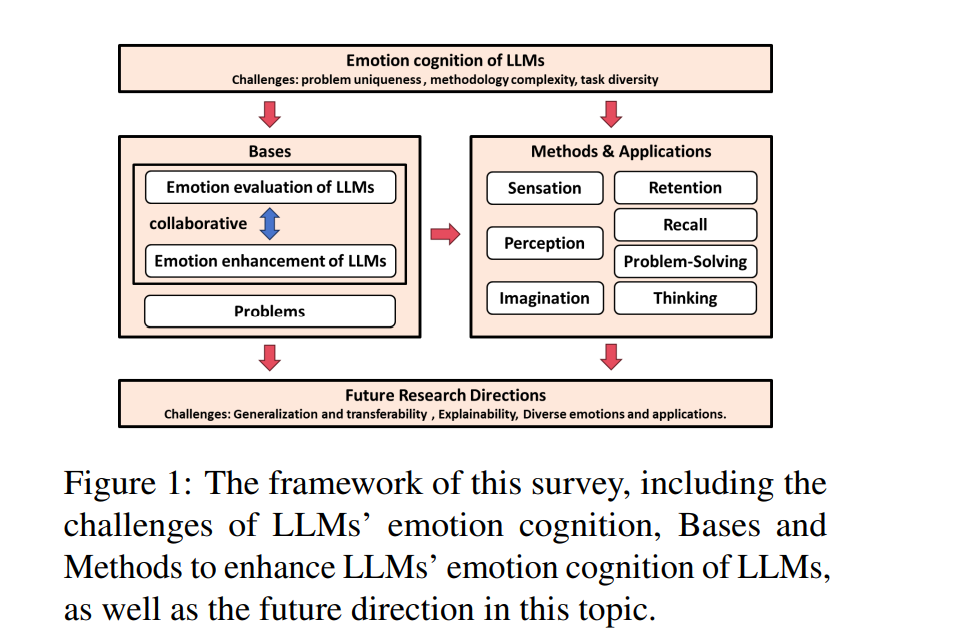

当前,关于LLMs情感认知的研究主要集中在处理和分析情感数据的各种方法上。这包括情感分类(Zhang等人, 2023)、生成情感丰富的响应(Xie等人, 2023;Chen等人, 2024g),以及“心理理论”评估(Sap等人, 2022)。研究人员还通过上下文学习(Sun等人, 2023;Chen等人, 2024c)和微调方法(Peng等人, 2023;Chen等人, 2023d)等技术,进一步增强LLMs的情感能力。然而,挑战仍然存在,包括对标注数据的过度依赖、处理复杂情感的困难,以及解释LLMs在情感认知中的决策过程的难度。此外,情感认知与人类的情感心理学密切相关,不仅需要计算方法和技术,还需要对心理学理论有深刻的理解和应用。 在我们的综述中,我们强调结合心理学的视角,特别是基于乌尔里克·奈瑟(Ulric Neisser)的认知心理学理论(Neisser, 2014),来探讨LLMs在情感认知中的应用与研究。奈瑟被誉为认知心理学之父,他在《认知心理学》一书中将认知描述为一个包含感觉、知觉、想象、记忆、回忆、问题解决和思维的综合过程。图1展示了本次综述的框架。具体而言,我们首先深入探讨了LLMs在情感认知中面临的三个关键挑战:情感问题的独特性、情感方法的复杂性和情感任务的多样性。接着,我们介绍了LLMs在情感认知中的两个典型方向:情感评估和情感增强。基于Ulric Neisser的认知定义,我们将LLMs情感领域的工作划分为七个阶段。在每个阶段中,我们探讨了更详细的研究方向和应用场景。此外,我们总结了情感认知领域的重要工作,并根据这七个阶段对其进行分类,包括这些工作的动机、关键方法、性能表现以及可用的开源代码和数据集。最后,我们识别并讨论了该领域中仍未解决的问题和未来的研究方向。我们的工作主要贡献包括:

-

我们从问题定义、方法论和应用领域的角度对情感认知中的主要挑战进行了深入分析。

-

我们根据认知心理学理论的七个阶段对情感领域的工作进行了分类,从而更好地将具体任务与人类认知过程对齐。

-

我们对情感认知领域的未来研究方向进行了深入的讨论,旨在激发LLMs情感计算领域的进一步发展。

方法与应用

在本节中,我们通过将奈瑟的认知过程与LLMs的能力进行类比,详细说明LLMs在情感认知中的七个阶段。我们列出了具有代表性的研究,包括其动机、关键技术、结果以及开源代码/数据集,见表1。扩展版本见表2和表3。

**1 感觉

感觉是指LLMs展现出类似于人类在处理输入文本数据时的能力。这方面的工作主要集中在输入形式上。常见的输入形式包括三类:提示工程、嵌入表示和知识增强。

提示工程是指通过添加一些指令来引导LLMs在下游任务中的表现。例如,Lynch等人(2023)提出了一种用于查询LLMs的结构化叙事提示。该研究使用OpenAI的ChatGPT生成叙事,并通过卡方检验和Fisher精确检验等统计方法将这些叙事中的情感水平与真实推文进行比较;Ratican和Hutson(2023)提出了6DE模型,用于分析LLMs上下文中的人类情感。该模型考虑了情感的多个维度,如唤醒度、情绪、主导性、代理性、忠实度和新颖性;Zhang等人(2023)探索了四种提示策略,包括有上下文和无上下文的零样本和少样本提示,展示了这些提示在情感分析和识别任务中的优异表现。该研究强调了上下文信息在增强LLMs情感估计中的重要性。

不同于使用提示作为输入,嵌入表示将输入文本转换为高维空间中的向量表示,捕捉词汇的语义信息,用于优化LLMs的内部处理过程。例如,Xu等人(2023)探索了指令微调以增强LLMs在心理健康预测中的表现。微调后的模型Mental-Alpaca和Mental-FLAN-T5在性能上显著超越了GPT-3.5和GPT-4,尽管模型体积明显较小;Binz和Schulz(2023)研究了心理实验数据用于微调LLMs。该研究表明,LLMs在准确模拟人类行为方面具有能力,并且在微调过程中使用嵌入表示时展示了其在情感认知中的潜力。

此外,知识增强是指将上下文或知识加入输入中,以增强LLMs在处理下游任务中的表现。例如,Sun等人(2023)通过引入外部知识增强共情响应生成。该研究提出了一种名为CoNECT的新方法,利用情感指标来评估上下文相关性并促进共情推理;Gagne和Dayan(2023)探讨了LLMs生成文本的情感分布。该方法通过利用特定分位数生成情感丰富的句子,展示了LLMs在情感生成方面的有效性,并提供了对LLMs内部机制的见解。 总之,当前在LLMs情感文本输入处理方面的研究主要通过提示工程、嵌入表示和知识增强取得了显著进展。这些方法增强了LLMs理解和生成情感丰富内容的能力。然而,在多样化接收和处理文本输入的模式方面仍有改进空间,包括整合更细致的内部情感认知,以更好地解释和响应输入。

**2 知觉

知觉涉及解释和理解感官信息,处理从感官收集的原始数据,以形成对外部世界的有意义理解。LLMs在情感认知中的知觉主要包含情感识别及其可解释性。

情感识别是指识别上下文或对话中的情感。例如,Rathje等人(2023)探讨了GPT-3.5和GPT-4在检测各种语言心理构建(情感、离散情感和攻击性)方面的表现,表明LLMs在准确性方面优于基于词典的方法和微调的机器学习模型;Zhang等人(2023)展示了LLMs在情感识别任务中能够实现可比甚至优于其他模型的表现,尤其是在识别少数情感类别方面;Lei等人(2023)提出了InstructERC框架,这是一个有效的生成框架,结合了检索模块和情感对齐任务用于情感识别;Venkatakrishnan等人(2023)强调了跨文化背景中情感检测的重要性,研究了LLMs对重大事件(如伊朗Zhina(Mahsa)Amini的谋杀案和土耳其和叙利亚的地震)的反应;Rodríguez-Ibánez等人(2023)评估了社交网络中的情感分析方法及其在股票市场估值、政治和网络欺凌教育等领域的应用。研究发现使用LLMs(如GPT-3和GPT-J)的表现不佳,要求进行领域特定的调整;Peng等人(2023)采用了深度提示微调和低秩适应来研究LLMs在语言情感识别中的表现。研究表明,经过调整的LLMs在六个广泛使用的数据集上表现出强大的可迁移性和可行性,超越了其他专用的深度模型;Kheiri和Karimi(2023)讨论了使用LLMs进行情感分析的潜力,表明LLMs在处理语言中情感分析的细微差别方面表现优异;Ullman(2023)强调了GPT-3.5在预测人类情感方面的技能,突出了其理解和解释文本中情感内容的能力。Carneros-Prado等人(2023)对GPT-3.5和IBM Watson进行了比较分析,使用了一个包含30,000条与新冠疫情相关推文的数据集。研究揭示了LLMs在情感分析和分类中的多方面能力,但它们在将文本表达与定义的情感类别相匹配方面仍存在困难。此外,幽默是情感认知中的一个更具挑战性的研究领域。Trott等人(2023b)研究了GPT-3理解语言幽默的能力。实验表明,GPT-3在检测、欣赏和理解笑话方面表现出色,尽管未达到人类表现。研究表明,尽管LLMs擅长捕捉幽默,但仅凭语言并不足以完全理解笑话,图像也很有用。

情感识别的可解释性是通过词权重分布、梯度、干扰等分析LLMs的内部状态。Kwon等人(2022)通过比较基于评价特征的相似性计算方法和基于词嵌入的相似性计算方法的性能,研究了表示情感概念的方法。研究发现,GPT-3在词嵌入相似性计算中表现优越,但也过度依赖于情感概念的估值。

总体而言,LLMs在情感知觉方面取得了显著进展,模仿了人类对情感细微差别的理解。尽管像GPT-3.5和GPT-4这样的模型在检测和解释多种情感上下文方面表现出色,但它们在完全理解情感背景和细微差别方面仍面临挑战,强调了进一步提高其感知能力的必要性,以实现更准确的情感分类、理解深度、领域适应性和价值对齐。

**3 想象

想象是指生成与情感相关的内容,例如情感故事、诗歌和情感对话,目的是创造符合人类价值观的内容。 在生成情感叙事方面,Xie等人(2023)专注于风格、语域和故事长度的变化,展示了LLMs在生成故事内容方面的显著优势。然而,一个关键观察是LLMs在处理世界知识时倾向于复制现实世界中的故事。Yongsatianchot等人(2023a)研究了GPT-4在情感预测任务中的熟练程度,展示了其不仅能够辨别和概念化情感理论,还能够创作与情感相关的故事。通过提示GPT-4识别和操作情感体验的关键元素,它展示了在其叙事中对情感强度的细致控制。

在生成情感对话方面,Zheng等人(2023)采用LLMs来增强情感支持对话。这种方法将对话增强视为对话补全任务,微调后的语言模型从不同话题中补全对话,随后进行基于启发式的后处理。Lee等人(2022)深入研究了GPT-3通过基于提示的上下文学习生成共情对话的能力。该研究引入了创新的上下文示例选择方法,SITSM和EMOSITSM,利用情感和情境信息,揭示了GPT-3在共情方面的竞争表现,甚至超越了Blender 90M。Zhao等人(2023)评估了ChatGPT的情感对话能力,通过一系列下游任务评估ChatGPT在理解和生成情感对话方面的表现。Guo等人(2023)指出,ChatGPT在垂直领域(如绘画创作)中的情感效果显著。它可以提供更清晰、更详细的绘画指令,并理解绘画中的抽象艺术表现和情感。

我们还关注一个更具体的方面:幽默生成,这是一种复杂且本质上具有人类特征的任务。例如,Jentzsch和Kersting(2023)深入探讨了OpenAI的ChatGPT在幽默生成能力方面的表现,评估了ChatGPT在生成、解释和检测笑话方面的能力。ChatGPT倾向于重复相同的笑话处理过程,而不是创造新的笑话,尽管它可以准确解释有效的笑话。Toplyn(2023)提出了一种创新的方法,用于LLMs的幽默生成。Witscript 3使用三种笑话生成机制来生成和选择最佳的喜剧响应。这代表了LLMs与人类专业知识之间的合作,结合了由专业喜剧作家编写的幽默算法。值得注意的是,Witscript 3的响应被人类评估者认为是笑话的概率为44%。Chen等人(2024f)构建了一个包含连锁幽默和幽默思维导图注释的中文可解释幽默响应数据集,以及与幽默相关的辅助任务,用于评估和改进PLM和LLMs的幽默响应能力。

总的来说,LLMs在情感相关内容的想象方面取得了重大成就,如故事、对话和幽默。它们在对话中的情感强度和共情方面表现出了细致的控制能力。然而,内容的原创性方面仍存在限制,特别是在幽默生成中,LLMs倾向于复制现有的笑话,而不是创造新的笑话。

**4 记忆

记忆是指编码和存储知识,创建“记忆”的过程。LLMs中的记忆与它们通过训练过程如何“记住”情感信息和知识有关,这对后续情感数据的处理和生成至关重要,例如角色扮演和角色模拟。

例如,Tao等人(2023)提出了一个创新框架,旨在改善LLMs的个性化角色扮演。他们采用了一种详细的情感分类策略,并在对话数据集中对情感进行了注解,使GPT-4能够根据其“记忆”中的情感创建角色档案。 Shao等人(2023)将重点转向基于个人档案、经历和情感状态训练智能体,而不是使用有限的提示来引导ChatGPT的API。实验结果表明,编辑和恢复个人档案有助于构建更准确和情感感知更强的LLMs模拟,模拟的人物更加人性化。Jiang等人(2023)探讨了个性化LLMs的行为在多大程度上反映了特定的性格特质。该研究使用大五人格模型创建了不同的LLMs角色,并通过各种任务(包括性格测试和故事写作)评估了它们的行为。结果表明,LLMs角色可以持续展现与其指定的人格特质一致的行为。Wang等人(2023)提出了RoleLLM框架,用于增强LLMs的角色扮演能力。该框架包括角色轮廓构建、基于上下文的指令生成以及角色特定知识的捕捉和记忆,展示了LLMs通过模拟语言风格和利用其记忆中的角色特定知识获得的竞争性成果。

我们还研究了LLMs在构建情感记忆模式和恢复这些记忆方面的能力。例如,NathanKlapach(2023)深入分析了五种广为人知的LLMs,包括BingAI、ChatGPT、GoogleBard和HuggingChat,重点分析了它们处理、模仿和表达情感的能力。这些LLMs被要求创建新故事,这些故事在语调、风格和情感影响方面反映了原始叙述的特征,以评估它们在存储情感方面的能力并有效地复制这些特征。Russo等人(2023)介绍了一种新方法,LLMs能够通过作者-审稿人流程管理社交媒体平台上的错误信息,并生成情感响应。

总的来说,LLMs的最新研究重点是增强它们对情感信息的记忆,这对于角色扮演和角色模拟等任务至关重要。然而,在有效编码和存储复杂的情感知识方面仍然存在挑战,特别是在由于上下文大小限制无法“记住”记忆的情况下。该领域正在探索如何改进LLMs的记忆模式及其准确和系统地保留情感信息的能力。

**5 回忆

回忆是指提取情感记忆,从“记忆”中提取信息。在LLMs的情感认知中,回忆与它们从内部或外部知识中检索与情感相关的信息能力有关,用于响应与情感相关的陈述、保持情感对话的一致性等。以下研究展示了LLMs如何有效利用情感记忆和历史以增强决策过程。

例如,Jia等人(2023)提出了一个知识增强的记忆模型,用于情感支持对话。该模型能够感知并适应对话中不同时期的情感变化,通过从对话中提取丰富的知识和常识(如ConceptNet)。Jeong和Makhmud(2023)提出了一种新方法,通过引入多样化的参数集(如五种感官、属性、情感状态、与对话者的关系和记忆)丰富LLMs的响应。他们强调了记忆在保持对话连贯性和情感真实性中的重要性。Zhong等人(2023)引入了一种动态记忆机制,使LLMs能够在当前决策过程中利用过去的情感互动。该机制受艾宾浩斯遗忘曲线(Ebbinghaus, 1885)的启发,使LLMs能够有选择地回忆情感互动,从而更像一个真正的人类朋友。Qian等人(2023)强调了LLMs根据历史情感背景生成共情响应的能力。他们引入了上下文学习和两阶段交互生成方法,使LLMs能够处理和反思过去的情感互动,从而做出更具共情的决策。此外,Wake等人(2023)研究了情感历史在决策中的应用。作者估计了当前语句的情感标签,仅基于过去对话的历史,展示了数据集和情感标签选择对ChatGPT情感识别表现的重大影响。

总之,最近对LLMs回忆能力的研究重点是检索和利用情感记忆,以在情感相关互动中做出决策。这些研究表明,LLMs能够适应动态情感变化,结合多样化的参数,并利用历史情感背景做出共情决策。然而,在完善复杂情感历史的回忆、有效检索最相关的知识并持续更新方面仍然存在挑战。

**6 问题解决

情感认知中的问题解决是指在各种场景中解决与情感相关的下游任务(Li等人,2023a;Chen等人,2024a;Li等人,2022,2024b,2023c;Ni等人,2024a;Li等人,2023b,2024e)。 例如,在心理健康领域,Tu等人(2023)提出了S2Conv框架,专门用于为心理健康问题提供个性化支持。该框架集成了基于个性和记忆的对话模型与人际匹配插件,强调了LLMs在提供社交支持方面的潜力(Ni等人,2024b;Li等人,2024d;Jin等人,2024a;Li等人,2024a)。Qi等人(2023)评估了LLMs在心理健康领域的表现。Zhu等人(2024)研究了LLMs在进行心理推理任务中的使用,特别是推断用户的潜在目标和基本心理需求。Lai等人(2023)在心理咨询场景中使用LLMs,提供即时响应和正念活动。Xu等人(2023)评估了LLMs在心理健康预测任务中的表现,强调了减轻偏见的必要性。在教育领域,Sajja等人(2023)提出了一个创新框架,用于个性化和自适应学习。 这些LLMs在情感相关问题解决中的多样化应用展示了它们的广泛潜力。然而,它们也揭示了诸如性别偏见和增强可解释性等限制。未来的研究方向可能包括微调LLMs,以更好地满足教育和心理健康领域的需求。

**7. 思考

思考是指问题解决后的反思和回顾。在LLMs的情感认知中,它涉及如何利用“心理理论”解决下游任务(Zhou等人,2024;Li等人,2024c)。心理理论(Theory of Mind, ToM)(Carlson等人,2013)是理解自身和他人心理状态(包括情感、意图、期望、思想、信念)的认知能力。可以使用这一理论来预测和解释各种行为。

LLMs在情感驱动的任务中展现了强大的思考能力。例如,Trott等人(2023a)展示了LLMs在推断他人信念方面的优异表现。Gandhi等人(2023)引入了一种基于因果关系的模板方法,用于评估LLMs的ToM。他们发现GPT-4具有人类般的推理模式,并拥有强大的ToM。Sap等人(2022)评估了GPT-3在社会推理和心理状态理解方面的表现,识别了LLMs的ToM能力的界限。Shapira等人(2023)通过多种检测方法在六个任务中进行了广泛实验,评估LLMs的ToM能力,发现这些能力不够稳健,更多依赖于表面的启发式方法而不是坚实的推理。Holterman和van Deemter(2023)通过给ChatGPT-3和ChatGPT-4提供六个涉及人类推理偏差的问题,检查了它们展示ToM的能力,发现ChatGPT-4在提供正确答案方面表现优于随机结果,尽管有时基于错误的假设或推理。

在思考领域,焦点扩展到了行为。例如,Zhou等人(2023)提出了一种新的“为行动而思考”评估范式,评估LLMs是否能够基于他人的心理状态识别适当的行为,而不仅仅是对这些状态的问题作出回应。该研究提出了一种名为“预见和反思”的零样本提示框架,以增强LLMs在预测未来事件和通过行动选择进行推理方面的能力。Jin等人(2022)旨在评估LLMs在理解和预测人类道德判断和决策行为方面的表现。他们提出了一种基于法律专业知识和道德推理理论的创新道德推理链提示策略(MoralCoT),表明MoralCoT在道德推理、复杂的道德判断和决策方面超越了现有的法律模型。Sorin等人(2023)回顾了LLMs展示共情的能力,探讨了LLMs如何处理和表达复杂的情感观点和推理。Del Arco等人(2022)强调了GPT-3在共情和痛苦预测中的作用,展示了其在复杂情感预测中的推理过程。Schaaff等人(2023)评估了ChatGPT的共情水平,并将其与人类标准进行了比较,比较了LLMs在理解和表达共情方面的能力。Saito等人(2023)展示了提出的ChatGPT-EDSS在捕捉对话中的共情方面的相似表现,评估了LLMs的情感理解和表达能力。Lee等人(2024)发现LLMs的响应比人类更具共情性,比较了模型和人类在情感推理和表达方面的差异。

总的来说,这些研究集中在LLMs的思考能力上。尽管像GPT-4这样的LLMs在理解和推断心理状态方面表现出色,但在推理和反思的深度、心理理论的更好利用以及情感驱动行为预测方面仍然存在挑战。该领域的目标是提高LLMs在回顾分析情感任务方面的能力,从而实现更细致和准确的问题解决。