强化学习是解决不确定序贯决策问题的一种重要方法。尽管近几十年来取得了许多显著的成就,但在现实世界中应用强化学习方法仍然具有挑战性。其中一个主要障碍是强化学习智能体缺乏对世界的共同知识,因此必须通过大量的交互从头开始学习。他们也可能很难解释他们的决策和泛化学到的知识。另一方面,因果关系在形式化知识和利用结构不变性进行有效的知识转移方面具有明显的优势。这导致了因果强化学习的出现,这是强化学习的一个子领域,旨在使用数据生成过程的结构化和可解释表示来改进现有算法**。本文全面回顾了因果强化学习的文献。首先介绍因果关系和强化学习的基本概念,然后解释因果建模如何解决非因果强化学习中的核心挑战。本文根据现有因果强化学习方法的目标问题和方法,对其进行了分类和系统回顾。**最后,对该新兴领域存在的问题和未来发展方向进行了展望。

https://openreview.net/forum?id=iATMbh8mhD&referrer=%5BTMLR%5D(%2Fgroup%3Fid%3DTMLR)

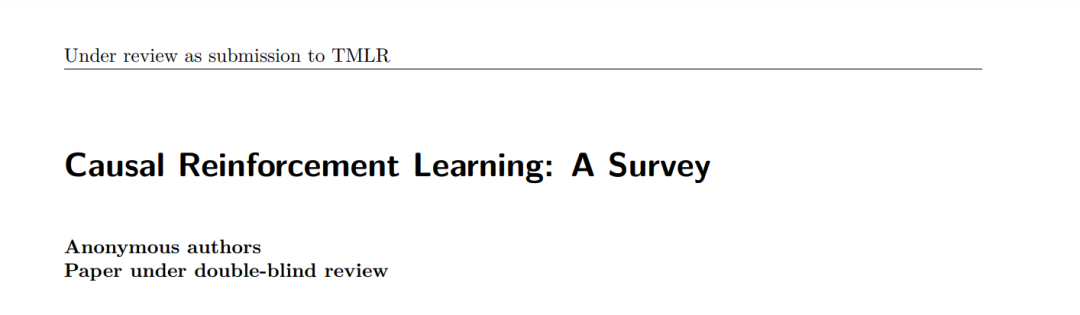

**1. 引言****人类从小就有一种与生俱来的能力来理解因果关系(Wellman, 1992;Inagaki & Hatano, 1993;Koslowski & Masnick, 2002;Sobel & Sommerville, 2010)。**这种程度的理解让我们意识到改变某些事情可以导致其他事情的发生;因此,我们可以积极地干预我们的环境,以实现预期的目标或获取新知识。理解因果关系使我们能够解释行为(Schult & Wellman, 1997),预测未来(Shultz, 1982),甚至可以进行反事实推理来反思过去的事件(Harris et al., 1996)。这些能力是人类智力发展所必需的,是现代社会和文明的基础,也是推动科学技术进步的基础。例如,考虑人类与坏血病斗争的故事,如图1所示(Pearl & Mackenzie, 2018年)。坏血病曾经阻碍了人类对世界的探索,夺走了大约200万水手的生命。经过长期的探索,人类发现食用柑橘类水果可以预防这种可怕的疾病。今天,我们知道坏血病的真正原因是缺乏维生素C,但在当时,这种因果机制尚不清楚。人们最初认为酸性可以治愈这种疾病。然而,加热果汁净化破坏了维生素C的含量,使它对坏血病无效。当时人们认为酸性只是一种安慰剂,而腐烂的肉才是致病的原因。这个错误的判断给斯科特的南极探险造成了重大损失。只有当人们完全了解了坏血病的因果关系后,才发现了对抗这种疾病的有效方法。这个例子展示了在决策中理解因果关系的重要性以及忽略它的潜在灾难性后果。

**数据本身不能回答因果问题。理解因果关系涉及对数据生成过程进行假设和测试。**数据驱动的机器学习可以有效地捕捉柑橘类水果和坏血病之间的相关性,但无法处理因果关系。例如,如果在坏血病预测问题中,我们将柑橘类水果替换为动物肝脏(也富含维生素C),由于外观和味道的显著差异,算法可能会给出错误的预测。因果机器学习(Schölkopf et al., 2021;Kaddour et al., 2022)是为了解决这一缺陷而开发的。近年来,因果关系与机器学习的结合受到了广泛关注,并被应用于各个领域,包括计算机视觉(Lopez-Paz et al., 2017;沈等,2018;Tang等人,2020;Wang et al., 2020b),自然语言处理(Wu et al., 2021;Jin等人,2021;Feder等人,2022)和推荐系统(Zheng等人,2021;Zhang et al., 2021b;Gao等人,2022年)。这些结果表明,因果建模显著提高了学习系统的分布鲁棒性和知识迁移能力。

**与其他机器学习范式不同,强化学习(RL) (Sutton & Barto, 2018)涉及对环境进行干预,以主动收集训练数据;从这个意义上说,RL与因果关系自然相关。**然而,在大多数研究中,智能体只允许干预行动变量,很难完全理解因果关系。这种困难在离线和离线设置中进一步加剧。在强化学习中,智能体旨在获得高回报的数据;因此,他们通过试错不断改进他们的策略。在这个动态过程中,环境通过从当前状态转移到新状态并返回标量奖励(或惩罚)来响应智能体的行动。状态转移和奖励分配都是因果关系;例如,维生素C缺乏(当前状态)会导致坏血病(下一状态),反之则不会。其他环境因素,如食物的味道和外观,不影响这种转变。为了避免受到非因果相关性的困扰,智能体必须捕获驱动底层数据生成过程的因果关系;否则,它将学习效率低下,甚至陷入次优策略。

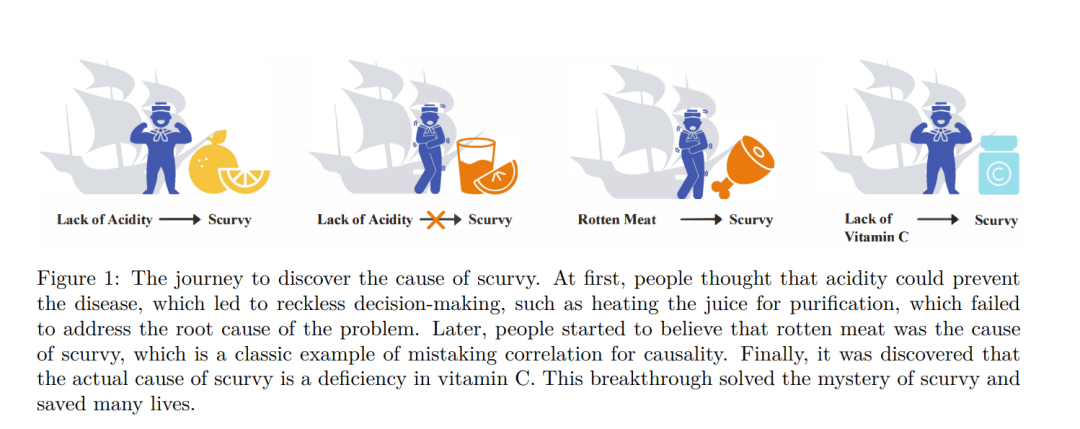

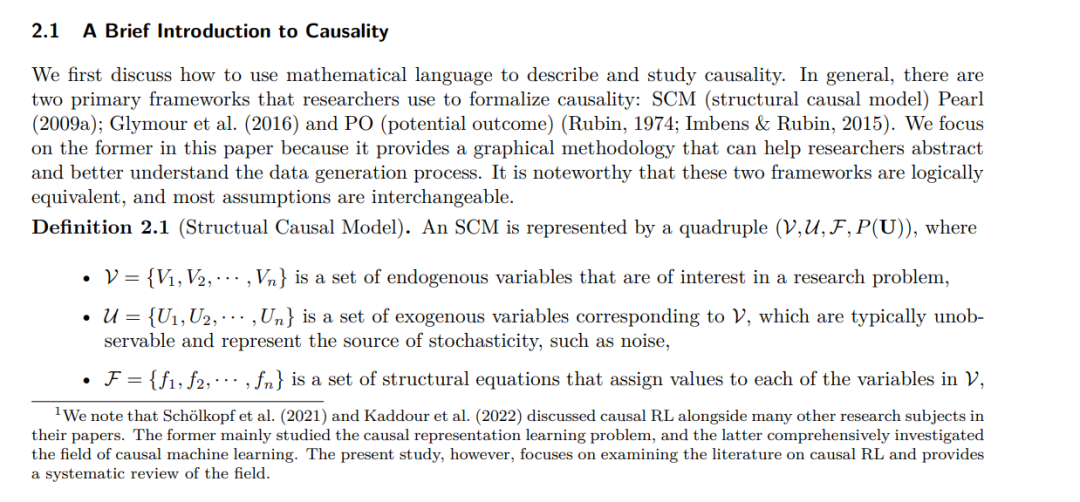

**许多研究人员研究了将因果知识与强化学习结合的原则性方法。最流行的是使用因果图(Glymour et al., 2016),这是因果知识的一种定性形式。**因果图可用于表示不区分每个维度含义的高层、粗粒度数据生成过程,例如标准的马尔可夫决策过程(MDP)。同时,因果图还可以传达低层次、细粒度的因果知识,如根据因果关系将状态分解为多个变量。此外,因果知识可以根据结构因果模型(SCM)框架进行定量表示(Pearl, 2009a;b),我们将在第2节中进一步解释。SCM认为数据生成过程是一个有序的方程集合,这些方程以结构化的方式生成数据。正如我们稍后在第4节中演示的那样,配备SCM的强化学习智能体可以直接生成数据,而不与实际环境交互,实现反事实数据增强和策略评估。

**本文对因果强化学习的综述提出了该领域的全面概述,在SCM框架内与现有研究保持一致。**本文通过回答三个基本问题来介绍因果强化学习:什么是因果强化学习?为什么需要研究它?因果模型如何改进现有的强化学习方法?本文还对因果关系研究和强化学习的基本概念进行了清晰和简洁的概述。据我们所知,这是现有强化学习文献中第一次对因果强化学习的全面综述。

**确定了强化学习中的瓶颈问题,这些问题可以通过因果建模的方式解决或改进。**进一步提出了一种面向问题的分类方法。这种分类法将帮助强化学习研究人员更深入地了解因果建模的优势和进一步研究的机会。另一方面,强化学习实践者也可以通过确定他们面临的挑战的解决方案,从这项综述中受益。根据现有的技术和设置,对现有的因果强化学习研究进行了比较和分析。

**强调了因果强化学习中未解决的主要问题和有希望的研究方向,如理论进展、基准和特定的学习范式。**这些研究主题在未来几年将变得越来越重要,并将有助于推进RL在现实世界应用中的使用。因此,在这一新兴领域中,有一个共同的基础来讨论这些有价值的想法是至关重要的,并将促进其持续发展和成功。