题目: Towards Hierarchical Importance Attribution:explaining compositional semantics for Neural Sequence Models

摘要:

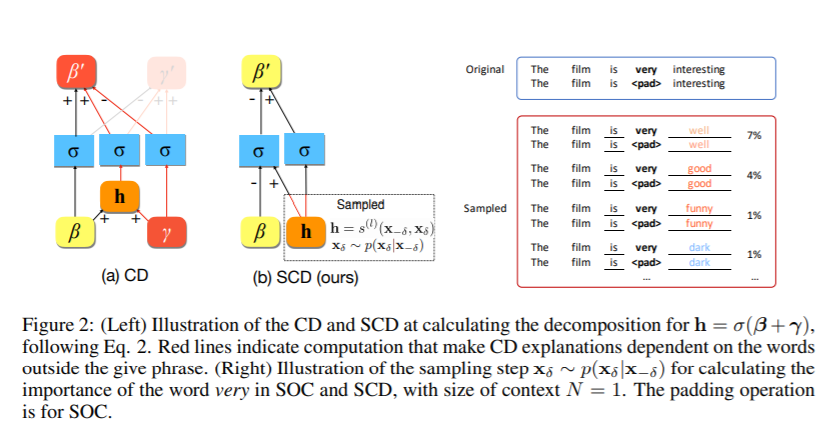

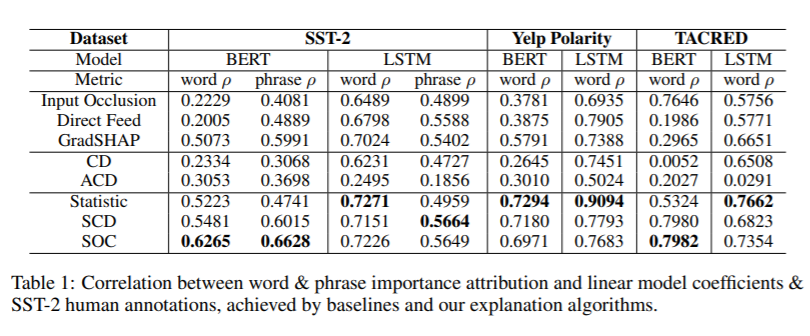

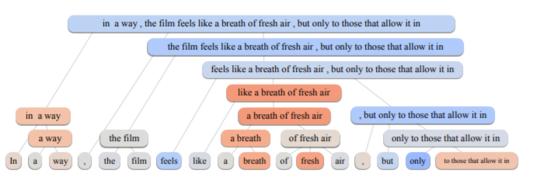

深度神经网络在处理复杂的自然语言语义方面取得了令人印象深刻的成绩,但大多数情况下被当作黑匣子。为了解释该模型如何处理单词和短语的组合语义,我们研究了层次解释问题。我们强调的关键挑战是计算非附加和上下文无关的单个单词和短语的重要性。我们展示了之前在层次解释上的一些努力,例如上下文分解,在数学上不能满足期望的属性,导致不同模型的解释质量不一致。在本文中,我们提出了一种形式化的方法来量化每个词或短语的重要性,从而产生层次解释。我们根据我们的公式修改了上下文分解算法,并提出了一个具有竞争性能的与模型无关的解释算法。对LSTM模型和对多个数据集的微调BERT Transformer模型进行人工评估和自动度量评估表明,我们的算法在层次解释方面明显优于先前的工作。我们展示了我们的算法有助于解释语义的组合性,提取分类规则,提高模型的人类可信度。

成为VIP会员查看完整内容

相关内容

Arxiv

5+阅读 · 2019年2月26日

Arxiv

4+阅读 · 2018年5月24日