1 引言

大语言模型(LLMs)因其在人类语言理解、生成与推理方面展现出的类人能力,已成为人工智能(AI)研究的核心 [1, 2]。最初,LLMs 主要作为工具,用于在更大应用体系中充当文本生成器或理解模块。然而,诸如小样本提示 [3]、链式思维(CoT)提示 [4] 和自提问提示 [5] 等方法展示了如何通过智能化的提示与输入模式设计进一步释放 LLMs 的潜力。 超越传统自然语言处理(NLP)任务,LLMs 现已作为自主智能体与智能工具应用于越来越复杂的工作流中,在其中承担规划、决策与工具交互的角色。这些应用涵盖研究辅助 [6]、软件开发 [7]、药物发现 [8]、多机器人系统 [9]、临床支持 [10]、游戏模拟 [11] 和科学仿真 [12] 等多个领域。 作为智能体,LLMs 能够感知环境、进行决策并采取行动。在这一范式下,单智能体 LLM 系统已在决策任务中展现出令人鼓舞的性能。例如 Reflexion [13]、Toolformer [14] 和 ReAct [15] 等系统展示了模型如何在包含规划、记忆与工具使用的决策循环中运行。然而,这类系统往往在动态环境下表现不足,难以应对同时进行的上下文追踪、外部记忆整合与自适应工具调用 [16, 17]。 为克服这些局限,多智能体 LLM 系统的概念逐渐受到重视。在此类系统中,多个 LLMs 作为专门化的智能体协作,每个智能体具有不同角色或目标,通过合作解决单一智能体难以完成的复杂任务。借助结构化通信、反思性推理与显式角色分配,多智能体 LLMs 在模拟环境中展现了诸如共识构建、具备不确定性意识的规划以及自主工具交互等能力 [18–20]。典型示例包括 MetaGPT [21]、CAMEL [22]、AgentBoard [23]、AutoAct [24] 与 ProAgent [25],它们展示了合作型智能体如何执行角色特定的指令并协调计划;而 Generative Agents [26] 则模拟了交互式环境中的类人行为。 此外,LLMs 作为智能体与工具展现出巨大的潜力,对其不断演化的角色的理解需求也在快速上升。因此,系统性综述其最新进展、讨论尚存不足,并提出未来研究方向,对于推动该领域发展具有重要意义。基于此,本文旨在提供一个全面且结构化的综述,涵盖当前能力与系统设计。我们将探讨支持 LLM 智能体行为的体系结构基础,分析其与外部工具的交互方式,讨论现有方法的主要局限,并突出现存的开放挑战。通过本综述,我们希望勾勒出这一新兴领域的研究图景,并为未来研究与发展奠定坚实基础。 本文的主要贡献总结如下:

系统性综述 LLMs 作为智能体与工具使用者的最新进展,提出了一个显式的分类体系,描述其架构、框架与交互范式; * 探讨 LLM 的推理、规划与记忆能力,并分析提示、微调与记忆增强如何提升智能体性能; * 批判性回顾当前 LLM 智能体与工具使用者的评估方法与基准; * 识别对齐性、可靠性与泛化性等核心挑战,并提出若干研究路径,以提升 LLM 智能体的鲁棒性与智能水平。

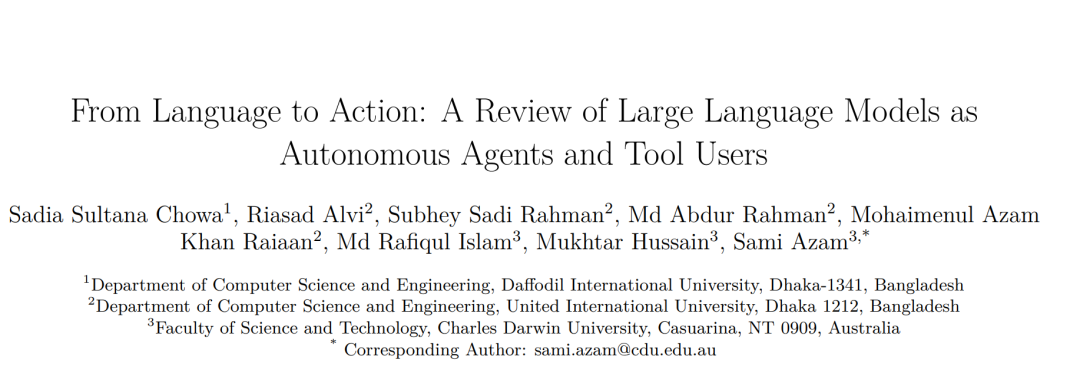

本文结构如下:第 2 节介绍相关工作,指出现有综述的不足并明确本文贡献;第 3 节阐述研究方法,包括研究问题、筛选标准与检索策略;第 4 节探讨用于智能体系统的基础 LLMs;第 5 节聚焦 LLM 工作流中的工具集成;第 6 节回顾单智能体与多智能体系统的框架;第 7 节研究 LLM 智能体的推理、规划与记忆能力;第 8 节讨论提示、微调与记忆增强等智能体性能提升技术;第 9 节评估现有基准与测评方法;第 10 节进行讨论;第 11 节提出未来研究方向;第 12 节总结全文贡献与洞见。图 1 展示了本文的整体结构。