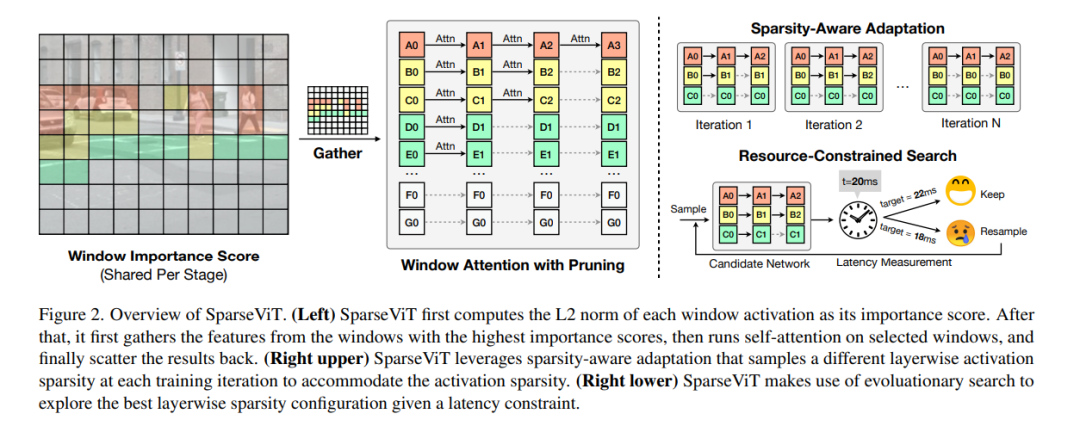

高分辨率图像使神经网络能够学习更丰富的视觉表示。然而,这种性能的提升是以计算复杂度的增加为代价的,阻碍了它们在对延迟敏感的应用程序中的使用。由于并非所有像素都相等,跳过不重要区域的计算提供了一种简单而有效的方法来减少计算量。然而,这很难转化为CNN的实际加速,因为它打破了密集卷积工作的规律。**本文提出SparseViT,重新审视最近基于窗口的视觉Transformer (vit)的激活稀疏性。**由于窗口注意力自然地在块上批量处理,因此窗口激活剪枝的实际加速成为可能:即在60%的稀疏性下减少50%的延迟。由于不同层的敏感度和计算代价不同,应该为其分配不同的剪枝率。引入稀疏感知自适应,并应用进化搜索,在巨大的搜索空间中有效地找到最优的分层稀疏配置。在单目3D目标检测、2D实例分割和2D语义分割方面,SparseViT与密集版本相比,分别实现了1.5倍、1.4倍和1.3倍的速度,而精度几乎没有损失。

https://www.zhuanzhi.ai/paper/0e163c1922196a209205cd9babff4aaf

成为VIP会员查看完整内容

相关内容

CVPR 2023大会将于 6 月 18 日至 22 日在温哥华会议中心举行。CVPR是IEEE Conference on Computer Vision and Pattern Recognition的缩写,即IEEE国际计算机视觉与模式识别会议。该会议是由IEEE举办的计算机视觉和模式识别领域的顶级会议,会议的主要内容是计算机视觉与模式识别技术。

CVPR 2023 共收到 9155 份提交,比去年增加了 12%,创下新纪录,今年接收了 2360 篇论文,接收率为 25.78%。作为对比,去年有 8100 多篇有效投稿,大会接收了 2067 篇,接收率为 25%。

Arxiv

0+阅读 · 2023年5月19日

Arxiv

12+阅读 · 2021年5月30日