题目: DeeBERT: Dynamic Early Exiting for Accelerating BERT Inference

摘要:

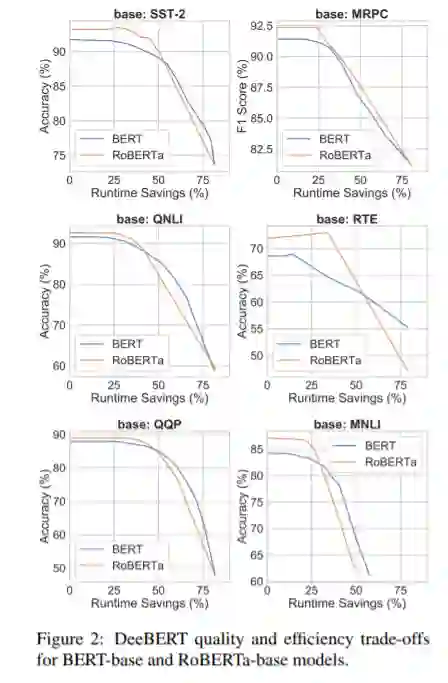

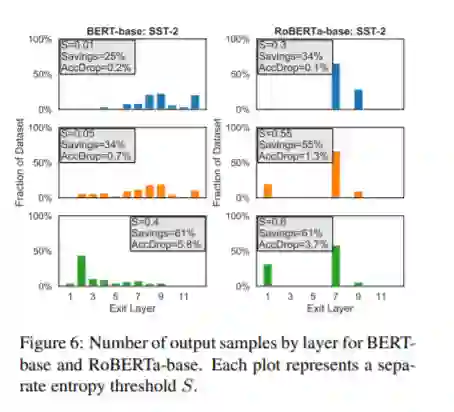

大规模的预训练语言模型(如BERT)给NLP应用带来了显著的改进。然而,它们也因推理速度慢而臭名昭著,这使得它们很难部署到实时应用程序中。我们提出了一个简单而有效的方法DeeBERT,来加速BERT推理。我们的方法允许样本在不经过整个模型的情况下提前退出。实验表明,在模型质量下降最小的情况下,DeeBERT可以节省高达40%的推理时间。进一步的分析显示了伯特变压器层的不同行为,并揭示了它们的冗余性。我们的工作为有效地将深度转换模型应用于下游任务提供了新的思路。

成为VIP会员查看完整内容

相关内容

Arxiv

15+阅读 · 2018年10月11日

Arxiv

3+阅读 · 2018年4月10日