目前,人工智能(AI)为改造许多军事行动领域提供了巨大的机会,包括作战、指挥与控制(C2)、后勤、安全和维护,以提高其整体作战效率。空中和导弹防御(AMD)是一个特别复杂的任务领域,人工智能的应用至关重要。空中导弹防御任务指的是保卫国土、保护区、地面基地、地面部队或舰艇免受敌对的空中或导弹威胁。AMD的威胁包括敌对的飞机、无人驾驶飞行器(UAV)或机载导弹。AMD行动的复杂性源于威胁的严重性、威胁的意外性、对形势认识的不确定性以及事件的快速发展,因为作战人员必须迅速评估形势,制定适当的行动方案,并最好地利用他们的战争资产来应对。美国国防部(U.S. DOD)正在研究使用AI系统(或AI-enabled AMD[AI-AMD]系统)作为AMD作战人员的自动决策辅助工具,以大大减少他们的认知负荷(Jones等人,2020),使AMD决策更快、更好。

人工智能的一个关键方面已经聚集了大量的研究兴趣,那就是信任。信任是有效团队的一个基本原则。它同时适用于人类和人机团队。信任使团队成员能够很好地合作,是有效团队表现的基础(Lee and See 2004)。与人工智能系统的成功合作将需要人类对人工智能系统有一个校准的信任和依赖程度(泰勒等人,2016)。

随着更先进和更快的空中和导弹威胁弹药的发展和投入使用,操作人员更需要在AMD行动中迅速作出监测。不及时的决策和反应将导致灾难性的后果。因此,人工智能是一个可能的解决方案,通过自动决策辅助工具加快和加强决策过程。这些AMD自动战斗管理辅助工具可以帮助战术操作人员应对更快的决策周期、大量的数据以及需要观察的几个系统或屏幕(Galdorisi 2019)。然而,为了有效地利用人工智能能力的潜力,需要操作员的高度信任。操作员对系统的信任程度低,可能会导致人工智能-AMD系统利用不足,受到不适当的监控,或者根本不使用(Floyd, Drinkwater, and Aha 2016)。这些问题中的任何一个都可能导致操作者的工作量不必要的增加,或者任务失败的可能性。

论文对信任的定义、人机交互(HMI)的概念、信任因素以及包括AMD杀伤链模型、威胁场景、架构、模型和功能在内的概念模型进行了广泛的回顾。有了这样的认识,论文提出了人工智能-AMD系统的信任框架,对人机交互和人工智能-AMD系统信任因素的描述。论文最后提出了在人类操作者和AI-AMD系统之间实现校准信任的策略。

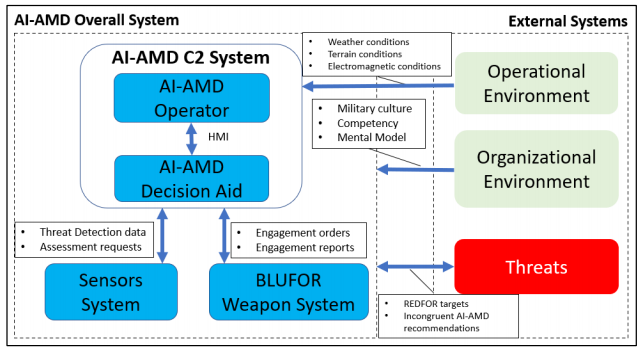

信任框架始于对系统背景的分析。图1显示了AI-AMD指挥与控制(C2)系统(包括AI-AMD操作员和决策辅助工具)及其他与之互动的子系统的背景图,这些子系统有助于操作员和AI-AMD决策辅助工具之间信任的发展。背景图使我们能够研究各系统之间的相互作用,以及它们对AI-AMD操作员和决策辅助工具之间信任动态的影响。

图1. AI-AMD系统框架图。

这篇论文将信任定义为操作者的态度,即AI-AMD决策辅助工具将有助于实现操作者的目标,即在一个以不确定性和脆弱性为特征的作战环境中迅速摧毁来袭威胁的任务。这种信任的定义表明,它是对操作者相信或感知AI-AMD决策辅助工具的一种情感评估。为了积极地影响信任,操作者必须亲自看到并感受到AI-AMD决策辅助行动的优势。AI-AMD行动涉及很多不确定因素,以及天气、电磁干扰和地形等环境因素以及不断变化的威胁的性质所带来的脆弱性。操作员将预期AI-AMD决策辅助系统按照 "合同 "执行,以处理这些不确定性和脆弱性。这些合同将是人工智能-AMD决策辅助工具应该执行的感知功能或任务,以及执行这些功能或任务的理想表现。

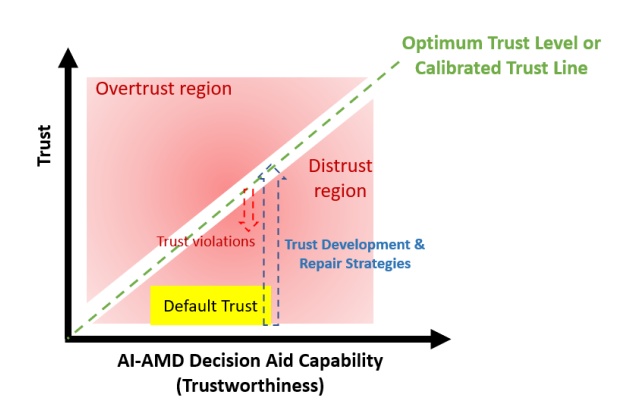

图2说明了操作员和AI-AMD决策辅助工具之间的信任框架。y轴代表人类对AI-AMD决策辅助系统的信任程度,x轴代表AI-AMD决策辅助系统的能力。绿色的45°虚线表示最佳的信任水平或校准的信任线,其中的信任与AI-AMD的能力相对应,导致正确的利用(Lee and See 2004)。过度信任由最佳信任水平线以上的区域表示,此时的信任超过了系统能力,导致误用。低于理想信任水平线的区域表示不信任,这时的信任没有达到系统能力,导致滥用。假设存在一些默认的信任水平(如黄框所示),目标是制定一个策略,以提高AI-AMD辅助决策能力的信任。在使用该系统时,可能会发生违反信任的情况,从而降低操作员的信任。因此,信任修复行动必须被纳入,以保持信任在最佳水平。

图2. 人类操作员和AI-AMD决策辅助工具之间的信任。

基于功能分配的操作员和AI-AMD决策辅助工具之间的人机交互研究表明,操作员和AI-AMD决策辅助工具应该被设计成在大多数杀戮链功能中作为一个 "团队"运作。这引导论文研究了单独和集体考虑人类和决策辅助的信任因素。对操作员和人工智能-AMD决策之间的人机交互的研究还显示,操作员的角色已经从手动控制器变成了监督控制器。因此,一个值得信赖的决策辅助工具是很重要的,因为操作者会期望系统的表现符合预期,以帮助操作者更好地履行他的角色。另外,为了进一步帮助减轻操作者的认知工作量,信息的外部表示、决策辅助工具的建议必须易于阅读和理解。

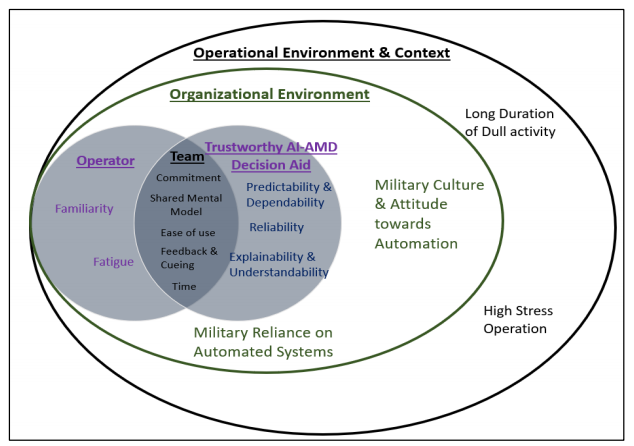

关于信任因素,本论文提出了一个 "由外而内 "的框架,如图3所示。论文首先考虑了与操作环境相关的因素,这些因素描述了AMD操作系统的背景。第二,它研究了与组织环境相关的因素,操作人员和人工智能-AMD系统得到了培训和发展。第三,论文研究了操作人员和人工智能-AMD决策辅助工具之间的交互,以提出与操作人员、人工智能-AMD、单独和集体相关的因素。

图3. 建议的信任因素

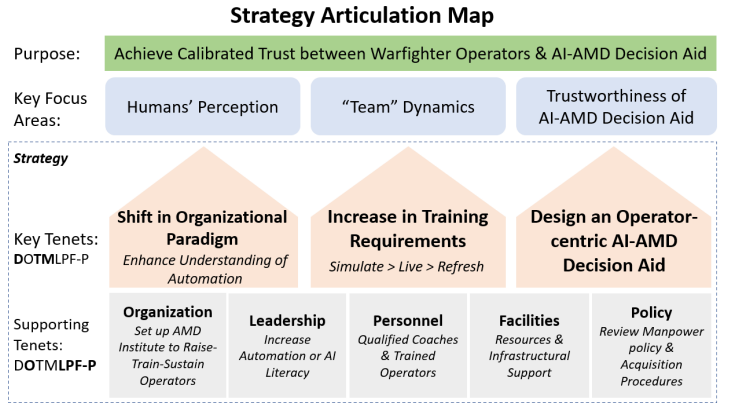

图4显示了拟议的战略衔接图,以实现操作者和AI-AMD辅助决策之间的校准信任。对信任定义、人机界面和信任因素的审查表明,该战略应关注三个关键领域:(1)人类对自动化技术和AI-AMD决策辅助系统的集体和个人感知;(2)增强操作员和AI-AMD决策辅助系统的团队活力;(3)AI-AMD决策辅助系统的可信度,重点是系统开发。该战略利用DOTMLPF-P框架提出了三个关键原则和五个支持原则。首先,军事作战人员需要被告知自动化技术的真正能力和局限性,特别是AI-AMD辅助决策。第二,操作员的培训要求必须增加,以应对新的工作范围和不断变化的威胁。第三,必须在人工智能-AMD决策辅助系统的开发中加入新的要求,以提高系统的可感知的可信度。这三个关键原则得到了DOTMLPF-P框架其他方面的支持,如组织、领导、人员、设施和政策。

图4. 实现操作员和人工智能-AMD决策辅助工具之间校准信任的战略衔接图