大型语言模型(LLMs),如 BERT、GPT-3 和 LLaMA,由于其强大的文本编码和解码能力以及发现的潜在能力(如推理),在自然语言处理的各种任务中表现出强大的性能和发展前景。尽管 LLMs 表现出色,但它们往往会从多个来源继承偏见,包括训练数据、编码过程和微调程序,这可能导致对某些由敏感属性(如年龄、性别或种族)定义的群体产生偏见决策。这种偏见预测引发了重要的伦理和社会问题,严重限制了 LLMs 在高风险决策场景(如招聘、贷款审批、法律判决和医疗诊断)中的应用。 因此,需要全面理解不同公平 LLM 方法在多样化研究中的实现和理解方式。如果缺乏对这些对应关系的清晰认识,未来公平 LLMs 的设计可能会变得困难。因此,迫切需要一个系统化的教程来阐明公平 LLMs 的最新进展。尽管已有一些教程探讨了机器学习算法中的公平性,但这些教程主要关注于更广泛的机器学习算法中的公平性。针对 LLMs 内部公平性的综合资源存在明显的缺口,这与传统模型有所区别,并讨论了最新的发展。为了解决这一需求,我们提出了一个关于大型语言模型中的公平性的教程:公平性进展与未来展望。本教程旨在为研究人员、开发人员和从业人员提供关于公平 LLMs 的最新和全面的现有工作综述。 我们的教程分为五个关键部分:

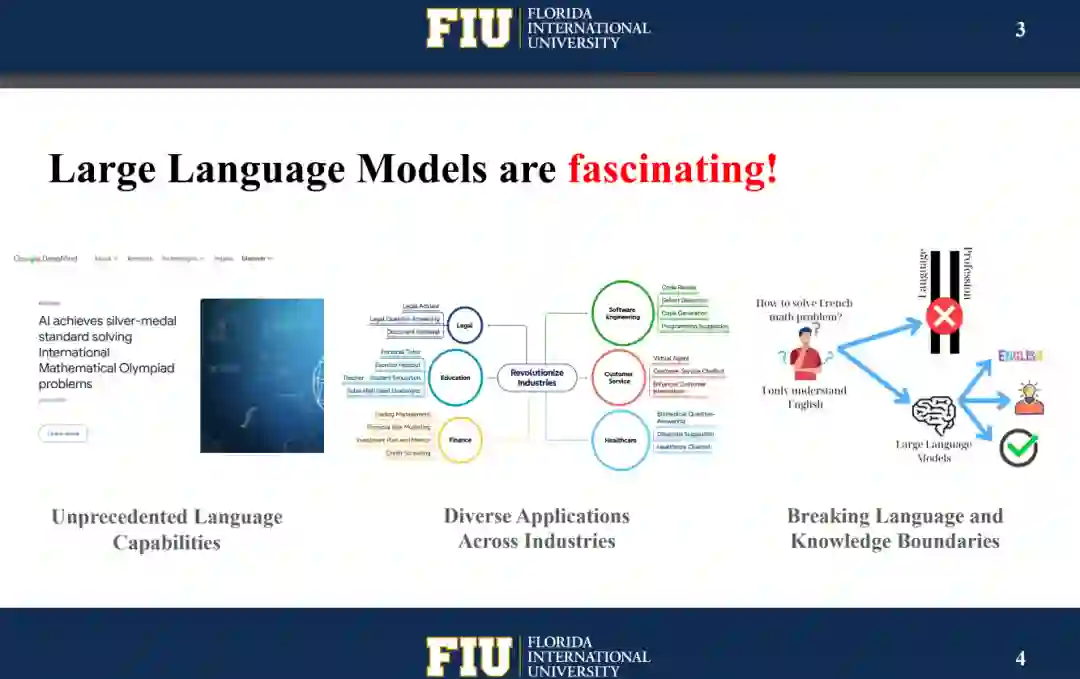

- LLMs 的背景

- LLMs 中的偏见量化

- LLMs 中的偏见缓解

- 偏见评估资源

- 挑战与未来方向

成为VIP会员查看完整内容

相关内容

Arxiv

225+阅读 · 2023年4月7日