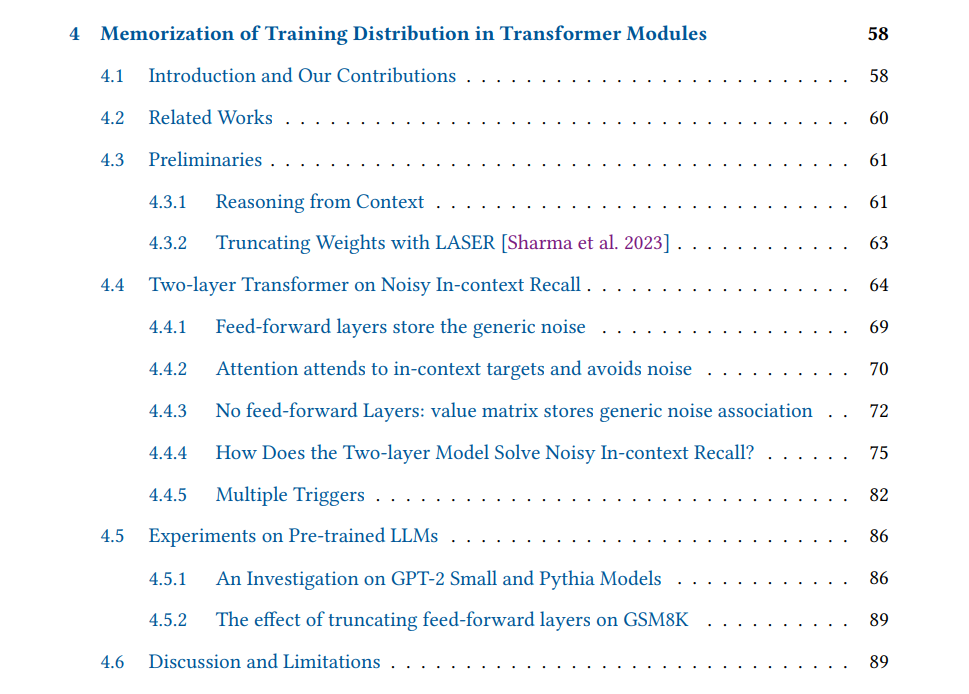

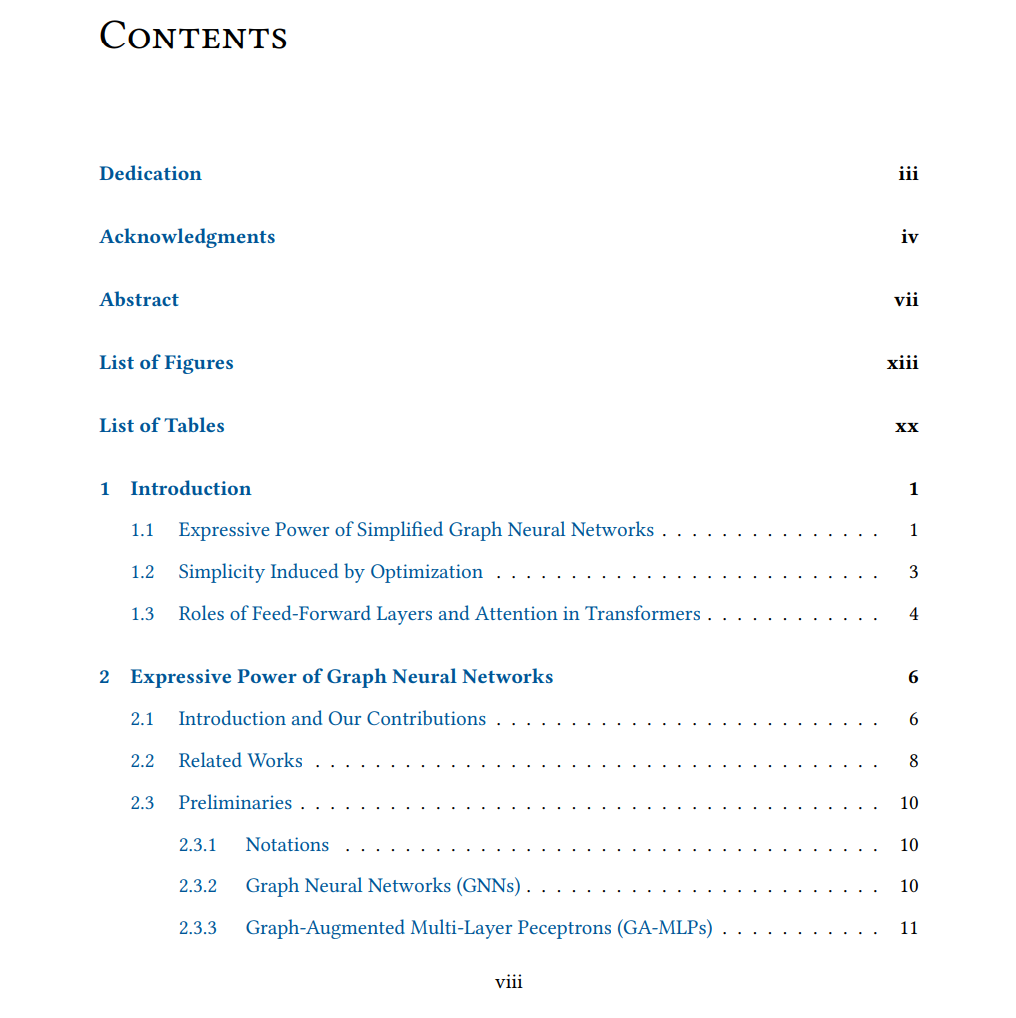

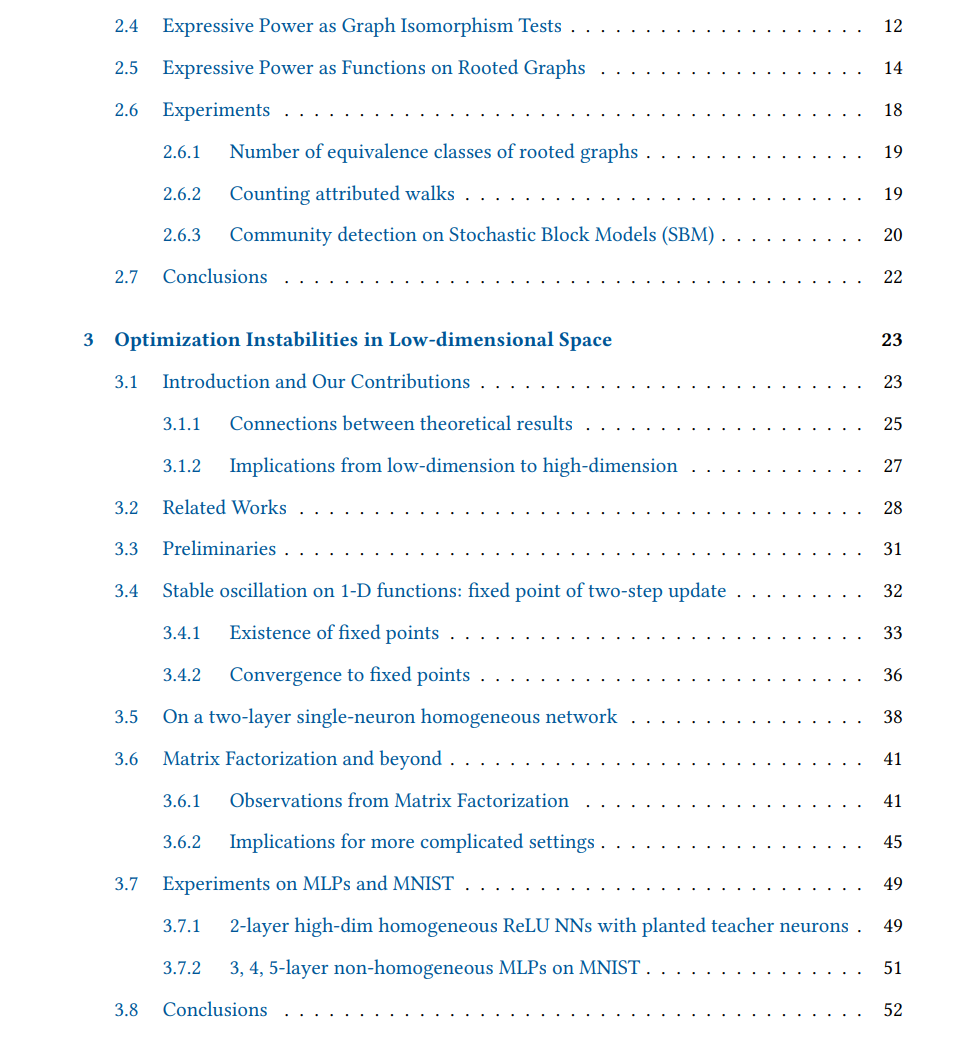

在这个大型语言模型(LLMs)及其他巨型神经网络迅猛发展的时代,我们旨在从零出发,分析简化情境,作为理解这些大型模型功能机制的基础性步骤。我们从三个方面展开探讨。 在表达能力方面,我们研究了一类简化的图网络——图增强多层感知机(Graph-Augmented Multi-layer Perceptrons, GA-MLPs)的函数类,并与经典图神经网络(Graph Neural Networks, GNNs)进行了对比。我们采用图同构测试和带属性路径计数等方式来衡量它们的表示能力。 在优化性方面,我们从理论角度分析了神经网络训练中由于大学习率引发的不稳定性现象,即“稳定性边缘”(Edge of Stability)。我们研究了损失函数在训练过程中为何会呈现出不稳定轨迹的条件,尤其是其在低维子空间中产生振荡的情况。随后,我们将这一特性应用于一些简单但具有代表性的学习问题中,如教师-学生框架下的两层单神经元同构网络和矩阵分解问题。 在推理任务中的数据分布方面,我们提出将下一个 token 的预测分解为两个部分:上下文内推理(in-context reasoning)与分布关联(distributional association)。我们在一个可控的合成实验设置中,从实证与理论两个角度对这一分解方法进行了研究,发现前馈层(feed-forward layers)更倾向于学习如二元语法(bigram)等简单的分布关联,而注意力层则主要负责上下文内的推理。最后,基于这些理解,我们进一步提供了实验证据,说明对前馈层进行修改可以提升 LLM 在某些任务上的表现。

成为VIP会员查看完整内容

相关内容

Arxiv

38+阅读 · 2023年4月19日

Arxiv

205+阅读 · 2023年4月7日

Arxiv

79+阅读 · 2023年4月4日

Arxiv

140+阅读 · 2023年3月29日