**引言

扩散模型(Diffusion Models)是近年来在各种视觉任务中广受关注的生成建模方法。由于这些模型不依赖标签注释,因此可以被视为一种独特的自监督学习方法。本文综述了扩散模型与表示学习之间的相互关系,概述了扩散模型的基本方面,包括数学基础、流行的去噪网络架构和指导方法。此外,本文还详细介绍了与扩散模型和表示学习相关的各种方法,包括利用预训练扩散模型学习的表示进行后续识别任务的框架,以及利用表示学习和自监督学习进展来增强扩散模型的方法。本文旨在提供扩散模型与表示学习之间分类法的全面概述,识别现有问题和潜在探索的关键领域。

扩散模型(Diffusion Models)最近在生成建模领域中脱颖而出,展示了在图像合成、自然语言处理、计算化学和音频合成等领域的非凡成果。扩散模型的卓越生成能力表明,它们不仅可以学习输入数据的低层次特征,还可以学习高层次特征,使其成为通用表示学习的理想候选者。与生成对抗网络(GANs)和变分自编码器(VAEs)等其他生成模型不同,扩散模型没有固定的架构组件来捕获数据表示,这使得基于扩散模型的表示学习具有挑战性。然而,利用扩散模型进行表示学习的方法受到了越来越多的关注,同时也得益于扩散模型在训练和采样方面的进展。

目前最先进的自监督表示学习方法展示了良好的可扩展性,因此,扩散模型也可能表现出类似的扩展特性。用于获得最先进的生成结果的控制生成方法(如分类器指导和无分类器指导)依赖于带注释的数据,这成为扩展扩散模型的瓶颈。利用表示学习的指导方法无需注释,提供了一种解决方案,可能使扩散模型能够在更大的、无注释的数据集上进行训练。

本文旨在阐明扩散模型与表示学习之间的关系和相互作用。我们重点介绍两个核心观点:利用扩散模型本身进行表示学习,以及利用表示学习来改进扩散模型。我们介绍了当前方法的分类,并总结了展示当前方法共性的通用框架。

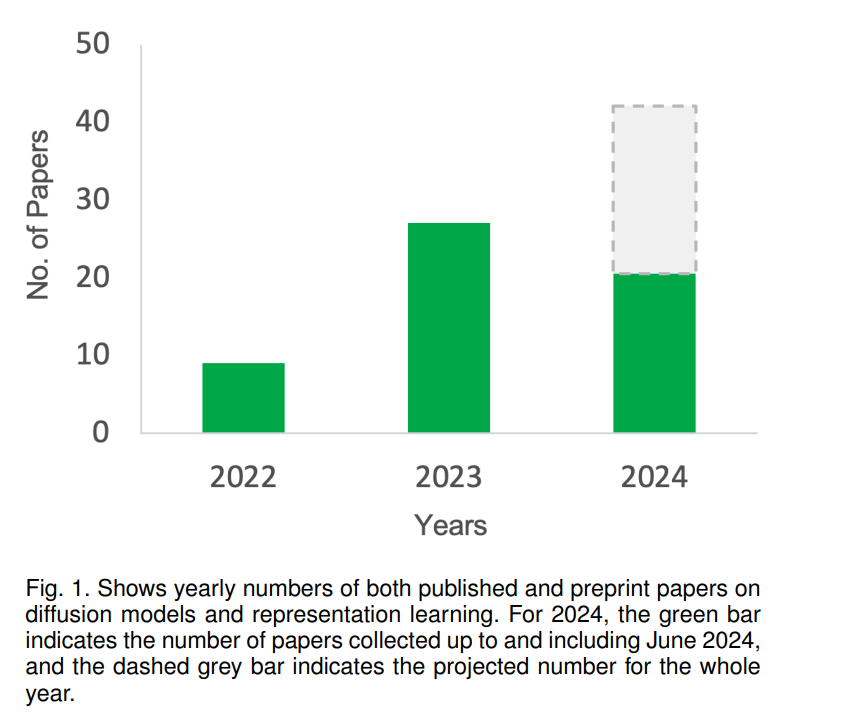

自Ho等人、Sohl-Dickstein等人和Song等人最初提出扩散模型以来,对探索扩散模型表示学习能力的兴趣不断增加。正如图1所示,我们预计这一趋势将在今年继续。扩散模型和表示学习方面发表的作品数量增加,使得研究人员更难识别最先进的方法并跟上当前的发展。这可能会阻碍这一领域的进展,这也是为什么我们认为需要对这一领域进行全面概述和分类。

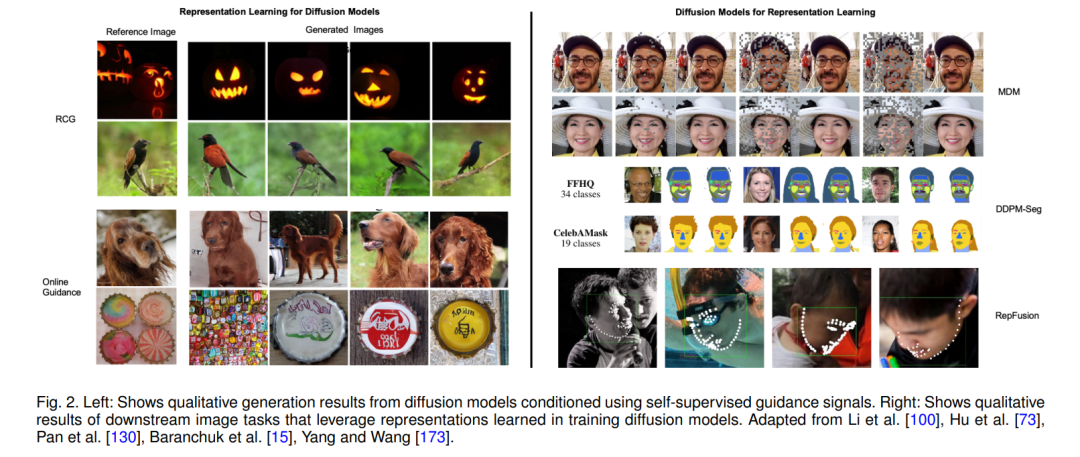

扩散模型和表示学习的研究还处于初期阶段。许多当前的方法仅依赖于为生成合成训练的扩散模型进行表示学习。因此,我们假设未来在这一领域有显著的进步机会,扩散模型可以越来越多地挑战当前表示学习的最先进水平。图2展示了现有方法的定性结果。我们希望这份综述可以通过澄清当前方法的共性和差异,促进基于扩散的表示学习的进展。总结而言,本文的主要贡献如下:

全面概述:提供扩散模型与表示学习相互作用的全面综述,澄清如何利用扩散模型进行表示学习,反之亦然。

方法分类:我们引入了基于扩散表示学习的当前方法的分类,突出它们之间的共性和差异。

通用框架:本文为扩散模型特征提取和基于分配的指导提出了通用框架,提供了对大量扩散模型和表示学习作品的结构化视角。

未来方向:我们确定了这一领域进一步发展的关键机会,鼓励探索扩散模型和流匹配作为表示学习的新前沿。