为提升无人机在复杂空战场景中的存活率, 基于公开无人机空战博弈仿真平台, 使用强化学习方法生成机动策略, 以深度双Q网络(double deep Q-network, DDQN)和深度确定性策略梯度(deep deterministic policy gradient, DDPG)算法为基础, 提出单元状态序列(unit state sequence, USS), 并采用门控循环单元(gated recurrent unit, GRU)融合USS中的态势特征, 增加复杂空战场景下的状态特征识别能力和算法收敛能力。实验结果表明, 智能体在面对采用标准比例导引算法的导弹攻击时, 取得了98%的规避导弹存活率, 使无人机在多发导弹同时攻击的复杂场景中, 也能够取得88%的存活率, 对比传统的简单机动模式, 无人机的存活率大幅提高。

现代空战环境错综复杂, 空空导弹和机载雷达性能不断提升, 超视距空战已经在现代空战中占据主导地位[1], 空空导弹也早已成为打击空中单位的主要武器。无人机作为空中战场的理想作战目标之一, 被普遍运用到军事领域当中[2]。利用无人机可持续大机动的飞行特点, 采取高效的机动策略以提高无人机对导弹的规避、逃逸成功率, 对提升无人机的空战生存能力而言至关重要[3]。

无人机规避空空导弹问题一直都是空战的研究热点。王怀威等[4]采用蒙特卡罗方法验证了无人机实施常规盘旋机动规避导弹的效果。Imado等[5]利用微分对策法研究导弹与无人机差速博弈的问题。另外, 还有诸多针对导弹的规避方式[6-10]、规避效能评估[11-13]以及无人机最优或次优规避策略解析解[14-16]等方面的研究。以上方法依赖于完备的空战对战模型以求解在单枚导弹打击情况下的最优机动策略, 当导弹数量变化时, 模型很难理解, 而且建立空战对战模型本身就是一个非常复杂的过程, 需要使用大量微分函数结合积分函数,才能表征无人机与导弹状态属性的转移规律。

深度强化学习(deep reinforcement learning, DRL)算法在马尔可夫决策过程(Markov decision process, MDP)基础上, 采用端到端学习方式, 以态势信息为输入, 直接利用神经网络获取输出, 控制智能体作出决策, 被广泛应用于自动化控制当中[17-22]。范鑫磊等[23]将深度确定性策略梯度(deep deterministic policy gradient, DDPG)算法[24]应用于无人机规避导弹训练, 在简易模型下对固定态势攻击的空空导弹进行仿真验证。宋宏川等[25]针对导弹制导规则设计成型奖励, 用DDPG算法训练无人机规避正面来袭的导弹, 对比典型规避策略, 训练出了仅次于置尾下降机动的逃逸策略。

上述研究表明, 无人机能够通过特定的机动方式来规避空空导弹的打击, 而深度强化学习算法可以训练出自动规避空空导弹的智能体。总体而言, 以往研究大多基于单枚导弹打击场景。但是在超视距空战中, 多枚导弹从不同方向锁定无人机并发动协同攻击的情况屡见不鲜。在这种情形下, DRL算法会存在状态空间维度大, 状态信息维度不断变化, 神经网络输入维度难以固定, 算法收敛性能差等问题。

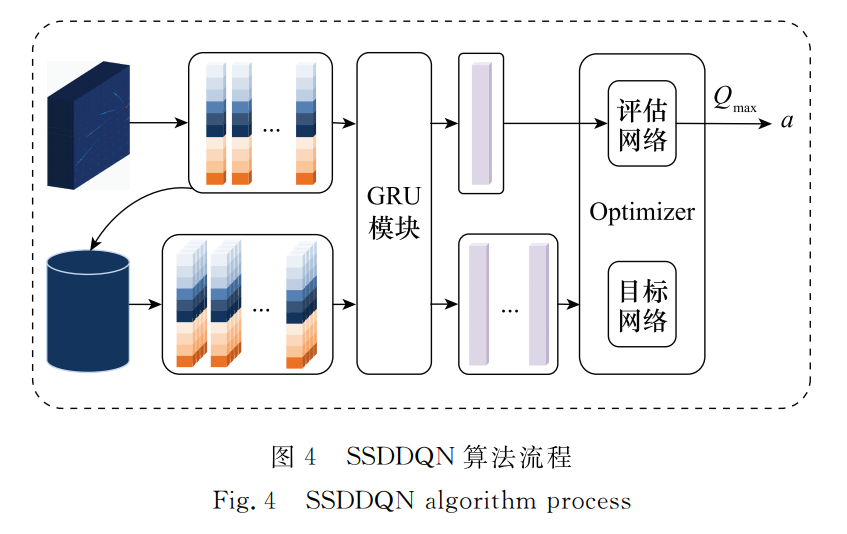

针对以上问题, 本文提出一种基于单元状态序列(unit state sequence, USS)的强化学习算法(reinforcement learning method based on USS, SSRL)。在该算法中,首先,将导弹和无人机进行一对一的特征编码,形成特征单元; 其次,根据距离优先级对所有编码后的特征单元进行排序, 组合成一个USS; 然后,使用门控循环单元(gated recurrent unit, GRU)对USS中的特征单元进行特征融合, 提取其中的隐藏特征信息; 最后,将隐藏特征信息看作该时刻的状态信息,并将信息传入强化学习算法的神经网络。将该算法分别应用于深度双Q网络(double deep Q-network, DDQN)[26]和DDPG算法上, 在公开无人机空战博弈仿真平台上进行训练。仿真结果表明, 由SSRL算法训练的智能体能够学到连续规避机动策略, 控制无人机进行规避导弹机动, 增加导弹脱靶量, 提升无人机连续规避导弹的成功率。