【视频检索用多模态融合Transformer】Everything at Once -- Multi-modal Fusion Transformer for Video Retrieval

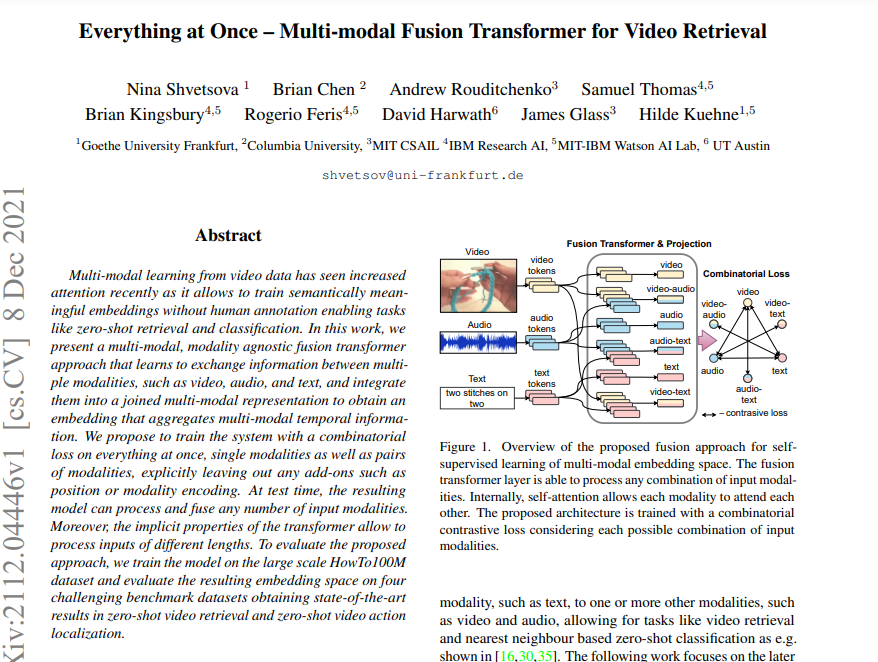

● 从视频数据中进行的多模态学习最近受到了越来越多的关注,因为它允许训练语义上有意义的嵌入,而无需人工标注,从而实现了零镜头检索和分类等任务。在这项工作中,我们提出了一种多模态、模态不可知的融合Transformer方法,它学习在多种模态之间交换信息,例如视频、音频和文本,并将它们集成到一个连接的多模态表示中,以获得一个聚合多模态时间信息的嵌入。我们建议在训练系统的同时对所有的东西进行组合损失,无论是单个模式还是成对的模式,明确地排除任何附加的东西,如位置或模式编码。在测试时,得到的模型可以处理和融合任意数量的输入模式。此外,变压器的隐式特性允许处理不同长度的输入。为了评估所提出的方法,我们在大规模的HowTo100M数据集上训练模型,并在四个具有挑战性的基准数据集上评估结果嵌入空间,获得了在零拍视频检索和零拍视频动作定位方面的最先进的结果。

● 论文链接:https://arxiv.org/abs/2112.04446

● 作者单位:法兰克福歌德大学、哥伦比亚大学、麻省理工学院、IBM、德州大学奥斯汀分校等

成为VIP会员查看完整内容