论文题目: Hashing Graph Convolution for Node Classification

论文摘要:

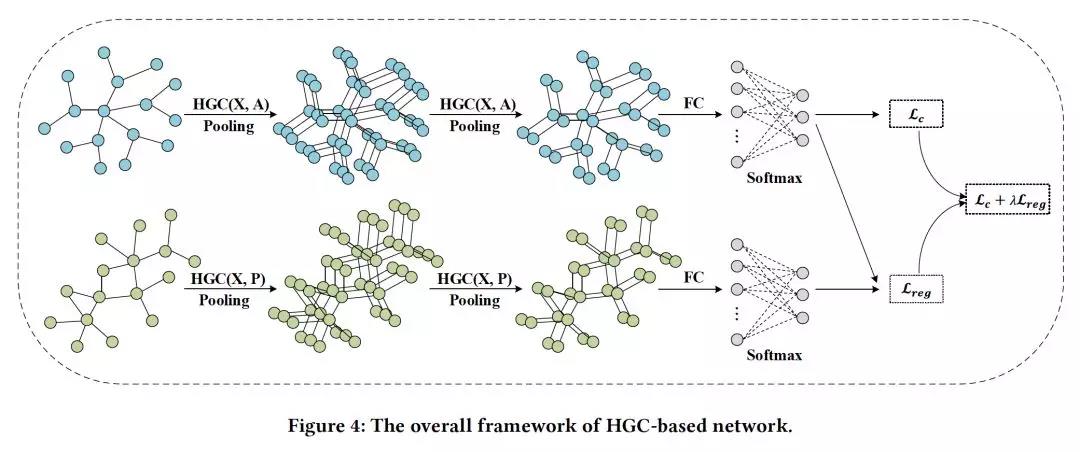

图数据卷积在non-gridded数据中的应用引起了人们的极大兴趣。为了克服相邻节点的排序和数量的影响,在以往的研究中,往往对局部接受域进行summing/average diffusion/aggregation。然而,这种压缩成一个节点的方法容易造成节点间的signal entanglement,导致次优特征信息,降低了节点的可分辨性。针对这一问题,本文提出了一种简单而有效的哈希图卷积(HGC)方法,该方法通过在节点聚合中使用全局哈希和局部投影来进行节点分类。与传统的完全collision聚合相比,hash-projection可以大大降低相邻节点聚合时的collision概率。我们认为基于hash-projection的方法可以更好地保持甚至增加局部区域的原始差异,并得到进一步的改进。hash-projection的另一个附带效果是将每个节点的接受域归一化为一个共同大小的bucket空间,不仅避免了大小不同的邻居节点及其顺序的麻烦,而且使图卷积运行起来就像标准的shape-girded卷积一样。考虑到训练样本较小,我们在HGC中引入预测一致性正则化项来约束图中未标记节点的得分一致性。HGC在transductive和inductive实验环境下进行评估。在节点分类任务上的大量实验表明,hash-projection确实可以提高性能,我们的HGC在所有实验数据集上都取得了最新最好的结果。

论文作者:

崔振在北京中国科学院计算技术研究所获得计算机科学博士学位,是新加坡国立大学电子与计算机工程系研究员。2012年6月至2012年12月,在南洋理工大学任研究助理半年。现为南京理工大学教授,他的研究兴趣包括计算机视觉、模式识别和机器学习,特别是图形、视频分析和场景理解等方面的深度学习。