Knowledge Distillation in Wide Neural Networks: Risk Bound, Data Efficiency and Imperfect Teacher

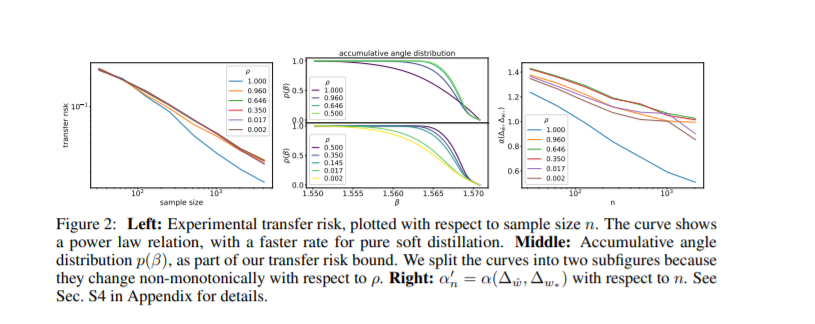

知识提炼是一种在教师网络的软输出指导下训练学生网络的策略。它已成为模型压缩和知识转移的成功方法。然而,目前的知识提炼缺乏令人信服的理论知识。另一方面,最近在神经正切核上的发现使我们能够使用网络随机特征的线性模型来近似宽泛的神经网络。在本文中,我们从理论上分析了广义神经网络的知识提炼问题。首先给出了线性化网络模型的转移风险界限。然后我们提出了一个任务训练难度的度量,称为数据效率。基于这一衡量标准,我们表明,对于一个完美的教师,高比例的教师软标签可能是有益的。最后,对于教师不完善的情况,我们发现硬标签可以纠正教师的错误预测,这就解释了硬标签和软标签混合使用的实践。

https://www.zhuanzhi.ai/paper/8fb343feb238db246bcdb59a367b6cbd

成为VIP会员查看完整内容

相关内容

人工神经网络(Artificial Neural Network,即ANN ),是20世纪80 年代以来人工智能领域兴起的研究热点。它从信息处理角度对人脑神经元网络进行抽象, 建立某种简单模型,按不同的连接方式组成不同的网络。在工程与学术界也常直接简称为神经网络或类神经网络。神经网络是一种运算模型,由大量的节点(或称神经元)之间相互联接构成。每个节点代表一种特定的输出函数,称为激励函数(activation function)。每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重,这相当于人工神经网络的记忆。网络的输出则依网络的连接方式,权重值和激励函数的不同而不同。而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。

最近十多年来,人工神经网络的研究工作不断深入,已经取得了很大的进展,其在模式识别、智能机器人、自动控制、预测估计、生物、医学、经济等领域已成功地解决了许多现代计算机难以解决的实际问题,表现出了良好的智能特性。

Arxiv

4+阅读 · 2020年10月20日