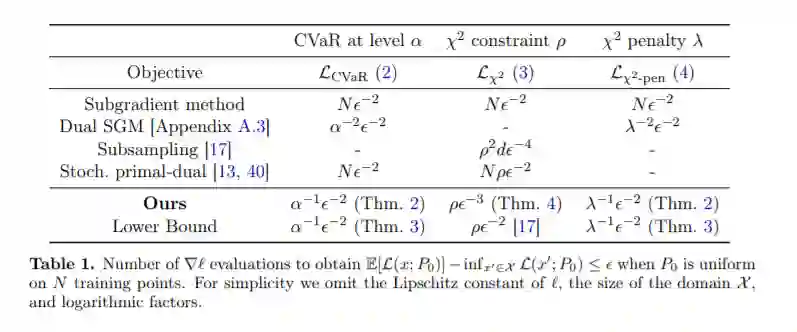

我们提出并分析了具有条件风险值(CVaR)的凸损失分布鲁棒优化算法和有条件风险值的χ2发散不确定性集。我们证明了我们的算法需要大量的梯度评估,独立于训练集的大小和参数的数量,使它们适合大规模的应用。对于χ2的不确定性集,这些是文献中第一个这样的保证,对于CVaR,我们的保证在不确定性水平上是线性的,而不是像之前的工作中那样是二次的。我们还提供了下界来证明我们的CVaR算法的最坏情况的最优性和一个惩罚性的版本的χ2问题。我们的主要技术贡献是基于[Blanchet & Glynn, 2015]的批量鲁棒风险估计偏差的新界和多层蒙特卡洛梯度估计器的方差。

https://arxiv.org/abs/2010.05893

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2020年11月24日