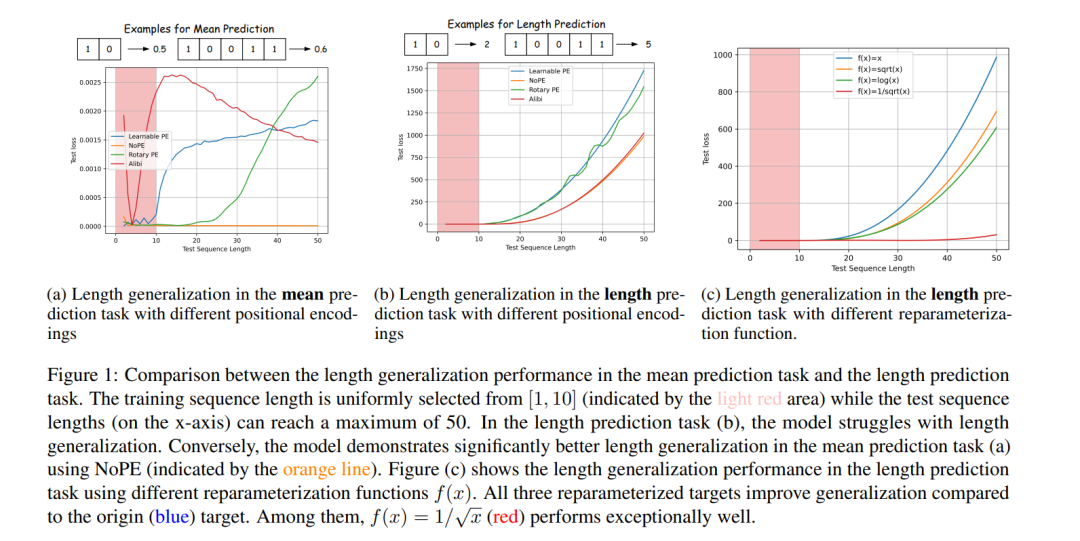

大型语言模型(LLMs)展现出了令人印象深刻的性能和惊人的涌现能力。然而,其有效性仍受限于 Transformer 架构的固定上下文窗口,这对长上下文建模带来了挑战。其中,长度泛化(length generalization)——即泛化到训练时未见过的更长序列的能力——是一个经典且基础的问题。 本文提出了一种关于长度泛化的新视角,将关注点从传统的输入特征(如位置编码或数据结构)转向模型的输出分布。具体而言,通过对合成任务的案例研究,我们强调了一个关键现象:长短对齐(long-short alignment),即模型在不同长度的序列上输出分布的一致性。我们进一步将这一洞察扩展至自然语言任务,提出了一个用于量化该现象的度量指标——长短失配(Long-Short Misalignment),并揭示该指标与长度泛化性能之间存在强相关性。 基于上述发现,我们设计了一种新的正则化项,在训练过程中促进模型的长短对齐。大量实验证明了该方法的有效性,为实现更强的长上下文建模能力提供了新的思路。

代码开源地址:https://github.com/PKU-ML/LongShortAlignment

成为VIP会员查看完整内容

相关内容

Arxiv

211+阅读 · 2023年4月7日

Arxiv

20+阅读 · 2023年3月21日