题目: “You are grounded!”: Latent Name Artifacts in Pre-trained Language Models

简介:

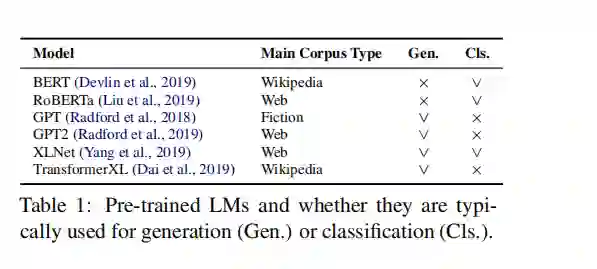

预训练语言模型(LM)可能会使训练语料库的偏见持续下降到下游模型。 我们将重点放在与给定名称(例如Donald)的表示相关的构件上,这些构件取决于语料库,可能与特定实体相关联,如下一个标记预测(例如Trump)所示。 虽然在某些情况下很有帮助,但在未指定或不适当的情况下也会发生接地。 例如,“唐纳德是一个”而产生的结尾与其他名字的结尾大不相同,并且通常具有比平均水平更高的负面情绪。 我们通过阅读理解证明了对下游任务的潜在影响。 我们的实验表明,对不同语料库进行额外的预训练可能会减轻这种影响。

成为VIP会员查看完整内容

相关内容

华盛顿大学(University of Washington)创建于1861年,坐落在美国最适宜居住和工作的城市西雅图,是美国西海岸最古老的大学,是一所世界顶尖的著名大学,长期保持世界大学财政支出和研究经费前三位。华盛顿大学拥有世界最顶尖的教师队伍,拥有29,804名教职员工,包括5803名教师,师生比例为 1:7.3 ,其中众多教授为所在学术领域的世界领导者。

专知会员服务

99+阅读 · 2020年7月3日

【ACL2020】不要停止预训练:根据领域和任务自适应调整语言模型,Don't Stop Pretraining: Adapt Language Models to Domains and Tasks

专知会员服务

46+阅读 · 2020年4月25日

Arxiv

4+阅读 · 2018年2月22日