大型语言模型(Large Language Models,LLMs)通过思维链(Chain-of-Thought,CoT)提示在各类复杂推理任务中表现出色。然而,传统 CoT 依赖于用自然语言显式书写的推理步骤,既降低了效率,也限制了其在抽象推理场景下的适用性。为此,研究者开始关注“潜在思维链”推理(latent CoT reasoning):让推理在潜在空间中进行。通过将推理过程与语言解耦,潜在推理能够生成更丰富的认知表征,并实现更灵活、更快速的推理。 围绕这一新兴方向,学界在训练方法、结构创新与内部推理机制等方面展开了多元探索。本文对该推理范式进行了系统综述与分析。首先,我们从四个维度提出统一的分类框架:逐 token 策略、内部机制、分析方法与应用场景。随后,对代表性方法进行深入讨论与对比分析,总结其设计模式、优势及尚待解决的挑战。我们期望为推动 LLM 推理领域的这一新方向提供结构化的理论与实践基础。

1 引言

“凡不能言说之事,当保持沉默。”——路德维希·维特根斯坦 大型语言模型(Large Language Models,LLMs)借助思维链(Chain-of-Thought,CoT)推理,在复杂推理任务中展现了卓越能力(Guo 等,2025;OpenAI,2025;Qwen,2025;Wei 等,2022;Chen 等,2025b)。CoT 通过引导模型以自然语言逐步推理,不仅提升了可解释性,还常常带来更优的任务表现(Kojima 等,2022;Chu 等,2024)。 然而,显式 CoT 推理受限于必须用自然语言记录每一步推理,导致两大问题: 1. 计算效率低下——并非所有生成的 token 都携带有用信息(Lin 等,2025b;Feng 等,2025;Qu 等,2025;Sui 等,2025;Wang 等,2025a;Liu 等,2025); 1. 思维表达受限——人类认知常常超越语言,可包含抽象洞见、直觉跃迁或高度组合式思考,这些内容难以完全或准确地口头化(Wittgenstein,1922;Pinker,1994)。正如 Hao 等(2024)指出,强行将每一步都显式化不仅困难,还对推理本身造成不自然的束缚。

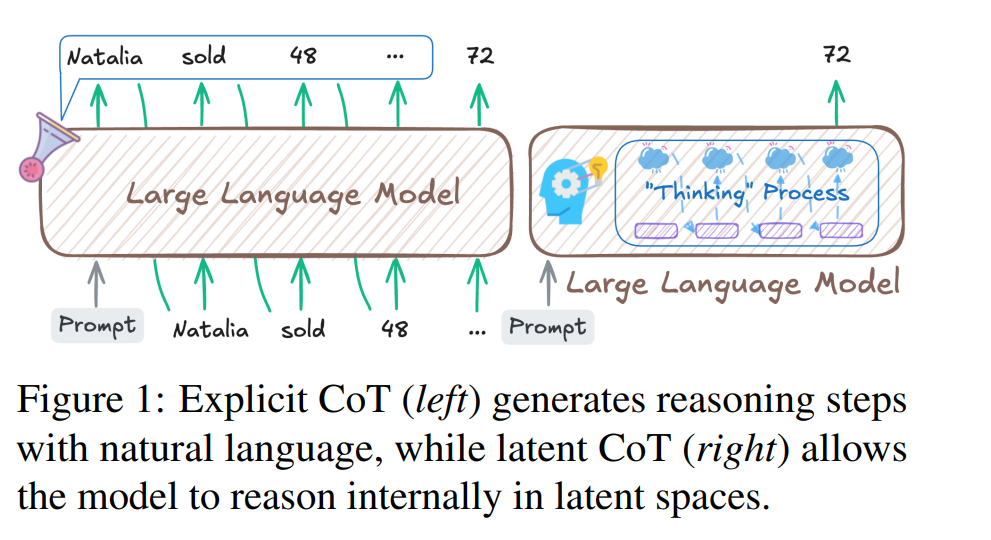

上述局限促使研究者转向潜在思维链推理(Latent Chain-of-Thought,latent CoT)。如图 1 所示,模型不再依赖语言 token,而是在潜在空间中进行推理,为类思维过程提供了更抽象、更高效的媒介。这种“去语言化”推理可带来更丰富的思维表征、通过压缩计算实现更快的推理速度,并对非语言认知模式具备更大灵活性(Lindsey 等,2025)。然而,潜在 CoT 也引发关键挑战: * 不可监督性:内部推理发生在难以直接解释的潜在空间内(Lindsey 等,2025); * 评估缺口:缺乏衡量深层潜在推理与输入-输出捷径的明确指标(Ameisen 等,2025); * 对齐风险:无法检查或约束潜在轨迹,使伦理控制更加复杂(Xu 等,2025b;Ruan 等,2025)。

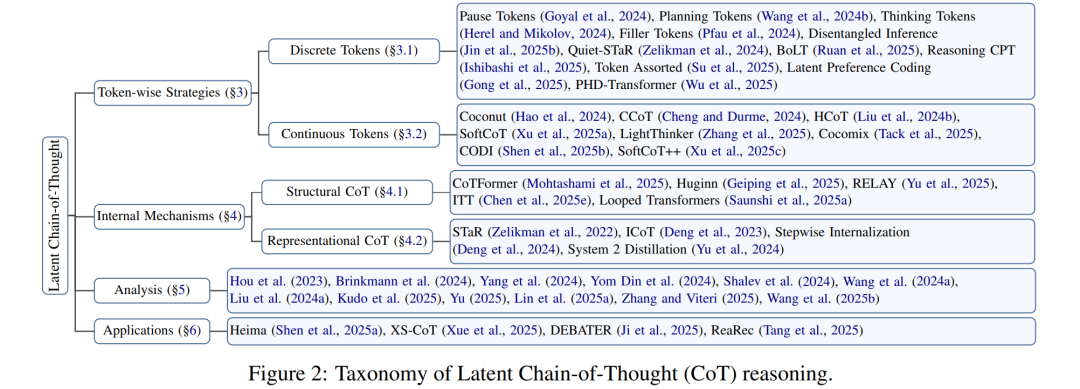

尽管存在未解难题,潜在推理研究发展迅速且碎片化,亟需研究社区对其进行清晰、系统的梳理。为此,我们提出首个潜在思维链推理的全面综述,贡献如下: 1. 系统化分类:提出潜在 CoT 研究的结构化分类框架,将现有工作划分为四大方向,并在各方向内部对代表性研究进行系统梳理,阐明其方法假设与创新(见图 2)。 1. 深入分析:基于该分类,对各类别代表性工作进行综合分析,比较其训练策略、设计范式、监督信号与效率权衡。 1. 挑战识别与前沿展望:总结潜在 CoT 领域的关键开放问题,并展望未来值得关注的研究方向。

我们期望整合潜在推理碎片化的研究现状,为该新兴方向的进一步发展奠定结构化的理论与实践基础。

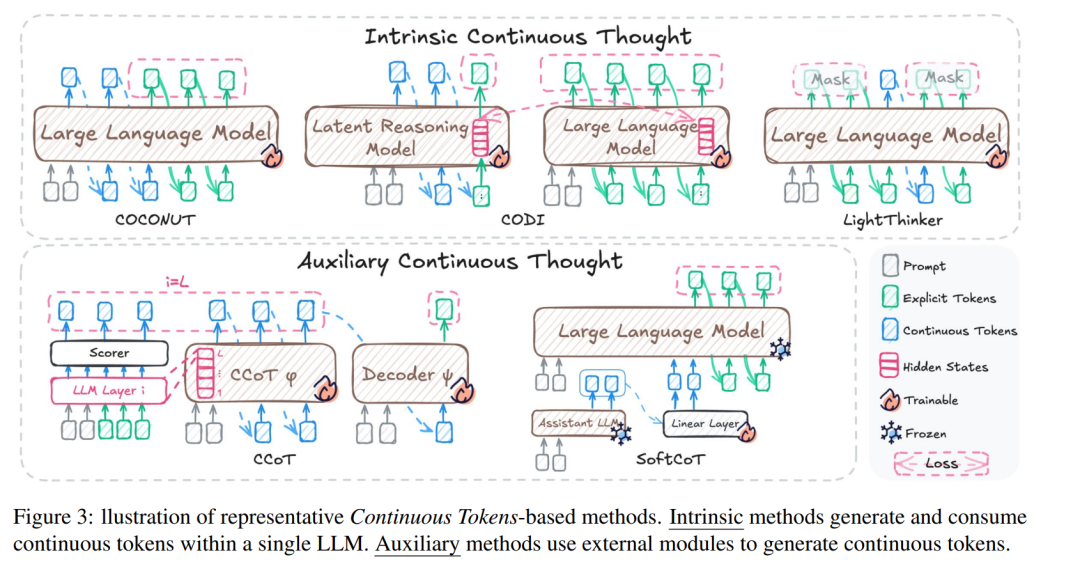

本文对大型语言模型中的潜在思维链推理(latent CoT)进行了全面综述。首先,我们梳理方法层面的最新进展,主要分为两大类:逐 token 策略(§3),涵盖离散 token(§3.1)与连续 token(§3.2);以及内部机制(§4),进一步细分为结构机制与表征机制。除设计机制外,我们还回顾了关于潜在推理分析与可解释性的持续研究进展(§5)。最后,本文讨论潜在 CoT 在实际场景中的应用(§6),并总结其所面临的挑战与未来研究方向(§7)。