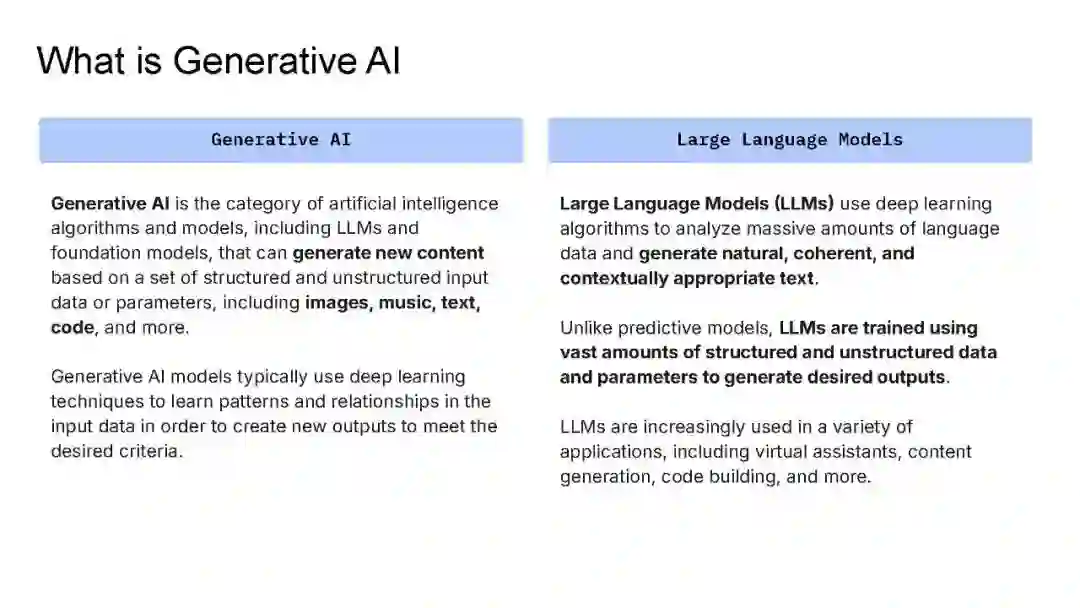

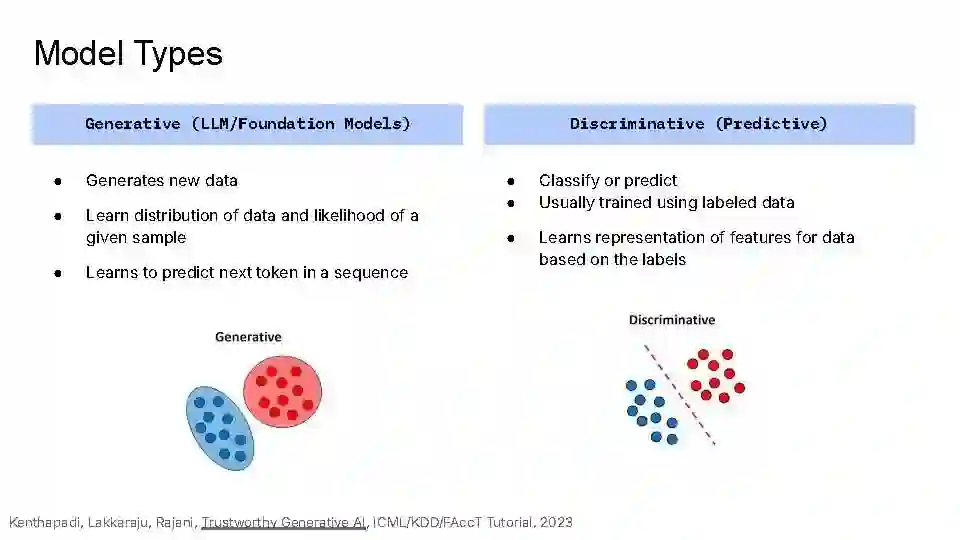

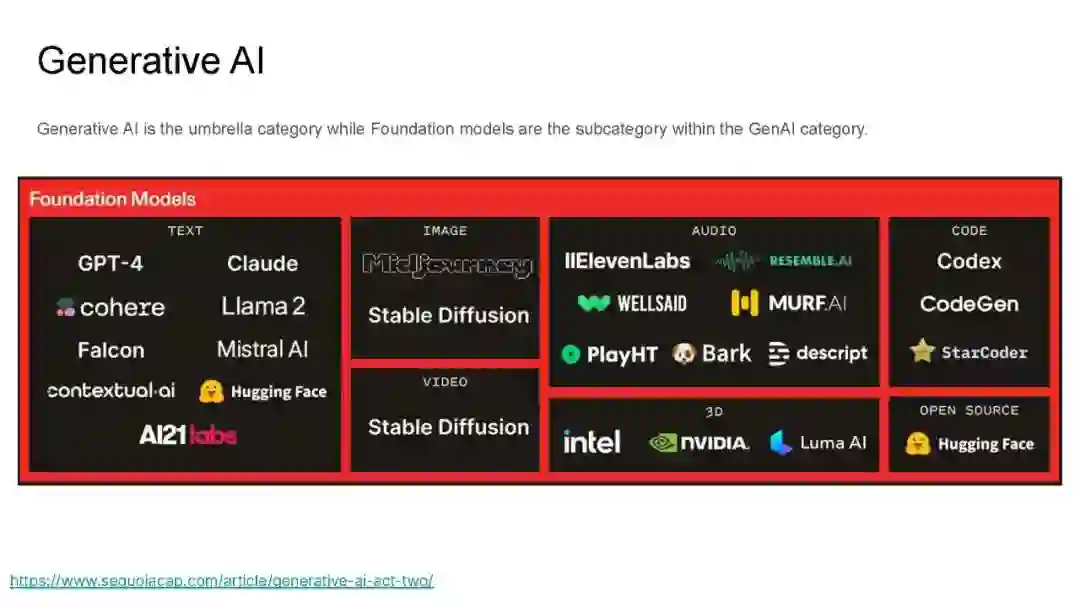

随着人工智能(AI)系统在金融服务、医疗与生命科学、招聘与人力资源、教育、社会基础设施和国家安全等高风险领域的快速普及,开发和部署基础AI模型和系统时必须以负责任的方式进行,并确保其可信性、安全性和可观测性。我们重点关注的是大型语言模型(LLMs)及其他生成式AI模型和应用。这些模型和应用不仅需要在准确性和质量相关指标上进行评估和监控,还需要在以下方面进行评估和监控:对抗性攻击下的鲁棒性、分布变化下的鲁棒性、对代表性不足群体的偏见和歧视、 安全性和隐私保护、可解释性、幻觉(以及其他没有根据或低质量的输出)、有害内容(如性别歧视、种族主义和仇恨言论)、安全性和一致性机制的越狱、提示注入攻击、虚假信息和错误信息、虚假、误导和操纵性内容、版权侵权以及其他负责任AI的维度。

https://sites.google.com/view/llm-evaluation-tutorial

Krishnaram Kenthapadi 是Oracle Health的首席科学家,负责临床AI领域的工作,他领导了Oracle Health产品中临床数字助手和其他AI项目的开发工作。此前,作为Fiddler AI的首席AI官兼首席科学家,他领导了生成式AI的多个项目(例如Fiddler Auditor,这是一个用于在部署前评估和红队化大型语言模型的开源库;AI安全性、可观测性及反馈机制在生产环境中的应用),以及AI安全性、一致性、可观测性和可信度的相关工作,还负责技术战略、客户驱动的创新和思想领导工作。在此之前,他曾担任Amazon AWS AI的首席科学家,领导了AWS AI平台上公平性、可解释性、隐私性和模型理解方面的工作。加入Amazon之前,他曾在LinkedIn AI团队领导类似的工作,并担任LinkedIn在微软AI与工程研究伦理(AETHER)咨询委员会中的代表。再之前,他是微软研究院硅谷实验室的研究员。Krishnaram于2006年在斯坦福大学获得计算机科学博士学位。他的研究工作获得了NAACL、WWW、SODA、CIKM、ICML AutoML研讨会和微软AI/ML大会(MLADS)的多个奖项。他发表了50多篇论文,引用量超过7000次,并申请了150多项专利(已授予72项)。他曾在多个行业论坛上介绍隐私、公平性、可解释AI、机器学习模型监控、负责任AI以及可信生成式AI的教程,如KDD '18 '19 '22 '23、WSDM '19、WWW '19 '20 '21 '23、FAccT '20 '21 '22 '23、AAAI '20 '21和ICML '21 '23,并在斯坦福大学教授了一门关于负责任AI的课程。

Mehrnoosh Sameki 是微软的首席产品经理和负责任AI工具领域负责人,领导一个AI产品经理团队,开发和交付用于模型评估和负责任AI的前沿工具,包括开源工具和通过Azure AI平台提供的生成式AI解决方案和机器学习模型工具。她还是波士顿大学计算机科学学院的兼职助理教授,并于2017年在该校获得博士学位。Mehrnoosh曾在多个行业论坛(包括微软Build)上发表演讲,并在KDD '19 '22、WWW '21 '23、FAccT '21 '22、AAAI '21和ICML '21等论坛上介绍了关于公平性、机器学习模型监控和负责任AI的教程。

Ankur Taly 是Google Gemini团队的高级研究科学家,负责领导后训练数据和模型质量相关的工作。在此之前,他曾是Google Cloud AI的一员,负责大型语言模型的真实性和基础性研究工作,再之前,他曾担任Fiddler AI的数据科学主管,负责开发和推广核心可解释AI技术。Ankur最为人知的是他在开发和应用综合梯度(Integrated Gradients,引用量超过6000次)——一种新的深度网络可解释性算法——方面的贡献。他在这一领域的研究成果发表于多个顶级机器学习会议和期刊。除了机器学习之外,Ankur还拥有广泛的研究背景,在计算机安全、编程语言和形式化验证等领域发表了30多篇论文。他在斯坦福大学共同教授CS 328:可信机器学习课程,并在多次会议上讲授短期课程和教程(如KDD 2024、KDD 2019、FActT 2019、FOSAD 2016等)。Ankur于2012年在斯坦福大学获得计算机科学博士学位,并于2007年在印度理工学院孟买分校获得计算机科学学士学位。