多模态大模型

·

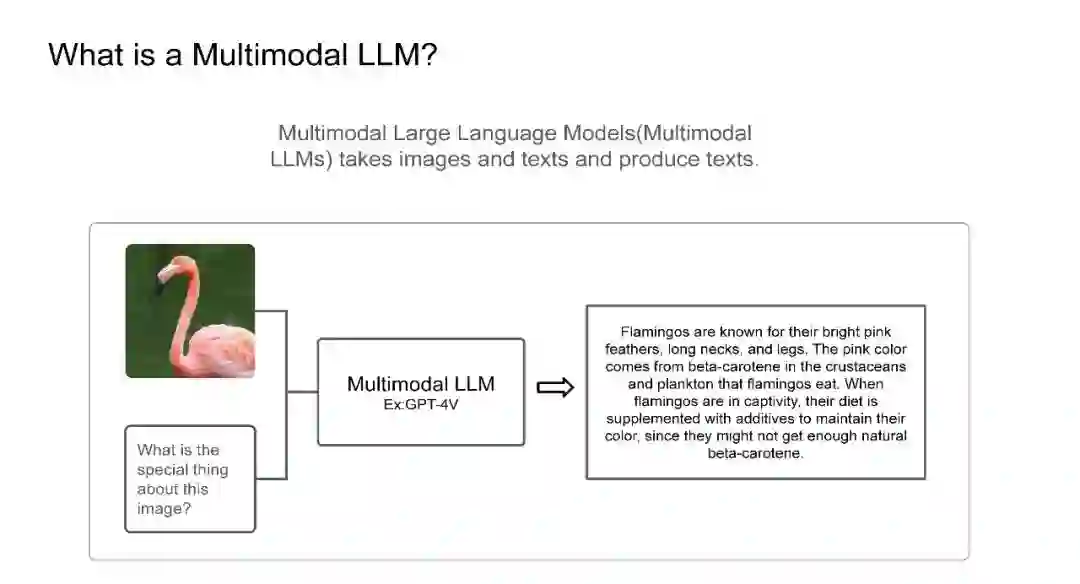

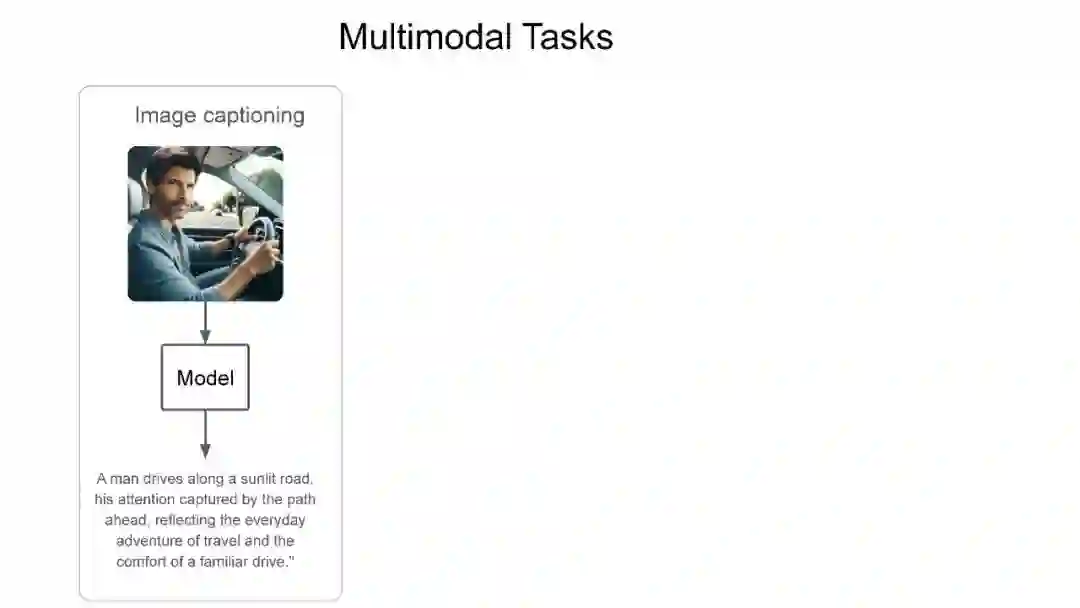

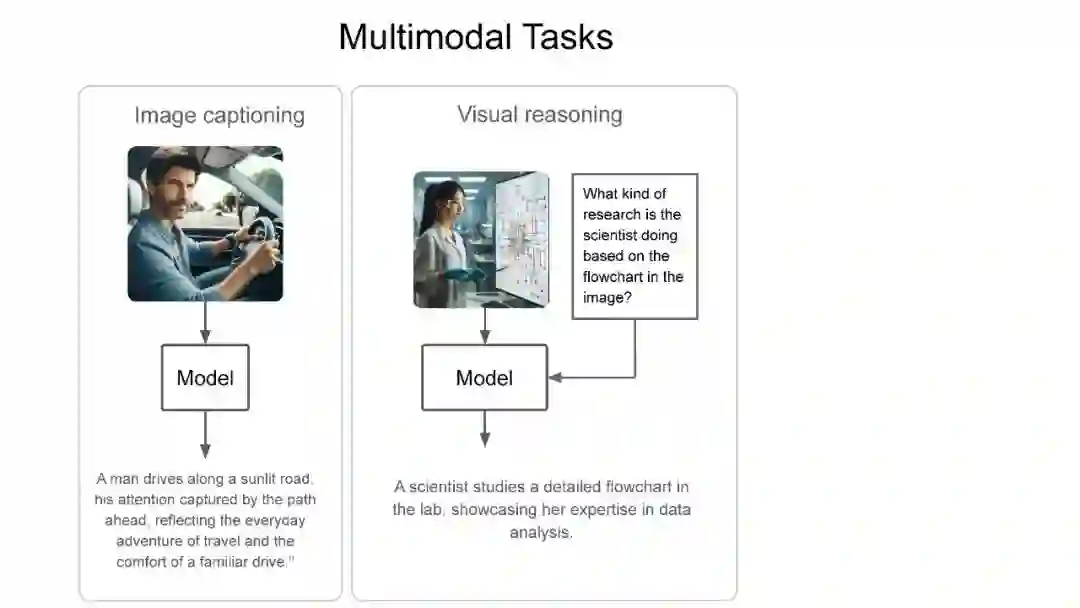

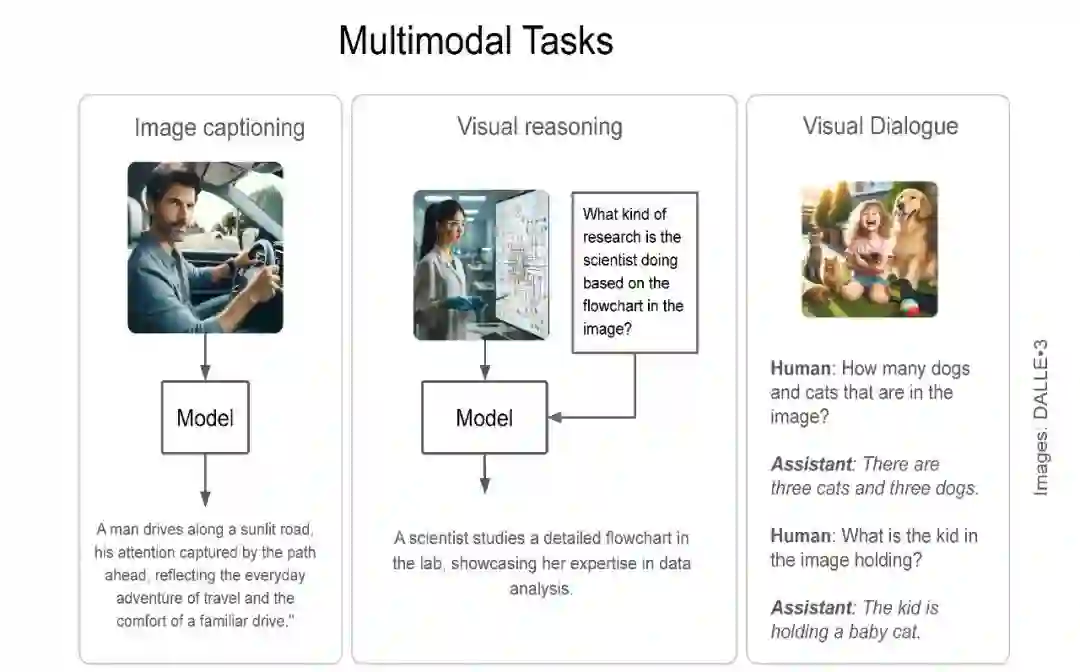

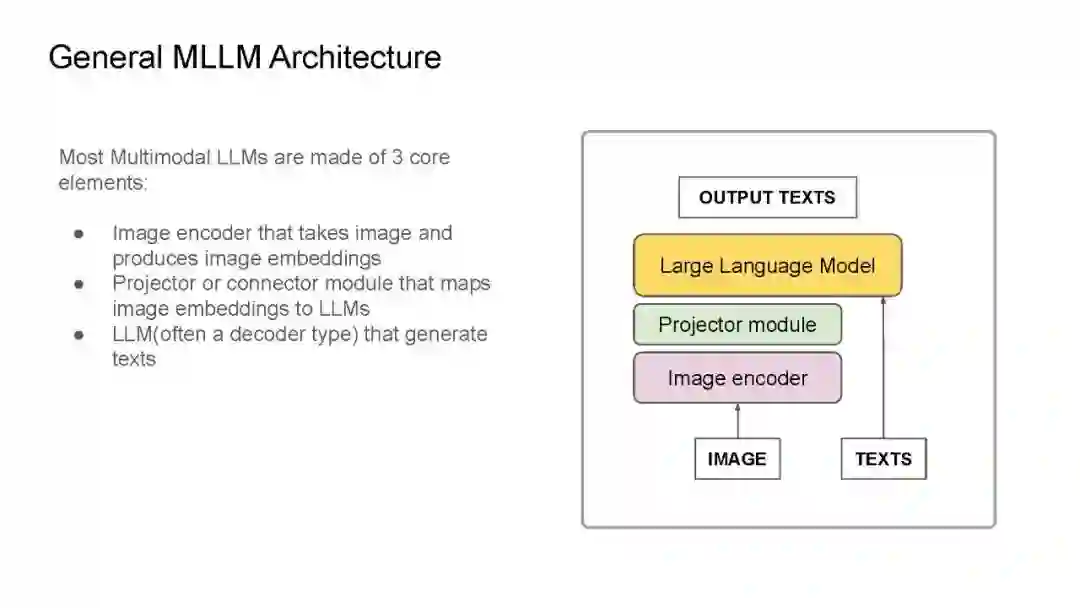

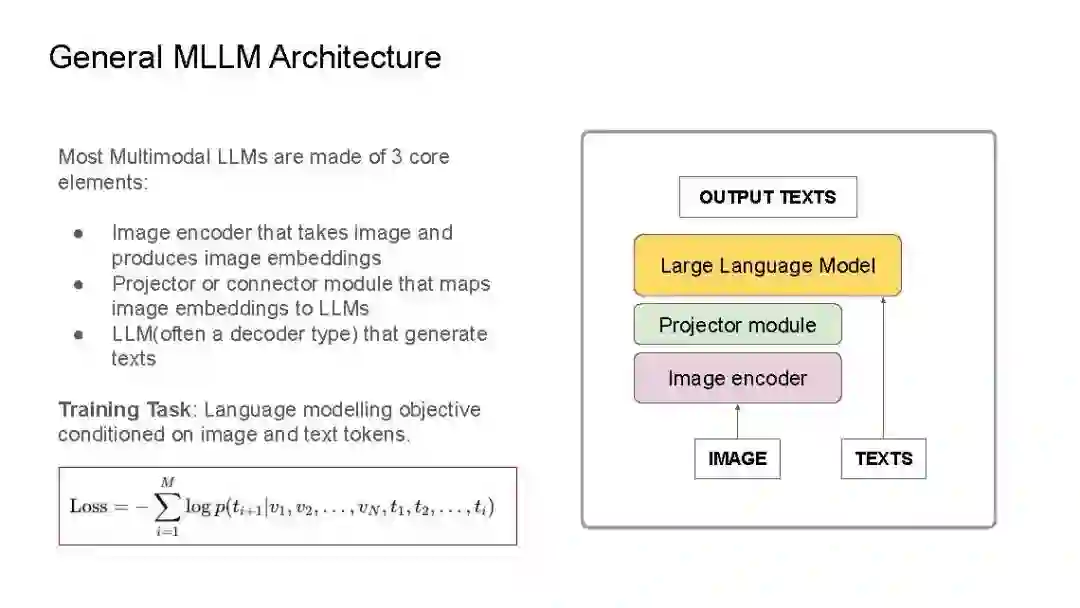

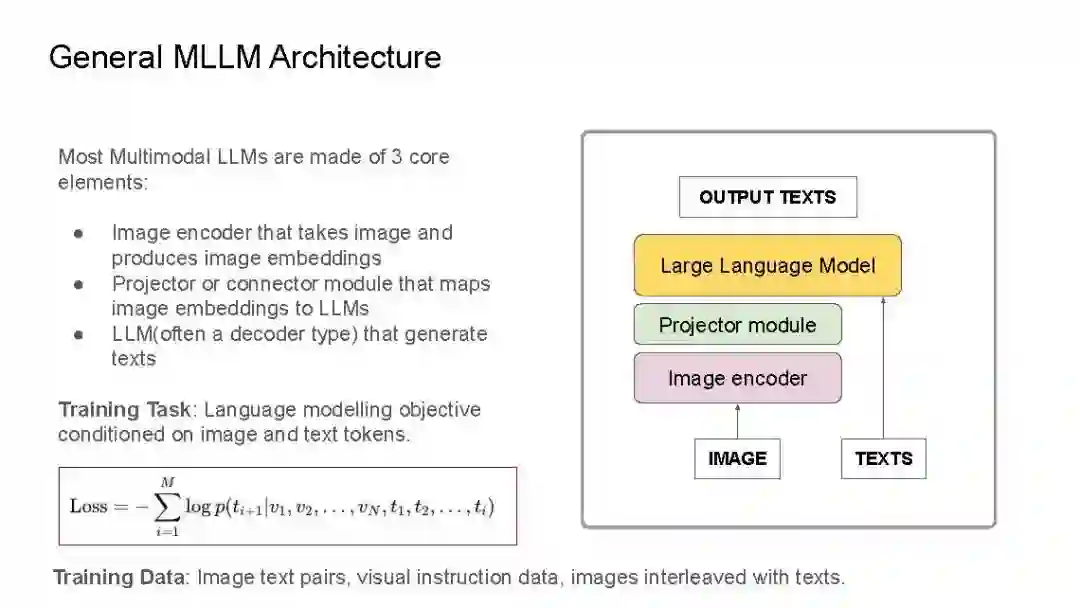

最近,我在IndabaX Rwanda和卡内基梅隆大学(CMU)学生研究讲座的“18-661 工程师机器学习导论”课程中进行了关于多模态大语言模型(LLMs)的演讲。 在演讲中,我们剖析了多模态大语言模型、多模态任务以及通用的多模态LLM架构。大多数多模态LLM的架构几乎非常相似:包括用于获取图像嵌入的视觉编码器(如CLIP-ViT或SigLIP),用于将图像标记映射到LLM维度空间的连接器/投影器(例如线性层/MLP/注意力层),以及用于生成的底层LLM(通常是解码器类型的语言模型)。 我们还探讨了具有代表性的模型:如CLIP,它奠定了基础,Flamingo则启发了图像-文本交替和视觉语言模型中的上下文学习,而LLaVA引入了视觉指令微调,在许多多模态基准测试中达到了SOTA(最新的技术水平)。 最后,我们讨论了基准测试、开源与闭源模型的对比、当前面临的挑战以及我对多模态LLM的愿望清单。

成为VIP会员查看完整内容

相关内容

Arxiv

153+阅读 · 2023年3月29日