麻省理工学院研究人员创建了一个数学框架来评估机器学习模型的解释并量化人们对它们的理解程度。

背景

现代机器学习模型,例如神经网络,通常被称为“黑盒”,因为它们非常复杂,以至于即使是设计它们的研究人员也无法完全理解它们是如何做出预测的。

为了提供一些见解,研究人员使用试图描述单个模型决策的解释方法。例如,他们可能会在电影评论中突出显示影响模型决定评论是正面的单词。

但是,如果人类不能轻易理解,甚至误解它们,这些解释方法就没有任何用处。因此,麻省理工学院的研究人员创建了一个数学框架来量化和评估机器学习模型解释的可理解性。如果研究人员仅评估少数个别解释以尝试理解整个模型,这可以帮助查明有关模型行为的见解。

"有了这个框架,我们不仅可以从这些局部解释中非常清楚地知道我们对模型的了解,更重要的是我们对模型的不了解,"计算机科学和人工智能实验室(CSAIL)的电气工程和计算机科学研究生Yilun Zhou说,他是本论文的主要作者。

Zhou的合著者包括微软研究院高级研究员 Marco Tulio Ribeiro 和高级作者、航空航天学教授、CSAIL 交互式机器人组主任 Julie Shah。该研究将在计算语言学协会北美分会(NAACL2022)上发表。

了解局部解释

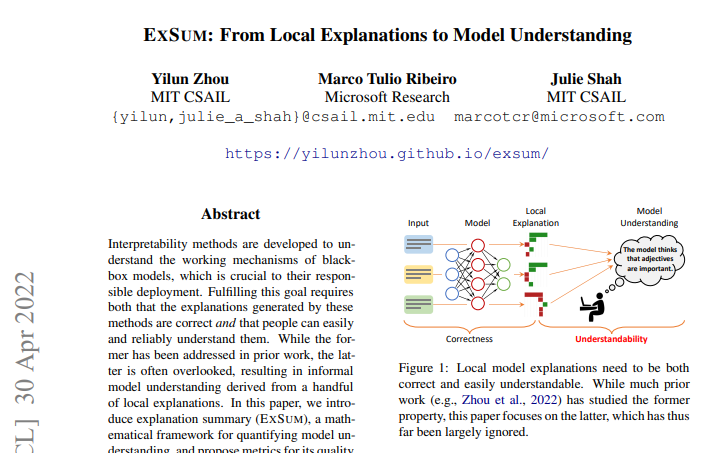

理解机器学习模型的一种方法是找到另一个模仿其预测但使用透明推理模式的模型。然而,最近的神经网络模型非常复杂,以至于这种技术通常会失败。相反,研究人员求助于使用关注个体输入的局部解释。通常,这些解释会突出显示文本中的单词,以表明它们对模型做出的一个预测的重要性。

然后,人们隐含地将这些局部解释推广到整体模型行为。有人可能会看到,当模型确定电影评论具有积极情绪时,局部解释方法突出显示积极词(如“难忘”、“完美无瑕”或“迷人”)是最有影响力的。然后他们可能会假设所有积极的词都会对模型的预测做出积极的贡献,但情况可能并非总是如此,Zhou说。

研究人员开发了一个框架,称为 ExSum(解释摘要的缩写),将这些类型的声明形式化为可以使用可量化指标进行测试的规则。ExSum 评估整个数据集上的规则,而不仅仅是为其构造的单个实例。

使用图形用户界面,写下规则,然后可以进行调整和评估。例如,当研究一个将电影评论分类为正面或负面的模型时,人们可能会写一条规则说“否定词具有负面显着性”,这意味着诸如“不”和“无”之类的词对电影评论的情绪产生负面影响。

使用 ExSum,用户可以使用三个特定指标查看该规则是否成立:覆盖率、有效性和清晰度。覆盖率衡量规则在整个数据集中的适用范围。有效性突出显示符合规则的单个示例的百分比。清晰度描述了规则的精确程度;一个高度有效的规则可能非常通用,以至于对理解模型没有用处。

扩展框架

在未来,Zhou希望通过将可理解性的概念扩展到其他标准和解释形式,如反事实解释(表明如何修改输入以改变模型预测)来建立这项工作。目前,他们专注于特征归因方法,这些方法描述了模型用于做出决策的各个特征(如电影评论中的文字)。

此外,他希望进一步增强框架和用户交互,以便人们可以更快地创建规则。编写规则可能需要数小时的人工参与——一定程度的人工参与至关重要,因为人类最终必须能够掌握解释——但人工智能的帮助可以简化这一过程。

在思考 ExSum 的未来时,Zhou希望他们的工作强调需要改变研究人员对机器学习模型解释的看法。

“在这项工作之前,如果你有一个正确的本地解释,你就完成了。你已经完成了解释你的模型。我们提出了这个额外的维度,以确保这些解释是可以理解的。可理解性需要成为评估我们解释的另一个指标,”Zhou说。

这项研究得到了美国国家科学基金会的部分支持。

论文

开发可解释性方法以了解黑盒模型的工作机制,这对其负责任的部署至关重要。实现这一目标既需要这些方法产生的解释是正确的,又需要人们可以轻松可靠地理解它们。虽然前者已在之前的工作中得到解决,但后者经常被忽视,导致从少数当地解释得出的非正式模型理解。在本文中,我们介绍了解释摘要(EXSUM),一个用于量化模型理解的数学框架,并提出了用于其质量评估的指标。在两个领域,EXSUM 突出了当前实践中的各种限制,帮助开发准确的模型理解,并揭示模型容易被忽视的属性。我们还将可理解性与解释的其他属性联系起来,例如人类对齐、鲁棒性以及反事实的最小化和合理性