深度神经网络(DNNs)已经广泛用在各种视觉模型中,一个实际问题是DNNs容易受到对抗样本的攻击, 对安全性造成严重的威胁。 北航韦星星等学者最新《 物理世界中的视觉对抗攻击与防御》综述,调查了关于计算机视觉中的物理对抗攻击和物理对抗防御,值得关注!

深度神经网络(DNN)虽然在各种实际场景中得到广泛应用,但它们容易受到对抗样本的攻击。根据攻击方式的不同,当前计算机视觉中的对抗攻击可以分为数字攻击和物理攻击两种形式。与数字攻击不同,物理攻击在现实世界中实施。由于物理对抗样本带来的严重安全问题,过去几年中出现了许多工作来评估DNN的物理对抗鲁棒性。在本文中,我们调查了关于计算机视觉中的物理对抗攻击和物理对抗防御。为了建立分类体系,我们分别从攻击任务、攻击形式和攻击方法组织当前的物理攻击。因此,读者可以从不同的角度系统地了解这个主题。对于物理防御,我们从DNN模型的预处理、处理和后处理方面建立分类体系,以实现对抗防御的全面覆盖。基于以上调查,我们最后讨论了这个研究领域的挑战和未来方向的展望。 地址:

https://www.zhuanzhi.ai/paper/fa93b0bb4a78fecb3ff90ea6e573abad

https://arxiv.org/abs/2211.01671

1.引言

深度神经网络(DNN)在计算机视觉(CV)和自然语言处理(NLP)领域取得了惊人的性能表现,并被广泛应用于商业和工业领域,例如移动支付[39]、自动驾驶[6]、监控[4]、机器人[102]和医学诊断[10]等。然而,繁荣背后潜藏着危机。Szegedy等人[50]发现,仅用微小的扰动就足以推翻最先进的DNN模型的预测。这种恶意行为被定义为对抗攻击,被篡改的图像被称为对抗样本。此后,在不同的CV任务中证明了对抗样本的有效性,主要包括图像分类[84]、语义分割[56]、目标检测[107]、目标跟踪[27]、运动检测[91]等。此外,一些研究[81,65]也从理论上证明了DNN的脆弱性。 在计算机视觉中,根据作用域,对抗攻击可以区分为数字攻击和物理攻击。数字攻击是指在摄像机成像后对数字像素进行攻击,而物理攻击是指在摄像机成像前对物理对象进行攻击。虽然数字攻击(如PGD [87]、MI-FGSM [36]、C&W [16]和Deepfool [93]等)对DNN模型有很高的攻击成功率,但在现实世界中难以实现。因为数字扰动通常是全局的和不显眼的,很难被摄像机清晰地捕捉到。这些缺点促使研究人员探索更实际的、并且能在物理世界实施的方式。为此,许多物理对抗攻击已在自动驾驶[7, 14, 19, 40, 44, 69, 85, 120, 130, 147, 154]、人脸识别[85, 99, 115, 116, 118, 144]、安全监控[34, 60-62, 125, 132, 137, 142, 146]等方面得到报告。这些工作对安全关键任务提出了巨大的挑战,因此研究CV系统对物理攻击的鲁棒性及相应的防御策略至关重要。

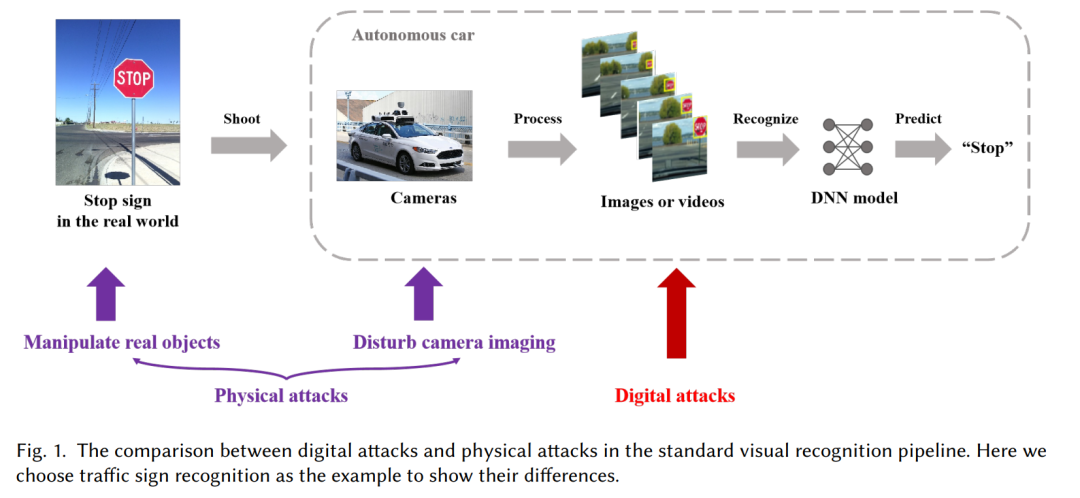

一般而言,数字攻击和物理攻击是在视觉识别流程的不同阶段进行的。例如,图1通过自动驾驶场景中的交通标志识别任务展示了物理攻击和数字攻击的区别。我们可以看到,对于物理攻击,对手可以通过操纵真实的停车标志或干扰相机成像。对于数字攻击,对手通常直接在相机捕捉的图像或视频中的像素上生成对抗扰动。无论是哪种攻击,当对抗样本被输入到DNN模型中时,它们都会导致错误的预测。与数字攻击相比,物理攻击面临以下几个重要挑战:

(1)物理对抗样本需要抵抗相机成像的影响,这主要受到光学镜头和图像传感器处理器的影响。 (2)物理对抗样本需要对不同的变换保持鲁棒性,例如拍摄距离变化、角度变化和光照变化等。 (3)物理对抗样本应该具有隐蔽性。数字图像是在像素级别进行修改,很难被察觉。但是,对于物理攻击来说,实现不引人注目是具有挑战性的。

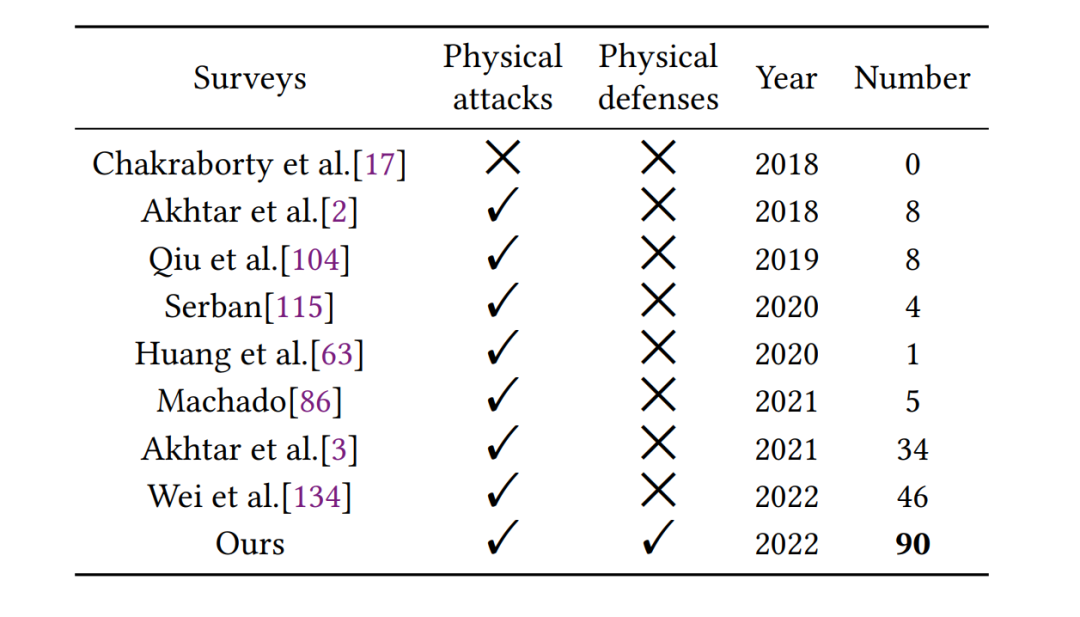

为了解决上述问题,近年来提出了许多方法来评估DNN在物理环境下的鲁棒性。有必要探索当前现有的物理攻击和防御方法,并对当前进展和未来方向进行总结。虽然已经存在一些关于计算机视觉中对抗攻击和防御的综述,但它们并不全面且不涉及物理攻击和防御。例如,[17]总结了针对不同机器学习模型的数字攻击和防御,但未涉及物理攻击和防御。Akhtar等人[2]回顾了2018年之前计算机视觉中的对抗攻击和防御,只涉及物理攻击的一些早期方法包含在“现实世界中的攻击”部分。随后,Qiu等人[104]将物理对抗攻击作为2019年对抗攻击的应用场景进行了介绍。2020年,Huang等人[63]将这个领域的研究总结为五个方面:验证、测试、对抗攻击和防御以及可解释性。之后,[3]系统地回顾了对抗攻击和防御,但物理攻击仍不是重点。一些研究专注于特定的计算机视觉任务,[114]总结了关于物体识别的对抗攻击和防御,[86]回顾了图像分类中的对抗机器学习。我们可以看到,上述工作主要集中于介绍数字领域的对抗攻击和防御,而忽略了物理领域。最近,Wei等人[133]发表了一篇有关计算机视觉中物理对抗攻击的综述。他们从有效性、隐秘性和鲁棒性三个方面讨论了当前的物理攻击。

我们与他们不同之处有三个方面: (1)除了物理对抗攻击,我们还对物理对抗防御进行了综述,而[133]未涉及该主题。 (2)我们从多级视角介绍了当前物理对抗攻击的更细致的分类(见图2),这比[133]更系统。 (3)我们讨论了比[133]更多的物理攻击和防御参考文献(90篇vs 46篇)。表1列出了这些综述的比较。简而言之,对于计算机视觉中最新的物理攻击和防御的全面回顾是必要的。

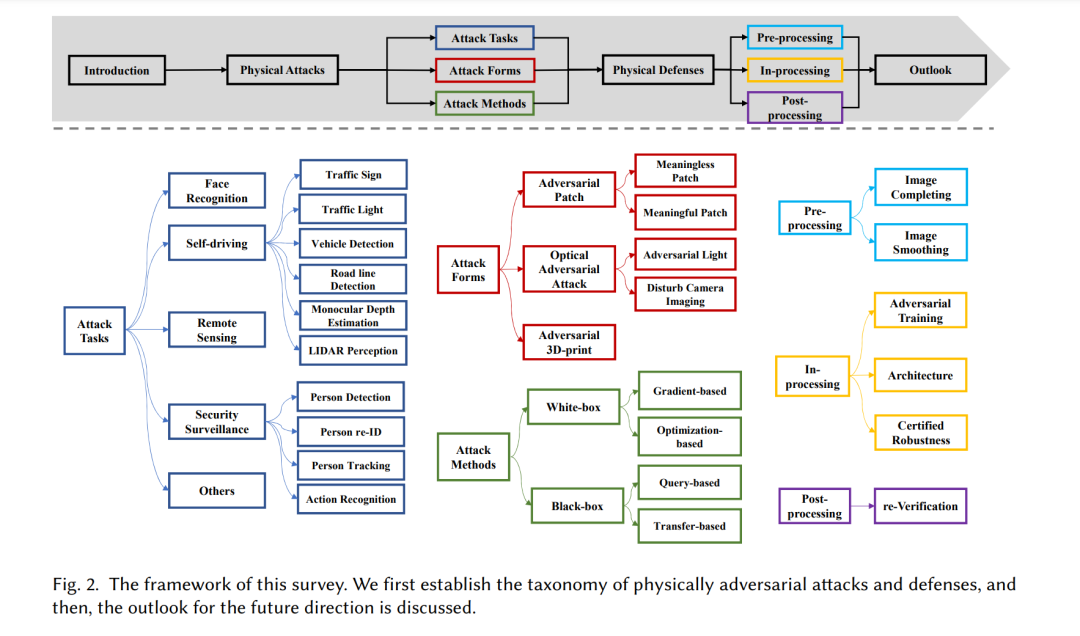

因此,本文撰写了一篇综述,系统地记录了过去十年中这一领域的最新研究。具体来说,我们首先从攻击任务、攻击形式和攻击方法等方面,建立了当前物理攻击的分类法。在攻击任务方面,我们介绍了研究人员通常进行物理攻击的五个关键任务。在攻击形式方面,我们总结了当前物理攻击涉及的三种主要方式。在攻击方法方面,我们从白盒和黑盒的角度总结了四个攻击设置。其次,我们从DNN模型的三个阶段(预处理、处理中和后处理)建立了当前物理防御的分类法。每个阶段都包含多个细粒度的防御方法分类。最后,我们讨论了七个现有的挑战,这些挑战在该领域仍未得到解决,并进一步展望未来的发展方向。本文的框架如图2所示。

总之,本文的三个主要贡献是: (1)我们从攻击任务、攻击形式和攻击方法三个角度建立了当前物理攻击的分类系统。我们相信这三个方面可以为读者提供清晰的描述。 (2)我们从 DNN 模型的三个角度(预处理、中处理和后处理)建立了当前物理防御的分类系统,以实现对防御过程的全面覆盖。 (3)物理攻击和防御仍然是一个快速发展的研究领域,许多问题需要解决。因此,我们总结了这个领域的挑战,并展望未来的研究方向。 本文的其余部分结构如下:第2节介绍了物理对抗攻击。第3节回顾了物理对抗防御。第4节分析了该领域的挑战,并对未来的研究方向进行了展望。

2.物理攻击

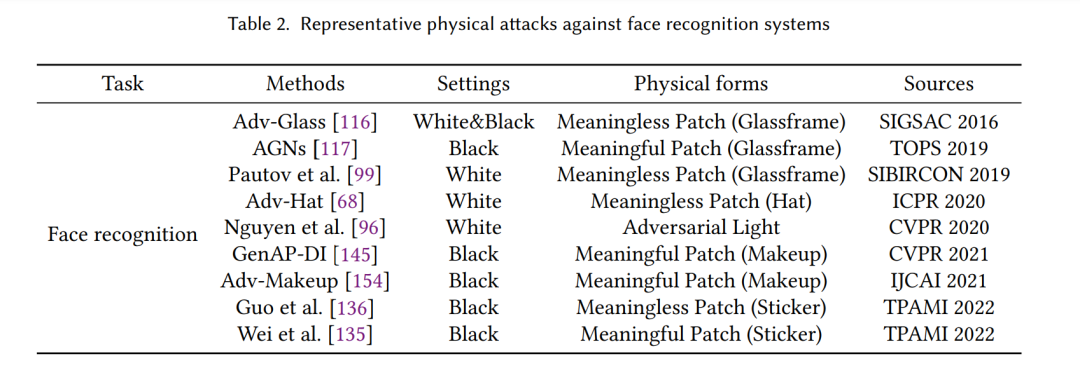

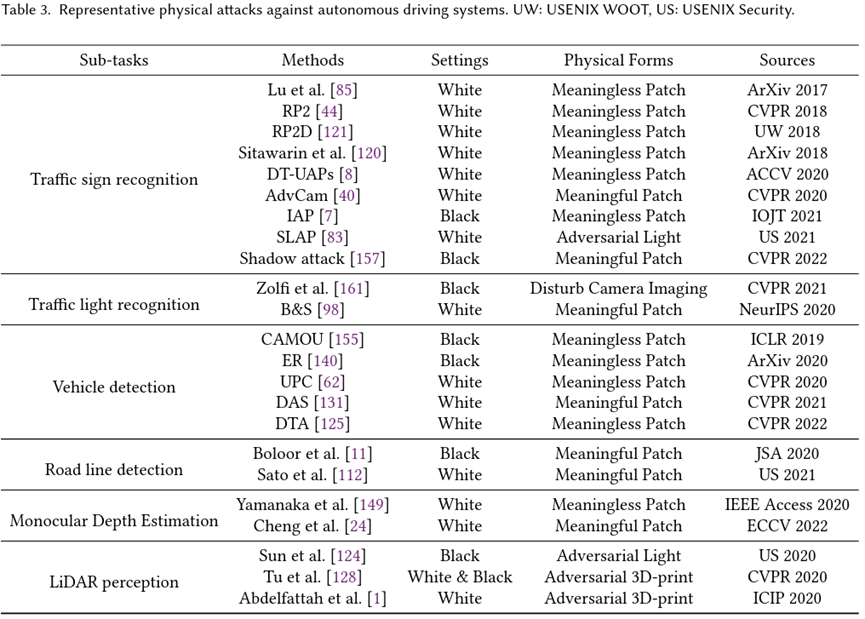

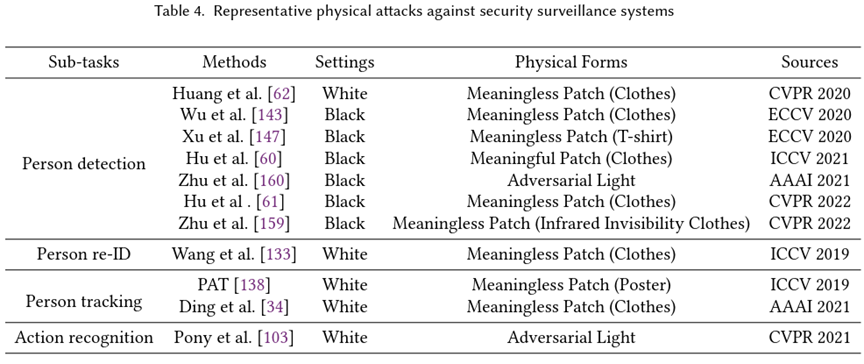

物理攻击是在现实世界中进行的,比数字攻击更具威胁。自Kurakin等人[70]首次展示深度神经网络易受物理对抗性样本攻击以来,越来越多的关注被投入到物理领域。在本节中,我们介绍了物理场景中不同的攻击任务,讨论了对抗性样本的物理形式,并分析白盒设置和黑盒设置下的攻击方法(不同攻击任务中代表性的方法分别在表2、3、4中简要展示)。

2.1 攻击任务

物理攻击是在各种任务的现实世界场景中实施的。在这部分中,我们主要介绍几个安全关键任务,包括人脸识别(表2)、自动驾驶(表3)、安全监控(表4)和遥感[29,32,38]。此外,我们展示了物理攻击在具身代理[79]中的应用。

2.2 攻击形式

本节主要介绍对抗补丁、光学对抗攻击和3D打印的对抗物体这三种物理世界的攻击形式。目前,对于物理攻击来说,对抗补丁是最普遍的方法。按照内容是否能被人类识别为现实世界中存在的对象,我们将抗补丁分为无意义的补丁(Meaningless Patch)和有意义的补丁(Meaningful Patch)来介绍,二者在对抗模式生成方式和物理形式制作方式上存在差异。计算机视觉系统的光学感知模块为物理对抗攻击留下了一个“漏洞”。对手可以利用相机的成像原理和图像传感器处理器的特性进行攻击。根据现有的研究,我们将光学对抗攻击分为对抗光(Adversarial Light)和干扰相机成像(Disturb Camera Imaging)。虽然对于2D图像的物理攻击已经暴露了严重的安全问题,针对三维点云识别的相关工作较少,三维对抗点云构造更为复杂,其物理形态也更难制做, [127][137]介绍了用3D打印物理对抗样本的实现方法和面临的挑战。

2.3 攻击方法

根据现有研究的主要目的和设置,我们将攻击方法分为白盒攻击和黑盒攻击。对于物理世界的白盒攻击,我们分别介绍了基于梯度和基于优化的方法。白盒设置可以实现高成功率,但是它们的性能通常在迁移到其他未知模型时下降,且缺乏隐蔽性。在物理世界中,对手只能访问有关目标模型的有限信息,所以研究黑盒设置下的攻击方法更有价值。我们将黑盒攻击分为查询攻击和迁移攻击。对于查询攻击,我们讨论了几种在物理攻击方法中使用的黑盒优化算法,例如贪心搜索,进化算法,强化学习和粒子群算法。物理场景中部署的DNN模型通常不支持查询,因此研究可迁移的物理攻击更具实际意义。对于迁移攻击,我们主要从集成攻击,生成对抗样本和元攻击进行讨论。

3.物理防御

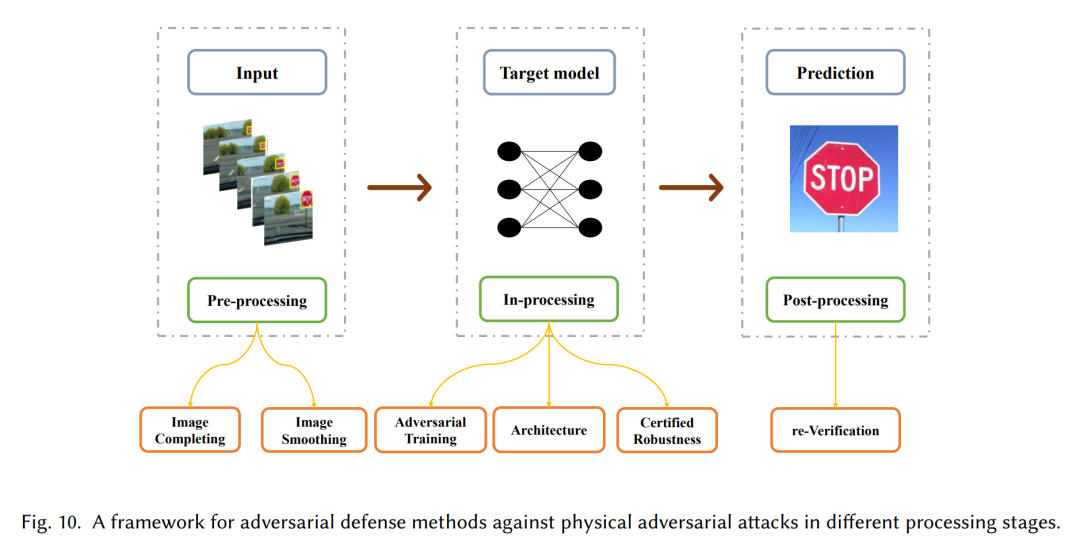

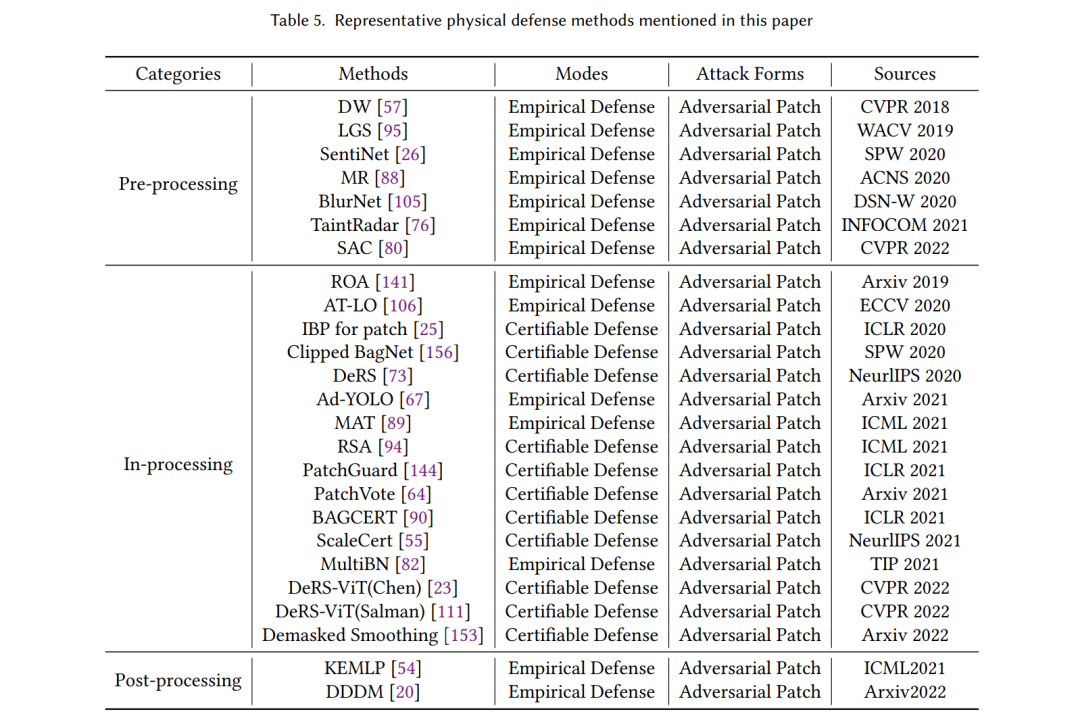

在本节中,我们回顾了用于物理对抗防御的计算机视觉文献。为了帮助读者对物理对抗防御有一个全面的认识,本文从DNN模型的三个阶段,即预处理(Pre-processing)、中处理(In-processing)和后处理(Post-processing)。分类框架如图10所示。具体来说,在3.1节中,我们讨论了预处理防御的机制。在第3.2节中,中处理中的防御方法分为对抗训练、结构修改和认证防御。3.3节将讨论后处理方法。此外,表5列出了关于物理对抗防御的总结。从表中,我们可以看到存在的物理对抗防御主要针对对抗补丁提出。这是合理的,因为对抗补丁是当前物理对抗攻击的主要形式。

3.1 预处理

数据预处理可以减少物理扰动的影响。目前的预处理方法可以分为图像补全(Image Completing)和图像平滑(Image Smoothing)。图像补全先采用一些手段定位补丁区域,然后补全图像内容来消除补丁的对抗性。图像平滑采用滑动窗口消融补丁区域,综合每一步的消融样本的结果得到对图片最终的预测。

3.2 中处理

预处理防御通常需要耗费大量时间。因此,有必要提高DNN模型本身的鲁棒性。现有的方法主要从三个方面入手:对抗训练(Adversarial Training)、模型结构(Architecture) 和认证鲁棒性(Certified Robustness) 。物理对抗训练采用包含不同补丁位置和内容的图片训练DNN模型;修改神经网络的结构可以削弱对抗补丁对分类结果的影响,主要分为缩小感受野和引入新神经元。认证鲁棒性用于验证防御方法是否能在任何情况下抵御补丁攻击,如果防御方法在干净样本上经过认证,则表明该方法实现了认证鲁棒性。

3.3后处理

后处理的思想来源于对结果重新验证。在DNN模型做出初步预测后,通过引入人类先验作为验证条件来提高预测结果的鲁棒性。

4.展望

近年来,物理对抗性攻击和防御的发展迅速,特别是对抗补丁,它已经在现实世界中的不同目标模型和场景中部署,并显示出实际威胁。然而,仍有许多棘手的问题值得讨论。在本节中,我们分析这些挑战并预测未来物理对抗攻击和防御的研究方向:(1)提高物理对抗样本的可迁移性;(2)提高物理对抗样本面对环境变换和相机处理的鲁棒性;(3)构建可被设备感知但不能被人类感知的物理对抗样本;(4)找到现实世界中自然形成的对抗样本;(5)构建通用的物理对抗防御方法;(6)减少额外的计算开销,实现高效的物理防御;(7)解决物理防御中面临的准确性和鲁棒性权衡问题。